Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Beispiel für einen Workflow zur Sprachtonanalyse für das Amazon Chime SDK

Wichtig

Bei der Stimmenanalyse werden auf der Grundlage sprachlicher und tonaler Informationen Vorhersagen über die Stimmung eines Sprechers getroffen. Sie dürfen Stimmungsanalysen nicht in gesetzlich verbotener Weise einsetzen, auch nicht im Zusammenhang mit Entscheidungen über eine Person, die rechtliche oder ähnlich erhebliche Auswirkungen auf diese Personen haben würden (z. B. in Bezug auf Beschäftigung, Wohnen, Kreditwürdigkeit oder finanzielle Angebote usw.).

Die Stimmenanalyse analysiert die Stimmen der Teilnehmer eines Anrufs und prognostiziert deren Stimmungslage, entweder, oderpositive. negative neutral

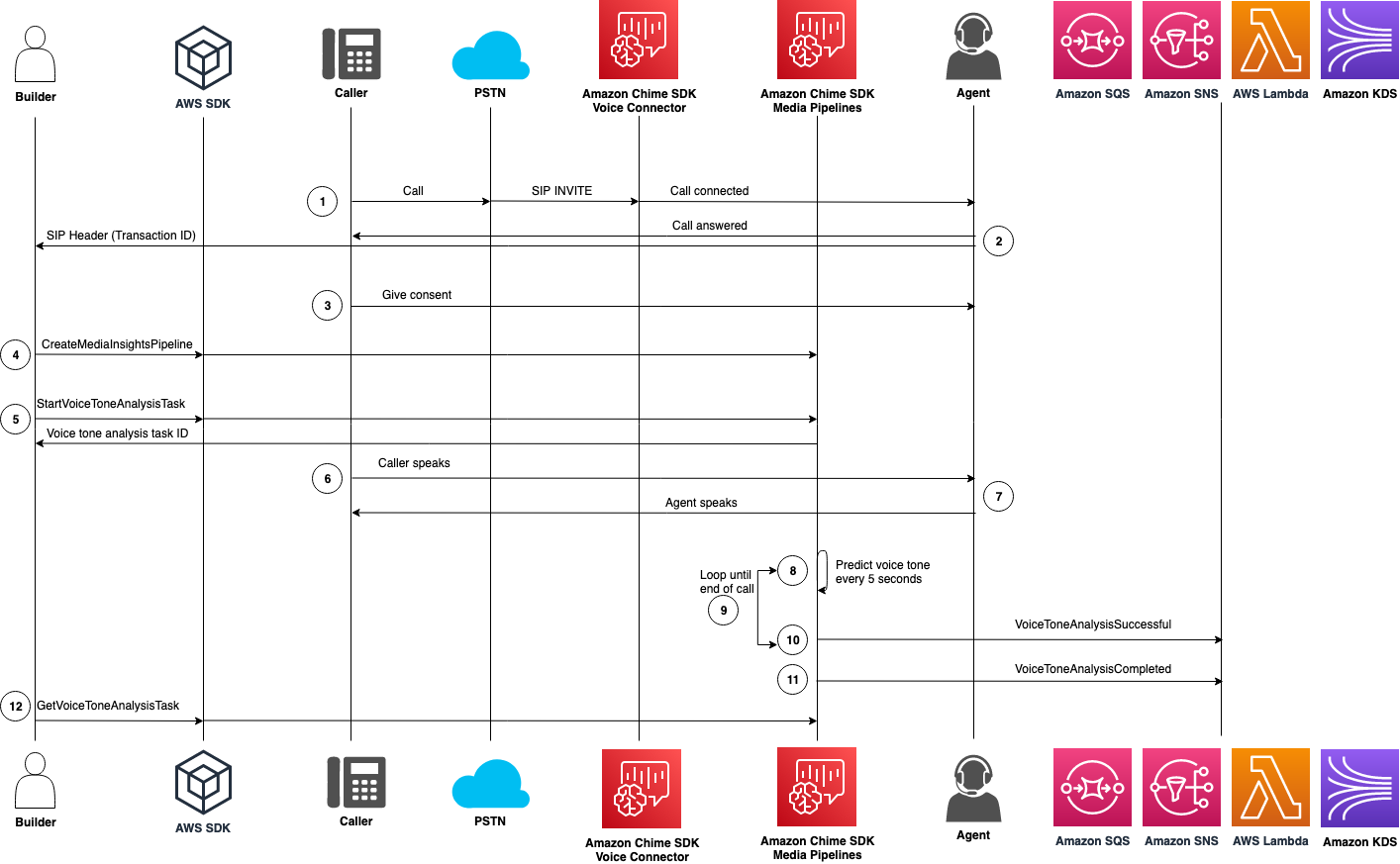

Das folgende Diagramm zeigt einen Beispiel-Workflow für eine Stimmenanalyse. Die nummerierten Elemente unter dem Bild beschreiben jeden Schritt des Prozesses.

Anmerkung

Das Diagramm geht davon aus, dass Sie bereits einen Amazon Chime SDK Voice Connector mit einer Anrufanalysekonfiguration konfiguriert haben, die über eine VoiceAnalyticsProcessor verfügt. Weitere Informationen finden Sie unter Aufzeichnen von Voice Connector-Anrufen.

Im Diagramm:

-

Ein Anrufer wählt sich mit einer Telefonnummer ein, die einem Amazon Chime SDK Voice Connector zugewiesen ist. Oder ein Agent verwendet eine Voice Connector-Nummer, um einen ausgehenden Anruf zu tätigen.

-

Der Voice Connector-Dienst erstellt eine Transaktions-ID und ordnet sie dem Anruf zu.

-

Ihre Anwendung — z. B. ein Interactive Voice Response-System — oder Ihr Agent informiert den Anrufer über die Anrufaufzeichnung und die Verwendung von Spracheinbettungen für Sprachanalysen und bittet ihn um seine Zustimmung zur Teilnahme.

-

Angenommen, Ihre Anwendung abonniert Ereignisse, ruft Ihre Anwendung die EventBridge CreateMediaInsightsPipelineAPI mit der Media Insights-Pipeline-Konfiguration und Kinesis Video Stream ARNs für den Voice Connector-Anruf.

Weitere Informationen zur Verwendung finden EventBridge Sie unter. Grundlegendes zu Workflows für auf maschinellem Lernen basierende Analysen für das Amazon Chime SDK

-

Sobald der Anrufer seine Zustimmung gegeben hat, kann Ihre Anwendung oder Ihr Mitarbeiter den StartSpeakerSearchTaskAPI über das Voice SDK, wenn Sie über einen Voice Connector und eine Transaktions-ID verfügen. Oder, wenn Sie statt einer Transaktions-ID eine Media Insights-Pipeline-ID haben, rufen Sie die StartSpeakerSearchTaskAPI im Media Pipelines SDK.

Sobald der Anrufer seine Zustimmung erteilt hat, ruft Ihre Anwendung oder Ihr Agent die API auf

StartSpeakerSearchTask. Sie müssen die Voice Connector-ID, die Transaktions-ID und die Domain-ID des Sprachprofils an die API übergeben. Es wird eine Aufgaben-ID für die Lautsprechersuche zurückgegeben, um die asynchrone Aufgabe zu identifizieren. -

Der Benutzer spricht während des gesamten Anrufs.

-

Der Agent spricht während des gesamten Anrufs.

-

Alle 5 Sekunden analysiert die Media Insights-Pipeline mithilfe eines Modells für maschinelles Lernen die letzten 30 Sekunden der Sprache und prognostiziert den Ton des Anrufers für dieses Intervall und für den gesamten Anruf ab dem

StartVoiceToneAnalysisTaskZeitpunkt des ersten Anrufs. -

Die Media Insights-Pipeline sendet eine Benachrichtigung mit diesen Informationen an die konfigurierten Benachrichtigungsziele. Sie können die Benachrichtigung anhand ihres Stream-ARN und ihrer Kanal-ID identifizieren. Weitere Informationen finden Sie weiter Grundlegendes zu Benachrichtigungen für das Amazon Chime SDK unten in diesem Abschnitt.

-

Wiederholen Sie die Schritte 9 und 10, bis der Anruf beendet ist.

-

Am Ende des Anrufs sendet die Media Insights-Pipeline eine letzte Benachrichtigung mit der aktuellen durchschnittlichen Tonvorhersage für die letzten 30 Sekunden sowie dem durchschnittlichen Ton des gesamten Anrufs.

-

Ihre Anwendung ruft den GetVoiceToneAnalysisTaskAPI nach Bedarf, um den neuesten Status der Aufgabe zur Stimmentonanalyse abzurufen.

Anmerkung

Die

GetVoiceToneAnalysisTaskAPI streamt die Tondaten nicht.

Anmerkung

Die GetVoiceToneAnalysisTaskDie API gibt keine Sprachtondaten zurück.