Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Übersicht

Es gibt keine allgemein anerkannte Definition dafür, was ein interpretierbares Modell ist oder welche Informationen für die Interpretation eines Modells geeignet sind. Dieser Leitfaden konzentriert sich auf den häufig verwendeten Begriff der Merkmalswichtigkeit, bei dem ein Wichtigkeitswert für jedes Eingabe-Feature verwendet wird, um zu interpretieren, wie es sich auf die Modellausgaben auswirkt. Diese Methode bietet Einblicke, erfordert aber auch Vorsicht. Bewertungen der Wichtigkeit von Merkmalen können irreführend sein und sollten sorgfältig analysiert werden, einschließlich einer Validierung durch Fachexperten, wenn möglich. Insbesondere raten wir Ihnen, Bewertungen der Wichtigkeit von Funktionen nicht ohne Überprüfung zu vertrauen, da Fehlinterpretationen zu schlechten Geschäftsentscheidungen führen können.

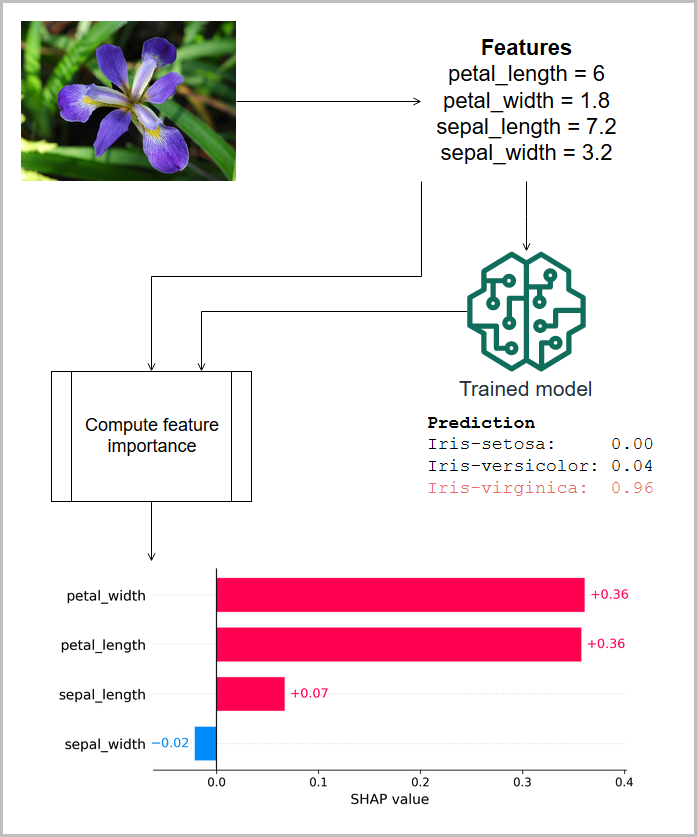

In der folgenden Abbildung werden die gemessenen Merkmale einer Iris in ein Modell übertragen, das die Art der Pflanze vorhersagt, und die damit verbundenen Merkmalsbedeutungen (SHAP-Attributionen) für diese Vorhersage werden angezeigt. In diesem Fall tragen Blütenblattlänge, Blütenblattbreite und Kelchblattlänge alle positiv zur Klassifizierung von Iris virginica bei, die Breite der Kelchblätter dagegen negativ. (Diese Information basiert auf dem Iris-Datensatz aus [4].)

Werte für die Wichtigkeit von Merkmalen können global sein, was bedeutet, dass die Bewertung für das Modell für alle Eingaben gültig ist, oder lokal, was bedeutet, dass die Bewertung für eine einzelne Modellausgabe gilt. Lokale Werte für die Wichtigkeit von Merkmalen werden häufig skaliert und summiert, um den Ausgangswert des Modells zu ermitteln, und werden daher als Attributionen bezeichnet. Einfache Modelle gelten als besser interpretierbar, da die Auswirkungen der Eingabe-Features auf die Modellausgabe leichter zu verstehen sind. In einem linearen Regressionsmodell liefern die Größen der Koeffizienten beispielsweise eine globale Bewertung der Merkmalswichtigkeit, und für eine bestimmte Vorhersage ist eine lokale Feature-Attribution das Produkt aus ihrem Koeffizienten und dem Feature-Wert. Liegt für eine Vorhersage kein direkter Wert für die lokale Merkmalswichtigkeit vor, können Sie einen Wichtigkeitswert aus einer Reihe von Basislinien-Eingabe-Features berechnen, um zu verstehen, welchen Beitrag ein Feature im Verhältnis zur Basislinie leistet.