Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Temperaturskalierung

Bei Klassifizierungsproblemen wird davon ausgegangen, dass die prognostizierten Wahrscheinlichkeiten (Softmax-Ausgabe) die wahre Korrektheitswahrscheinlichkeit für die prognostizierte Klasse darstellen. Obwohl diese Annahme für Modelle vor einem Jahrzehnt vernünftig gewesen sein könnte, gilt dies nicht für die heutigen modernen neuronalen Netzmodelle (Guo et al. 2017) enthalten. Der Verlust der Verbindung zwischen Modellprognostizierungswahrscheinlichkeiten und dem Vertrauen von Modellvorhersagen würde die Anwendung moderner neuronaler Netzmodelle in reale Probleme wie in Entscheidungssystemen verhindern. Die genaue Kenntnis des Konfidenz-Scores von Modellprognosen ist eine der wichtigsten Einstellungen zur Risikokontrolle, die für den Aufbau robuster und vertrauenswürdiger Anwendungen für maschinelles Lernen erforderlich ist.

Moderne neuronale Netzmodelle verfügen in der Regel über große Architekturen mit Millionen von Lernparametern. Die Verteilung der Prognosewahrscheinlichkeiten in solchen Modellen ist oft stark auf 1 oder 0 verzerrt, was bedeutet, dass das Modell zu zuversichtlich ist und der absolute Wert dieser Wahrscheinlichkeiten bedeutungslos sein könnte. (Dieses Problem ist unabhängig davon, ob ein Klassenungleichgewicht im Datensatz vorhanden ist.) In den letzten zehn Jahren wurden verschiedene Kalibrierungsmethoden zur Erstellung eines Prognosekonfidenzpunkts entwickelt, um die naiven Wahrscheinlichkeiten des Modells neu zu kalibrieren. In diesem Abschnitt wird eine Kalibrierungsmethode mit dem Namen beschriebenTemperaturskalierung, was eine einfache und dennoch effektive Technik zur Neukalibrierung von Prognosewahrscheinlichkeiten ist (Guo et al. 2017) enthalten. Die Temperaturskalierung ist eine Einzelparameter-Version von Platt Logistic Scaling (Platt 1999) enthalten.

Die Temperaturskalierung verwendet einen einzigen skalaren ParameterT > 0, woTist die Temperatur, um Logit-Scores vor der Anwendung der Softmax-Funktion neu zu skalieren, wie in der folgenden Abbildung gezeigt. Weil das GleicheTwird für alle Klassen verwendet, die Softmax-Ausgabe mit Skalierung hat eine monotonische Beziehung zur nicht skalierten Ausgabe. WannT= 1, stellen Sie die ursprüngliche Wahrscheinlichkeit mit der Standard-Softmax-Funktion wieder her. In übermütigen Modellen woT > 1 haben die neu kalibrierten Wahrscheinlichkeiten einen niedrigeren Wert als die ursprünglichen Wahrscheinlichkeiten und sind gleichmäßiger zwischen 0 und 1 verteilt.

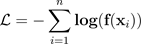

Die Methode, um eine optimale Temperatur zu erhaltenTfür ein geschultes Modell besteht darin, die negative Protokollwahrscheinlichkeit für ein ausgehaltenes Validierungs-Dataset zu minimieren.

Wir empfehlen, die Temperaturskalierungsmethode als Teil des Modelltrainingsprozesses zu integrieren: Extrahieren Sie nach Abschluss eines Modelltrainings den TemperaturwertTindem Sie das Validierungs-Dataset verwenden und dann Logitwerte erneut skalierenTin der Softmax-Funktion. Basierend auf Experimenten in Textklassifizierungsaufgaben unter Verwendung von Bert-basierten Modellen ist die TemperaturTSkaliert normalerweise zwischen 1,5 und 3.

Die folgende Abbildung veranschaulicht die Temperaturskalierungsmethode, die den Temperaturwert anwendetTbevor Sie den Logit-Score an die Softmax-Funktion übergeben.

Die kalibrierten Wahrscheinlichkeiten durch Temperaturskalierung können annähernd den Konfidenzwert von Modellprognosen darstellen. Dies kann quantitativ ausgewertet werden, indem ein Zuverlässigkeitsdiagramm erstellt wird (Guo et al. 2017), was die Ausrichtung zwischen der Verteilung der erwarteten Genauigkeit und der Verteilung der Prognosewahrscheinlichkeiten darstellt.

Die Temperaturskalierung wurde auch als eine effektive Methode zur Quantifizierung der gesamten vorausschauenden Unsicherheit in den kalibrierten Wahrscheinlichkeiten bewertet, ist jedoch nicht robust bei der Erfassung epistemischer Unsicherheit in Szenarien wie Datenverschiebungen (Ovadia et al. 2019) enthalten. Angesichts der einfachen Implementierung empfehlen wir Ihnen, eine Temperaturskalierung auf Ihre Deep-Learning-Modellausgabe anzuwenden, um eine robuste Lösung zur Quantifizierung vorausschauender Unsicherheiten zu entwickeln.