Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Objektlokalisierung in Manifestdateien

Sie können Bilder importieren, die mit Informationen zur Objektlokalisierung beschriftet sind, indem Sie JSON-Zeilen im SageMaker AI Ground Truth Bounding Box Job Output-Format zu einer Manifestdatei hinzufügen.

Lokalisierungsinformationen stellen die Position eines Objekts auf einem Bild dar. Die Position wird durch einen Begrenzungsrahmen dargestellt, der das Objekt umgibt. Die Begrenzungsrahmenstruktur enthält die oberen linken Koordinaten des Begrenzungsrahmens sowie die Breite und Höhe des Begrenzungsrahmens. Eine JSON-Zeile im Begrenzungsrahmen-Format enthält Begrenzungsrahmen für die Positionen eines oder mehrerer Objekte auf einem Bild und die Klasse jedes Objekts auf dem Bild.

Eine Manifestdatei besteht aus einer oder mehreren JSON-Zeilen, wobei jede Zeile die Informationen für ein einzelnes Bild enthält.

So erstellen Sie eine Manifestdatei zur Objektlokalisierung

-

Erstellen Sie eine leere Textdatei.

-

Fügen Sie eine JSON-Zeile für jedes Bild hinzu, das Sie importieren möchten. Jede JSON-Zeile sollte nun etwa folgendermaßen aussehen.

{"source-ref": "s3://bucket/images/IMG_1186.png", "bounding-box": {"image_size": [{"width": 640, "height": 480, "depth": 3}], "annotations": [{ "class_id": 1, "top": 251, "left": 399, "width": 155, "height": 101}, {"class_id": 0, "top": 65, "left": 86, "width": 220, "height": 334}]}, "bounding-box-metadata": {"objects": [{ "confidence": 1}, {"confidence": 1}], "class-map": {"0": "Echo", "1": "Echo Dot"}, "type": "groundtruth/object-detection", "human-annotated": "yes", "creation-date": "2013-11-18T02:53:27", "job-name": "my job"}} -

Speichern Sie die Datei. Sie können die Erweiterung

.manifestverwenden, sie ist jedoch nicht erforderlich. -

Erstellen Sie mit der Datei, die Sie gerade erstellt haben, einen Datensatz. Weitere Informationen finden Sie unter So erstellen Sie einen Datensatz mit einer Manifestdatei im SageMaker AI Ground Truth Format (Konsole).

JSON-Zeilen, die das Objekt begrenzen

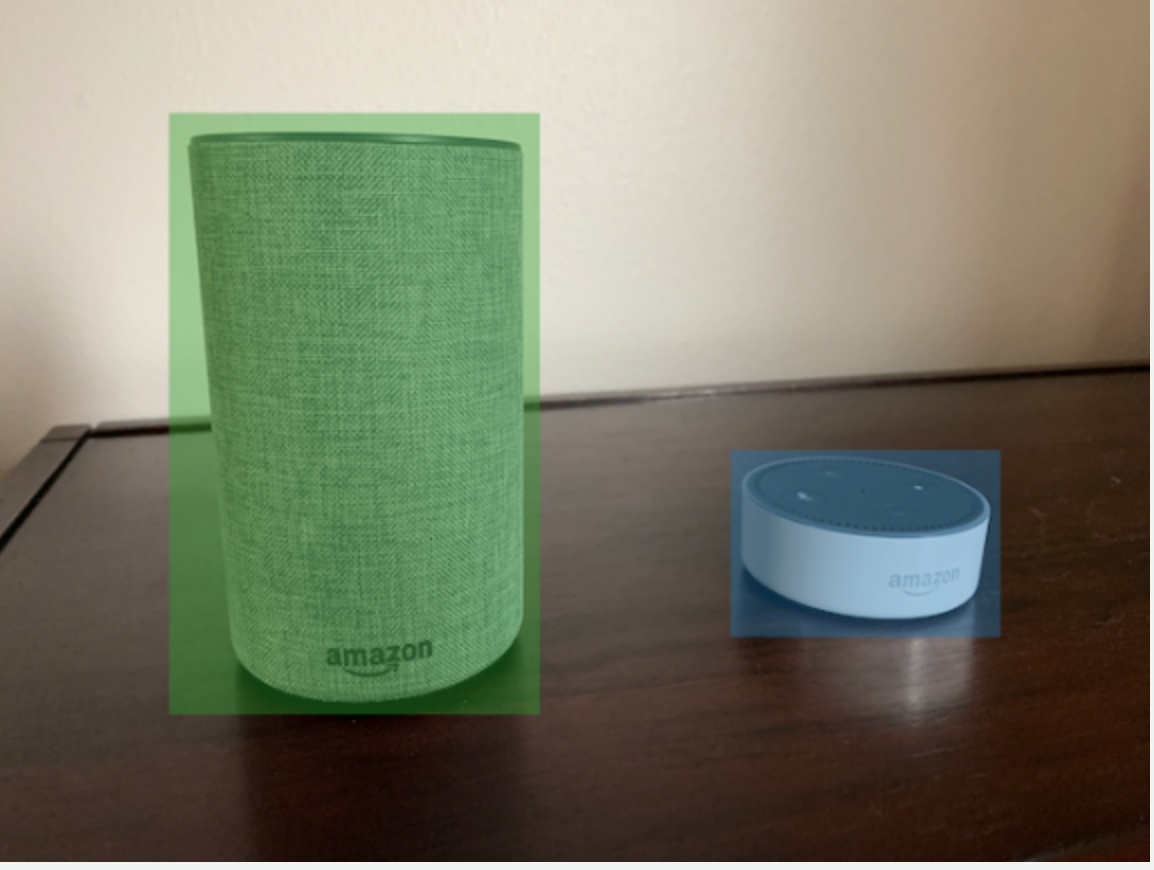

In diesem Abschnitt zeigen wir Ihnen, wie Sie eine JSON-Zeile für ein einzelnes Bild erstellen. Das folgende Bild zeigt Begrenzungsrahmen rund um Amazon Echo- und Amazon Echo Dot-Geräte.

Das Folgende ist die JSON-Begrenzungsrahmen-Zeile für das vorherige Bild.

{ "source-ref": "s3://custom-labels-bucket/images/IMG_1186.png", "bounding-box": { "image_size": [{ "width": 640, "height": 480, "depth": 3 }], "annotations": [{ "class_id": 1, "top": 251, "left": 399, "width": 155, "height": 101 }, { "class_id": 0, "top": 65, "left": 86, "width": 220, "height": 334 }] }, "bounding-box-metadata": { "objects": [{ "confidence": 1 }, { "confidence": 1 }], "class-map": { "0": "Echo", "1": "Echo Dot" }, "type": "groundtruth/object-detection", "human-annotated": "yes", "creation-date": "2013-11-18T02:53:27", "job-name": "my job" } }

Notieren Sie die folgenden Informationen:

Quellennachweis

(Erforderlich) Der Amazon S3-Speicherort des Bildes. Das Format ist "s3://. Bilder in einem importierten Datensatz müssen im gleichen Amazon-S3-Bucket gespeichert werden. BUCKET/OBJECT_PATH"

bounding-box

(Erforderlich) Das Label-Attribut. Sie wählen den Feldnamen. Enthält die Bildgröße und die Begrenzungsrahmen für jedes Objekt, das im Bild erkannt wurde. Es müssen entsprechende Metadaten vorhanden sein, die durch den Feldnamen mit angehängtem -Metadaten identifiziert werden. Beispiel, "bounding-box-metadata".

- Bildgröße

-

(Erforderlich) Ein Array mit einem einzelnen Element, das die Größe des Bildes in Pixeln enthält.

-

Höhe - (Erforderlich) Die Höhe, in Pixeln, des Bildes.

-

Breite — (Erforderlich) Die Tiefe des Bildes in Pixeln.

-

Tiefe — (Erforderlich) Die Anzahl der Kanäle im Bild. Die Wert für RGB-Bilder ist 3. Wird derzeit nicht von Amazon Rekognition Custom Labels verwendet, aber ein Wert ist erforderlich.

-

- Anmerkungen

-

(Erforderlich) Eine Reihe von Bounding-Box-Informationen für jedes Objekt, das im Bild erkannt wurde.

-

Klassen_ID — (Erforderlich) Ordnet dem Label in Klassenzuordnung zu. Im vorherigen Beispiel ist das Objekt mit der Klassen_ID von

1der Echo Dot im Bild. -

oben — (Erforderlich) Der Abstand zwischen dem oberen Bildrand und dem oberen Rand des Begrenzungsrahmens in Pixeln.

-

links — (Erforderlich) Der Abstand von der linken Seite des Bilds zur linken Seite des Begrenzungsrahmens in Pixeln.

-

Breite — (Erforderlich) Die Breite des Begrenzungsrahmens in Pixeln.

-

Höhe - (Erforderlich) Die Höhe des Begrenzungsrahmens in Pixeln.

-

bounding-box-Metadaten

(Erforderlich) Metadaten zum Label-Attribut. Der Feldname muss mit dem Label-Attribut identisch sein, wobei -Metadaten angehängt ist. Eine Reihe von Begrenzungsrahmen-Informationen für jedes Objekt, das im Bild erkannt wurde.

- Objekte

-

(Erforderlich) Ein Array von Objekten im Bild. Ordnet dem Array Anmerkungen nach Index zu. Das Vertrauensattribut wird von Amazon Rekognition Custom Labels nicht verwendet.

- Klassenzuordnung

-

(Erforderlich) Eine Zuordnung der Klassen, die für die im Bild erkannten Objekte gelten.

- Typ

-

(Erforderlich) Der Typ des Klassifizierungsauftrags.

"groundtruth/object-detection"identifiziert den Job als Objekterkennung. - Erstellungsdatum

-

(Erforderlich) Das Datum und die Uhrzeit in koordinierter Weltzeit (UTC), zu der das Label erstellt wurde.

- Mit menschlichen Anmerkungen versehen

-

(Erforderlich) Geben Sie

"yes"an, wenn die Anmerkung von einem Menschen ausgefüllt wurde. Andernfalls"no". - Jobname

-

(Optional) Der Name des Jobs, der das Bild verarbeitet.