Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Erkennen von Videosegmenten in gespeicherten Videos

Amazon Rekognition Video bietet eine API, die nützliche Videosegmente wie schwarze Frames und Abspann identifiziert.

Heute werden Menschen mehr Inhalte als jemals zuvor präsentiert. Insbesondere die Plattformen Over-The-Top (OTT) und Video-On-Demand (VOD) bieten jederzeit, überall und auf jedem Bildschirm eine große Auswahl an Inhalten. Angesichts der wachsenden Inhaltsvolumina stehen Medienunternehmen vor Herausforderungen bei der Vorbereitung und Verwaltung ihrer Inhalte. Dies ist sehr wichtig, um hochwertigen Benutzerkomfort bereitzustellen und Inhalte besser monetarisieren zu können. Heute verwenden Unternehmen große Teams speziell geschulter Arbeitskräfte, um Aufgaben wie die folgenden zu erfüllen.

-

Herausfinden, wo sich der Vor- und Abspann in einem Inhalt befindet

-

Auswahl der richtigen Stellen zum Einfügen von Werbung, z. B. in stillen schwarzen Frame-Sequenzen

-

Aufteilen von Videos in kleinere Clips für eine einfachere Indizierung.

Diese manuellen Prozesse sind teuer, langsam und können nicht skaliert werden, um mit der Menge an Inhalten, die täglich produziert, lizenziert und aus Archiven abgerufen werden, Schritt zu halten.

Sie können Amazon Rekognition Video verwenden, um betriebliche Medienanalyseaufgaben mithilfe einer vollständig verwalteten, speziell entwickelten Videosegmenterkennung auf APIs Basis von maschinellem Lernen (ML) zu automatisieren. Mithilfe des Amazon Rekognition Video-Segments APIs können Sie problemlos große Videomengen analysieren und Markierungen wie schwarze Bilder oder Veränderungen bei der Aufnahme erkennen. Sie erhalten Zeitcodes, Zeitstempel und Bildnummern von SMPTE (Society of Motion Picture and Television Engineers) zu jeder Erkennung. ML-Erfahrung ist nicht erforderlich.

Amazon Rekognition Video analysiert Videos, die in einem Amazon-Simple-Storage-Service-Bucket (Amazon S3) gespeichert sind. Die zurückgegebenen SMPTE-Zeitcodes sind bildgenau – Amazon Rekognition Video liefert die genaue Bildnummer eines erkannten Videosegments und verarbeitet automatisch verschiedene Video-Bildratenformate. Sie können die Frame-genauen Metadaten aus Amazon Rekognition Video verwenden, um bestimmte Aufgaben vollständig zu automatisieren oder den Prüfungsaufwand für geschulte menschliche Bediener erheblich zu reduzieren, damit diese sich auf kreativere Arbeiten konzentrieren können. Sie können Aufgaben wie die Vorbereitung von Inhalten, das Einfügen von Werbung und das Hinzufügen von „Binge-Markern“ zu Inhalten in großem Umfang in der Cloud durchführen.

Informationen zu Preisen finden Sie unter Amazon Rekognition – Preise

Die Segmenterkennung von Amazon Rekognition Video unterstützt zwei Arten von Segmentierungsaufgaben: Technische Signale-Erkennung und Einstellungserkennung.

Themen

Technische Signale

Ein technisches Signal kennzeichnet schwarze Frames, Farbbalken, Vor- und Abspänne, Studiologos und primäre Programminhalte in einem Video.

Schwarze Frames

Videos enthalten oft leere schwarze Frames ohne Ton, die dazu dienen, Werbung einzufügen oder das Ende eines Programmabschnitts zu markieren, z. B. einer Szene oder eines Vorspanns. Mit Amazon Rekognition Video können Sie Sequenzen mit schwarzen Frames erkennen, um die Schaltung von Werbung zu automatisieren, Inhalte für VOD zu verpacken oder verschiedene Programmteile oder Szenen abzugrenzen. Schwarze Frames mit Ton (wie z. B. Ausblendungen oder Voiceover-Passagen) werden als Inhalt betrachtet und nicht zurückgegeben.

Guthaben

Amazon Rekognition Video kann automatisch die genauen Frames identifizieren, in denen der Vor- und Abspann eines Films oder einer Fernsehsendung beginnt und endet. Mit diesen Informationen können Sie in Video-on-Demand-Anwendungen (VOD) „Binge-Marker“ oder interaktive Zuschaueraufforderungen wie „Nächste Folge“ oder „Vorspann überspringen“ generieren. Sie können auch den ersten und den letzten Frame des Programminhalts in einem Video erkennen. Amazon Rekognition Video ist darauf trainiert, mit einer Vielzahl von Eröffnungs- und Abschlussarten umzugehen, von einfachen rollierenden Krediten bis hin zu anspruchsvolleren Abrechnungen neben Inhalten.

Farbbalken

Mit Amazon Rekognition Video können Sie Videoabschnitte erkennen, die SMPTE-Farbbalken zeigen. Dabei handelt es sich um eine Reihe von Farben, die in bestimmten Mustern angezeigt werden, damit die Farben auf Monitoren, in Programmen und in Kameras richtig eingestellt sind. Weitere Informationen zu SMPTE-Farbbalken finden Sie unter SMPTE-Farbbalken

Slates

Slates sind Abschnitte des Videos, die in der Regel am Anfang stehen und Textmetadaten zur Folge, zum Studio, zum Videoformat, zu den Audiokanälen und mehr enthalten. Amazon Rekognition Video kann den Anfang und das Ende von Slates erkennen, sodass es einfach ist, die Textmetadaten zu verwenden oder die Slate zu entfernen, wenn Inhalte für die endgültige Ansicht vorbereitet werden.

Studiologos

Studiologos sind Sequenzen, die die Logos oder Embleme des Produktionsstudios zeigen, das an der Produktion der Show beteiligt war. Amazon Rekognition Video kann diese Sequenzen erkennen, sodass Benutzer sie überprüfen können, um Studios zu identifizieren.

Inhalt

Inhalt sind die Teile der Fernsehsendung oder des Films, die das Programm oder verwandte Elemente enthalten. Schwarze Frames, Quellenangaben, Farbbalken, Slates und Studiologos gelten nicht als Inhalt. Amazon Rekognition Video kann den Anfang und das Ende jedes Inhaltssegments im Video erkennen, sodass Sie die Laufzeit des Programms oder bestimmte Segmente ermitteln können.

Zu den Inhaltssegmenten gehören unter anderem:

-

Programmszenen zwischen zwei Werbepausen

-

Eine kurze Zusammenfassung der vorherigen Folge am Anfang des Videos

-

Bonus-Inhalt nach dem Abspann

-

„Textloser“ Inhalt, z. B. eine Zusammenstellung aller Programmszenen, die ursprünglich überlagerten Text enthielten, bei denen der Text jedoch entfernt wurde, um die Übersetzung in andere Sprachen zu ermöglichen.

Nachdem Amazon Rekognition Video die Erkennung aller Inhaltssegmente abgeschlossen hat, können Sie Domänenwissen anwenden oder die Segmente einer menschlichen Überprüfung unterziehen, um sie weiter zu kategorisieren. Wenn Sie beispielsweise Videos verwenden, die immer mit einer Zusammenfassung beginnen, könnten Sie das erste Inhaltssegment als Zusammenfassung kategorisieren.

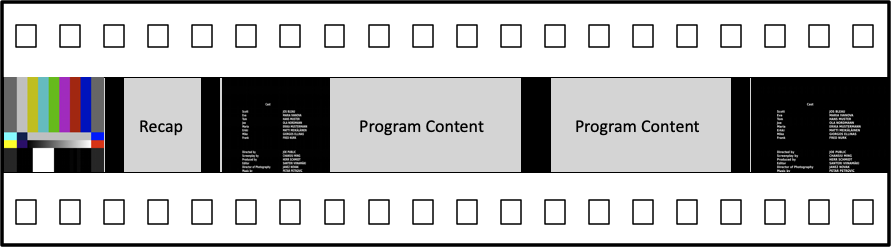

Das folgende Diagramm zeigt technische Signalsegmente auf der Zeitachse einer Show oder eines Films. Beachten Sie die Farbbalken und den Vorspann, Inhaltssegmente wie Zusammenfassung und Hauptprogramm, schwarze Frames im gesamten Video und den Abspann.

Einstellungserkennung

Eine Einstellung besteht aus einer Reihe von aufeinander folgenden, zusammenhängenden Bildern, die von einer einzigen Kamera aufgenommen werden und eine kontinuierliche Aktion in Zeit und Raum darstellen. Mit Amazon Rekognition Video können Sie den Anfang, das Ende und die Dauer jeder Aufnahme sowie die Anzahl aller Aufnahmen in einem Inhaltsstück erkennen. Sie können Einstellungsmetadaten für Aufgaben wie die folgenden verwenden.

-

Erstellen von Werbevideos mit ausgewählten Einstellungen.

-

Einfügen von Werbung an Stellen, an denen der Zuschauer nicht gestört wird, z. B. nicht in der Mitte einer Einstellung, wenn jemand spricht.

-

Generieren einer Reihe von Vorschau-Miniaturansichten, die Übergangsinhalte zwischen Einstellungen vermeiden.

Die Einstellungserkennung markiert die exakte Stelle, an der ein harter Schnitt auf eine andere Kamera erfolgt. Bei einem weichen Übergang von einer Kamera zu einer anderen lässt Amazon Rekognition Video den Übergang aus. Dadurch wird sichergestellt, dass Start- und Endzeiten keine Abschnitte ohne eigentlichen Inhalt enthalten.

Das folgende Diagramm zeigt Einstellungserkennungssegmente in einem Film. Beachten Sie, dass jede Einstellung durch einen Schnitt von einem Kamerawinkel oder einer Position zum/zur nächsten identifiziert wird.

Über die Amazon-Rekognition-Video-Segmenterkennungs-API

Um ein gespeichertes Video zu segmentieren, verwenden Sie die asynchronen Operationen StartSegmentDetectionund GetSegmentDetectionAPI-Operationen, um einen Segmentierungsjob zu starten und die Ergebnisse abzurufen. Die Segmenterkennung akzeptiert Videos, die in einem Amazon-S3-Bucket gespeichert sind, und gibt eine JSON-Ausgabe zurück. Sie können wählen, ob nur technische Signale, nur Einstellungsänderungen oder beides zusammen erkannt werden sollen, indem Sie die Amazon-Rekognition-Video-API--StartSegmentdetectionAnforderung konfigurieren. Sie können erkannte Segmente auch filtern, indem Sie Schwellenwerte für eine minimale Prognosegenauigkeit festlegen. Weitere Informationen finden Sie unter Verwenden der Amazon-Rekognition-Segment-API . Beispielcode finden Sie unter Beispiel: Erkennen von Segmenten in einem gespeicherten Video.