Ya no actualizamos el servicio Amazon Machine Learning ni aceptamos nuevos usuarios para él. Esta documentación está disponible para los usuarios actuales, pero ya no la actualizamos. Para obtener más información, consulte Qué es Amazon Machine Learning.

Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Información sobre modelos binarios

Interpretación de las predicciones

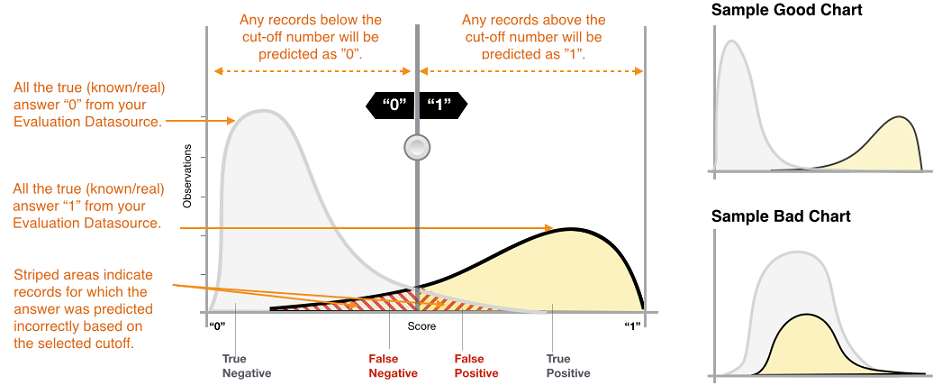

El resultado real de muchos algoritmos de clasificación binaria es una puntuación de predicción. La puntuación indica la certeza del sistema de que la observación determinada pertenece a la clase positiva (el valor objetivo real es de 1). Los modelos de clasificación binaria en Amazon ML producen una puntuación que oscila entre 0 y 1. Como consumidor de esta puntuación, para tomar la decisión sobre si la observación debe clasificarse como 1 o 0, interpreta la puntuación seleccionando un umbral de clasificación o de corte y compara la puntuación con dicho umbral. Cualquier observación con puntuaciones superiores al valor de corte se predice como objetivo = 1 y las puntuaciones inferiores al corte, se predicen como objetivo = 0.

En Amazon ML, el corte de puntuación predeterminado es 0,5. Puede decidir actualizar este límite para que se ajuste a sus necesidades de negocio. Puede utilizar las visualizaciones en la consola para comprender cómo afectará la selección de corte a su aplicación.

Medición de la precisión del modelo de ML

Amazon ML proporciona una métrica de precisión estándar del sector para modelos de clasificación binaria denominada Area Under the (Receiver Operating Characteristic) Curve (AUC). AUC mide la capacidad del modelo de predecir una mayor puntuación para ejemplos positivos en comparación con ejemplos negativos. Dado que es independiente del corte de puntuación, puede hacerse una idea de la precisión de la predicción de su modelo a partir de la métrica de AUC sin elegir un umbral.

La métrica AUC devuelve un valor decimal comprendido entre 0 y 1. Los valores de AUC próximos a 1 indican un modelo de aprendizaje automático muy preciso. Los valores cercanos a 0,5 indican un modelo de ML que no es mejor que hacer una suposición al azar. No es habitual ver valores cercanos a 0 y suelen indicar un problema con los datos. Básicamente, una AUC cercana a 0 indica que el modelo de ML ha aprendido los patrones correctos, pero que los utiliza para realizar predicciones contrarios a la realidad (Los '0' se predicen como '1' y viceversa). Para obtener más información acerca de la AUC, vaya a la página de Curva ROC

La métrica de AUC de referencia para un modelo binario es 0,5. Es el valor de un modelo de ML hipotético que predice aleatoriamente una respuesta de 1 o 0. El modelo de ML binario debe funcionar mejor que este valor para comenzar a ser de utilidad.

Uso de la visualización del desempeño

Para explorar la precisión del modelo de ML, puede revisar los gráficos en la página Evaluación en la consola de Amazon ML. Esta página muestra dos histogramas: a) un histograma de las puntuaciones de los positivos reales (el objetivo es 1) y b) un histograma de las puntuaciones de negativos reales (el objetivo es 0) en los datos de evaluación.

Un modelo de ML que tiene buena precisión predictiva predecirá puntuaciones más altas que los 1 reales y puntuaciones más bajas que los 0 reales. Un modelo perfecto tendrá los dos histogramas en dos extremos diferentes del eje x que demuestren que todos los positivos reales han obtenido puntuaciones altas y que todos los negativos reales han obtenido puntuaciones bajas. No obstante, los modelos de ML cometen errores y un gráfico típico demostrará que los dos histogramas se solapan en determinadas puntuaciones. Un modelo de rendimiento extremadamente deficiente no podrá distinguir entre las clases positivas y negativas, y ambas clases tendrán principalmente histogramas que se solapan.

Mediante las visualizaciones, puede identificar el número de predicciones que pertenecen a los dos tipos de predicciones correctas y a los dos tipos de predicciones incorrectas.

Predicciones correctas

-

Positivo real (TP): Amazon ML ha predicho el valor como 1 y el valor real es 1.

-

Negativo real (TN): Amazon ML ha predicho el valor como 0 y el valor real es 0.

Predicciones erróneas

-

Positivo falso (FP): Amazon ML ha predicho el valor como 1 pero el valor real es 0.

-

Negativo falso (FN): Amazon ML ha predicho el valor como 0 pero el valor real es 1.

nota

El número de TP, TN, FP y FN depende del umbral de puntuación seleccionado y la optimización de cualquiera de uno de estos números supondría realizar una compensación en los demás. Un número alto de TPs normalmente da como resultado un número alto FPs y un número bajo de TNs.

Ajuste del corte de la puntuación

Los modelos de ML funcionan generando puntuaciones de predicciones numéricas y, a continuación, aplicando un corte para convertir estas puntuaciones en etiquetas 0/1 binarias. Al cambiar el corte de puntuación, puede ajustar el comportamiento del modelo cuando comete un error. En la página Evaluación de la consola de Amazon ML, puede comprobar el impacto de distintos cortes de puntuación y puede guardar el corte de puntuación que desee utilizar para su modelo.

Al ajustar el umbral de corte de puntuación, observe la compensación entre los dos tipos de errores. Al desplazar el corte a la izquierda, capta más positivos reales, pero la compensación produce un aumento del número de errores positivos falsos. Al desplazarlo a la derecha, capta menos errores positivos falsos, pero a cambio no captará algunos positivos verdaderos. Para su aplicación predictiva, usted decide qué tipo de error es más tolerable seleccionando una puntuación de corte adecuada.

Revisión de la métrica avanzada

Amazon ML ofrece las siguientes métricas adicionales para medir la precisión predictiva del modelo de ML: exactitud, precisión, exhaustividad y tasa de falsos positivos.

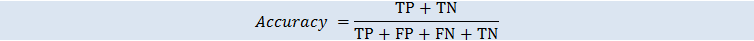

Exactitud

La exactitud (ACC) mide la fracción de predicciones correctas. El rango va de 0 a 1. Un mayor valor indica una mayor exactitud predictiva:

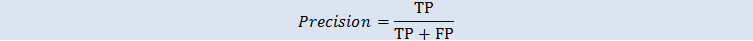

Precisión

La precisión mide la fracción de positivos reales entre los ejemplos que se prevén como positivos. El rango va de 0 a 1. Un mayor valor indica una mayor exactitud predictiva:

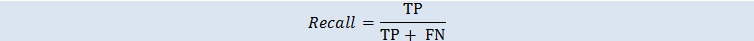

Exhaustividad

La exhaustividad mide la fracción de positivos reales que se prevén como positivos. El rango va de 0 a 1. Un mayor valor indica una mayor exactitud predictiva:

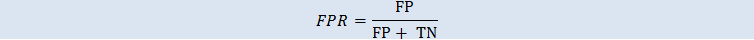

Tasa de positivos falsos

La tasa de positivos falsos (FPR) mide la tasa de alarma falsa o la fracción de los negativos reales que se prevén como positivos. El rango va de 0 a 1. Un valor bajo indica una mayor exactitud predictiva:

En función del problema de su negocio, puede que le interese más un modelo que funcione bien para un subconjunto concreto de estas métricas. Por ejemplo, dos aplicaciones de negocio podrían tener requisitos muy diferentes para su modelos de ML:

-

Una aplicación podría necesitar estar muy segura de que las predicciones positivas sean realmente positivas (alta precisión) y podría permitirse la clasificación incorrecta de algunos ejemplos positivos como negativos (exhaustividad moderada).

-

Otra aplicación podría necesitar predecir correctamente el mayor número de ejemplos positivos posible (exhaustividad elevada) y aceptaría que algunos ejemplos negativos se clasifiquen incorrectamente como positivos (precisión moderada).

Amazon ML le permite elegir un corte de puntuación que se corresponda con un valor determinado de cualquiera de las métricas avanzadas anteriores. También muestra las compensaciones que se generan con la optimización de cualquier métrica. Por ejemplo, si selecciona un corte que se corresponde con una alta precisión, normalmente tendrá que compensarlo con una menor exhaustividad.

nota

Debe guardar el corte de puntuación para que surta efecto al clasificar las futuras predicciones realizadas por modelo de ML.