Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Información general

No existe una definición universalmente aceptada sobre qué es un modelo interpretable o qué información es adecuada como interpretación de un modelo. Esta guía se centra en la noción comúnmente utilizada de la importancia de las características, en la que se utiliza una puntuación de importancia para cada característica de entrada para interpretar cómo afecta a los resultados del modelo. Este método proporciona información, pero también requiere precaución. Las puntuaciones en torno a la importancia de las características pueden ser engañosas y deben analizarse detenidamente, incluida la validación con expertos en la materia si es posible. En concreto, le recomendamos que no confíe en las puntuaciones de importancia de las características sin verificarlas, ya que las interpretaciones erróneas pueden conducir a tomar malas decisiones empresariales.

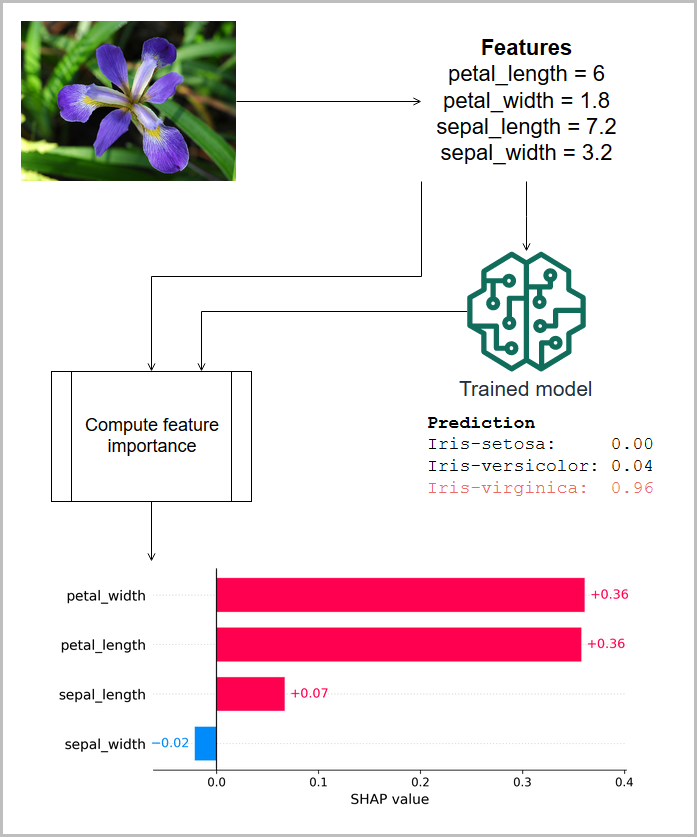

En la siguiente ilustración, las características medidas de un iris se pasan a un modelo que predice la especie de la planta, y se muestra la importancia de las características asociadas (atribuciones de SHAP) para esta predicción. En este caso, la longitud del pétalo, el ancho y el largo del sépalo contribuyen de manera positiva a la clasificación de Iris virginica, pero el ancho del sépalo tiene una contribución negativa. (Esta información se basa en el conjunto de datos sobre el iris de [4]).

Las puntuaciones de importancia de las características pueden ser globales, lo que indica que la puntuación es válida para el modelo en todas las entradas, o locales, lo que indica que la puntuación se aplica a la salida de un único modelo. Las puntuaciones de importancia de las características locales suelen escalarse y sumarse para obtener el valor de salida del modelo y, por lo tanto, se denominan atribuciones. Los modelos simples se consideran más interpretables, porque los efectos de las características de entrada en la salida del modelo se comprenden más fácilmente. Por ejemplo, en un modelo de regresión lineal, las magnitudes de los coeficientes proporcionan una puntuación global de importancia de una característica y, para una predicción dada, la atribución de una característica local es el producto de su coeficiente y el valor de la característica. En ausencia de una puntuación de importancia de una característica local directa para una predicción, puede calcular una puntuación de importancia a partir de un conjunto de características de entrada de base de referencia para comprender cómo contribuye una característica en relación con la base de referencia.