Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Escalado de temperatura

En los problemas de clasificación, se supone que las probabilidades pronosticadas (salida softmax) representan la probabilidad de corrección real de la clase pronosticada. Sin embargo, aunque esta suposición podría haber sido razonable para los modelos de hace una década, no lo es para los modelos de redes neuronales modernos de hoy en día (Guo et al. 2017). La pérdida de conexión entre las probabilidades de predicción de los modelos y la confianza en las predicciones de los modelos impediría la aplicación de los modelos modernos de redes neuronales a problemas del mundo real, como en los sistemas de toma de decisiones. Conocer con precisión la puntuación de confianza de las predicciones de los modelos es uno de los parámetros de control de riesgos más importantes que se requieren para crear aplicaciones de machine learning sólidas y fiables.

Los modelos de redes neuronales modernos suelen tener arquitecturas grandes con millones de parámetros de aprendizaje. La distribución de las probabilidades de predicción en estos modelos suele estar muy sesgada, ya sea de 1 o 0, lo que significa que el modelo se basa en un exceso de confianza y el valor absoluto de estas probabilidades podría carecer de sentido. (Este problema es independiente de si el conjunto de datos presenta un desequilibrio de clases). En los últimos diez años, se han desarrollado varios métodos de calibración para crear una puntuación de confianza en la predicción mediante pasos posteriores al procesamiento para recalibrar las probabilidades primitivas del modelo. En esta sección se describe un método de calibración denominado escalado de temperatura, que es una técnica sencilla pero eficaz para recalibrar las probabilidades de predicción (Guo et al., 2017). El escalado de temperatura es una versión de un solo parámetro de Platt Logistic Scaling (Platt 1999).

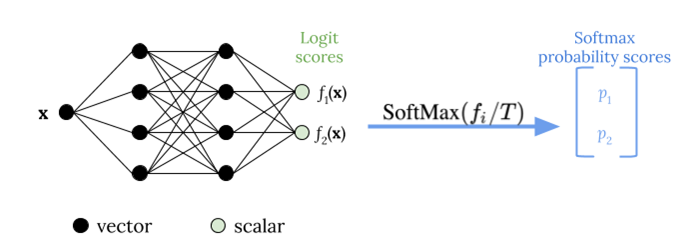

La escala de temperatura utiliza un único parámetro escalar T > 0, donde T es la temperatura, para cambiar la escala de las puntuaciones logit antes de aplicar la función softmax, como se muestra en la siguiente figura. Como se usa la misma T para todas las clases, la salida softmax con escalado tiene una relación monótona con la salida sin escalar. Cuando T = 1, se recupera la probabilidad original con la función softmax predeterminada. En los modelos de exceso de confianza en los que T > 1, las probabilidades recalibradas tienen un valor inferior al de las probabilidades originales y se distribuyen de forma más uniforme entre 0 y 1.

El método para obtener una temperatura T óptima para un modelo entrenado consiste en minimizar la probabilidad logarítmica negativa de un conjunto de datos de validación retenido.

Le recomendamos que integre el método de escalado de temperatura como parte del proceso de entrenamiento del modelo: Una vez finalizado el entrenamiento del modelo, extraiga el valor de temperatura T mediante el conjunto de datos de validación y, a continuación, cambie la escala de los valores logit mediante T en la función softmax. Según los experimentos realizados en tareas de clasificación de textos con modelos basados en BERT, la temperatura T suele oscilar entre 1,5 y 3.

La siguiente figura ilustra el método de escalado de temperatura, que aplica el valor de temperatura T antes de pasar la puntuación logit a la función softmax.

Las probabilidades calibradas mediante la escalada de temperatura pueden representar aproximadamente la puntuación de confianza de las predicciones del modelo. Esto se puede evaluar cuantitativamente mediante la creación de un diagrama de fiabilidad (Guo et al. 2017), que representa la alineación entre la distribución de la precisión esperada y la distribución de las probabilidades de predicción.

La escalada de temperatura también se ha evaluado como una forma eficaz de cuantificar la incertidumbre predictiva total en las probabilidades calibradas, pero no es sólida a la hora de captar la incertidumbre epistémica en escenarios como las derivas de datos (Ovadia et al. 2019). Dada la facilidad de implementación, le recomendamos que aplique la escalada de temperatura a los resultados de su modelo de aprendizaje profundo a fin de crear una solución sólida para cuantificar las incertidumbres predictivas.