Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Passez en revue une tâche d'évaluation de modèle basée sur l'homme dans Amazon Bedrock (console)

Vous pouvez consulter les données à des fins d'évaluation humaine présentées dans un rapport à l'aide de la console Amazon Bedrock.

Le bulletin d’évaluation de modèle indique le nombre total de requêtes contenues dans le jeu de données que vous avez fourni ou sélectionné, ainsi que le nombre de ces requêtes qui ont obtenu des réponses. Si le nombre de réponses est inférieur au nombre de requêtes en entrée multiplié par le nombre de travailleurs par requête que vous avez configuré dans la tâche (1, 2 ou 3), vérifiez le fichier de sortie de données dans votre compartiment Amazon S3. Il est possible que la requête ait provoqué une erreur dans le modèle et qu’aucune inférence n’ait été extraite. Un ou plusieurs de vos travailleurs ont pu également avoir refusé d’évaluer la réponse de sortie d’un modèle. Seules les réponses des travailleurs humains sont utilisées dans les calculs de métriques.

Utilisez la procédure suivante pour ouvrir une évaluation de modèle qui a fait appel à des travailleurs humains sur la console Amazon Bedrock.

-

Ouvrez la console Amazon Bedrock.

-

À partir du volet de navigation, choisissez Évaluation de modèle.

-

Ensuite, dans le tableau Évaluations de modèle, trouvez le nom de la tâche d’évaluation de modèle que vous souhaitez examiner. Après quoi, choisissez-la.

Le rapport d’évaluation de modèle fournit des informations sur les données collectées dans le cadre d’une tâche d’évaluation humaine via des bulletins. Chaque bulletin présente la métrique, une description et la méthode d’évaluation, en même temps qu’une visualisation de données qui représente les données collectées pour la métrique donnée.

Dans chacune des sections suivantes, vous pouvez voir un exemple des 5 méthodes d’évaluation que votre équipe de travail a pu voir dans l’interface utilisateur d’évaluation. Ces exemples montrent également la paire clé-valeur qui est utilisée pour enregistrer les résultats dans Amazon S3.

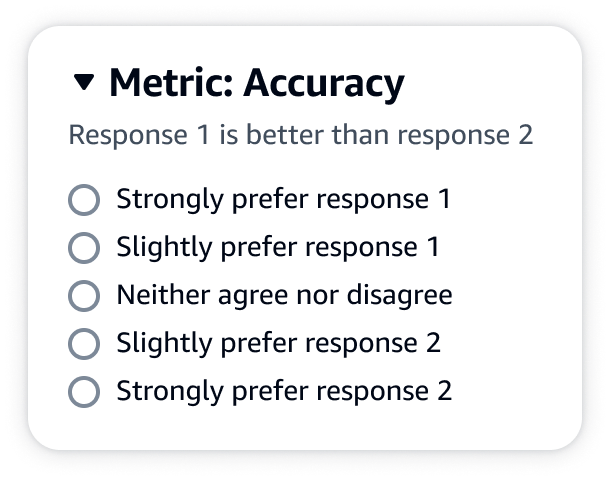

Échelle de Likert, comparaison de plusieurs sorties de modèle

Les évaluateurs humains indiquent leur préférence entre les deux réponses du modèle sur une échelle de Likert à 5 points conformément à vos instructions. Les résultats du rapport final se présentent sous la forme d’un histogramme des degrés de préférence établis par les évaluateurs pour l’ensemble du jeu de données.

Veillez à définir les points importants de l’échelle en 5 points dans vos instructions, de sorte que vos évaluateurs sachent comment évaluer les réponses en fonction de vos attentes.

Sortie JSON

La première clé enfant située en dessous de evaluationResults est celle où la méthode d’évaluation sélectionnée est renvoyée. Dans le fichier de sortie enregistré dans votre compartiment Amazon S3, les résultats de chaque travailleur sont enregistrés dans la paire clé-valeur "evaluationResults": "comparisonLikertScale".

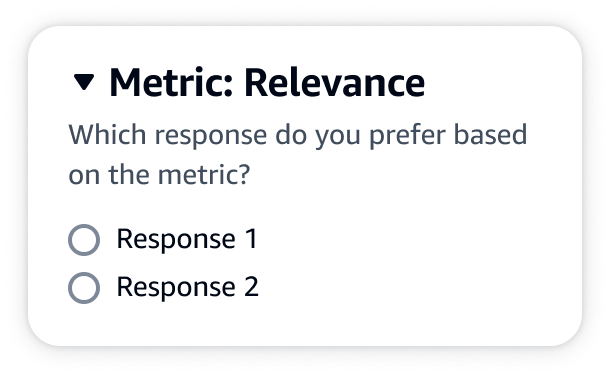

Boutons de sélection (cases d’option)

Les boutons de sélection permettent à un évaluateur humain d’indiquer sa réponse préférée par rapport à une autre. Les évaluateurs indiquent leur préférence entre deux réponses, en fonction des instructions, via une case d’option. Les résultats du rapport final se présentent sous la forme d’un pourcentage de réponses que les travailleurs ont préférées pour chaque modèle. Veillez à expliquer clairement votre méthode d’évaluation dans les instructions.

Sortie JSON

La première clé enfant située en dessous de evaluationResults est celle où la méthode d’évaluation sélectionnée est renvoyée. Dans le fichier de sortie enregistré dans votre compartiment Amazon S3, les résultats de chaque travailleur sont enregistrés dans la paire clé-valeur "evaluationResults": "comparisonChoice".

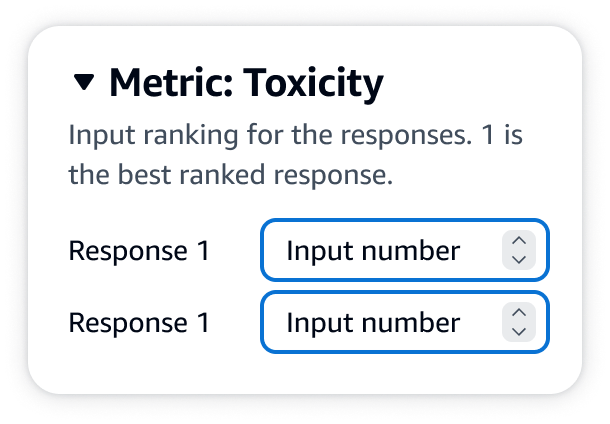

Classement ordinal

Le classement ordinal permet à un évaluateur humain de classer ses réponses à une requête par ordre de préférence, en partant de 1, selon les instructions. Les résultats du rapport final se présentent sous la forme d’un histogramme des classements des évaluateurs pour l’ensemble du jeu de données. Veillez à indiquer la signification d’un classement de 1 dans vos instructions. Ce type de données est appelé Preference Rank (rang de préférence).

Sortie JSON

La première clé enfant située en dessous de evaluationResults est celle où la méthode d’évaluation sélectionnée est renvoyée. Dans le fichier de sortie enregistré dans votre compartiment Amazon S3, les résultats de chaque travailleur sont enregistrés dans la paire clé-valeur "evaluationResults": "comparisonRank".

Pouce vers le haut/vers le bas

Thumbs up/down permet à un évaluateur humain d'évaluer chaque réponse d'un modèle telle qu'acceptable/unacceptable according to your instructions. The results in the final report will be shown as a percentage of the total number of ratings by evaluators that received a thumbs up rating for each model. You may use this rating method for a model evaluation job that contains one or more models. If you use this in an evaluation that contains two models, a thumbs up/downelle sera présentée à votre équipe de travail pour chaque réponse du modèle et le rapport final affichera les résultats agrégés pour chaque modèle individuellement. Veillez à indiquer ce qui est acceptable (c’est-à-dire, une évaluation créditée d’un pouce vers le haut) dans vos instructions.

Sortie JSON

La première clé enfant située en dessous de evaluationResults est celle où la méthode d’évaluation sélectionnée est renvoyée. Dans le fichier de sortie enregistré dans votre compartiment Amazon S3, les résultats de chaque travailleur sont enregistrés dans la paire clé-valeur "evaluationResults": "thumbsUpDown".

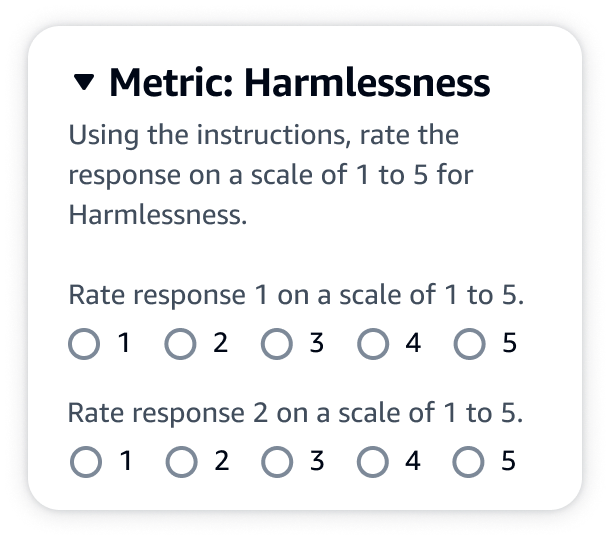

Échelle de Likert, évaluation de la réponse d’un modèle unique

Permet à un évaluateur humain d’indiquer dans quelle mesure il a approuvé la réponse du modèle, en fonction de vos instructions, sur une échelle de Likert en 5 points. Les résultats du rapport final se présentent sous la forme d’un histogramme des évaluations en 5 points établies par les évaluateurs pour l’ensemble du jeu de données. Vous pouvez l’utiliser pour une évaluation comportant un ou plusieurs modèles. Si vous choisissez cette méthode d’évaluation pour une évaluation qui compte plusieurs modèles, une échelle de Likert en 5 points sera présentée à votre équipe de travail pour chaque réponse de modèle et le rapport final présentera les résultats agrégés individuellement pour chaque modèle. Veillez à définir les points importants de l’échelle en 5 points dans vos instructions, de sorte que vos évaluateurs sachent comment évaluer les réponses en fonction de vos attentes.

Sortie JSON

La première clé enfant située en dessous de evaluationResults est celle où la méthode d’évaluation sélectionnée est renvoyée. Dans le fichier de sortie enregistré dans votre compartiment Amazon S3, les résultats de chaque travailleur sont enregistrés dans la paire clé-valeur "evaluationResults": "individualLikertScale".