Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Présentation

Il n'existe pas de définition universellement acceptée de ce qu'est un modèle interprétable, ni des informations qui constituent une interprétation adéquate d'un modèle. Ce guide se concentre sur la notion couramment utilisée d'importance des caractéristiques, dans laquelle un score d'importance pour chaque caractéristique en entrée est utilisé pour interpréter la manière dont elle affecte les sorties du modèle. Cette méthode fournit des informations mais nécessite également de la prudence. Les notes d'importance des fonctionnalités peuvent être trompeuses et doivent être analysées avec soin, y compris, si possible, être validées par des experts en la matière. Plus précisément, nous vous conseillons de ne pas vous fier aux notes d'importance des fonctionnalités sans vérification, car les erreurs d'interprétation peuvent entraîner de mauvaises décisions commerciales.

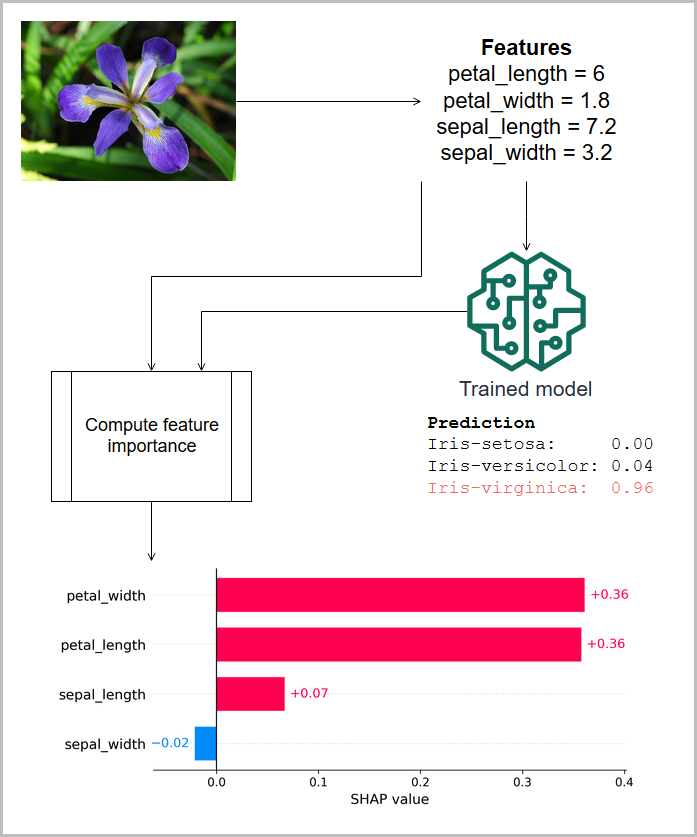

Dans l'illustration suivante, les caractéristiques mesurées d'un iris sont transmises à un modèle qui prédit l'espèce de la plante, et les importances des caractéristiques associées (attributions SHAP) pour cette prédiction sont affichées. Dans ce cas, la longueur des pétales, la largeur des pétales et la longueur des sépales contribuent toutes positivement à la classification d'Iris virginica, mais la largeur des sépales a une contribution négative. (Ces informations sont basées sur l'ensemble de données sur l'iris de [4].)

Les scores d'importance des caractéristiques peuvent être globaux, indiquant que le score est valide pour le modèle pour toutes les entrées, ou locaux, indiquant que le score s'applique à une seule sortie du modèle. Les scores d'importance des caractéristiques locales sont souvent redimensionnés et additionnés pour produire la valeur de sortie du modèle, et sont donc appelés attributions. Les modèles simples sont considérés comme plus interprétables, car les effets des caractéristiques d'entrée sur la sortie du modèle sont plus faciles à comprendre. Par exemple, dans un modèle de régression linéaire, les amplitudes des coefficients fournissent un score d'importance global des caractéristiques, et pour une prédiction donnée, l'attribution d'une caractéristique locale est le produit de son coefficient et de la valeur de la caractéristique. En l'absence d'un score d'importance local direct pour une prédiction, vous pouvez calculer un score d'importance à partir d'un ensemble d'entités en entrée de référence afin de comprendre la contribution d'une caractéristique par rapport à la ligne de base.