Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Abandon scolaire à Monte-Carlo

L'une des méthodes les plus populaires pour estimer l'incertitude consiste à déduire des distributions prédictives à l'aide de réseaux neuronaux bayésiens. Pour indiquer une distribution prédictive, utilisez :

avec des objectifs

, des entrées

, des entrées

et

et

de nombreux exemples de formation

de nombreux exemples de formation

. Lorsque vous obtenez une distribution prédictive, vous pouvez inspecter la variance et détecter les incertitudes. Une façon d'apprendre une distribution prédictive consiste à apprendre une distribution sur les fonctions ou, de manière équivalente, une distribution sur les paramètres (c'est-à-dire la distribution postérieure paramétrique).

. Lorsque vous obtenez une distribution prédictive, vous pouvez inspecter la variance et détecter les incertitudes. Une façon d'apprendre une distribution prédictive consiste à apprendre une distribution sur les fonctions ou, de manière équivalente, une distribution sur les paramètres (c'est-à-dire la distribution postérieure paramétrique).

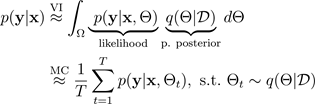

La technique d'abandon scolaire de Monte Carlo (MC) (Gal et Ghahramani 2016) fournit un moyen évolutif d'apprendre une distribution prédictive. Le décrochage du MC fonctionne en désactivant de manière aléatoire les neurones d'un réseau neuronal, ce qui régularise le réseau. Chaque configuration d'abandon correspond à un échantillon différent de la distribution paramétrique postérieure approximative :

où

correspond à une configuration d'abandon, ou, de manière équivalente, à une simulation ~, échantillonnée à partir du paramètre postérieur approximatif

correspond à une configuration d'abandon, ou, de manière équivalente, à une simulation ~, échantillonnée à partir du paramètre postérieur approximatif

, comme le montre la figure suivante. L'échantillonnage à partir de la valeur postérieure approximative

, comme le montre la figure suivante. L'échantillonnage à partir de la valeur postérieure approximative

permet d'intégrer à Monte Carlo la vraisemblance du modèle, ce qui permet de découvrir la distribution prédictive, comme suit :

permet d'intégrer à Monte Carlo la vraisemblance du modèle, ce qui permet de découvrir la distribution prédictive, comme suit :

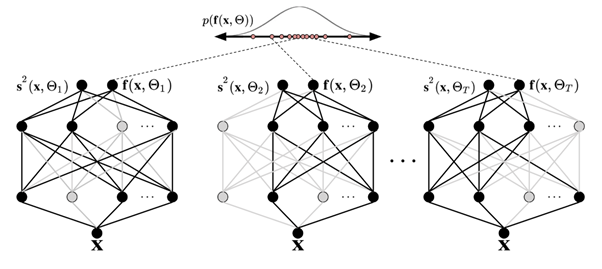

Pour des raisons de simplicité, la probabilité peut être supposée être distribuée de Gauss :

avec la fonction gaussienne

spécifiée par les

spécifiée par les

paramètres de moyenne

paramètres de moyenne

et de variance, qui sont produits par des simulations à partir du BNN, un décrocheur de Monte Carlo :

et de variance, qui sont produits par des simulations à partir du BNN, un décrocheur de Monte Carlo :

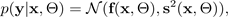

La figure suivante illustre l'abandon scolaire chez MC. Chaque configuration de décrochage produit un résultat différent en désactivant les neurones de manière aléatoire (cercles gris) et en les activant (cercles noirs) à chaque propagation vers l'avant. Plusieurs passes directes avec différentes configurations d'abandon produisent une distribution prédictive sur la moyenne p (f (x, ø)).

Le nombre de transferts directs entre les données doit être évalué quantitativement, mais 30 à 100 constituent une fourchette appropriée à prendre en compte (Gal et Ghahramani 2016).