Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Étape 4 : Analyser une image avec votre modèle

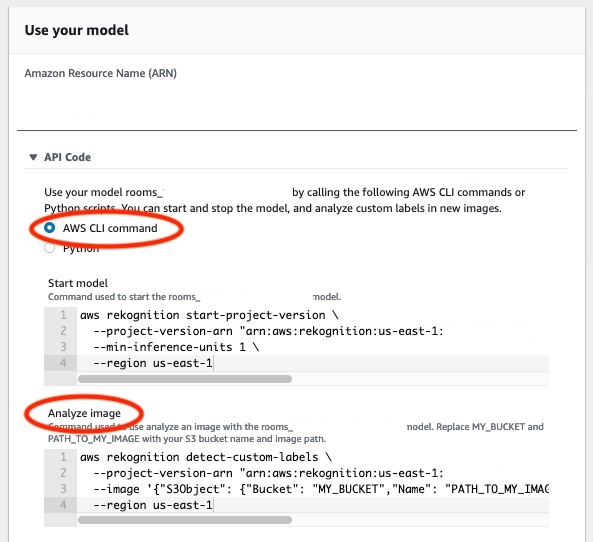

Vous analysez une image en appelant l'API DetectCustomLabels. Dans cette étape, vous utilisez la commande detect-custom-labels AWS Command Line Interface (AWS CLI) pour analyser un exemple d'image. Vous obtenez la AWS CLI commande depuis la console Amazon Rekognition Custom Labels. La console configure la AWS CLI commande pour utiliser votre modèle. Il vous suffit de fournir une image stockée dans un compartiment Amazon S3. Cette rubrique fournit une image que vous pouvez utiliser pour chaque exemple de projet.

Note

La console fournit également un exemple de code Python.

Le résultat de detect-custom-labels inclut la liste des étiquettes détectées dans l’image, les cadres de délimitation (si le modèle recherche les emplacements d’objets) et le score de confiance du modèle concernant la précision des prédictions.

Pour plus d’informations, consultez Analyse d’une image avec un modèle entraîné.

Pour analyser une image (console)

-

L'<textobject><phrase>état du modèle s'affiche comme étant en cours d'exécution, avec le bouton Stop pour arrêter le modèle en cours d'exécution. </phrase></textobject>

Si ce n'est pas déjà fait, configurez le AWS CLI. Pour obtenir des instructions, veuillez consulter Étape 4 : Configuration des AWS SDK AWS CLI et.

-

Commencez à exécuter votre modèle si vous ne l’avez pas déjà fait. Pour plus d’informations, consultez Étape 3 : Démarrer votre modèle.

-

Choisissez l’onglet Utiliser le modèle, puis Code de l’API. Le panneau d'état du modèle illustré ci-dessous indique que le modèle est en cours d'exécution, avec un bouton Stop pour arrêter le modèle en cours d'exécution et une option pour afficher l'API.

Choisissez Commande de l’interface de ligne de commande AWS.

-

Dans la section Analyser l'image, copiez la AWS CLI commande qui appelle

detect-custom-labels. L'image suivante de la console Rekognition montre la section « Analyser l'image » avec la commande AWS CLI pour détecter les étiquettes personnalisées sur une image à l'aide d'un modèle d'apprentissage automatique, ainsi que des instructions pour démarrer le modèle et fournir des détails sur l'image.

-

Chargez un exemple d’image dans un compartiment Amazon S3. Pour obtenir des instructions, veuillez consulter Obtention d’un exemple d’image.

-

À l'invite de commande, entrez la AWS CLI commande que vous avez copiée à l'étape précédente. Elle doit ressembler à l’exemple suivant.

La valeur de

--project-version-arndoit être l’Amazon Resource Name (ARN) de votre modèle. La valeur de--regiondoit être la région AWS dans laquelle vous avez créé le modèle.Remplacez

MY_BUCKETetPATH_TO_MY_IMAGEpar le compartiment Amazon S3 et l’image que vous avez utilisés à l’étape précédente.Si vous utilisez le profil custom-labels-access pour obtenir des informations d’identification, ajoutez le paramètre

--profile custom-labels-access.aws rekognition detect-custom-labels \ --project-version-arn "model_arn" \ --image '{"S3Object": {"Bucket": "MY_BUCKET","Name": "PATH_TO_MY_IMAGE"}}' \ --regionus-east-1\ --profile custom-labels-accessSi le modèle trouve des objets, des scènes et des concepts, la sortie JSON de la commande AWS CLI doit ressembler à ce qui suit.

Nameest le nom de l’étiquette au niveau de l’image trouvée par le modèle.Confidence(0 à 100) est le niveau de confiance du modèle dans l’exactitude de la prédiction.{ "CustomLabels": [ { "Name": "living_space", "Confidence": 83.41299819946289 } ] }Si le modèle trouve des emplacements d’objets ou trouve une marque, les cadres de délimitation étiquetés sont renvoyés.

BoundingBoxcontient l’emplacement d’un cadre qui entoure l’objet.Nameest l’objet que le modèle a trouvé dans le cadre de délimitation.Confidenceest le niveau de confiance du modèle que le cadre de délimitation contient l’objet.{ "CustomLabels": [ { "Name": "textract", "Confidence": 87.7729721069336, "Geometry": { "BoundingBox": { "Width": 0.198987677693367, "Height": 0.31296101212501526, "Left": 0.07924537360668182, "Top": 0.4037395715713501 } } } ] } -

Continuez à utiliser le modèle pour analyser d’autres images. Arrêtez le modèle si vous ne l’utilisez plus. Pour plus d’informations, consultez Étape 5 : Arrêter votre modèle.

Obtention d’un exemple d’image

Vous pouvez utiliser les images suivantes avec l’opération DetectCustomLabels. Il y a une image pour chaque projet. Pour utiliser les images, vous les chargez dans un compartiment S3.

Pour utiliser un exemple d’image

-

Cliquez avec le bouton droit sur l’image suivante qui correspond à l’exemple de projet que vous utilisez. Choisissez ensuite Enregistrer l’image pour enregistrer l’image sur votre ordinateur. L’option du menu peut être différente selon le navigateur que vous utilisez.

-

Téléchargez l'image dans un compartiment Amazon S3 appartenant à votre AWS compte et situé dans la même AWS région que celle dans laquelle vous utilisez les étiquettes personnalisées Amazon Rekognition.

Pour en savoir plus, consultez Chargement d’objets dans Amazon S3 dans le Guide de l’utilisateur Amazon Simple Storage Service.

Classification d’images

Classification à plusieurs étiquettes

Détection des marques

Localisation d’objets