Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Afficher les expériences et les exécutions

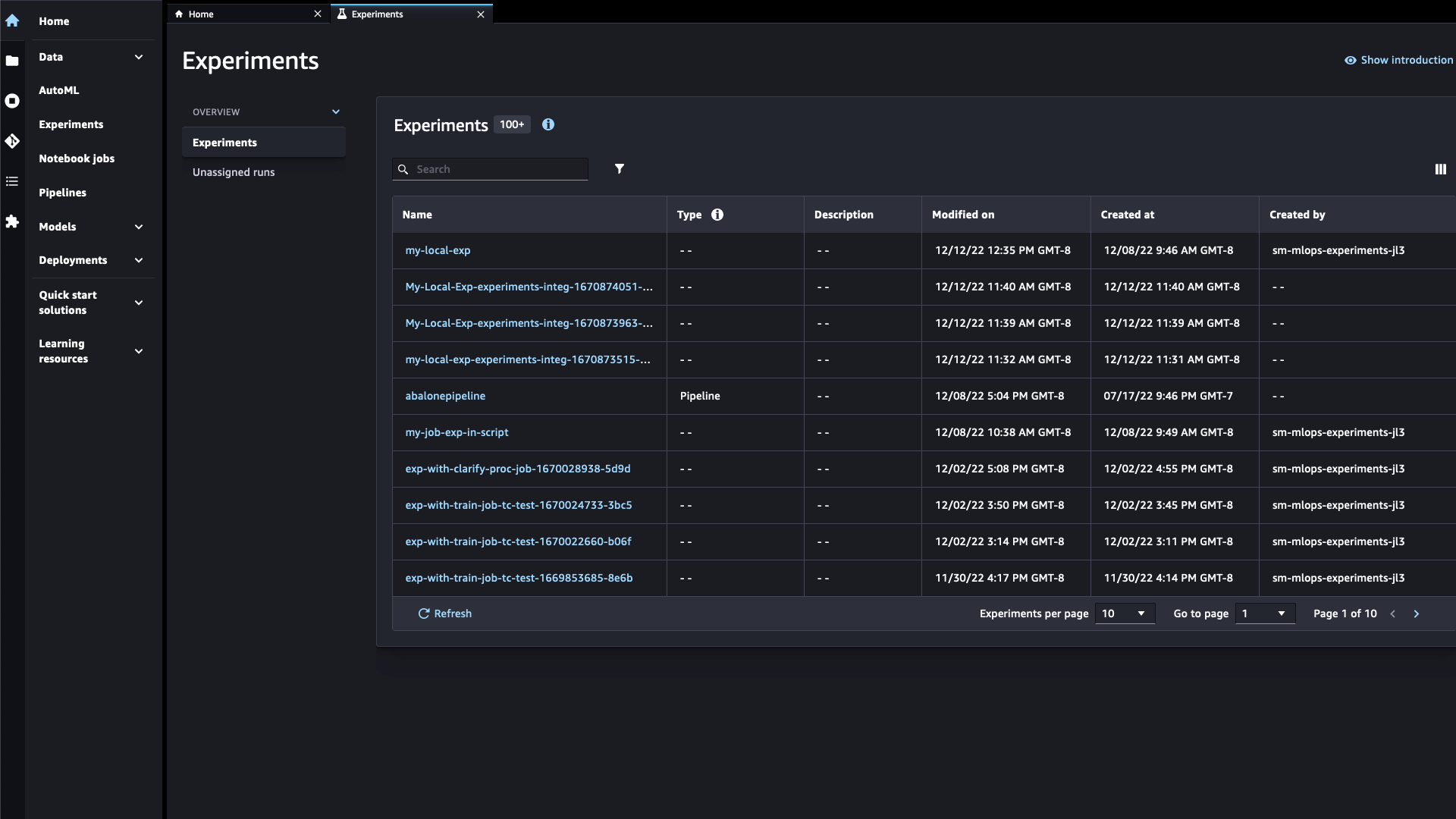

Amazon SageMaker Studio Classic fournit un navigateur d'expériences que vous pouvez utiliser pour consulter les listes d'expériences et d'essais. Vous pouvez choisir l'une de ces entités pour afficher des informations détaillées sur l'entité ou choisir plusieurs entités à comparer. Vous pouvez filtrer la liste des expériences par nom d'entité, type et balises.

Pour afficher les expériences et les exécutions

-

Pour afficher le test dans Studio Classic, dans la barre latérale gauche, sélectionnez Experiments.

Sélectionnez le nom de l'expérience pour afficher toutes les exécutions associées. Vous pouvez rechercher des expériences en les saisissant directement dans la barre Search (Recherche) ou en filtrant par type d'expérience. Vous pouvez également choisir les colonnes à afficher dans votre expérience ou votre liste d'exécutions.

Il peut s'écouler un moment avant que la liste ne s'actualise et affiche une nouvelle expérience ou une exécution d'expérience. Vous pouvez cliquer sur Refresh (Actualiser) pour mettre à jour la page. Votre liste d'expériences doit être similaire à ce qui suit :

-

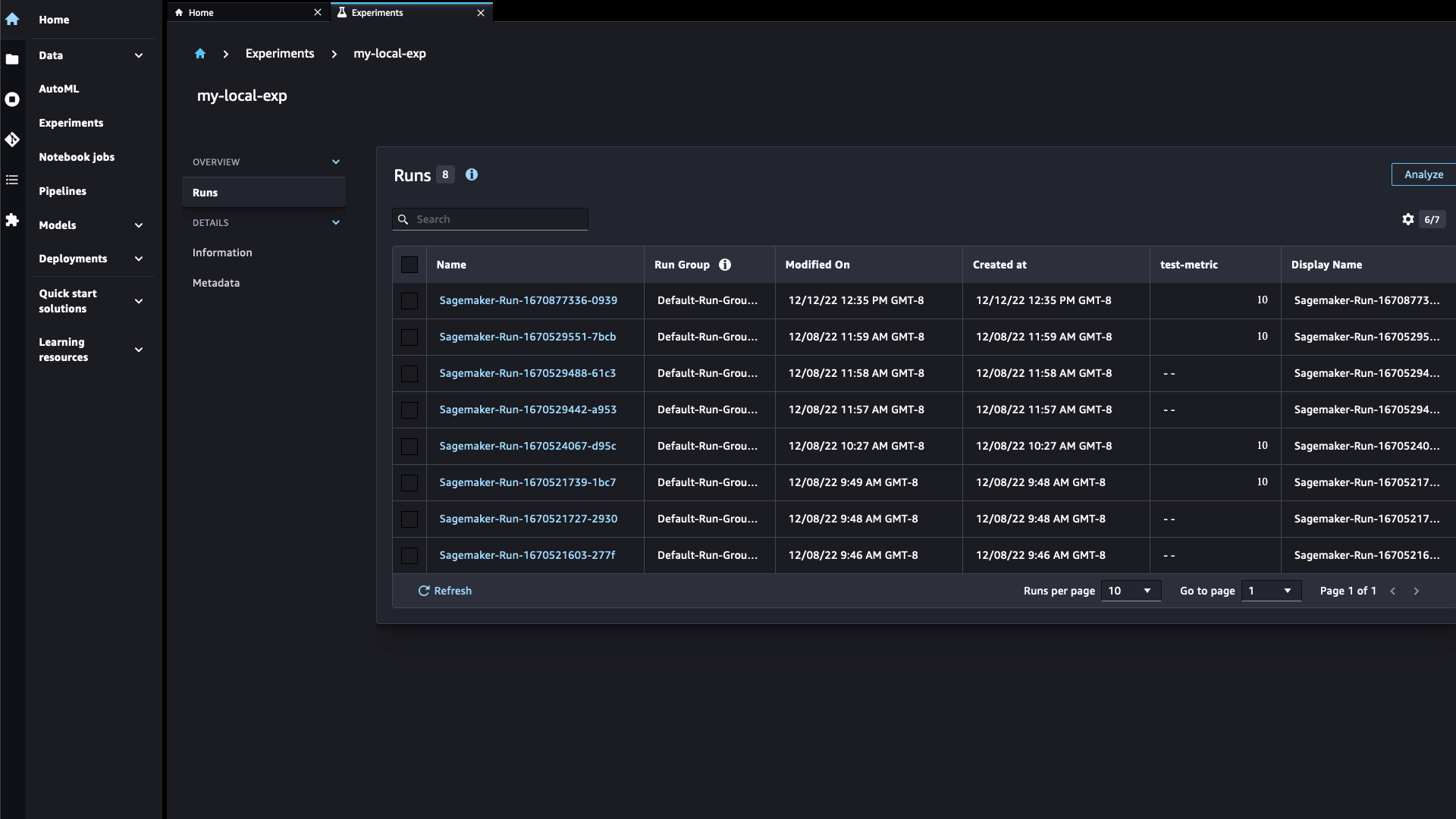

Dans la liste d'expériences, double-cliquez sur une expérience pour afficher sa liste d'exécutions.

Note

Les tests créés automatiquement par les tâches et les conteneurs d' SageMaker IA sont visibles par défaut dans l'interface utilisateur classique d'Experiments Studio. Pour masquer les essais créés par les tâches d' SageMaker intelligence artificielle pour une expérience donnée, cliquez sur l'icône des paramètres (

) et activez l'option Afficher les tâches.

) et activez l'option Afficher les tâches.

-

Double-cliquez sur une exécution pour afficher les informations relatives à une exécution spécifique.

Dans le volet Overview (Présentation), choisissez l'un des en-têtes suivants pour afficher les informations disponibles sur chaque exécution :

-

Metrics (Métriques) : métriques journalisées pendant une exécution.

-

Charts (Graphiques) : créez vos propres graphiques pour comparer les exécutions.

-

Output artifacts (Artefacts de sortie) : tous les artefacts résultant de l'exécution de l'expérience et l'emplacement des artefacts dans Amazon S3.

-

Rapports de biais — Rapports de biais générés avant ou après l'entraînement à l'aide de Clarify.

-

Explainability (Explicabilité) : rapports d'explicabilité générés à l'aide de Clarify.

-

Debugs (Débogages) : une liste de règles Debugger et des problèmes détectés.

-