Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Rapport de performances d'un modèle

Un rapport sur la qualité du modèle Amazon SageMaker AI (également appelé rapport de performance) fournit des informations et des informations de qualité sur le meilleur modèle candidat généré par une tâche AutoML. Cela inclut des informations sur les détails de la tâche, le type de problème du modèle, la fonction objectif et diverses métriques. Cette section détaille le contenu d'un rapport de performances pour les problèmes de classification d'image et explique comment accéder aux métriques en tant que données brutes dans un fichier JSON.

Vous trouverez le préfixe Amazon S3 des artefacts du rapport de qualité du modèle générés pour le meilleur candidat dans la réponse à DescribeAutoMLJobV2, dans BestCandidate.CandidateProperties.CandidateArtifactLocations.ModelInsights.

Le rapport de performances contient deux sections :

-

La première section contient des détails sur la tâche Autopilot qui a produit le modèle.

-

La seconde section contient un rapport de qualité du modèle avec différentes métriques de performances.

Détails de la tâche Autopilot

La première section du rapport fournit des informations générales sur la tâche Autopilot qui a produit le modèle. Ces détails incluent les informations suivantes :

-

Nom du candidat Autopilot : nom du meilleur modèle candidat.

-

Nom de la tâche Autopilot : nom de la tâche.

-

Type de problème : le type de problème. Dans notre cas, classification d'image.

-

Métrique d'objectif : métrique d'objectif utilisée pour optimiser les performances du modèle. Dans notre cas, la précision.

-

Direction de l'optimisation : indique s'il faut minimiser ou maximiser la métrique d'objectif.

Rapport de qualité du modèle

Des informations sur la qualité du modèle sont générées par les analyses du modèle Autopilot. Le contenu du rapport généré dépend du type de problème pris en compte. Le rapport spécifie le nombre de lignes incluses dans le jeu de données d'évaluation et le moment auquel l'évaluation a eu lieu.

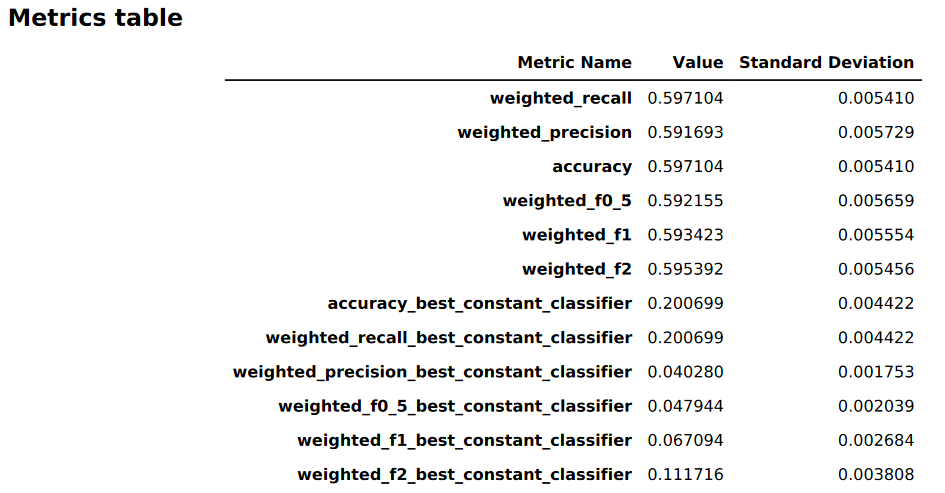

Tableaux de métriques

La première partie du rapport sur la qualité du modèle contient des tableaux de métriques. Ils sont adaptés au type de problème traité par le modèle.

L'image suivante est un exemple de table de métriques générée par Autopilot pour un problème de classification d'image ou de texte. Il indique le nom, la valeur et l'écart type de la métrique.

Informations graphiques sur les performances du modèle

La deuxième partie du rapport sur la qualité du modèle contient des informations graphiques qui vous aident à évaluer les performances du modèle. Le contenu de cette section dépend du type de problème sélectionné.

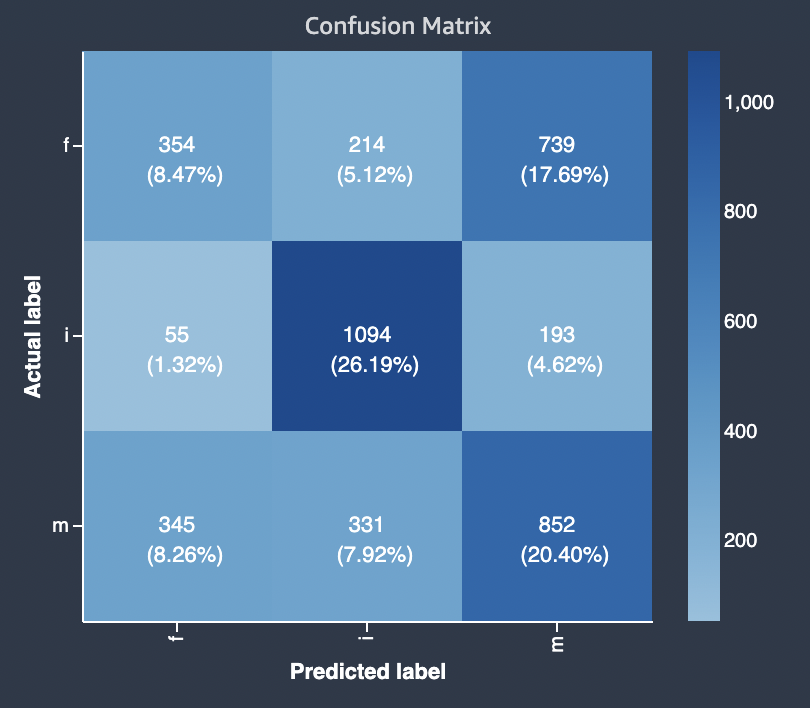

Matrice Confusion

Une matrice de confusion permet de visualiser la précision des prédictions faites par un modèle de classification binaire et multi-classes pour différents problèmes.

Un résumé des composantes du graphe relatives au taux de faux positifs (FPR) et au taux de vrais positifs (TPR) est défini comme suit.

-

Prédictions correctes

-

Vrai positif (TP, True Positive) : la valeur prédite est 1, et la valeur observée est 1.

-

Vrai négatif (TN, True Negative) : la valeur prédite est 0, et la valeur observée est 0.

-

-

Prédictions erronées

-

Faux positif (FP) : la valeur prédite est 1, mais la valeur observée est 0.

-

Faux négatif (FN) : la valeur prédite est 0, mais la valeur observée est 1.

-

La matrice de confusion du rapport sur la qualité du modèle contient les éléments suivants.

-

Le nombre et le pourcentage de prédictions correctes et incorrectes pour les étiquettes réelles

-

Le nombre et le pourcentage de prédictions exactes sur la diagonale, du coin supérieur gauche au coin inférieur droit

-

Le nombre et le pourcentage de prédictions inexactes sur la diagonale, du coin supérieur droit au coin inférieur gauche

Les prédictions incorrectes d'une matrice de confusion sont les valeurs de confusion.

Le diagramme suivant est un exemple de matrice de confusion pour un problème de classification multi-classes. La matrice de confusion du rapport sur la qualité du modèle contient les éléments suivants.

-

L'axe vertical est divisé en trois rangées contenant trois étiquettes réelles différentes.

-

L'axe horizontal est divisé en trois colonnes contenant des étiquettes prédites par le modèle.

-

La barre de couleur attribue une tonalité plus foncée à un plus grand nombre d'échantillons afin d'indiquer visuellement le nombre de valeurs classées dans chaque catégorie.

Dans l'exemple ci-dessous, le modèle a correctement prédit 354 valeurs réelles pour l'étiquette f, 1094 valeurs pour l'étiquette i et 852 valeurs pour l'étiquette m. La différence de tonalité indique que le jeu de données n'est pas équilibré car il existe beaucoup plus d'étiquettes pour la valeur i que pour f ou m.

La matrice de confusion du rapport sur la qualité du modèle fourni peut prendre en charge un maximum de 15 étiquettes pour les types de problèmes de classification multi-classes. Si une ligne correspondant à une étiquette affiche une valeur Nan, cela signifie que le jeu de données de validation utilisé pour vérifier les prévisions du modèle ne contient pas de données portant cette étiquette.