Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

SageMaker HyperPod recettes

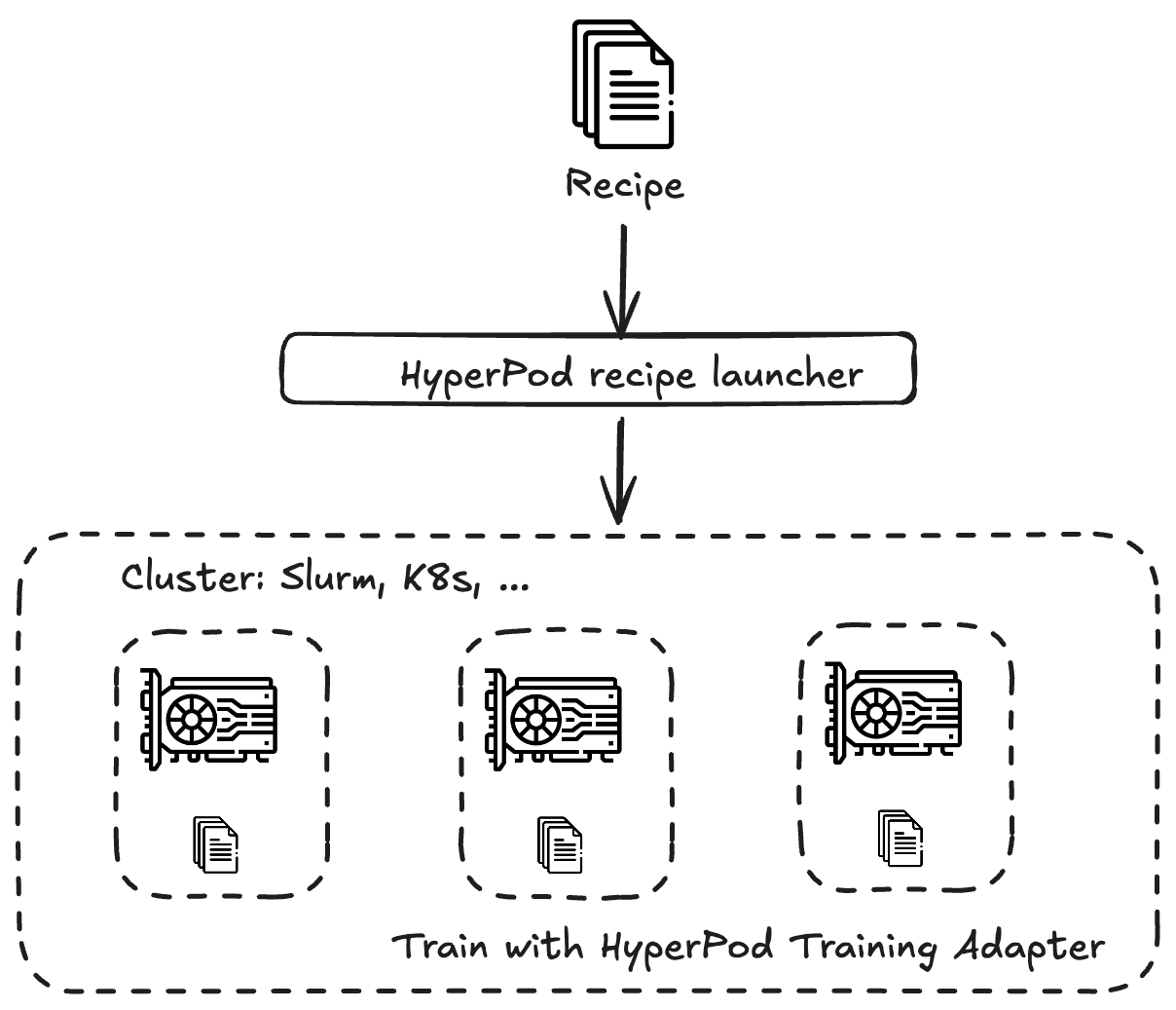

Les SageMaker HyperPod recettes Amazon sont des modules de formation préconfigurés fournis pour vous aider AWS à démarrer rapidement la formation et à peaufiner les modèles de base accessibles au public (FMs) issus de différentes familles de modèles telles que Llama, Mistral, Mixtral ou. DeepSeek Les recettes automatisent la boucle d' end-to-endentraînement, notamment le chargement d'ensembles de données, l'application de techniques d'entraînement distribuées et la gestion des points de contrôle pour accélérer la reprise en cas de panne.

SageMaker HyperPod les recettes sont particulièrement bénéfiques pour les utilisateurs qui ne possèdent peut-être pas d'expertise approfondie en apprentissage automatique, car elles éliminent une grande partie de la complexité liée à la formation de grands modèles.

Vous pouvez exécuter des recettes dans le cadre de tâches de SageMaker formation SageMaker HyperPod ou en tant que telles.

Les tableaux suivants sont conservés dans le SageMaker HyperPod GitHub référentiel et fournissent le plus d' up-to-dateinformations sur les modèles pris en charge pour la pré-formation et le réglage, leurs recettes et scripts de lancement respectifs, les types d'instances pris en charge, etc.

-

Pour obtenir la liste la plus récente des modèles, des recettes et des scripts de lancement pris en charge pour la pré-formation, consultez le tableau de pré-formation

. -

Pour obtenir la liste la plus récente des modèles, des recettes et des scripts de lancement pris en charge pour un réglage précis, consultez le tableau des réglages précis

.

Pour SageMaker HyperPod les utilisateurs, l'automatisation des flux de end-to-end formation provient de l'intégration de l'adaptateur de formation aux SageMaker HyperPod recettes. L'adaptateur d'entraînement est basé sur le NeMo framework NVIDIA

Vous pouvez également entraîner votre propre modèle en définissant votre propre recette personnalisée.

Pour démarrer avec un didacticiel, voirDidacticiels.