Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Memulai pekerjaan ETL visual di AWS Glue Studio

Anda dapat menggunakan antarmuka visual sederhana AWS Glue Studio untuk membuat pekerjaan ETL Anda. Anda menggunakan halaman Tugas untuk membuat tugas baru. Anda juga dapat menggunakan editor skrip atau buku catatan untuk bekerja secara langsung dengan kode dalam skrip pekerjaan AWS Glue Studio ETL.

Pada halaman Jobs, Anda dapat melihat semua pekerjaan yang telah Anda buat baik dengan AWS Glue Studio atauAWS Glue. Anda dapat melihat, mengelola, dan menjalankan tugas Anda di halaman ini.

Lihat juga tutorial blog

Memulai pekerjaan di AWS Glue Studio

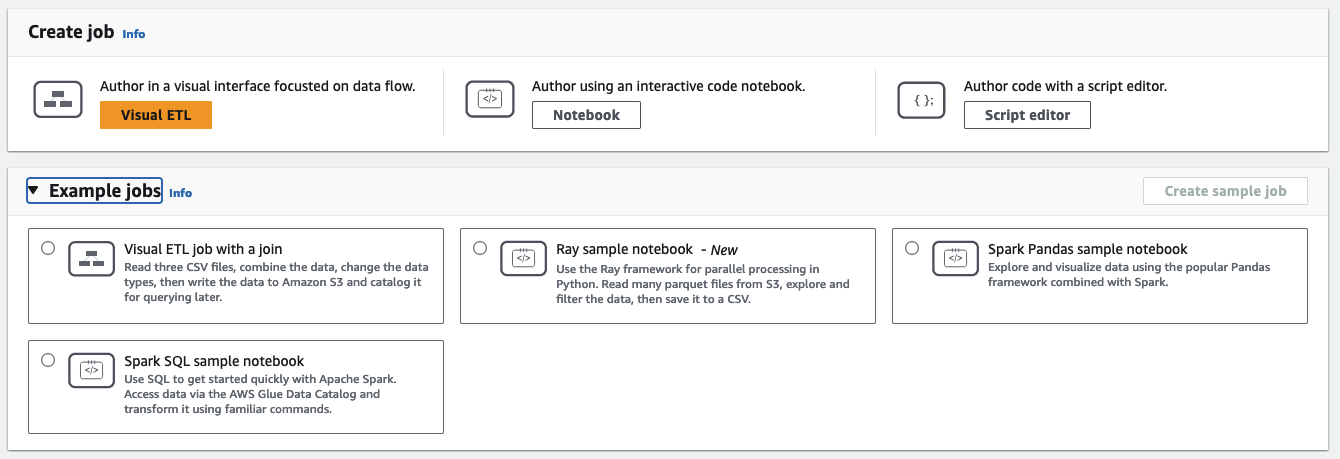

AWS Gluememungkinkan Anda membuat pekerjaan melalui antarmuka visual, buku catatan kode interaktif, atau dengan editor skrip. Anda dapat memulai pekerjaan dengan mengklik salah satu opsi atau membuat pekerjaan baru berdasarkan contoh pekerjaan.

Contoh pekerjaan membuat pekerjaan dengan alat pilihan Anda. Misalnya, pekerjaan sampel memungkinkan Anda membuat pekerjaan ETL visual yang menggabungkan file CSV ke dalam tabel catatlog, membuat pekerjaan di buku catatan kode interaktif dengan AWS Glue untuk Ray atau AWS Glue untuk Spark saat bekerja dengan panda, atau membuat pekerjaan di buku catatan kode interaktif dengan SparkSQL.

Membuat pekerjaan AWS Glue Studio dari awal

Masuk ke AWS Management Console dan buka AWS Glue Studio konsol di https://console.aws.amazon.com/gluestudio/

. -

Pilih pekerjaan ETL dari panel navigasi.

-

Di bagian Buat pekerjaan, pilih opsi konfigurasi untuk pekerjaan Anda.

Opsi untuk membuat pekerjaan dari awal:

-

Visual ETL — penulis dalam antarmuka visual yang berfokus pada aliran data

-

Penulis menggunakan buku catatan kode Interaktif — pekerjaan penulis interaktif di antarmuka notebook berdasarkan Jupyter Notebooks

Ketika Anda memilih opsi ini, Anda harus memberikan informasi tambahan sebelum membuat sesi penulisan buku catatan. Untuk informasi selengkapnya tentang cara menentukan informasi ini, lihatMemulai dengan notebook di AWS Glue Studio.

-

Kode penulis dengan editor skrip — Bagi mereka yang terbiasa dengan pemrograman dan penulisan skrip ETL, pilih opsi ini untuk membuat pekerjaan Spark ETL baru. Pilih mesin (Python shell, Ray, Spark (Python), atau Spark (Scala). Kemudian, pilih Mulai baru atau Unggah skrip. mengunggah skrip yang ada dari file lokal. Jika Anda memilih untuk menggunakan editor skrip, Anda tidak dapat menggunakan editor pekerjaan visual untuk merancang atau mengedit pekerjaan Anda.

Sebuah tugas Spark dijalankan di lingkungan Apache Spark yang dikelola oleh AWS Glue. Secara default, skrip baru dikodekan dengan Python. Untuk menulis skrip Scala baru, lihatMembuat dan mengedit skrip Scala di AWS Glue Studio.

-

Membuat pekerjaan AWS Glue Studio dari contoh pekerjaan

Anda dapat memilih untuk membuat pekerjaan dari contoh pekerjaan. Di bagian Contoh pekerjaan, pilih pekerjaan sampel, lalu pilih Buat pekerjaan sampel. Membuat contoh pekerjaan dari salah satu opsi menyediakan templat cepat yang dapat Anda kerjakan.

Masuk ke AWS Management Console dan buka AWS Glue Studio konsol di https://console.aws.amazon.com/gluestudio/

. -

Pilih pekerjaan ETL dari panel navigasi.

-

Pilih opsi buat pekerjaan dari pekerjaan sampel:

-

Tugas ETL visual untuk bergabung dengan beberapa sumber — Baca tiga file CSV, gabungkan data, ubah tipe data, lalu tulis data ke Amazon S3 dan katalogkan untuk kueri nanti.

-

Notebook Spark menggunakan Pandas — Jelajahi dan visualisasikan data menggunakan kerangka kerja Pandas populer yang dikombinasikan dengan Spark.

-

Spark notebook menggunakan SQL - Gunakan SQL untuk memulai dengan cepat dengan Apache Spark. Akses data melalui Katalog AWS Glue Data dan ubah menggunakan perintah yang sudah dikenal.

-

-

Pilih Buat pekerjaan sampel.