Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Pemecahan masalah: DAG, Operator, Koneksi, dan masalah lainnya di Apache Airflow v2

Topik pada halaman ini menjelaskan resolusi untuk dependensi Apache Airflow v2 Python, plugin kustom, DAG, Operator, Koneksi, tugas, dan masalah server Web yang mungkin Anda temui di Amazon Managed Workflow untuk lingkungan Apache Airflow.

Daftar Isi

Koneksi

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat menggunakan sambungan Apache Airflow, atau menggunakanAWS database lain.

Saya tidak dapat terhubung ke Secrets Manager

Kami merekomendasikan langkah-langkah berikut:

-

Pelajari cara membuat kunci rahasia untuk koneksi Apache Airflow dan variabel AndaMengkonfigurasi koneksi Apache Airflow menggunakan rahasia AWS Secrets Manager.

-

Pelajari cara menggunakan kunci rahasia untuk variabel Apache Airflow (

test-variable) diMenggunakan kunci rahasia AWS Secrets Manager untuk variabel Apache Airflow. -

Pelajari cara menggunakan kunci rahasia untuk koneksi Apache Airflow (

myconn) diMenggunakan kunci rahasia AWS Secrets Manager untuk koneksi Apache Airflow.

Bagaimana cara mengonfigurasi kondisi manajersecretsmanager:ResourceTag/<tag-key> rahasia atau pembatasan sumber daya dalam kebijakan peran eksekusi saya?

catatan

Berlaku untuk Apache Airflow versi 2.0 dan versi sebelumnya.

Saat ini, Anda tidak dapat membatasi akses ke rahasia Secrets Manager dengan menggunakan kunci kondisi atau pembatasan sumber daya lainnya dalam peran eksekusi lingkungan Anda, karena masalah yang diketahui di Apache Airflow.

Saya tidak dapat terhubung ke Snowflake

Kami merekomendasikan langkah-langkah berikut:

-

Uji DAG, plugin kustom, dan dependensi Python Anda secara lokal menggunakan aws-mwaa-local-runner

onGitHub. -

Tambahkan entri berikut ke requirements.txt untuk lingkungan Anda.

apache-airflow-providers-snowflake==1.3.0 -

Tambahkan impor berikut:

from airflow.providers.snowflake.operators.snowflake import SnowflakeOperator

Pastikan objek koneksi Apache Airflow menyertakan pasangan kunci-nilai berikut:

-

Kontak Id: snowflake_conn

-

Tipe Conn: Kepingan Salju

-

Tuan rumah:<my account>. <my region if not us-west-2>.snowflakecomputing.com

-

Skema: <my schema>

-

Masuk: <my user name>

-

Kata Sandi: ********

-

Pelabuhan: <port, if any>

-

Ekstra:

{ "account": "<my account>", "warehouse": "<my warehouse>", "database": "<my database>", "region": "<my region if not using us-west-2 otherwise omit this line>" }

Misalnya:

>>> import json >>> from airflow.models.connection import Connection >>> myconn = Connection( ... conn_id='snowflake_conn', ... conn_type='Snowflake', ... host='YOUR_ACCOUNT.YOUR_REGION.snowflakecomputing.com', ... schema='YOUR_SCHEMA' ... login='YOUR_USERNAME', ... password='YOUR_PASSWORD', ... port='YOUR_PORT' ... extra=json.dumps(dict(account='YOUR_ACCOUNT', warehouse='YOUR_WAREHOUSE', database='YOUR_DB_OPTION', region='YOUR_REGION')), ... )

Saya tidak dapat melihat koneksi saya di UI Aliran Udara

Apache Airflow menyediakan template koneksi di Apache Airflow UI. Menggunakan ini untuk menghasilkan string URI koneksi, terlepas dari jenis koneksi. Jika template koneksi tidak tersedia di UI Apache Airflow, template koneksi alternatif dapat digunakan untuk membuat string URI koneksi, seperti menggunakan template koneksi HTTP.

Kami merekomendasikan langkah-langkah berikut:

-

Lihat jenis koneksi yang disediakan Amazon MWAA di UI Apache Airflow diPaket penyedia Apache Airflow diinstal di lingkungan Amazon MWAA.

-

Lihat perintah untuk membuat koneksi Apache Airflow di CLI diReferensi perintah CLI Aliran Udara Apache.

-

Pelajari cara menggunakan template koneksi di UI Apache Airflow secara bergantian untuk jenis koneksi yang tidak tersedia di UI Apache Airflow di Amazon MWAA atIkhtisar Jenis.

Server web

Topik berikut menjelaskan kesalahan yang mungkin Anda terima untuk server Apache Airflow Web Anda di Amazon MWAA.

Saya melihat kesalahan 5xx mengakses server web

Kami merekomendasikan langkah-langkah berikut:

-

Periksa opsi konfigurasi Apache Airflow. Pastikan pasangan kunci-nilai yang Anda tentukan sebagai opsi konfigurasi Apache Airflow, misalnyaAWS Secrets Manager, telah dikonfigurasi dengan benar. Untuk mempelajari selengkapnya, lihat Saya tidak dapat terhubung ke Secrets Manager.

-

Periksa

requirements.txt. Verifikasi paket “ekstra” aliran udara dan pustaka lain yang tercantum dalam Andarequirements.txtkompatibel dengan versi Apache Airflow Anda. -

Jelajahi cara untuk menentukan dependensi Python dalam

requirements.txtfile, lihatMengelola dependensi Python di requirements.txt.

Saya melihat kesalahan 'Penjadwal tidak tampak berjalan'

Jika penjadwal tampaknya tidak berjalan, atau “detak jantung” terakhir diterima beberapa jam yang lalu, DAG Anda mungkin tidak muncul di Apache Airflow, dan tugas baru tidak akan dijadwalkan.

Kami merekomendasikan langkah-langkah berikut:

-

Konfirmasikan bahwa grup keamanan VPC Anda mengizinkan akses masuk ke port

5432. Port ini diperlukan untuk terhubung ke database metadata Amazon Aurora PostgreSQL untuk lingkungan Anda. Setelah aturan ini ditambahkan, berikan Amazon MWAA beberapa menit, dan kesalahannya akan hilang. Untuk mempelajari selengkapnya, lihat Keamanan di VPC Anda di Amazon MWAA.catatan

-

Metadatabase Aurora PostgreSQL adalah bagian dari arsitektur layanan Amazon MWAA dan tidak terlihat di situs AndaAkun AWS.

-

Kesalahan terkait database biasanya merupakan gejala kegagalan penjadwal dan bukan akar penyebabnya.

-

-

Jika scheduler tidak berjalan, mungkin karena sejumlah faktor seperti kegagalan instalasi ketergantungan, atau scheduler kelebihan beban. Konfirmasikan bahwa DAG, plugin, dan persyaratan Anda bekerja dengan benar dengan melihat grup log yang sesuai diCloudWatch Log. Untuk mempelajari selengkapnya, lihat Pemantauan dan metrik untuk Alur Kerja Terkelola Amazon untuk Apache Airflow.

Tugas

Topik berikut menjelaskan kesalahan yang mungkin Anda terima untuk tugas Apache Airflow di lingkungan.

Saya melihat tugas saya macet atau tidak menyelesaikan

Jika tugas Apache Airflow Anda “macet” atau tidak selesai, kami merekomendasikan langkah-langkah berikut:

-

Mungkin ada sejumlah besar DAG yang ditentukan. Kurangi jumlah DAG dan lakukan pembaruan lingkungan (seperti mengubah level log) untuk memaksa reset.

-

Aliran udara mem-parsing DAG apakah mereka diaktifkan atau tidak. Jika Anda menggunakan lebih dari 50% kapasitas lingkungan Anda, Anda dapat mulai membebani Apache Airflow Scheduler. Ini mengarah ke Total Parse Time yang besar dalamCloudWatch Metrik atau waktu pemrosesan DAG yang panjang diCloudWatch Log. Ada cara lain untuk mengoptimalkan Apache Airflow yang berada di luar cakupan panduan ini.

-

Untuk mempelajari lebih lanjut tentang praktik terbaik yang kami sarankan untuk menyesuaikan kinerja lingkungan Anda, lihatPenyetelan kinerja untuk Apache Airflow di Amazon MWAA.

-

-

Mungkin ada sejumlah besar tugas dalam antrian. Ini sering muncul sebagai jumlah tugas yang besar dan bertambah—dalam status “Tidak Ada”, atau sebagai jumlah besar dalam Tugas Antrian dan/atau Tugas TertundaCloudWatch. Hal ini dapat terjadi karena alasan berikut:

-

Jika ada lebih banyak tugas untuk dijalankan daripada lingkungan memiliki kapasitas untuk menjalankan, dan/atau sejumlah besar tugas yang antri sebelum autoscaling memiliki waktu untuk mendeteksi tugas dan menyebarkan Pekerja tambahan.

-

Jika ada lebih banyak tugas untuk dijalankan daripada lingkungan yang memiliki kapasitas untuk dijalankan, kami sarankan untuk mengurangi jumlah tugas yang dijalankan oleh DAG Anda secara bersamaan, dan/atau meningkatkan Pekerja Aliran Udara Apache minimum.

-

Jika ada sejumlah besar tugas yang diantri sebelum penskalaan otomatis memiliki waktu untuk mendeteksi dan menyebarkan pekerja tambahan, kami merekomendasikan penyebaran tugas yang mengejutkan dan/atau meningkatkan Pekerja Aliran Udara Apache minimum.

-

Anda dapat menggunakan perintah update-environment diAWS Command Line Interface (AWS CLI) untuk mengubah jumlah minimum atau maksimum Pekerja yang berjalan di lingkungan Anda.

aws mwaa update-environment --name MyEnvironmentName --min-workers 2 --max-workers 10 -

Untuk mempelajari lebih lanjut tentang praktik terbaik yang kami sarankan untuk menyesuaikan kinerja lingkungan Anda, lihatPenyetelan kinerja untuk Apache Airflow di Amazon MWAA.

-

-

Mungkin ada tugas yang dihapus pertengahan eksekusi yang muncul sebagai log tugas yang berhenti tanpa indikasi lebih lanjut di Apache Airflow. Hal ini dapat terjadi karena alasan berikut:

-

Jika ada momen singkat di mana 1) tugas saat ini melebihi kapasitas lingkungan saat ini, diikuti oleh 2) beberapa menit tidak ada tugas yang mengeksekusi atau sedang antri, maka 3) tugas baru sedang antri.

-

Autoscaling Amazon MWAA bereaksi terhadap skenario pertama dengan menambahkan pekerja tambahan. Dalam skenario kedua, itu menghilangkan pekerja tambahan. Beberapa tugas yang sedang antri dapat mengakibatkan pekerja dalam proses dihapus, dan akan berakhir ketika wadah dihapus.

-

Kami menyarankan untuk meningkatkan jumlah minimum pekerja di lingkungan Anda. Pilihan lainnya adalah menyesuaikan waktu DAG dan tugas Anda untuk memastikan bahwa skenario ini tidak terjadi.

-

Anda juga dapat mengatur pekerja minimum yang sama dengan pekerja maksimum di lingkungan Anda, secara efektif menonaktifkan penskalaan otomatis. Gunakan perintah update-environment diAWS Command Line Interface (AWS CLI) untuk menonaktifkan penskalaan otomatis dengan menetapkan jumlah minimum dan maksimum pekerja agar sama.

aws mwaa update-environment --name MyEnvironmentName --min-workers 5 --max-workers 5 -

Untuk mempelajari lebih lanjut tentang praktik terbaik yang kami sarankan untuk menyesuaikan kinerja lingkungan Anda, lihatPenyetelan kinerja untuk Apache Airflow di Amazon MWAA.

-

-

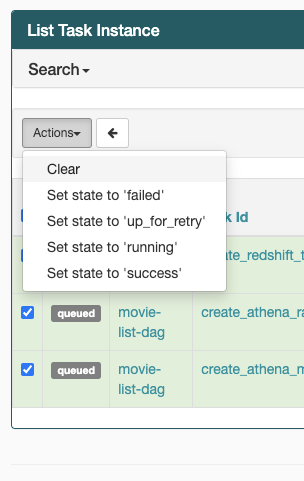

Jika tugas Anda terjebak dalam keadaan “berjalan”, Anda juga dapat menghapus tugas atau menandainya sebagai berhasil atau gagal. Hal ini memungkinkan komponen autoscaling untuk lingkungan Anda untuk menurunkan jumlah pekerja yang berjalan di lingkungan Anda. Gambar berikut menunjukkan contoh tugas yang terdampar.

-

Pilih lingkaran untuk tugas yang terdampar, lalu pilih Clear (seperti yang ditunjukkan). Hal ini memungkinkan Amazon MWAA untuk menurunkan skala pekerja; jika tidak, Amazon MWAA tidak dapat menentukan DAG mana yang diaktifkan atau dinonaktifkan, dan tidak dapat menurunkan skala, jika masih ada tugas antrian.

-

-

Pelajari lebih lanjut tentang siklus hidup tugas Apache Airflow di Concepts

dalam panduan referensi Apache Airflow.

CLI

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat menjalankan perintah Airflow CLI diAWS Command Line Interface.

Saya melihat kesalahan '503' saat memicu DAG di CLI

Airflow CLI berjalan pada server Apache Airflow Web, yang memiliki konkurensi terbatas. Biasanya maksimal 4 perintah CLI dapat berjalan secara bersamaan.

Mengapa perintahdags backfill Apache Airflow CLI gagal? Apakah ada solusi?

catatan

Hal ini berlaku hanya untuk Apache Airflow v2.0.2.

backfillPerintah, seperti perintah Apache Airflow CLI lainnya, mem-parsing semua DAG secara lokal sebelum DAG diproses, terlepas dari DAG mana operasi CLI berlaku. Di lingkungan Amazon MWAA menggunakan Apache Airflow v2.0.2, karena plugin dan persyaratan belum diinstal di server web pada saat perintah CLI berjalan, operasi parsing gagal, danbackfill operasi tidak dipanggil. Jika Anda tidak memiliki persyaratan atau plugin di lingkungan Anda,backfill operasi akan berhasil.

Agar dapat menjalankan perintahbackfill CLI, kami sarankan memohon dalam operator bash. Dalam operator bash,backfill dimulai dari pekerja, memungkinkan DAG untuk mengurai berhasil karena semua persyaratan yang diperlukan dan plguin tersedia dan diinstal. Contoh berikut menunjukkan cara membuat DAG denganBashOperator menjalankanbackfill.

from airflow import DAG from airflow.operators.bash_operator import BashOperator from airflow.utils.dates import days_ago with DAG(dag_id="backfill_dag", schedule_interval=None, catchup=False, start_date=days_ago(1)) as dag: cli_command = BashOperator( task_id="bash_command", bash_command="airflow dags backfill my_dag_id" )

Operator

Topik berikut menjelaskan kesalahan yang mungkin Anda terima saat menggunakan Operator.

Saya menerimaPermissionError: [Errno 13] Permission denied kesalahan menggunakan operator S3Transform

Kami merekomendasikan langkah-langkah berikut jika Anda mencoba menjalankan skrip shell dengan operator S3Transform dan Anda menerimaPermissionError: [Errno 13] Permission denied kesalahan. Langkah-langkah berikut mengasumsikan Anda memiliki file plugins.zip yang ada. Jika Anda membuat plugins.zip baru, lihatMenginstal plugin kustom.

-

Uji DAG, plugin kustom, dan dependensi Python Anda secara lokal menggunakan aws-mwaa-local-runner

onGitHub. -

Buat skrip “transformasi” Anda.

#!/bin/bash cp $1 $2 -

(opsional) pengguna macOS dan Linux mungkin perlu menjalankan perintah berikut untuk memastikan skrip dapat dijalankan.

chmod 777 transform_test.sh -

Tambahkan skrip ke plugins.zip Anda.

zip plugins.zip transform_test.sh -

Ikuti langkah-langkah di Upload plugins.zip ke Amazon S3.

-

Ikuti langkah-langkah dalam Menentukan versi plugins.zip di konsol Amazon MWAA.

-

Membuat DAG berikut.

from airflow import DAG from airflow.providers.amazon.aws.operators.s3_file_transform import S3FileTransformOperator from airflow.utils.dates import days_ago import os DAG_ID = os.path.basename(__file__).replace(".py", "") with DAG (dag_id=DAG_ID, schedule_interval=None, catchup=False, start_date=days_ago(1)) as dag: file_transform = S3FileTransformOperator( task_id='file_transform', transform_script='/usr/local/airflow/plugins/transform_test.sh', source_s3_key='s3://YOUR_S3_BUCKET/files/input.txt', dest_s3_key='s3://YOUR_S3_BUCKET/files/output.txt' ) -

Ikuti langkah-langkah dalam Mengunggah kode DAG ke Amazon S3.