Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Keadilan, penjelasan model, dan deteksi bias dengan Clarify SageMaker

Anda dapat menggunakan Amazon SageMaker Clarify untuk memahami keadilan dan penjelasan model serta untuk menjelaskan dan mendeteksi bias dalam model Anda. Anda dapat mengonfigurasi tugas pemrosesan SageMaker Clarify untuk menghitung metrik bias dan atribusi fitur serta menghasilkan laporan untuk penjelasan model. SageMaker Pekerjaan pemrosesan klarifikasi diimplementasikan menggunakan gambar kontainer SageMaker Clarify khusus. Halaman berikut SageMaker menjelaskan cara kerja Clarify dan cara memulai analisis.

Apa keadilan dan penjelasan model untuk prediksi pembelajaran mesin?

Model pembelajaran mesin (ML) membantu membuat keputusan dalam domain termasuk layanan keuangan, perawatan kesehatan, pendidikan, dan sumber daya manusia. Pembuat kebijakan, regulator, dan advokat telah meningkatkan kesadaran tentang tantangan etika dan kebijakan yang ditimbulkan oleh ML dan sistem berbasis data. Amazon SageMaker Clarify dapat membantu Anda memahami mengapa model ML Anda membuat prediksi tertentu dan apakah bias ini memengaruhi prediksi ini selama pelatihan atau inferensi. SageMaker Clarify juga menyediakan alat yang dapat membantu Anda membangun model pembelajaran mesin yang kurang bias dan lebih mudah dipahami. SageMaker Clarify juga dapat menghasilkan laporan tata kelola model yang dapat Anda berikan kepada tim risiko dan kepatuhan serta regulator eksternal. Dengan SageMaker , Anda dapat melakukan hal berikut ini:

-

Deteksi bias dan bantu jelaskan prediksi model Anda.

-

Identifikasi jenis bias dalam data pra-pelatihan.

-

Identifikasi jenis bias dalam data pasca-pelatihan yang dapat muncul selama pelatihan atau saat model Anda sedang diproduksi.

SageMaker Clarify membantu menjelaskan bagaimana model Anda membuat prediksi menggunakan atribusi fitur. Ini juga dapat memantau model inferensi yang sedang diproduksi untuk bias dan penyimpangan atribusi fitur. Informasi ini membantu Anda menentukan hal berikut:

-

Regulasi — Pembuat kebijakan dan regulator lainnya dapat memiliki kekhawatiran tentang dampak diskriminatif dari keputusan yang menggunakan output dari model ML. Misalnya, model ML dapat mengkodekan bias dan mempengaruhi keputusan otomatis.

-

Bisnis — Domain yang diatur mungkin memerlukan penjelasan yang dapat diandalkan tentang bagaimana model ML membuat prediksi. Penjelasan model mungkin sangat penting bagi industri yang bergantung pada keandalan, keamanan, dan kepatuhan. Ini dapat mencakup layanan keuangan, sumber daya manusia, perawatan kesehatan, dan transportasi otomatis. Misalnya, aplikasi pinjaman mungkin perlu memberikan penjelasan tentang bagaimana model ML membuat prediksi tertentu kepada petugas pinjaman, peramal, dan pelanggan.

-

Ilmu Data — Ilmuwan data dan insinyur ML dapat men-debug dan meningkatkan model ML ketika mereka dapat menentukan apakah suatu model membuat kesimpulan berdasarkan fitur yang bising atau tidak relevan. Mereka juga dapat memahami keterbatasan model dan mode kegagalan yang mungkin dihadapi model mereka.

Untuk posting blog yang menunjukkan cara merancang dan membangun model pembelajaran mesin lengkap untuk klaim mobil palsu yang mengintegrasikan SageMaker Clarify ke dalam pipa SageMaker AI, lihat Arsitek dan bangun siklus hidup pembelajaran mesin lengkap dengan: AWS

Praktik terbaik untuk mengevaluasi keadilan dan penjelasan dalam siklus hidup ML

Keadilan sebagai proses — Gagasan bias dan keadilan tergantung pada penerapannya. Pengukuran bias dan pilihan metrik bias dapat dipandu oleh pertimbangan sosial, hukum, dan non-teknis lainnya. Keberhasilan adopsi pendekatan ML yang sadar keadilan termasuk membangun konsensus dan mencapai kolaborasi di seluruh pemangku kepentingan utama. Ini mungkin termasuk produk, kebijakan, hukum, teknik, AI/ML tim, pengguna akhir, dan komunitas.

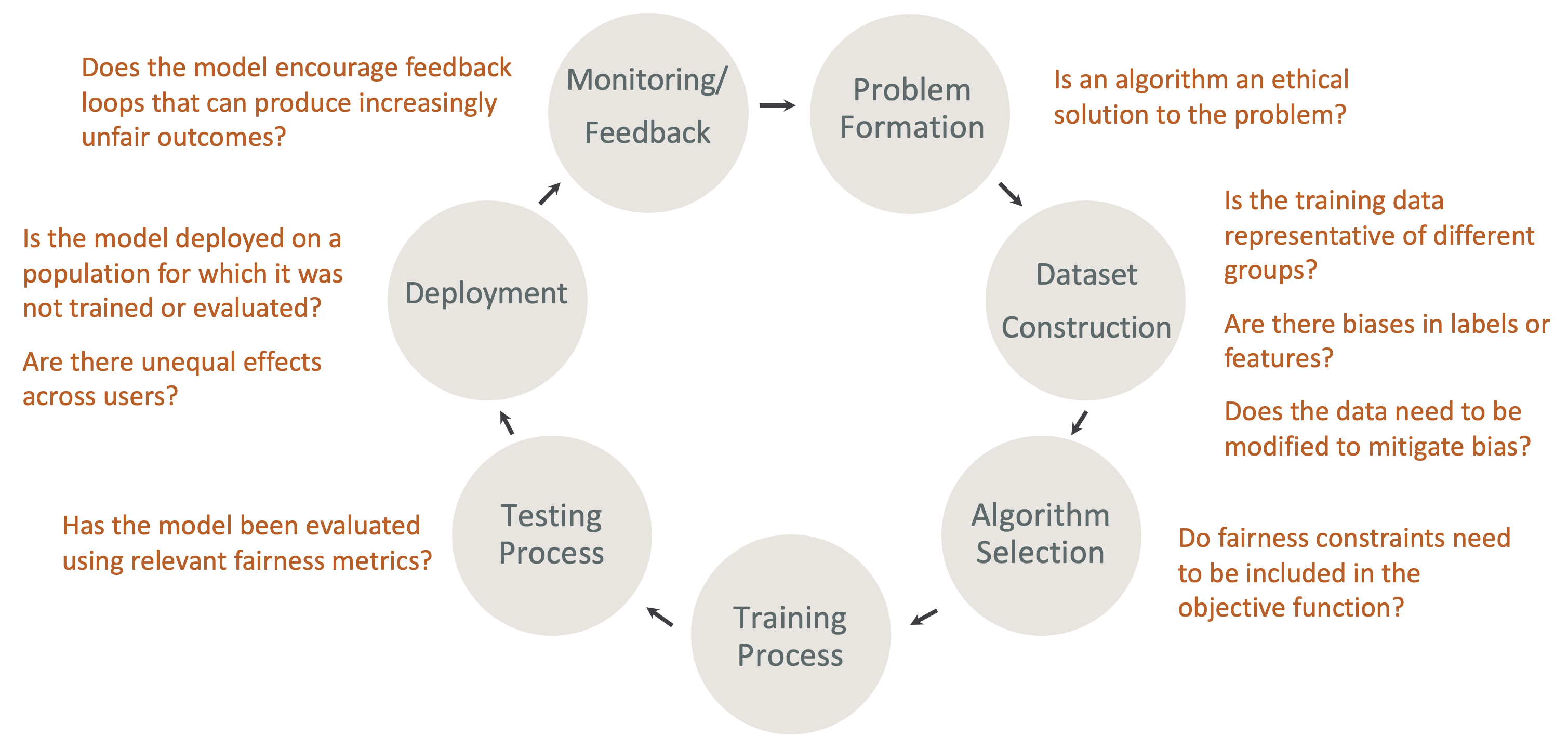

Keadilan dan keterjelasannya berdasarkan desain dalam siklus hidup ML — Pertimbangkan keadilan dan penjelasan selama setiap tahap siklus hidup ML. Tahapan ini meliputi pembentukan masalah, konstruksi dataset, pemilihan algoritma, proses pelatihan model, proses pengujian, penyebaran, dan pemantauan dan umpan balik. Penting untuk memiliki alat yang tepat untuk melakukan analisis ini. Sebaiknya ajukan pertanyaan-pertanyaan berikut selama siklus hidup ML:

-

Apakah model mendorong loop umpan balik yang dapat menghasilkan hasil yang semakin tidak adil?

-

Apakah algoritma merupakan solusi etis untuk masalah tersebut?

-

Apakah data pelatihan mewakili kelompok yang berbeda?

-

Apakah ada bias dalam label atau fitur?

-

Apakah data perlu dimodifikasi untuk mengurangi bias?

-

Apakah kendala keadilan perlu dimasukkan dalam fungsi objektif?

-

Apakah model telah dievaluasi menggunakan metrik keadilan yang relevan?

-

Apakah ada efek yang tidak setara di seluruh pengguna?

-

Apakah model tersebut digunakan pada populasi yang tidak dilatih atau dievaluasi?

Panduan untuk penjelasan SageMaker AI dan dokumentasi bias

Bias dapat terjadi dan diukur dalam data baik sebelum dan sesudah melatih model. SageMaker Clarify dapat memberikan penjelasan untuk prediksi model setelah pelatihan dan untuk model yang digunakan untuk produksi. SageMaker Clarify juga dapat memantau model dalam produksi untuk setiap penyimpangan dalam atribusi penjelasan dasar mereka, dan menghitung garis dasar bila diperlukan. Dokumentasi untuk menjelaskan dan mendeteksi bias menggunakan SageMaker Clarify disusun sebagai berikut:

-

Untuk informasi tentang menyiapkan pekerjaan pemrosesan untuk bias dan penjelasan, lihat. Konfigurasikan SageMaker Clarify Processing Job

-

Untuk informasi tentang mendeteksi bias dalam data pra-pemrosesan sebelum digunakan untuk melatih model, lihat. Bias Data Pra-pelatihan

-

Untuk informasi tentang mendeteksi data pasca-pelatihan dan bias model, lihat. Data Pasca Pelatihan dan Bias Model

-

Untuk informasi tentang pendekatan atribusi fitur model-agnostik untuk menjelaskan prediksi model setelah pelatihan, lihat. Penjelasan Model

-

Untuk informasi tentang pemantauan kontribusi fitur yang menjauh dari baseline yang ditetapkan selama pelatihan model, lihat. Penyimpangan atribusi fitur untuk model dalam produksi

-

Untuk informasi tentang model pemantauan yang sedang diproduksi untuk penyimpangan dasar, lihat. Bias drift untuk model dalam produksi

-

Untuk informasi tentang mendapatkan penjelasan secara real time dari titik akhir SageMaker AI, lihat. Penjelasan online dengan Clarify SageMaker

Bagaimana SageMaker Memperjelas Pekerjaan Pemrosesan Pekerjaan

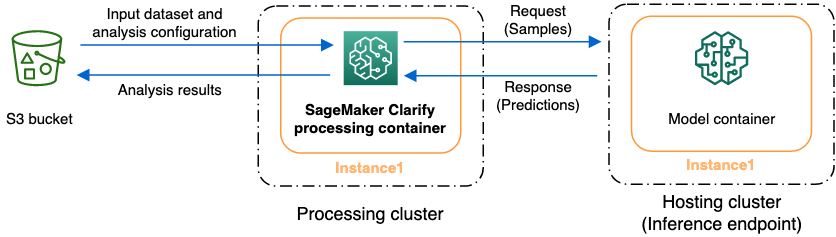

Anda dapat menggunakan SageMaker Clarify untuk menganalisis kumpulan data dan model Anda untuk menjelaskan dan bias. Pekerjaan pemrosesan SageMaker Clarify menggunakan container pemrosesan SageMaker Clarify untuk berinteraksi dengan bucket Amazon S3 yang berisi kumpulan data input Anda. Anda juga dapat menggunakan SageMaker Clarify untuk menganalisis model pelanggan yang diterapkan ke titik akhir inferensi SageMaker AI.

Grafik berikut menunjukkan bagaimana pekerjaan pemrosesan SageMaker Clarify berinteraksi dengan data input Anda dan secara opsional, dengan model pelanggan. Interaksi ini tergantung pada jenis analisis spesifik yang dilakukan. Container pemrosesan SageMaker Clarify memperoleh dataset input dan konfigurasi untuk analisis dari bucket S3. Untuk jenis analisis tertentu, termasuk analisis fitur, wadah pemrosesan SageMaker Clarify harus mengirim permintaan ke wadah model. Kemudian mengambil prediksi model dari respons yang dikirim oleh wadah model. Setelah itu, wadah pemrosesan SageMaker Clarify menghitung dan menyimpan hasil analisis ke bucket S3.

Anda dapat menjalankan tugas pemrosesan SageMaker Clarify pada beberapa tahap dalam siklus hidup alur kerja pembelajaran mesin. SageMaker Clarify dapat membantu Anda menghitung jenis analisis berikut:

-

Metrik bias pra-pelatihan. Metrik ini dapat membantu Anda memahami bias dalam data Anda sehingga Anda dapat mengatasinya dan melatih model Anda pada kumpulan data yang lebih adil. Lihat Metrik Bias Pra-pelatihan untuk informasi tentang metrik bias pra-pelatihan. Untuk menjalankan pekerjaan menganalisis metrik bias pra-pelatihan, Anda harus menyediakan kumpulan data dan file konfigurasi analisis JSON. File konfigurasi

-

Metrik bias pasca-pelatihan. Metrik ini dapat membantu Anda memahami bias apa pun yang diperkenalkan oleh algoritme, pilihan hiperparameter, atau bias apa pun yang tidak terlihat sebelumnya dalam aliran. Untuk informasi lebih lanjut tentang metrik bias pasca-pelatihan, lihat. Data Pasca-pelatihan dan Metrik Bias Model SageMaker Clarify menggunakan prediksi model selain data dan label untuk mengidentifikasi bias. Untuk menjalankan pekerjaan menganalisis metrik bias pasca-pelatihan, Anda harus menyediakan kumpulan data dan file konfigurasi analisis JSON. Konfigurasi harus menyertakan model atau nama titik akhir.

-

Nilai Shapley, yang dapat membantu Anda memahami dampak fitur Anda terhadap prediksi model Anda. Untuk informasi lebih lanjut tentang nilai-nilai batas waktu tersebut, lihat Atribusi Fitur yang Menggunakan Nilai Shapley. Fitur ini membutuhkan model yang terlatih.

-

Plot ketergantungan parsi (PDPs), yang dapat membantu Anda memahami seberapa besar variabel target prediksi Anda akan berubah jika Anda memvariasikan nilai satu fitur. Untuk informasi selengkapnya PDPs, lihat Fitur Analisis plot ketergantungan sebagian (PDPs) ini memerlukan model terlatih.

SageMaker Klarifikasi prediksi model kebutuhan untuk menghitung metrik bias pasca-pelatihan dan atribusi fitur. Anda dapat memberikan endpoint atau SageMaker Clarify akan membuat endpoint sementara menggunakan nama model Anda, juga dikenal sebagai titik akhir bayangan. Container SageMaker Clarify menghapus titik akhir bayangan setelah perhitungan selesai. Pada tingkat tinggi, kontainer SageMaker Clarify menyelesaikan langkah-langkah berikut:

-

Memvalidasi input dan parameter.

-

Menciptakan titik akhir bayangan (jika nama model disediakan).

-

Memuat dataset input ke dalam bingkai data.

-

Memperoleh prediksi model dari titik akhir, jika perlu.

-

Menghitung metrik bias dan fitur atribusi.

-

Menghapus titik akhir bayangan.

-

Menghasilkan hasil analisis.

Setelah pekerjaan pemrosesan SageMaker Clarify selesai, hasil analisis akan disimpan di lokasi keluaran yang Anda tentukan dalam parameter keluaran pemrosesan pekerjaan. Hasil ini mencakup file JSON dengan metrik bias dan atribusi fitur global, laporan visual, dan file tambahan untuk atribusi fitur lokal. Anda dapat mengunduh hasil dari lokasi output dan melihatnya.

Untuk informasi tambahan tentang metrik bias, penjelasan, dan cara menafsirkannya, lihat Pelajari Bagaimana Amazon SageMaker Clarify Membantu Mendeteksi Bias

Notebooks contoh

Bagian berikut berisi buku catatan untuk membantu Anda mulai menggunakan SageMaker Clarify, menggunakannya untuk tugas-tugas khusus, termasuk yang ada di dalam pekerjaan terdistribusi, dan untuk visi komputer.

Memulai

Contoh buku catatan berikut menunjukkan cara menggunakan SageMaker Clarify untuk memulai tugas penjelasan dan bias model. Tugas-tugas ini termasuk membuat pekerjaan pemrosesan, melatih model pembelajaran mesin (ML), dan memantau prediksi model:

-

Penjelasan dan deteksi bias dengan Amazon SageMaker Clarify

— Gunakan SageMaker Clarify untuk membuat pekerjaan pemrosesan guna mendeteksi bias dan menjelaskan prediksi model. -

Memantau penyimpangan bias dan penyimpangan atribusi fitur Amazon SageMaker

Clarify — Gunakan Monitor Model SageMaker Amazon untuk memantau penyimpangan bias dan fitur penyimpangan atribusi dari waktu ke waktu. -

Cara membaca kumpulan data dalam format JSON Lines menjadi pekerjaan

pemrosesan SageMaker Clarify. -

Mitigasi Bias, latih model lain yang tidak bias, dan masukkan ke dalam registri model

— Gunakan Teknik Pengambilan Sampel Minoritas Sintetis (SMOTE) dan SageMaker Klarifikasi untuk mengurangi bias, melatih model lain, lalu memasukkan model baru ke dalam registri model. Notebook contoh ini juga menunjukkan cara menempatkan artefak model baru, termasuk data, kode, dan metadata model, ke dalam registri model. Notebook ini adalah bagian dari seri yang menunjukkan cara mengintegrasikan SageMaker Clarify ke dalam pipeline SageMaker AI yang dijelaskan dalam Arsitek dan membangun siklus hidup pembelajaran mesin lengkap dengan AWS posting blog.

Kasus khusus

Buku catatan berikut menunjukkan cara menggunakan SageMaker Clarify untuk kasus khusus termasuk di dalam wadah Anda sendiri dan untuk tugas pemrosesan bahasa alami:

-

Keadilan dan Keterjelasan dengan SageMaker Clarify (Bring Your Own Container)

— Bangun model dan wadah Anda sendiri yang dapat diintegrasikan dengan SageMaker Clarify untuk mengukur bias dan menghasilkan laporan analisis penjelasan. Notebook contoh ini juga memperkenalkan istilah-istilah utama dan menunjukkan cara mengakses laporan melalui SageMaker Studio Classic. -

Keadilan dan Keterjelasan dengan SageMaker Clarify Spark Distributed Processing

— Gunakan pemrosesan terdistribusi untuk menjalankan pekerjaan SageMaker Clarify yang mengukur bias pra-pelatihan dari kumpulan data dan bias pasca-pelatihan suatu model. Contoh buku catatan ini juga menunjukkan kepada Anda cara mendapatkan penjelasan tentang pentingnya fitur input pada keluaran model, dan mengakses laporan analisis eksplainabilitas melalui SageMaker Studio Classic. -

Keterjelasan dengan SageMaker Clarify - Plot Ketergantungan Sebagian (PDP)

- Gunakan SageMaker Clarify untuk menghasilkan PDPs dan mengakses laporan penjelasan model. -

Gunakan penjelasan visi komputer (CV) untuk klasifikasi gambar dan deteksi

objek .

Notebook ini telah diverifikasi untuk berjalan di Amazon SageMaker Studio Classic. Jika Anda memerlukan petunjuk tentang cara membuka notebook di Studio Classic, lihatMembuat atau Membuka Notebook Amazon SageMaker Studio Classic. Jika Anda diminta untuk memilih kernel, pilih Python 3 (Ilmu Data).