Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Menerapkan Model Kompilasi Menggunakan Konsol

Anda harus memenuhi bagian prasyarat jika model dikompilasi menggunakan AWS SDK untuk Python (Boto3), konsol, AWS CLI atau Amazon AI. SageMaker Ikuti langkah-langkah di bawah ini untuk membuat dan menerapkan model yang dikompilasi SageMaker AI Neo menggunakan konsol SageMaker https://console.aws.amazon.com AI/AI. SageMaker

Topik

Menyebarkan Model

Setelah Anda memenuhi prasyarat, gunakan langkah-langkah berikut untuk menerapkan model yang dikompilasi dengan Neo:

-

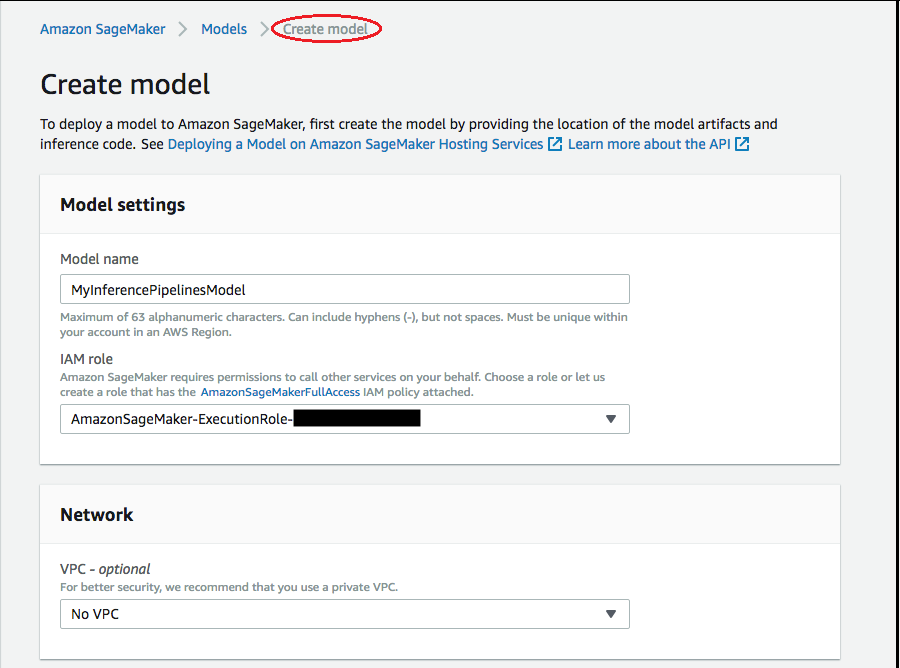

Pilih Model, lalu pilih Buat model dari grup Inferensi. Pada halaman Buat model, lengkapi nama Model, peran IAM, dan bidang VPC (opsional), jika diperlukan.

-

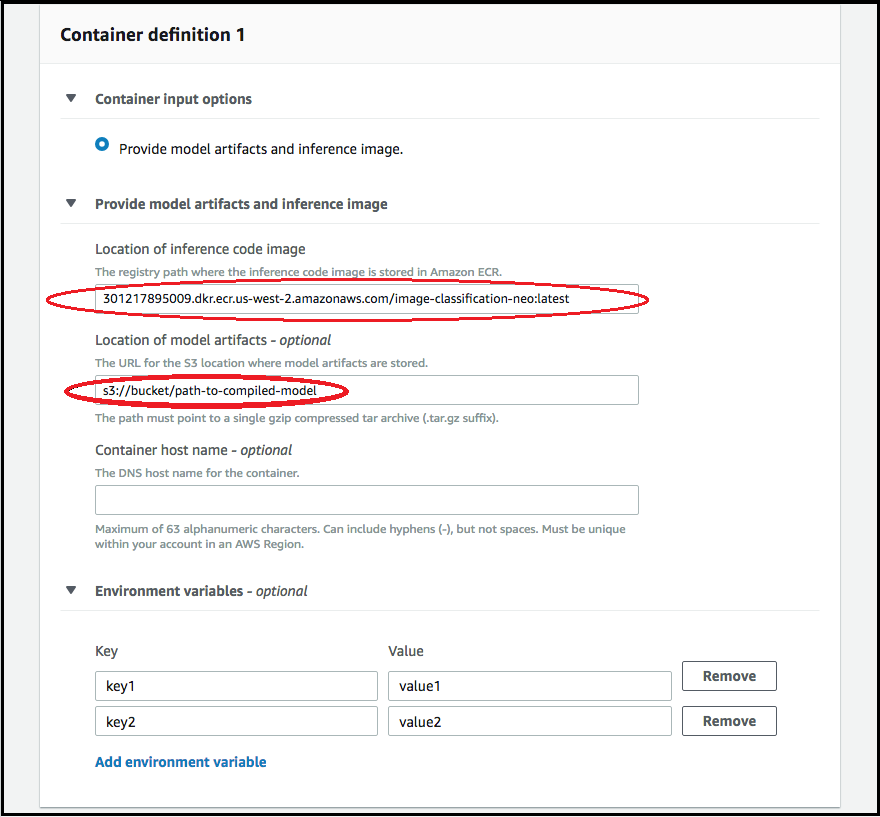

Untuk menambahkan informasi tentang kontainer yang digunakan untuk menyebarkan model Anda, pilih Tambahkan kontainer kontainer, lalu pilih Berikutnya. Lengkapi opsi input Container, Lokasi gambar kode inferensi, dan Lokasi artefak model, dan opsional, nama host kontainer, dan bidang variabel Lingkungan.

-

Untuk menerapkan model yang dikompilasi NEO, pilih yang berikut ini:

-

Opsi input kontainer: Pilih Berikan artefak model dan gambar inferensi.

-

Lokasi gambar kode inferensi: Pilih URI gambar inferensi dari Neo Inference Container Images, tergantung pada AWS Wilayah dan jenis aplikasi.

-

Lokasi artefak model: Masukkan URI bucket Amazon S3 dari artefak model terkompilasi yang dihasilkan oleh API kompilasi Neo.

-

Variabel lingkungan:

-

Biarkan bidang ini kosong untuk SageMaker XGBoost.

-

Jika Anda melatih model menggunakan SageMaker AI, tentukan variabel lingkungan

SAGEMAKER_SUBMIT_DIRECTORYsebagai URI bucket Amazon S3 yang berisi skrip pelatihan. -

Jika Anda tidak melatih model Anda menggunakan SageMaker AI, tentukan variabel lingkungan berikut:

Kunci Nilai untuk MXNet dan PyTorch Nilai TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <your region> <your region> MMS_DEFAULT_RESPONSE_TIMEOUT 500 Biarkan bidang ini kosong untuk TF

-

-

-

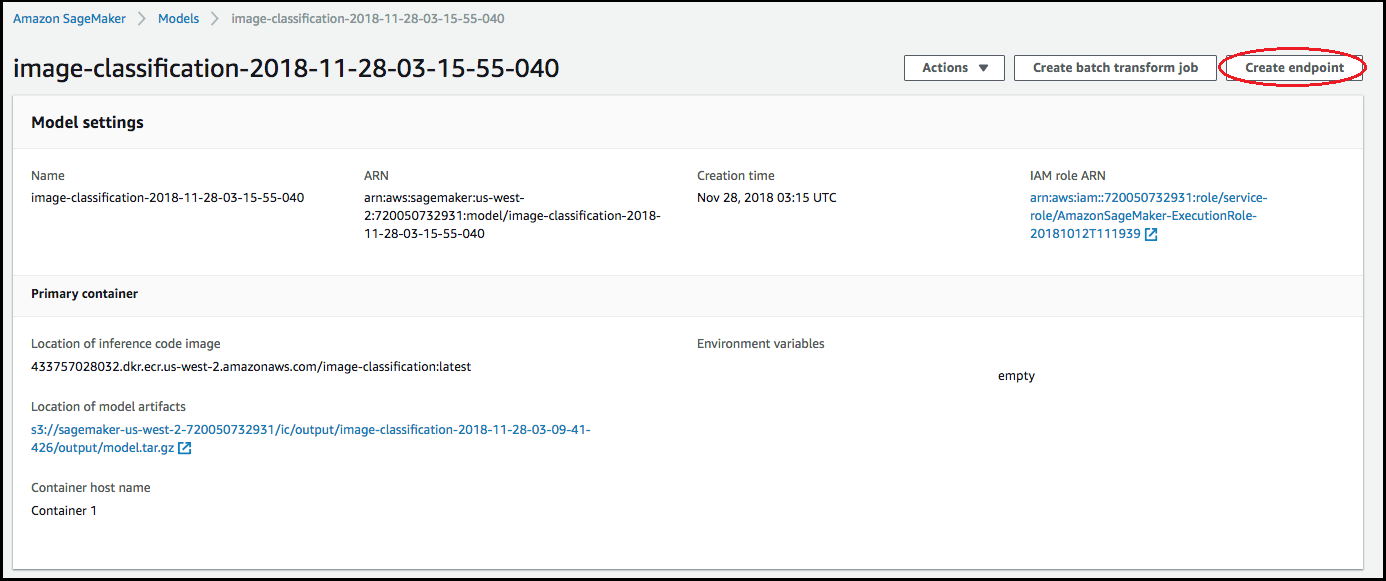

Konfirmasikan bahwa informasi untuk kontainer akurat, lalu pilih Buat model. Pada halaman landing Create model, pilih Create endpoint.

-

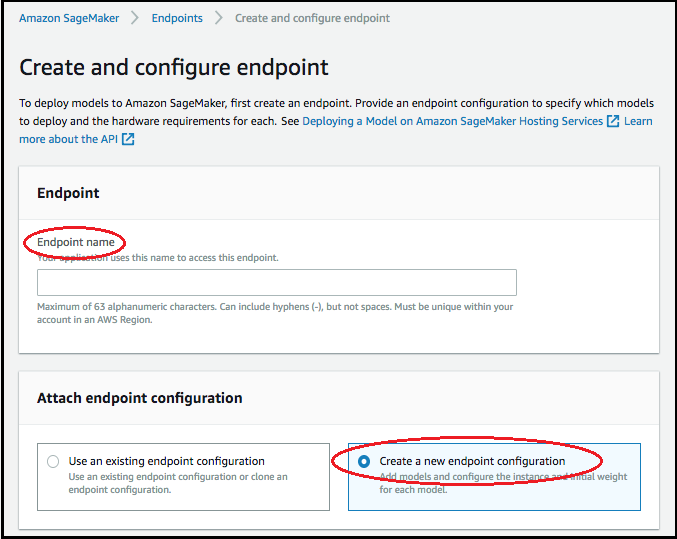

Di Buat dan konfigurasikan diagram titik akhir, tentukan nama Endpoint. Untuk konfigurasi Attach endpoint, pilih Create a new endpoint configuration.

-

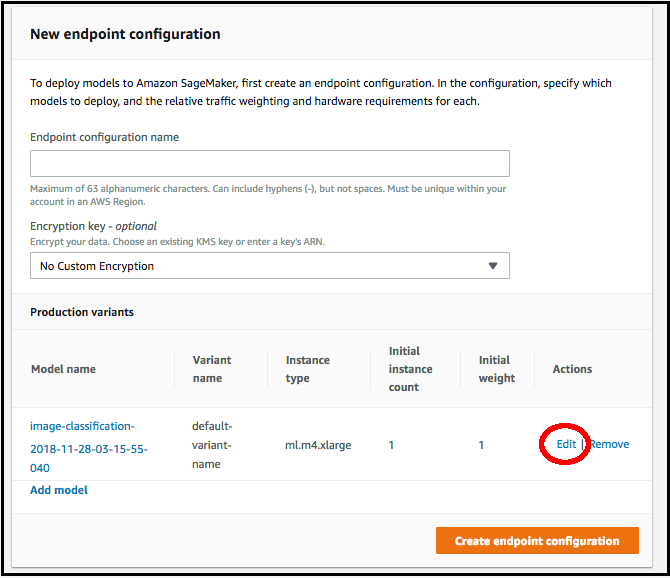

Di halaman konfigurasi titik akhir baru, tentukan nama konfigurasi Endpoint.

-

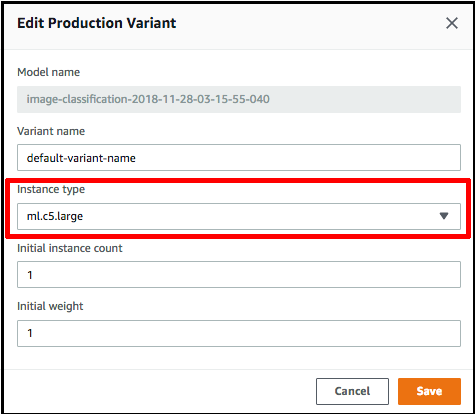

Pilih Edit di samping nama model dan tentukan jenis Instance yang benar pada halaman Edit Production Variant. Sangat penting bahwa nilai tipe Instance cocok dengan yang ditentukan dalam pekerjaan kompilasi Anda.

-

Pilih Simpan.

-

Pada halaman konfigurasi titik akhir baru, pilih Buat konfigurasi titik akhir, lalu pilih Buat titik akhir.