Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Aggiungere dati a un database RDS di origine (cluster ) e interrogarlo

Per completare la creazione di un'integrazione zero-ETL che replica i dati da Amazon RDS Amazon Amazon Redshift, devi creare un database nella destinazione di destinazione.

Per le connessioni con Amazon Redshift, connettiti al tuo cluster o gruppo di lavoro Amazon Redshift e crea un database con un riferimento al tuo identificatore di integrazione. Quindi, puoi aggiungere dati al cluster del database RDS di origine e vederli replicati in Amazon Redshift o. Amazon SageMaker

Argomenti

Creazione di un database di destinazione

Prima di poter iniziare a replicare i dati in Amazon Redshift, dopo aver creato un'integrazione, devi creare un database nel data warehouse di destinazione. Questo database deve includere un riferimento all'identificatore di integrazione. Puoi utilizzare la console Amazon Redshift o Editor di query v2 per creare il database.

Per istruzioni sulla creazione di un database di destinazione, consulta Creazione di un database di destinazione in Amazon Redshift.

Aggiungere dati al cluster del database di origine

Dopo aver configurato l'integrazione, puoi popolare il del database RDS di origine con i dati che desideri replicare nel tuo data warehouse.

Nota

Esistono differenze tra i tipi di dati in Amazon RDS Aurora e il magazzino di analisi di destinazione. Per una tabella di mappature dei tipi di dati, consulta Differenze tra i tipi di dati tra i database RDS e Amazon Redshift.

Innanzitutto, connettiti al del database di origine utilizzando il client di tua scelta. Per istruzioni, consultare Connessione alla tua istanza DB MySQL.

Quindi, crea una tabella e inserisci una riga di dati di esempio.

Importante

Assicurati che la tabella abbia una chiave primaria. Altrimenti, non può essere replicata nel data warehouse di destinazione.

per MySQL

L'esempio seguente utilizza l'utilità MySQL Workbench

CREATE DATABASEmy_db; USEmy_db; CREATE TABLEbooks_table(ID int NOT NULL, Title VARCHAR(50) NOT NULL, Author VARCHAR(50) NOT NULL, Copyright INT NOT NULL, Genre VARCHAR(50) NOT NULL, PRIMARY KEY (ID)); INSERT INTObooks_tableVALUES (1, 'The Shining', 'Stephen King', 1977, 'Supernatural fiction');

RDS per PostgreSQL

L'esempio seguente utilizza il terminale psql interattivo PostgreSQL. Quando ti connetti al database, includi il nome del database che desideri replicare.

psql -hmydatabase.123456789012.us-east-2.rds.amazonaws.com -p 5432 -Uusername-dnamed_db; named_db=> CREATE TABLEbooks_table(ID int NOT NULL, Title VARCHAR(50) NOT NULL, Author VARCHAR(50) NOT NULL, Copyright INT NOT NULL, Genre VARCHAR(50) NOT NULL, PRIMARY KEY (ID)); named_db=> INSERT INTObooks_tableVALUES (1, 'The Shining', 'Stephen King', 1977, 'Supernatural fiction');

RDS per Oracle

L'esempio seguente utilizza SQL*Plus per connettersi al database RDS for Oracle.

sqlplus 'user_name@(DESCRIPTION=(ADDRESS=(PROTOCOL=TCP)(HOST=dns_name)(PORT=port))(CONNECT_DATA=(SID=database_name)))' SQL> CREATE TABLEbooks_table(ID int NOT NULL, Title VARCHAR(50) NOT NULL, Author VARCHAR(50) NOT NULL, Copyright INT NOT NULL, Genre VARCHAR(50) NOT NULL, PRIMARY KEY (ID)); SQL> INSERT INTObooks_tableVALUES (1, 'The Shining', 'Stephen King', 1977, 'Supernatural fiction');

Interrogazione dei dati di Amazon RDS in Amazon Redshift

Dopo aver aggiunto i dati al cluster del database RDS, questi vengono replicati nel database di destinazione e sono pronti per essere interrogati.

Esecuzione di query sui dati replicati

-

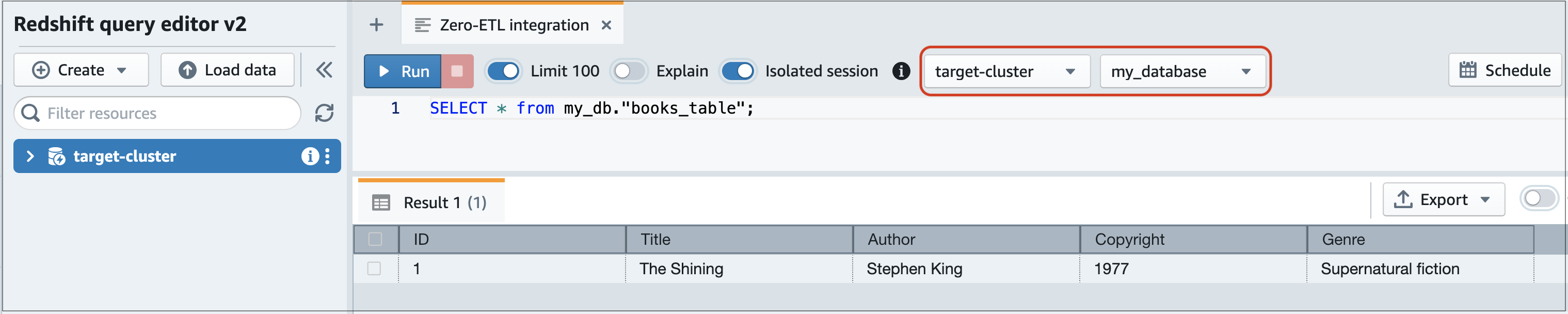

Vai alla console Amazon Redshift e scegli Editor di query v2 nel riquadro di navigazione a sinistra.

-

Connettiti al cluster o al gruppo di lavoro e scegli il database di destinazione (creato dall'integrazione) dal menu a tendina (destination_database in questo esempio). Per istruzioni sulla creazione di un database di destinazione, consulta Creazione di un database di destinazione in Amazon Redshift.

-

Utilizza un'istruzione SELECT per interrogare i tuoi dati. In questo esempio, è possibile eseguire il comando seguente per selezionare tutti i dati dalla tabella creata nel database RDS di origine del cluster :

SELECT * frommy_db."books_table";

-

my_db -

books_table

-

È inoltre possibile interrogare i dati utilizzando un client a riga di comando. Per esempio:

destination_database=# select * frommy_db."books_table"; ID | Title | Author | Copyright | Genre | txn_seq | txn_id ----+–------------+---------------+-------------+------------------------+----------+--------+ 1 | The Shining | Stephen King | 1977 | Supernatural fiction | 2 | 12192

Nota

Per distinguere tra maiuscole e minuscole, usa le virgolette doppie (" ") per i nomi di schemi, tabelle e colonne. Per ulteriori informazioni, consulta enable_case_sensitive_identifier.

Differenze tra i tipi di dati tra i database RDS e Amazon Redshift

Le tabelle seguenti mostrano le mappature delle tabelle RDS per MySQL, RDS per PostgreSQL e RDS per Oracle mostrano le mappature di Aurora MySQL e Aurora PostgreSQL . Amazon RDS Aurora attualmente supporta solo questi tipi di dati per integrazioni zero-ETL.

Se una tabella nel del database di origine include un tipo di dati non supportato, la tabella non è sincronizzata e non è utilizzabile dalla destinazione di destinazione. Lo streaming dall'origine alla destinazione va avanti, ma la tabella con il tipo di dati non supportato non è disponibile. Per correggere la tabella e renderla disponibile nella destinazione di destinazione, è necessario annullare manualmente la modifica iniziale e quindi aggiornare l'integrazione eseguendo. ALTER DATABASE...INTEGRATION

REFRESH

Nota

Non puoi aggiornare le integrazioni zero-ETL con un lakehouse. Amazon SageMaker Invece, elimina e prova a creare nuovamente l'integrazione.

Argomenti

| Tipo di dati RDS per MySQL | Tipo di dati di destinazione | Descrizione | Limitazioni |

|---|---|---|---|

| INT | INTEGER | Intero a quattro byte firmato | Nessuno |

| SMALLINT | SMALLINT | Intero a due byte firmato | Nessuno |

| TINYINT | SMALLINT | Intero a due byte firmato | Nessuno |

| MEDIUMINT | INTEGER | Intero a quattro byte firmato | Nessuno |

| BIGINT | BIGINT | Intero a otto byte firmato | Nessuno |

| INT UNSIGNED | BIGINT | Intero a otto byte firmato | Nessuno |

| TINYINT UNSIGNED | SMALLINT | Intero a due byte firmato | Nessuno |

| MEDIUMINT UNSIGNED | INTEGER | Intero a quattro byte firmato | Nessuno |

| BIGINT UNSIGNED | DECIMAL(20,0) | Numerico esatto di precisione selezionabile | Nessuno |

| DECIMALE (p, s) = NUMERICO (p, s) | DECIMAL(p,s) | Numerico esatto di precisione selezionabile |

Precisione superiore a 38 e scala superiore a 37 non supportate |

| DECIMALE (p, s) SENZA SEGNO = NUMERICO (p, s) SENZA SEGNO | DECIMAL(p,s) | Numerico esatto di precisione selezionabile |

Precisione superiore a 38 e scala superiore a 37 non supportate |

| FLOAT4/REALE | REAL | Numero in virgola mobile a precisione singola | Nessuno |

| FLOAT4/REAL NON FIRMATO | REAL | Numero in virgola mobile a precisione singola | Nessuno |

| DOUBLE/REAL/FLOAT8 | DOUBLE PRECISION | Numero in virgola mobile a precisione doppia | Nessuno |

| DOUBLE/REAL/FLOAT8 NON FIRMATO | DOUBLE PRECISION | Numero in virgola mobile a precisione doppia | Nessuno |

| BIT (n) | BARBYTE(8) | Valore binario a lunghezza variabile | Nessuno |

| BINARY(n) | BARBYTE (n) | Valore binario a lunghezza variabile | Nessuno |

| VARBINARY(n) | VARBYTE (n) | Valore binario a lunghezza variabile | Nessuno |

| CHAR(n) | VARCHAR(n) | Valore di stringa di lunghezza variabile | Nessuno |

| VARCHAR(n) | VARCHAR(n) | Valore di stringa di lunghezza variabile | Nessuno |

| TEXT | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| TINYTEXT | VARCHAR(255) | Valore di stringa a lunghezza variabile fino a 255 caratteri | Nessuno |

| MEDIUMTEXT | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| LONGTEXT | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| ENUM | VARCHAR(1020) | Valore di stringa a lunghezza variabile fino a 1.020 caratteri | Nessuno |

| SET | VARCHAR(1020) | Valore di stringa a lunghezza variabile fino a 1.020 caratteri | Nessuno |

| DATE | DATE | Data di calendario (anno, mese, giorno) | Nessuno |

| DATETIME | TIMESTAMP | Data e ora (senza fuso orario) | Nessuno |

| TIMESTAMP(p) | TIMESTAMP | Data e ora (senza fuso orario) | Nessuno |

| TIME | VARCHAR(18) | Valore di stringa a lunghezza variabile fino a 18 caratteri | Nessuno |

| ANNO | VARCHAR(4) | Valore di stringa a lunghezza variabile fino a 4 caratteri | Nessuno |

| JSON | SUPER | Dati o documenti semistrutturati come valori | Nessuno |

Le integrazioni zero-ETL per RDS for PostgreSQL Aurora PostgreSQL non supportano tipi di dati tipi di dati creati da estensioni.

| Tipo di dati RDS per PostgreSQL Aurora | Tipo di dati di Amazon Redshift | Descrizione | Limitazioni |

|---|---|---|---|

| array | SUPER | Dati o documenti semistrutturati come valori | Nessuno |

| bigint | BIGINT | Intero a otto byte firmato | Nessuno |

| grande seriale | BIGINT | Intero a otto byte firmato | Nessuno |

| bit variabile (n) | BARBYTE (n) | Valore binario a lunghezza variabile fino a 16.777.216 byte | Nessuno |

| bit (n) | BARBYTE (n) | Valore binario a lunghezza variabile fino a 16.777.216 byte | Nessuno |

| bit, bit variabile | BARBYTE (16777216) | Valore binario a lunghezza variabile fino a 16.777.216 byte | Nessuno |

| booleano | BOOLEAN | Booleano logico (vero/falso) | Nessuno |

| bytea | BARBYTE (16777216) | Valore binario a lunghezza variabile fino a 16.777.216 byte | Nessuno |

| carattere (n) | CHAR(n) | Valore di stringa di caratteri a lunghezza fissa fino a 65.535 byte | Nessuno |

| carattere variabile (n) | VARCHAR(65535) | Valore della stringa di caratteri a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| cid | BIGINT |

Intero a otto byte firmato |

Nessuno |

| sidro |

ARCHAR (19) |

Valore di stringa a lunghezza variabile fino a 19 caratteri |

Nessuno |

| data | DATE | Data di calendario (anno, mese, giorno) |

Valori superiori a 294.276 d.C. non sono supportati |

| double precision | DOUBLE PRECISION | Numeri a virgola mobile a doppia precisione | Valori subnormali non completamente supportati |

|

gtsvector |

VARCHAR(65535) |

Valore di stringa a lunghezza variabile fino a 65.535 caratteri |

Nessuno |

| inet |

VARCHAR (19) |

Valore di stringa a lunghezza variabile fino a 19 caratteri |

Nessuno |

| integer | INTEGER | Intero a quattro byte firmato | Nessuno |

|

int2 vector |

SUPER | Dati o documenti semistrutturati come valori. | Nessuno |

| intervallo | INTERVAL | Durata del tempo | Sono supportati solo i tipi INTERVAL che specificano un qualificatore anno/mese o un qualificatore da giorno a secondo. |

| json | SUPER | Dati o documenti semistrutturati come valori | Nessuno |

| jsonb | SUPER | Dati o documenti semistrutturati come valori | Nessuno |

| percorso json | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

|

macaddr |

VARCHAR (17) | Valore di stringa a lunghezza variabile fino a 17 caratteri | Nessuno |

|

macaddr8 |

BARRA (23) | Valore di stringa a lunghezza variabile fino a 23 caratteri | Nessuno |

| money | DECIMALE (20,3) | Importo in valuta | Nessuno |

| nome | VARCHAR (64) | Valore di stringa a lunghezza variabile fino a 64 caratteri | Nessuno |

| numeric(p,s) | DECIMAL(p,s) | Valore di precisione fisso definito dall'utente |

|

| oid | BIGINT | Intero a otto byte firmato | Nessuno |

| vettore oid | SUPER | Dati o documenti semistrutturati come valori. | Nessuno |

| pg_brin_bloom_summary | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| pg_dependencies | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| pg_lsn | VARCHAR (17) | Valore di stringa a lunghezza variabile fino a 17 caratteri | Nessuno |

| pg_mcv_list | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| pg_ndistinct | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| pg_node_tree | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| pg_snapshot | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| real | REAL | Numero in virgola mobile a precisione singola | Valori subnormali non completamente supportati |

| cursore | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| smallint | SMALLINT | Intero a due byte firmato | Nessuno |

| seriale piccolo | SMALLINT | Intero a due byte firmato | Nessuno |

| seriale | INTEGER | Intero a quattro byte firmato | Nessuno |

| text | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| tid | VARCHAR (23) | Valore di stringa a lunghezza variabile fino a 23 caratteri | Nessuno |

| ora [(p)] senza fuso orario | VARCHAR (19) | Valore di stringa a lunghezza variabile fino a 19 caratteri | Infinitye -Infinity valori non supportati |

| ora [(p)] con fuso orario | VARCHAR (22) | Valore di stringa a lunghezza variabile fino a 22 caratteri | Infinitye -Infinity valori non supportati |

| timestamp [(p)] senza fuso orario | TIMESTAMP | Data e ora (senza fuso orario) |

|

| timestamp [(p)] con fuso orario | TIMESTAMPTZ | Data e ora (con fuso orario) |

|

| tsquery | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| tsvector | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| txid_snapshot | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

| uuid | VARCHAR (36) | Stringa di 36 caratteri a lunghezza variabile | Nessuno |

| xid | BIGINT | Intero a otto byte firmato | Nessuno |

| xid8 | DECIMALE (20, 0) | Decimale a precisione fissa | Nessuno |

| xml | VARCHAR(65535) | Valore di stringa a lunghezza variabile fino a 65.535 caratteri | Nessuno |

RDS per Oracle

Tipi di dati non supportati

I seguenti tipi di dati RDS per Oracle non sono supportati da Amazon Redshift:

-

ANYDATA -

BFILE -

REF -

ROWID -

UROWID -

VARRAY -

SDO_GEOMETRY -

Tipi di dati definiti dall'utente

Differenze tra i tipi di dati

La tabella seguente mostra le differenze tra i tipi di dati che influiscono su un'integrazione zero-ETL quando RDS per Oracle è l'origine e Amazon Redshift è la destinazione.

| Tipo di dati RDS per Oracle | Tipo di dati di Amazon Redshift |

|---|---|

|

BINARY_FLOAT |

FLOAT4 |

|

BINARY_DOUBLE |

FLOAT8 |

|

BINARY |

VARCHAR (lunghezza) |

|

FLOAT (P) |

Se la precisione è =< 24, allora. FLOAT4 Se la precisione è > 24, allora FLOAT8. |

|

NUMBER (P,S) |

Se la scala è => 0 e =< 37, allora NUMERIC (p, s). Se la scala è => 38 e =< 127, allora VARCHAR (Lunghezza). Se la scala è 0:

Se la scala è inferiore a 0, allora INT8. |

|

DATE |

Se la scala è => 0 e =< 6, a seconda del tipo di colonna di destinazione Redshift, allora una delle seguenti:

Se la scala è => 7 e =< 9, allora VARCHAR (37). |

|

INTERVAL_YEAR TO MONTH |

Se la lunghezza è 1—65.535, allora VARCHAR (lunghezza in byte). Se la lunghezza è 65.536—2.147.483.647, allora VARCHAR (65535). |

|

INTERVAL_DAY TO SECOND |

Se la lunghezza è 1—65.535, allora VARCHAR (lunghezza in byte). Se la lunghezza è 65.536—2.147.483.647, allora VARCHAR (65535). |

|

TIMESTAMP |

Se la scala è => 0 e =< 6, a seconda del tipo di colonna di destinazione Redshift, allora una delle seguenti:

Se la scala è => 7 e =< 9, allora VARCHAR (37). |

|

TIMESTAMP WITH TIME ZONE |

Se la lunghezza è 1—65.535, allora VARCHAR (lunghezza in byte). Se la lunghezza è 65.536—2.147.483.647, allora VARCHAR (65535). |

|

TIMESTAMP WITH LOCAL TIME ZONE |

Se la lunghezza è 1—65.535, allora VARCHAR (lunghezza in byte). Se la lunghezza è 65.536—2.147.483.647, allora VARCHAR (65535). |

|

CHAR |

Se la lunghezza è 1—65.535, allora VARCHAR (lunghezza in byte). Se la lunghezza è 65.536—2.147.483.647, allora VARCHAR (65535). |

|

VARCHAR2 |

Quando la lunghezza è superiore a 4.000 byte, allora VARCHAR (dimensione massima LOB). Le dimensioni massime di LOB non possono superare 63 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. Quando la lunghezza è pari o inferiore a 4.000 byte, allora VARCHAR (lunghezza in byte). |

|

NCHAR |

Se la lunghezza è compresa tra 1 e 65.535, allora NVARCHAR (lunghezza in byte). Se la lunghezza è 65.536—2.147.483.647, allora NVARCHAR (65535). |

|

NVARCHAR2 |

Quando la lunghezza è superiore a 4.000 byte, allora NVARCHAR (dimensione massima LOB). Le dimensioni massime di LOB non possono superare 63 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. Quando la lunghezza è pari o inferiore a 4.000 byte, allora NVARCHAR (lunghezza in byte). |

|

RAW |

VARCHAR (lunghezza) |

|

REAL |

FLOAT8 |

|

BLOB |

VARCHAR (dimensioni massime di LOB *2) Le dimensioni massime di LOB non possono superare 31 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. |

|

CLOB |

VARCHAR (dimensioni massime di LOB) Le dimensioni massime di LOB non possono superare 63 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. |

|

NCLOB |

NVARCHAR (dimensioni massime di LOB) Le dimensioni massime di LOB non possono superare 63 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. |

|

LONG |

VARCHAR (dimensioni massime di LOB) Le dimensioni massime di LOB non possono superare 63 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. |

|

LONG RAW |

VARCHAR (dimensioni massime di LOB *2) Le dimensioni massime di LOB non possono superare 31 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. |

|

XMLTYPE |

VARCHAR (dimensioni massime di LOB) Le dimensioni massime di LOB non possono superare 63 KB. Amazon Redshift non supporta VARCHARs dimensioni superiori a 64 KB. |

Le integrazioni zero-ETL sfruttano queste somiglianze per semplificare la replica dei dati da RDS per PostgreSQL Aurora PostgreSQL ad Amazon Redshift, mappando , schema e tabella.

Considera i seguenti punti quando gestisci le integrazioni RDS per PostgreSQL Aurora Zero-ETL:

-

L'isolamento è gestito a livello di database.

-

La replica avviene a livello di database.

-

I database RDS per PostgreSQL sono mappati ai database Amazon Redshift per nome, con i dati che fluiscono verso il corrispondente database Redshift rinominato se l'originale viene rinominato.

Nonostante le loro somiglianze, Amazon Redshift e RDS per PostgreSQL Aurora presentano differenze importanti. Le seguenti sezioni descrivono le risposte del sistema Amazon Redshift per le operazioni DDL comuni.

Operazioni di database

La tabella seguente mostra le risposte di sistema per le operazioni DDL del database.

| Operazione DDL | Risposta del sistema Redshift |

|---|---|

CREATE DATABASE |

Nessuna operazione |

DROP DATABASE |

Amazon Redshift elimina tutti i dati nel database Redshift di destinazione. |

RENAME DATABASE |

Amazon Redshift elimina tutti i dati nel database di destinazione originale e risincronizza i dati nel nuovo database di destinazione. Se il nuovo database non esiste, devi crearlo manualmente. Per istruzioni, consulta Creare un database di destinazione in Amazon Redshift. |

Operazioni dello schema

La tabella seguente mostra le risposte del sistema per le operazioni DDL dello schema.

| Operazione DDL | Risposta del sistema Redshift |

|---|---|

CREATE SCHEMA |

Nessuna operazione |

DROP SCHEMA |

Amazon Redshift elimina lo schema originale. |

RENAME SCHEMA |

Amazon Redshift elimina lo schema originale, quindi risincronizza i dati nel nuovo schema. |

Operazioni sulle tabelle

La tabella seguente mostra le risposte del sistema per le operazioni DDL della tabella.

| Operazione DDL | Risposta del sistema Redshift |

|---|---|

CREATE TABLE |

Amazon Redshift crea la tabella. Alcune operazioni impediscono la creazione della tabella, ad esempio la creazione di una tabella senza una chiave primaria o l'esecuzione del partizionamento dichiarativo. Per ulteriori informazioni, consultare Limitazioni e Risoluzione dei problemi delle integrazioni zero-ETL di Amazon RDS. |

DROP TABLE |

Amazon Redshift abbandona la situazione. |

TRUNCATE TABLE |

Amazon Redshift tronca la tabella. |

ALTER TABLE

(RENAME...) |

Amazon Redshift rinomina la tabella o la colonna. |

ALTER TABLE (SET

SCHEMA) |

Amazon Redshift elimina la tabella nello schema originale e risincronizza la tabella nel nuovo schema. |

ALTER TABLE (ADD PRIMARY

KEY) |

Amazon Redshift aggiunge una chiave primaria e risincronizza la tabella. |

ALTER TABLE (ADD

COLUMN) |

Amazon Redshift aggiunge una colonna alla tabella. |

ALTER TABLE (DROP

COLUMN) |

Amazon Redshift elimina la colonna se non è una colonna chiave primaria. Altrimenti, risincronizza la tabella. |

ALTER TABLE (SET

LOGGED/UNLOGGED) |

Se modifichi la tabella in loggata, Amazon Redshift risincronizza la tabella. Se modifichi la tabella in unlogged, Amazon Redshift elimina la tabella. |