Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

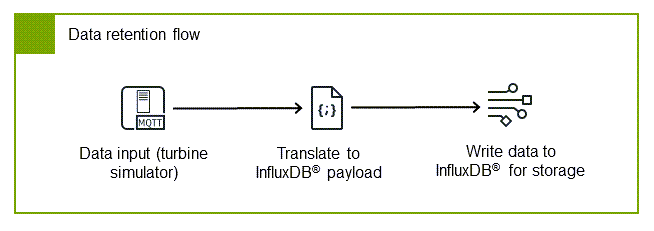

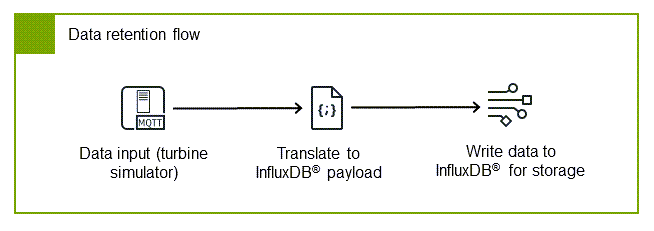

Configura il flusso di conservazione dei dati

Il flusso di conservazione dei dati può essere utilizzato per mantenere la visibilità operativa ai margini. Ciò è utile durante le interruzioni della rete o quando è necessario l'accesso immediato ai dati. Questo flusso si iscrive al broker MQTT per ricevere i dati del dispositivo, li converte in formato InfluxDB® e li archivia localmente. Implementando questo flusso, si crea un archivio dati locale resiliente a cui gli operatori possono accedere senza dipendere dal cloud, che consente il monitoraggio in tempo reale e il processo decisionale a livello perimetrale.

Il flusso è composto da tre componenti chiave che interagiscono per garantire che i dati vengano acquisiti e archiviati correttamente:

-

Client di abbonamento MQTT: riceve i dati dal broker, garantendo l'acquisizione di tutti i dati industriali pertinenti

-

Traduttore InfluxDB: converte il AWS IoT SiteWise payload in formato InfluxDB, preparando i dati per un'archiviazione efficiente delle serie temporali

-

Writer InfluxDB: gestisce l'archiviazione locale, garantendo la persistenza e la disponibilità dei dati per le applicazioni locali

Configura il client di abbonamento MQTT

-

Configura il client di abbonamento MQTT in Node-RED per ricevere dati dal broker MQTT EMQX importando l'esempio seguente. AWS IoT SiteWise

Esempio : MQTT nel nodo

[ { "id": "string", "type": "mqtt in", "z": "string", "name": "Subscribe to MQTT broker", "topic": "/Renton/WindFarm/Turbine/WindSpeed", "qos": "1", "datatype": "auto-detect", "broker": "string", "nl": false, "rap": true, "rh": 0, "inputs": 0, "x": 290, "y": 340, "wires": [ [ "string" ] ] }, { "id": "string", "type": "mqtt-broker", "name": "emqx", "broker": "127.0.0.1", "port": "1883", "clientid": "", "autoConnect": true, "usetls": false, "protocolVersion": "5", "keepalive": 15, "cleansession": true, "autoUnsubscribe": true, "birthTopic": "", "birthQos": "0", "birthPayload": "", "birthMsg": {}, "closeTopic": "", "closePayload": "", "closeMsg": {}, "willTopic": "", "willQos": "0", "willPayload": "", "willMsg": {}, "userProps": "", "sessionExpiry": "" } ]

Questo abbonamento garantisce che tutti i dati rilevanti pubblicati sul broker vengano acquisiti per l'archiviazione locale, fornendo una registrazione completa delle vostre operazioni industriali. Il nodo utilizza gli stessi parametri di connessione MQTT della Configurare l'editore MQTT sezione, con le seguenti impostazioni di abbonamento:

-

Argomento —

/Renton/WindFarm/Turbine/WindSpeed -

QoS —

1

Per ulteriori informazioni, vedere Connect to an MQTT Broker

Configura il traduttore InfluxDB

InfluxDB organizza i dati utilizzando tag

-

Tag: proprietà di qualità e nome per un'indicizzazione efficiente

-

Campi: timestamp (in millisecondi dall'epoca) e valore

Esempio : nodo funzionale di traduzione in un payload InfluxDB

[ { "id": "string", "type": "function", "z": "string", "name": "Translate to InfluxDB payload", "func": "let data = msg.payload;\n\nlet timeInSeconds = data.propertyValues[0].timestamp.timeInSeconds;\nlet offsetInNanos = data.propertyValues[0].timestamp.offsetInNanos;\nlet timestampInMilliseconds = (timeInSeconds * 1000) + (offsetInNanos / 1000000);\n\nmsg.payload = [\n {\n \"timestamp(milliseconds_since_epoch)\": timestampInMilliseconds,\n \"value\": data.propertyValues[0].value.doubleValue\n },\n {\n \"name\": data.propertyAlias,\n \"quality\": data.propertyValues[0].quality\n }\n]\n\nreturn msg", "outputs": 1, "timeout": "", "noerr": 0, "initialize": "", "finalize": "", "libs": [], "x": 560, "y": 340, "wires": [ [ "string" ] ] } ]

Per ulteriori opzioni di configurazione, consulta il node-red-contrib-influxdb

Configura lo scrittore InfluxDB

Il nodo writer InfluxDB è il componente finale del flusso di conservazione dei dati, responsabile della memorizzazione dei dati industriali nel database locale InfluxDB. Questa archiviazione locale è importante per mantenere la visibilità operativa durante le interruzioni della rete e fornire l'accesso immediato ai dati per applicazioni che richiedono un intervento urgente.

-

Installa il node-red-contrib-influxdb pacchetto tramite l'opzione Manage palette. Questo pacchetto fornisce i nodi necessari per connettere Node-RED con InfluxDB.

-

Aggiungi un nodo di uscita InfluxDB al tuo flusso. Questo nodo gestirà l'effettiva scrittura dei dati nel database InfluxDB.

-

Configura le proprietà del server per stabilire una connessione sicura alla tua istanza InfluxDB:

-

Imposta la versione su 2.0: specifica che ti stai connettendo a InfluxDB v2.x, che utilizza un'API diversa rispetto alle versioni precedenti

-

Imposta l'URL su: rimanda alla tua

http://127.0.0.1:8086istanza locale di InfluxDB -

Inserisci il tuo token di autenticazione InfluxDB. Questo token sicuro autorizza la connessione al tuo database. Il token è stato generato durante la Configura l'archiviazione locale con InfluxDB procedura.

-

-

Specificate i parametri della posizione di archiviazione per definire dove e come verranno archiviati i dati:

-

Inserisci il nome della tua organizzazione InfluxDB: l'organizzazione è uno spazio di lavoro per un gruppo di utenti, a cui appartengono i bucket e le dashboard. Per ulteriori informazioni, consulta Gestire le organizzazioni in. InfluxData Documentation

-

Specificate il bucket InfluxDB (ad esempio,

WindFarmData): il bucket è equivalente a un database nei sistemi tradizionali e funge da contenitore per i dati delle serie temporali -

Imposta la misurazione InfluxDB (ad esempio,

TurbineData): la misurazione è simile a una tabella nei database relazionali, che organizza i punti dati correlati

-

Nota

Trova il nome della tua organizzazione nella barra laterale sinistra dell'istanza InfluxDB. I concetti di organizzazione, bucket e misurazione sono fondamentali per il modello di organizzazione dei dati di InfluxDB. Per ulteriori informazioni, consulta la documentazione di InfluxDB.

Implementa e verifica il flusso di conservazione

Dopo aver configurato tutti i componenti del flusso di conservazione dei dati, è necessario implementare e verificare che il sistema funzioni correttamente. Questa verifica garantisce che i dati industriali vengano archiviati correttamente a livello locale per l'accesso e l'analisi immediati.

-

Connect i tre nodi come illustrato nel diagramma del flusso di conservazione dei dati. Questo crea una pipeline completa dalla sottoscrizione dei dati all'archiviazione locale.

-

Scegli Deploy per applicare le modifiche e attivare il flusso. Questo avvia il processo di raccolta e archiviazione dei dati.

-

Usa InfluxDB Data Explorer per interrogare e visualizzare i tuoi dati. Questo strumento consente di verificare che i dati vengano archiviati correttamente e di creare visualizzazioni iniziali dei dati delle serie temporali.

In Data Explorer, dovreste essere in grado di vedere le misurazioni della velocità del vento registrate nel tempo, a conferma del corretto funzionamento dell'intera pipeline, dalla generazione dei dati all'archiviazione locale.

Per ulteriori informazioni, vedere Query in Data Explorer

in. InfluxData Documentation

Con l'implementazione sia del flusso di pubblicazione dei dati che del flusso di conservazione dei dati, ora disponi di un sistema completo che invia i dati al AWS IoT SiteWise cloud mantenendo una copia locale per un accesso e una resilienza immediati. Questo approccio a doppio percorso ti garantisce di ottenere i vantaggi dell'analisi e dello storage basati sul cloud mantenendo al contempo la visibilità operativa all'edge.