Avviso di fine del supporto: il 15 dicembre 2025, AWS terminerà il supporto per AWS IoT Analytics. Dopo il 15 dicembre 2025, non potrai più accedere alla AWS IoT Analytics console o AWS IoT Analytics alle risorse. Per ulteriori informazioni, consulta AWS IoT Analytics Fine del supporto.

Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Fase 1: Reindirizzare l'inserimento continuo dei dati

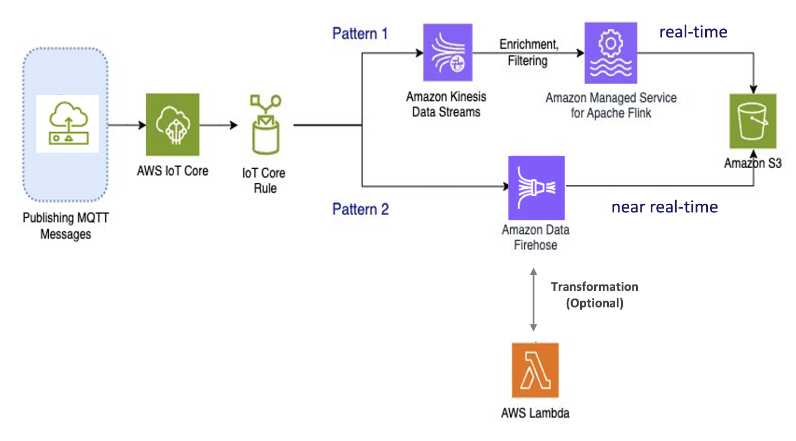

Il primo passo della migrazione consiste nel reindirizzare l'inserimento continuo dei dati verso un nuovo servizio. Consigliamo due modelli in base al caso d'uso specifico:

Modello 1: Amazon Kinesis Data Streams con Amazon Managed Service per Apache Flink

In questo modello, inizi con la pubblicazione di dati AWS IoT Core che si integrano con Amazon Kinesis Data Streams, consentendoti di raccogliere, elaborare e analizzare un'ampia larghezza di banda di dati in tempo reale.

Metriche e analisi

-

Ingestisci dati: AWS IoT i dati vengono inseriti in un Amazon Kinesis Data Streams in tempo reale. Amazon Kinesis Data Streams è in grado di gestire un elevato throughput di dati da AWS IoT milioni di dispositivi, abilitando analisi in tempo reale e rilevamento delle anomalie.

-

Elabora dati: utilizza Amazon Managed Service for Apache Flink per elaborare, arricchire e filtrare i dati da Amazon Kinesis Data Streams. Flink offre funzionalità affidabili per l'elaborazione di eventi complessi, come aggregazioni, join e operazioni temporali.

-

Dati di archiviazione: Flink invia i dati elaborati ad Amazon S3 per l'archiviazione e ulteriori analisi. Questi dati possono quindi essere interrogati utilizzando Amazon Athena o integrati con AWS altri servizi di analisi.

Usa questo schema se la tua applicazione prevede lo streaming di dati a elevata larghezza di banda e richiede un'elaborazione avanzata, come il pattern matching o il windowing, questo pattern è la soluzione migliore.

Modello 2: Usa Amazon Data Firehose

In questo modello, i dati vengono pubblicati su AWS IoT Core, che si integra con Amazon Data Firehose, consentendoti di archiviare i dati direttamente in Amazon S3. Questo modello supporta anche trasformazioni di base utilizzando. AWS Lambda

Metriche e analisi

-

Ingest Data: i AWS IoT dati vengono inseriti direttamente dai tuoi dispositivi o in AWS IoT Core Amazon Data Firehose.

-

Dati di processo: Amazon Data Firehose esegue trasformazioni ed elaborazioni di base sui dati, come la conversione e l'arricchimento del formato. È possibile abilitare la trasformazione dei dati di Firehose configurandoli per richiamare AWS Lambda funzioni per trasformare i dati di origine in entrata prima di consegnarli alle destinazioni.

-

Dati di archiviazione: i dati elaborati vengono consegnati ad Amazon S3 quasi in tempo reale. Amazon Data Firehose si ridimensiona automaticamente in base al throughput dei dati in entrata, garantendo una distribuzione dei dati affidabile ed efficiente.

Usa questo modello per carichi di lavoro che richiedono trasformazioni ed elaborazioni di base. Inoltre, Amazon Data Firehose semplifica il processo offrendo funzionalità di buffering dei dati e partizionamento dinamico per i dati archiviati in Amazon S3.