Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Panoramica

Non esiste una definizione universalmente accettata di cosa sia un modello interpretabile o quali informazioni siano adeguate come interpretazione di un modello. Questa guida si concentra sulla nozione comunemente usata di importanza delle funzionalità, in cui viene utilizzato un punteggio di importanza per ciascuna funzionalità di input per interpretare il modo in cui influisce sugli output del modello. Questo metodo fornisce informazioni ma richiede anche cautela. I punteggi di importanza delle funzionalità possono essere fuorvianti e devono essere analizzati attentamente, inclusa la convalida con esperti in materia, se possibile. In particolare, ti consigliamo di non fidarti dei punteggi di importanza delle funzionalità senza verifica, poiché le interpretazioni errate possono portare a decisioni aziendali sbagliate.

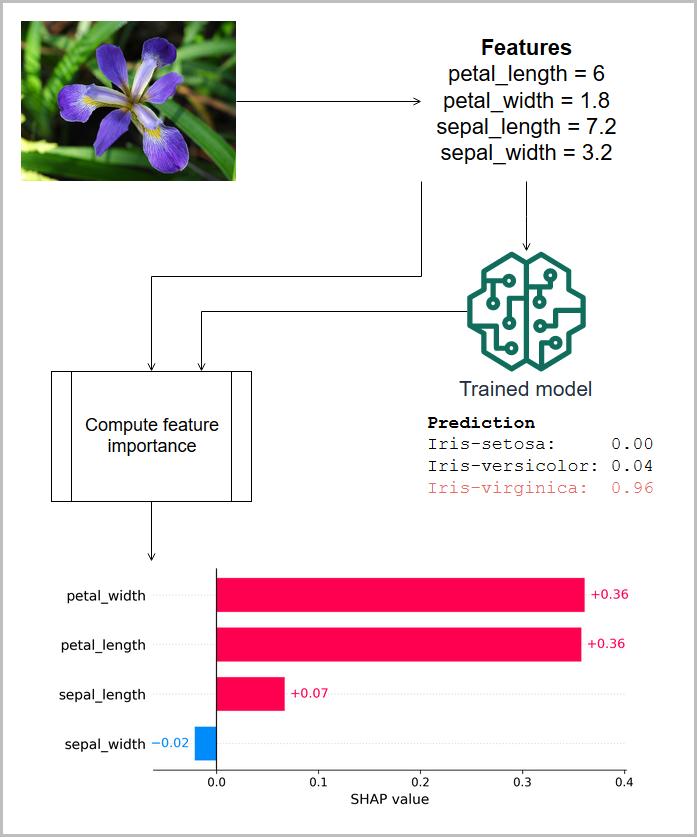

Nella figura seguente, le caratteristiche misurate di un'iride vengono passate a un modello che prevede la specie della pianta e vengono visualizzate le importanze delle caratteristiche associate (attribuzioni SHAP) per questa previsione. In questo caso, la lunghezza del petalo, la larghezza del petalo e la lunghezza del sepalo contribuiscono tutti positivamente alla classificazione di Iris virginica, ma la larghezza del sepalo ha un contributo negativo. (Queste informazioni si basano sul set di dati dell'iride di [4].)

I punteggi di importanza delle funzionalità possono essere globali, indicando che il punteggio è valido per il modello in tutti gli input o locali, indicando che il punteggio si applica a un singolo output del modello. I punteggi di importanza delle caratteristiche locali vengono spesso ridimensionati e sommati per produrre il valore di output del modello, e quindi denominati attribuzioni. I modelli semplici sono considerati più interpretabili, poiché gli effetti delle funzionalità di input sull'output del modello sono più facilmente comprensibili. Ad esempio, in un modello di regressione lineare, le grandezze dei coefficienti forniscono un punteggio globale di importanza delle caratteristiche e, per una determinata previsione, l'attribuzione di una caratteristica locale è il prodotto del suo coefficiente e del valore della caratteristica. In assenza di un punteggio locale diretto di importanza delle caratteristiche per una previsione, è possibile calcolare un punteggio di importanza da una serie di funzionalità di input di base per comprendere in che modo una funzionalità contribuisce rispetto alla linea di base.