Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Utilizzo del rilevamento di linguaggio tossico

Utilizzo del rilevamento di linguaggio tossico in una trascrizione in batch

Per utilizzare il rilevamento di linguaggio tossico con una trascrizione in batch, vedi quanto segue per alcuni esempi:

-

Accedi alla AWS Management Console

. -

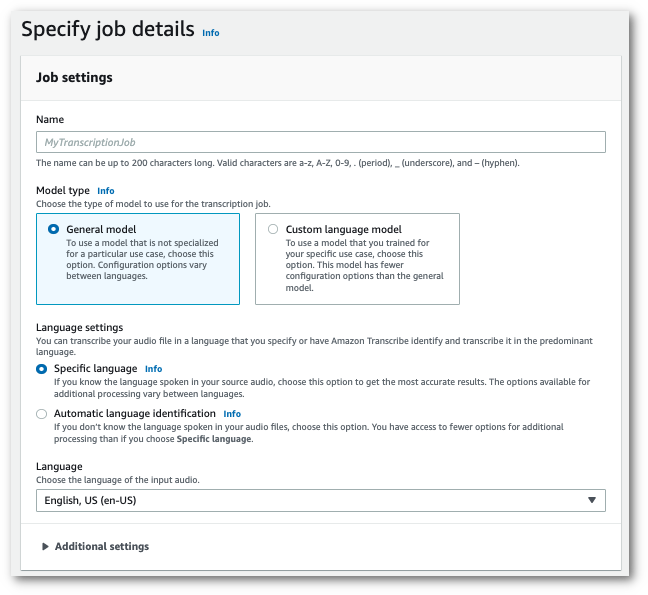

Nel riquadro di navigazione, scegli Processi di trascrizione, quindi seleziona Crea processo (in alto a destra). Si aprirà la pagina Specifica i dettagli del processo.

-

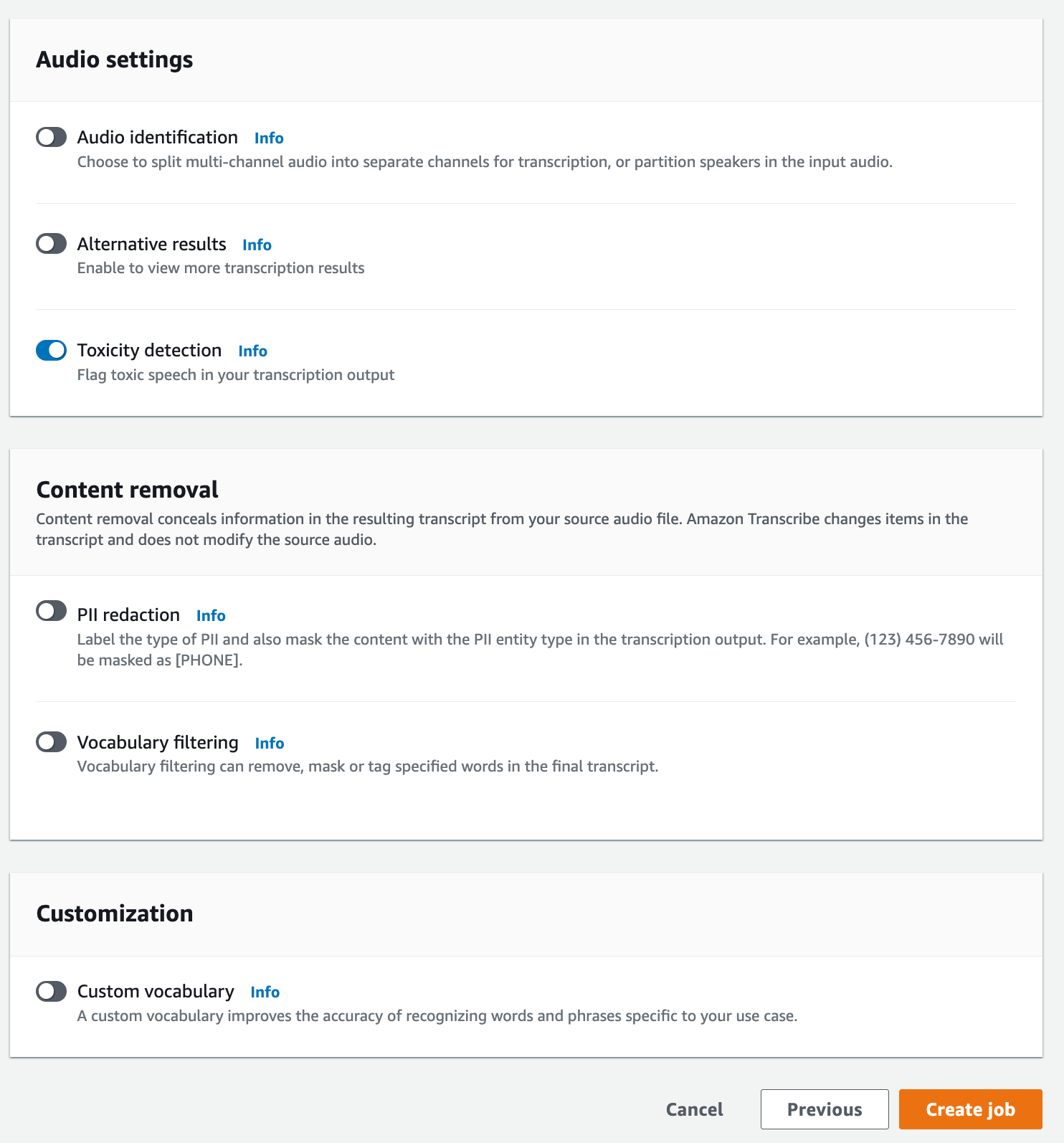

Nella pagina Specifica i dettagli del processo, puoi anche abilitare la redazione delle PII, se lo desideri. Tieni presente che le altre opzioni elencate non sono supportate dal rilevamento della tossicità. Seleziona Avanti. Verrà visualizzata la pagina Configura processo - opzionale. Nel pannello Impostazioni audio, seleziona Rilevamento della tossicità.

-

Seleziona Crea processo per eseguire il processo di trascrizione.

-

Una volta completato il processo di trascrizione, puoi scaricare la trascrizione dal menu a discesa Scarica nella pagina dei dettagli del processo di trascrizione.

Questo esempio utilizza il start-transcription-jobToxicityDetection Per ulteriori informazioni, consulta StartTranscriptionJob e ToxicityDetection.

aws transcribe start-transcription-job \ --regionus-west-2\ --transcription-job-namemy-first-transcription-job\ --media MediaFileUri=s3://amzn-s3-demo-bucket/my-input-files/my-media-file.flac\ --output-bucket-nameamzn-s3-demo-bucket\ --output-keymy-output-files/\ --language-code en-US \ --toxicity-detection ToxicityCategories=ALL

Ecco un altro esempio di utilizzo del start-transcription-job

aws transcribe start-transcription-job \ --regionus-west-2\ --cli-input-jsonfile://filepath/my-first-toxicity-job.json

Il file my-first-toxicity-job.json contiene il seguente corpo della richiesta.

{ "TranscriptionJobName": "my-first-transcription-job", "Media": { "MediaFileUri": "s3://amzn-s3-demo-bucket/my-input-files/my-media-file.flac" }, "OutputBucketName": "amzn-s3-demo-bucket", "OutputKey": "my-output-files/", "LanguageCode": "en-US", "ToxicityDetection": [ { "ToxicityCategories": [ "ALL" ] } ] }

Questo esempio utilizza AWS SDK per Python (Boto3) to enable ToxicityDetection per il metodo start_transcription_jobStartTranscriptionJob e ToxicityDetection.

Per ulteriori esempi di utilizzo dello scenario e degli esempi tra servizi AWS SDKs, inclusi quelli relativi a specifiche funzionalità, consultate il capitolo. Esempi di codice per l'utilizzo di Amazon Transcribe AWS SDKs

from __future__ import print_function import time import boto3 transcribe = boto3.client('transcribe', 'us-west-2') job_name = "my-first-transcription-job" job_uri = "s3://amzn-s3-demo-bucket/my-input-files/my-media-file.flac" transcribe.start_transcription_job( TranscriptionJobName = job_name, Media = { 'MediaFileUri': job_uri }, OutputBucketName = 'amzn-s3-demo-bucket', OutputKey = 'my-output-files/', LanguageCode = 'en-US', ToxicityDetection = [ { 'ToxicityCategories': ['ALL'] } ] ) while True: status = transcribe.get_transcription_job(TranscriptionJobName = job_name) if status['TranscriptionJob']['TranscriptionJobStatus'] in ['COMPLETED', 'FAILED']: break print("Not ready yet...") time.sleep(5) print(status)

Output di esempio

Il linguaggio tossico è etichettato e classificato nell'output della trascrizione. Ogni istanza di linguaggio tossico viene classificata e assegnato un punteggio di affidabilità (un valore compreso tra 0 e 1). Un valore di affidabilità più elevato indica una maggiore probabilità che il contenuto contenga linguaggio tossico all'interno della categoria specificata.

Di seguito è riportato un esempio di output in formato JSON che mostra linguaggio tossico classificato con punteggi di affidabilità associati.

{ "jobName": "my-toxicity-job", "accountId": "111122223333", "results": { "transcripts": [...], "items":[...], "toxicity_detection": [ { "text": "What the * are you doing man? That's why I didn't want to play with your * . man it was a no, no I'm not calming down * man. I well I spent I spent too much * money on this game.", "toxicity": 0.7638, "categories": { "profanity": 0.9913, "hate_speech": 0.0382, "sexual": 0.0016, "insult": 0.6572, "violence_or_threat": 0.0024, "graphic": 0.0013, "harassment_or_abuse": 0.0249 }, "start_time": 8.92, "end_time": 21.45 }, Items removed for brevity { "text": "What? Who? What the * did you just say to me? What's your address? What is your * address? I will pull up right now on your * * man. Take your * back to , tired of this **.", "toxicity": 0.9816, "categories": { "profanity": 0.9865, "hate_speech": 0.9123, "sexual": 0.0037, "insult": 0.5447, "violence_or_threat": 0.5078, "graphic": 0.0037, "harassment_or_abuse": 0.0613 }, "start_time": 43.459, "end_time": 54.639 }, ] }, ... "status": "COMPLETED" }