翻訳は機械翻訳により提供されています。提供された翻訳内容と英語版の間で齟齬、不一致または矛盾がある場合、英語版が優先します。

チュートリアル: 開発エンドポイントで Amazon SageMaker ノートブックを使用する

AWS Glue では、開発エンドポイントを作成し、ETL および機械学習スクリプトの開発に役立つ SageMaker ノートブックを作成できます。SageMaker ノートブックは、Jupyter Notebook アプリケーションを実行しているフルマネージド型機械学習コンピューティングインスタンスです。

-

AWS Glue コンソールで [Dev endpoints (開発エンドポイント)] を選択して、開発エンドポイントのリストに移動します。

-

使用する開発エンドポイントの名前の横にあるチェックボックスをオンにし、[アクション] メニューで [Create SageMaker notebook (SageMaker ノートブックの作成)] を選択します。

-

[Create and configure a notebook (ノートブックの作成と設定)] ページに次のように入力します。

-

ノートブック名を入力します。

-

[Attach to development endpoint (開発エンドポイントにアタッチ] で、開発エンドポイントを確認します。

-

AWS Identity and Access Management (IAM) ロールを作成または選択します。

ロールを作成することをお勧めします。既存のロールを使用する場合は、必要な権限があることを確認します。(詳細については、ステップ 6: SageMaker ノートブック用に IAM ポリシーを作成する を参照してください)。

-

(オプション) VPC、サブネット、および 1 つ以上のセキュリティグループを選択します。

-

(オプション) AWS Key Management Service 暗号化キーを選択します。

-

(オプション) ノートブックインスタンスのタグを追加します。

-

-

[Create notebook (ノートブックの作成)] を選択します。[ノートブック] ページで、右上にある更新アイコンを選択し、[ステータス] に

Readyと表示されるまで続行します。 -

新しいノートブック名の横にあるチェックボックスをオンにし、[ノートブックを開く] を選択します。

-

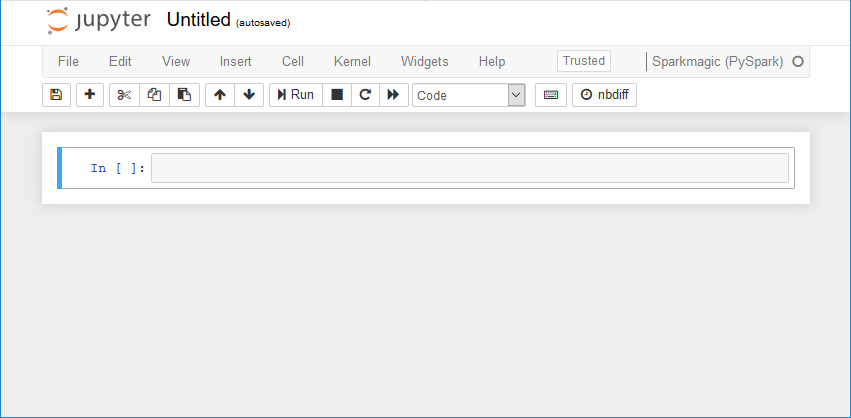

新しいノートブックを作成する: jupyter ページで [新規] を選択し、[Sparkmagic (PySpark)] を選択します。

これで、画面は以下のようになります。

-

(オプション) ページの上部にある [Untitled (無題)] を選択し、ノートブックに名前を付けます。

-

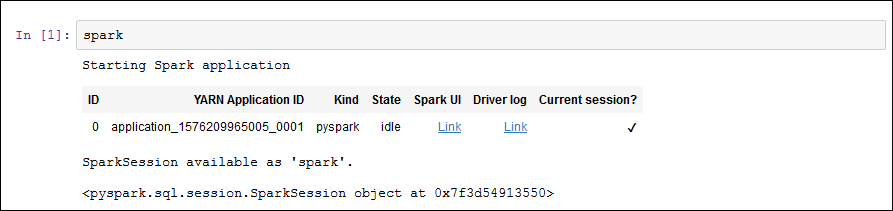

Spark アプリケーションを起動するには、次のコマンドをノートブックに入力し、ツールバーで [実行] を選択します。

sparkしばらくすると、次のようなレスポンスが表示されます。

-

動的フレームを作成し、それに対してクエリを実行します。

persons_jsonテーブルのカウントとスキーマを出力する次のコードをコピー、貼り付け、実行します。import sys from pyspark.context import SparkContext from awsglue.context import GlueContext from awsglue.transforms import * glueContext = GlueContext(SparkContext.getOrCreate()) persons_DyF = glueContext.create_dynamic_frame.from_catalog(database="legislators", table_name="persons_json") print ("Count: ", persons_DyF.count()) persons_DyF.printSchema()