기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

모범 사례

후속 기계 학습(ML) 또는 강화 학습(RL)을 활성화하려면 데이터 수집, 자산 관리, 원격 측정 스토리지 및 시각화를 비롯한 다양한 영역의 모범 사례를 따르는 것이 중요합니다.

데이터 수집은 프로젝트의 성공에 중요한 역할을 합니다. 여기에는 엣지 자산에서 생성된 데이터를 AWS 또는 원하는 클라우드에 업로드하여 클라우드 규모의 상호 작용을 허용하는 작업이 포함됩니다. 프로세스를 간소화하고 확장성을 높이려면 새 사이트의 자동 온보딩을 위한 엣지 측 구성 요소를 구현해야 합니다. 이렇게 하면 새 자산이 온라인 상태가 될 때 기존 인프라와 원활하게 통합될 수 있습니다.

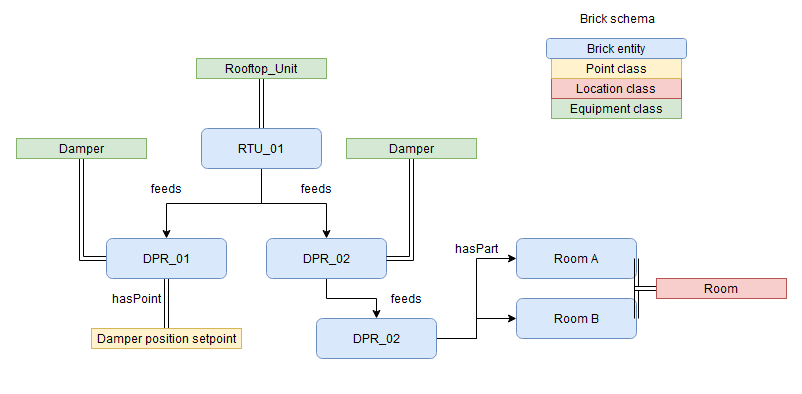

자산 관리는 신중한 고려가 필요한 또 다른 중요한 측면입니다. 자산 메타데이터를 Brick onlogy와 같은 표준화된 onlogy에 매핑하면 자산과 자산의 속성, 계층 구조 및 관계를 전체적으로 파악할 수 있습니다. 다음 다이어그램은 Brick onlogy

Amazon Neptune

원격 측정 저장소는 수집된 데이터를 실시간으로 저장하고 수명 주기 관리를 사용하여 비용을 절감하고 위험을 최소화할 책임이 있습니다. 원격 측정 스토어는 핫 스토리지 메커니즘과 콜드 스토리지 메커니즘을 모두 사용하여 효율적이고 안정적인 데이터 스토리지를 지원합니다. 와 같은 데이터 카탈로그를 구현하면 데이터 검색 가능성과 접근성이 AWS Glue

인사이트를 제공하고 정보에 입각한 의사 결정을 가능하게 하려면 시각화 구성 요소를 개발하는 것이 좋습니다. 이 대시보드는 사용자가 업로드된 자산 데이터를 시각화하고 수집된 정보를 명확하고 직관적으로 표현할 수 있도록 해줍니다. 사용자 친화적인 방식으로 데이터를 제시하면 이해관계자가 에너지 최적화 프로젝트의 현재 상태를 쉽게 파악하고 데이터 기반 결정을 내리는 데 도움이 될 수 있습니다. 이 데이터 기반을 설정한 후 RL을 사용하여 에너지 최적화를 활성화할 수 있습니다. 샘플 구현은 GitHub 리포지토리 Amazon Neptune 및 산업용 기계 학습 애플리케이션 AWS IoT SiteWise 용

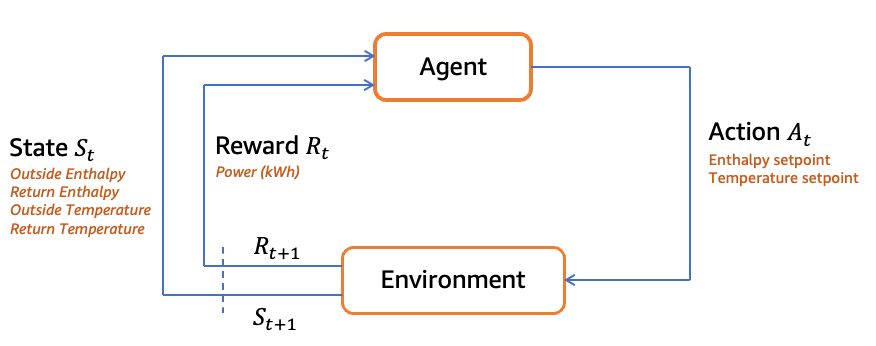

외부 조건은 RL 환경에서 중요한 역할을 합니다. 대기압, 일정한 공기 흐름, 공급 온도, 공급 상대 습도, 영역 온도, 영역 상대 습도, 외부 공기 온도, 외부 공기 상대 습도, 냉각 설정점 및 최소 외부 공기 백분율과 같은 변수를 고려해야 합니다. 이러한 조건은 상태 표현을 형성하고 RL 에이전트가 결정을 내리는 데 필요한 컨텍스트를 제공합니다.

RL 솔루션은 일정한 공기 흐름 및 일정한 공급 공기 온도 또는 상대 습도와 같은 특정 가정을 수행하여 문제를 간소화해야 합니다. 이러한 가정은 RL 에이전트의 환경을 제한하고 에이전트가 작업을 더 빠르게 학습하고 최적화할 수 있도록 합니다.

RL 에이전트의 작업은 economizer 활성화 설정점에 의해 정의됩니다. 이코노마이저 최대 활성화 온도 및 이코노마이저 최대 활성화 엔탈피와 같은 이러한 설정점은 시스템의 동작과 절전 가능성을 결정합니다. RL 에이전트는 관찰된 상태를 기반으로 적절한 설정점을 선택하여 절전 보상을 극대화하는 방법을 배웁니다.

보상 함수는 RL의 중요한 측면입니다. 이 경우 보상은 사람의 편의를 유지하면서 절전 로직을 기반으로 계산됩니다. RL 에이전트는 전력 소비를 최소화하는 것을 목표로 하며, 보상은 선택한 이코노마이저 활성화 설정점과 전력 소비를 비교함으로써 결정됩니다. RL 에이전트는 전력 절감을 장려하여 시간이 지남에 따라 작업을 최적화하는 방법을 배웁니다.

다음 다이어그램은 에너지 최적화 RL 루프의 예를 보여줍니다. 이 워크플로 및 샘플 코드에 대한 자세한 내용은의 GitHub 리포지토리 에너지 사용량 모니터링 및 최적화 지침을 참조하세요 AWS

모범 사례에 따라 RL 솔루션을 개발하려면 탐색과 악용 간의 균형을 유지해야 합니다. Epsilon-Greedy 탐색 또는 Thompson 샘플링과 같은 기법은 에이전트가 훈련 시 적절한 횟수의 반복을 사용하는 데 도움이 됩니다.

Q-learning 또는 Deep Q Network(DQN)와 같은 신중한 RL 알고리즘 선택은 하이퍼파라미터 튜닝과 함께 최적의 학습 및 수렴을 보장합니다. 경험 재생과 같은 기법을 사용하면 사용 가능한 샘플의 효율성을 높일 수 있으며 에이전트에 대한 실제 경험이 제한적일 때 유용합니다. 대상 네트워크는 에이전트가 접근 방식을 재고하기 전에 여러 예제를 시도하도록 하여 훈련의 안정성을 개선합니다. 전반적으로 이러한 관행은 보상을 극대화하고 성능을 최적화하기 위한 효과적인 RL 솔루션 개발을 촉진합니다.

요약하면, 절전 시뮬레이터를 위한 RL 솔루션을 개발하려면 외부 조건을 고려하고, 가정을 정의하고, 의미 있는 조치를 선택하고, 적절한 보상 함수를 설계해야 합니다. 모범 사례에는 적절한 탐색-탐색 장단점, 알고리즘 선택, 하이퍼파라미터 튜닝, 경험 재생 및 대상 네트워크와 같은 안정성 향상 기법 채택이 포함됩니다. 클라우드 기술은 분석 및 기계 학습을 위한 비용 효율성, 내구성 및 확장성을 제공합니다. 데이터 수집, 자산 관리, 원격 측정 스토리지, 시각화 및 기계 학습 개발의 모범 사례를 준수하면 원활한 통합, 효율적인 데이터 처리 및 귀중한 인사이트가 가능해져 성공적인 프로젝트 제공이 가능합니다.