기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

콘솔을 사용하여 컴파일된 모델 배포

모델이 AWS CLI또는 Amazon SageMaker AI 콘솔을 사용하여 AWS SDK for Python (Boto3)컴파일된 경우 사전 조건 섹션을 충족해야 합니다. 아래 단계에 따라 SageMaker AI 콘솔 - SageMaker AI를 사용하여 SageMaker AI Neo 컴파일 모델을 생성하고 배포합니다.https://console.aws.amazon.com/ SageMaker

주제

모델 배포

사전 조건을 충족한 후에는 다음 단계를 사용하여 Neo로 컴파일된 모델을 배포하세요.

-

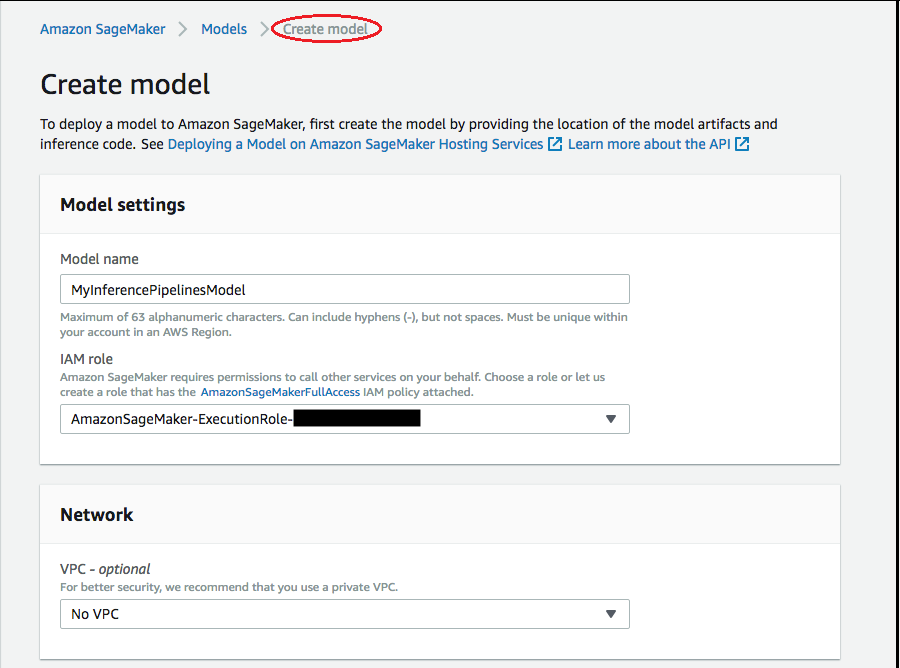

모델을 선택한 다음 추론 그룹에서 모델 생성을 선택합니다. 모델 생성 페이지에서 모델 이름, IAM 역할, 그리고 필요할 경우 VPC(선택)를 입력합니다.

-

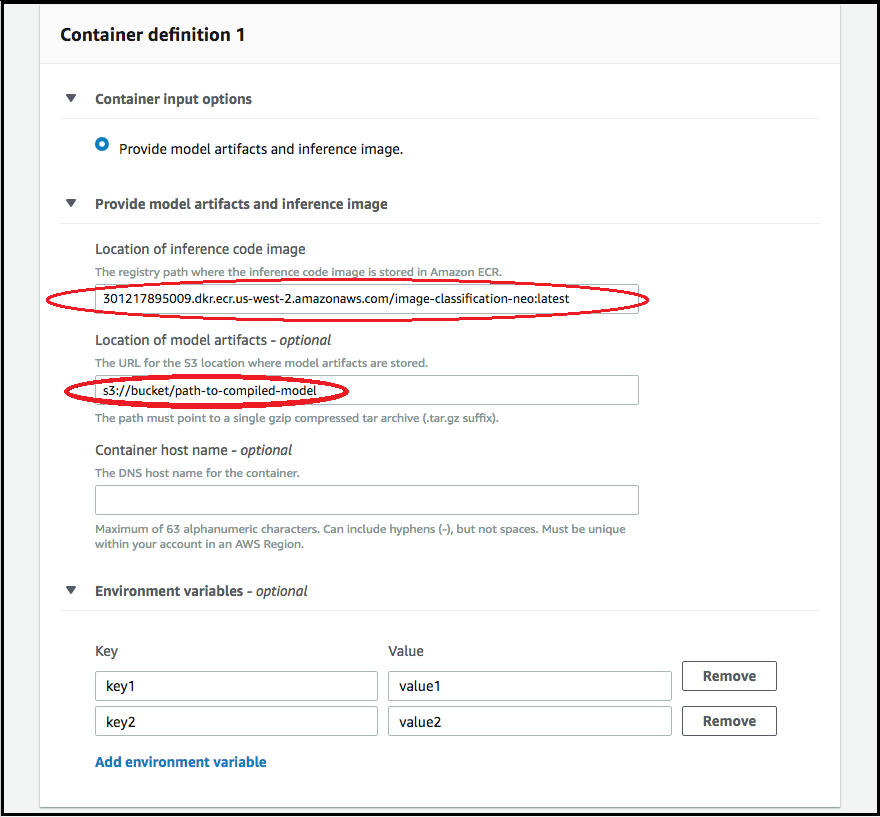

모델 배포에 사용되는 컨테이너에 대한 정보를 추가하려면 컨테이너 추가를 선택하고 다음을 선택합니다. 컨테이너 입력 옵션, 추론 코드 이미지 위치 및 모델 아티팩트의 위치에 값을 입력하고, 선택에 따라 컨테이너 호스트 이름 및 Environmental variables(환경 변수) 필드를 입력합니다.

-

Neo 컴파일 모델을 배포하려면 다음 항목을 선택합니다.

-

컨테이너 입력 옵션: 모델 아티팩트 및 추론 이미지를 션택합니다.

-

추론 코드 이미지 위치: AWS 리전 및 애플리케이션 종류에 따라 네오 추론 컨테이너 이미지에서 추론 이미지 URI를 선택합니다.

-

모델 아티팩트 위치: Neo 컴파일 API에서 생성된 컴파일된 모델 아티팩트의 Amazon S3 버킷 URI를 입력합니다.

-

환경 변수:

-

SageMaker XGBoost의 경우 이 필드를 비워 두세요.

-

SageMaker AI를 사용하여 모델을 훈련시킨 경우 환경 변수를 훈련 스크립트가 포함된 Amazon S3 버킷 URI

SAGEMAKER_SUBMIT_DIRECTORY로 지정합니다. -

SageMaker AI를 사용하여 모델을 훈련하지 않은 경우 다음 환경 변수를 지정합니다.

키 MXNet과 PyTorch에 대한 값 값 TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <해당 리전> <해당 리전> MMS_DEFAULT_RESPONSE_TIMEOUT 500 이 필드는 TF를 위해 비워둡니다.

-

-

-

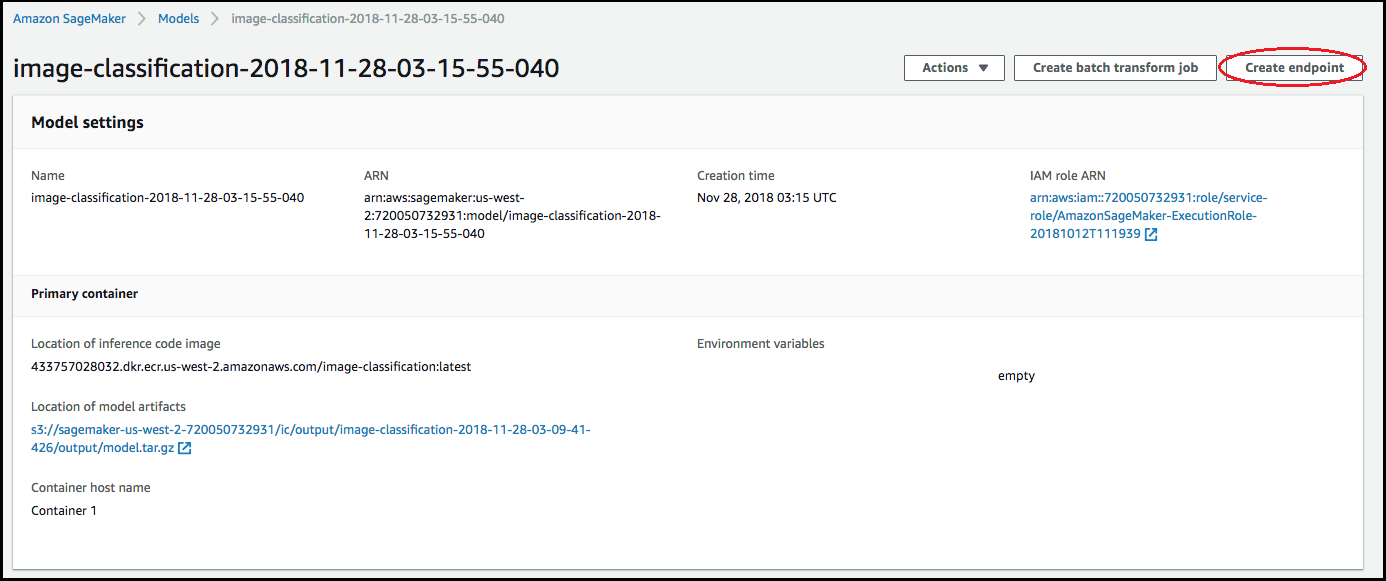

컨테이너에 대한 정보가 정확한지 확인한 다음 모델 생성을 선택합니다. 모델 생성 시작 페이지에서 엔드포인트 생성을 선택합니다.

-

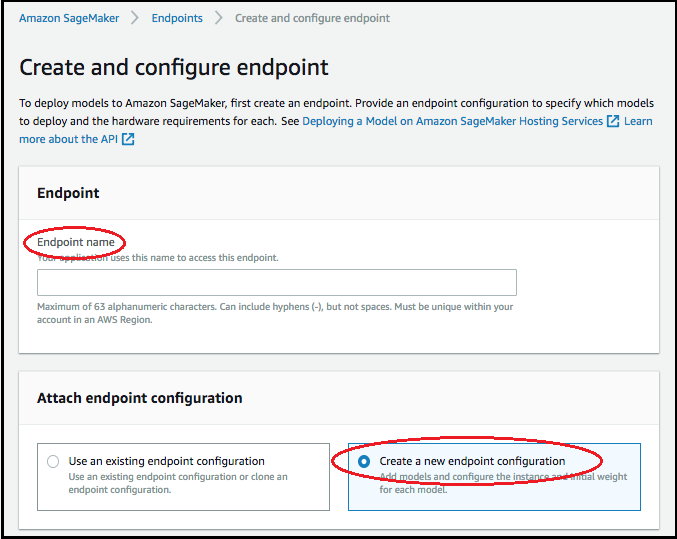

엔드포인트 생성 및 구성 다이어그램에서 엔드포인트 이름을 지정합니다. 엔드포인트 구성 연결에서 새 엔드포인트 구성 생성을 선택합니다.

-

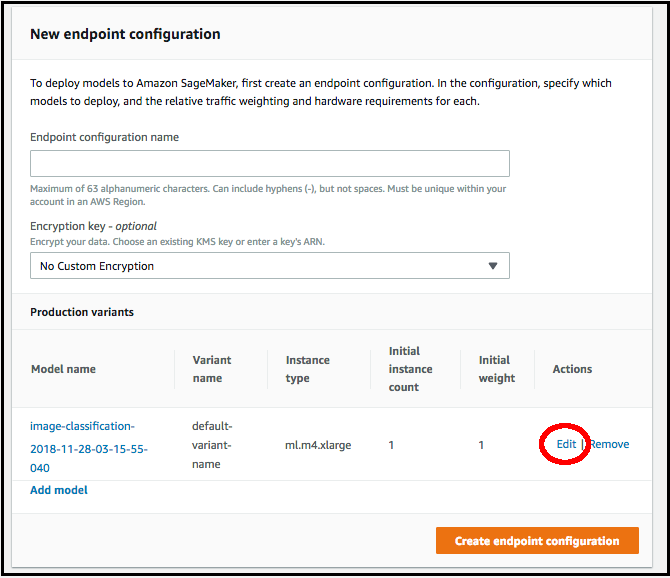

새로운 엔드포인트 구성 페이지에서 엔드포인트 구성 이름을 지정합니다.

-

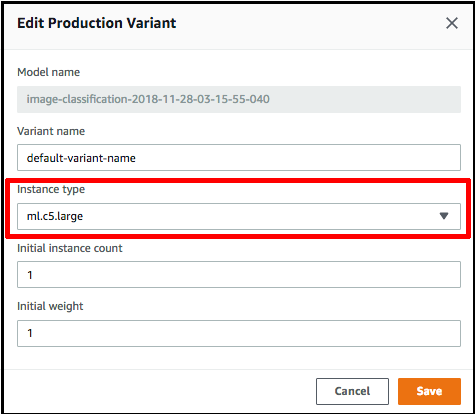

모델 이름 옆의 편집을 선택하고 프로덕션 변형 편집 페이지에서 올바른 인스턴스 유형을 지정합니다. 인스턴스 유형 값은 컴파일 작업에 지정된 유형과 일치해야 합니다.

-

저장을 선택합니다.

-

새 엔드포인트 구성 페이지에서 엔드포인트 구성 생성을 선택한 다음 엔드포인트 생성을 선택합니다.