As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Métricas de classificador personalizados

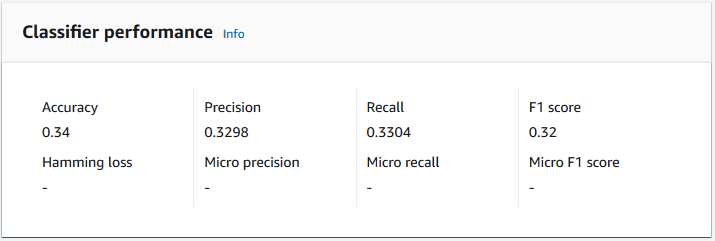

O Amazon Comprehend fornece métricas para ajudar você a estimar o desempenho de um classificador personalizado. O Amazon Comprehend calcula as métricas usando os dados de teste da tarefa de treinamento do classificador. As métricas representam com precisão o desempenho do modelo durante o treinamento, portanto, elas se aproximam do desempenho do modelo para classificação de dados semelhantes.

Use operações de API, como DescribeDocumentClassifierrecuperar as métricas de um classificador personalizado.

nota

Consulte Métricas: Precisão, recall e FScore

Métricas

O Amazon Comprehend é compatível com as seguintes métricas:

Para visualizar as métricas de um classificador, abra a página Detalhes do classificador no console.

Precisão

A precisão indica a porcentagem de rótulos dos dados de teste que o modelo previu com precisão. Para calcular a precisão, divida o número de rótulos previstos com precisão nos documentos de teste pelo número total de rótulos nos documentos de teste.

Por exemplo

| Rótulo real | Rótulo previsto | Preciso/Incorreto |

|---|---|---|

|

1 |

1 |

Preciso |

|

0 |

1 |

Incorreto |

|

2 |

3 |

Incorreto |

|

3 |

3 |

Preciso |

|

2 |

2 |

Preciso |

|

1 |

1 |

Preciso |

|

3 |

3 |

Preciso |

A precisão consiste no número de previsões precisas dividido pelo número geral de amostras de teste = 5/7 = 0,714 ou 71,4%

Precisão (precisão macro)

A precisão é uma medida da utilidade dos resultados do classificador nos dados do teste. É definido como o número de documentos classificados com precisão, dividido pelo número total de classificações da turma. Alta precisão significa que o classificador retornou resultados significativamente mais relevantes do que resultados irrelevantes.

A métrica de Precision também é conhecida como Precisão macro.

O exemplo a seguir mostra resultados de precisão para um conjunto de testes.

| Rótulo | Tamanho da amostra | Precisão do rótulo |

|---|---|---|

|

Rótulo_1 |

400 |

0.75 |

|

Rótulo_2 |

300 |

0,80 |

|

Rótulo_3 |

30000 |

0.90 |

|

Rótulo_4 |

20 |

0.50 |

|

Rótulo_5 |

10 |

0,40 |

A métrica de precisão (Precisão macro) para o modelo é, portanto:

Macro Precision = (0.75 + 0.80 + 0.90 + 0.50 + 0.40)/5 = 0.67Recall (recall macro)

Isso indica a porcentagem de categorias corretas em seu texto que o modelo pode prever. Essa métrica vem da média das pontuações de recall de todos os rótulos disponíveis. O recall é uma medida do quanto os resultados do classificador estão completos para os dados do teste.

Um alto recall significa que o classificador retornou a maioria dos resultados relevantes.

A métrica de Recall também é conhecida como Recall macro.

O exemplo a seguir mostra resultados de recall para um conjunto de testes.

| Rótulo | Tamanho da amostra | Recall de rótulo |

|---|---|---|

|

Rótulo_1 |

400 |

0,70 |

|

Rótulo_2 |

300 |

0,70 |

|

Rótulo_3 |

30000 |

0,98 |

|

Rótulo_4 |

20 |

0,80 |

|

Rótulo_5 |

10 |

0.10 |

A métrica recall (Recall macro) para o modelo é, portanto:

Macro Recall = (0.70 + 0.70 + 0.98 + 0.80 + 0.10)/5 = 0.656Pontuação F1 (macro pontuação F1)

A pontuação F1 é derivada dos valores de Precision e de Recall. Ele mede a precisão geral do classificador. A pontuação mais alta é 1 e a mais baixa é 0.

O Amazon Comprehend calcula a Macro pontuação F1. É a média não ponderada das pontuações F1 dos rótulos. Utilizar o seguinte conjunto de testes como exemplo:

| Rótulo | Tamanho da amostra | Pontuação F1 do rótulo |

|---|---|---|

|

Rótulo_1 |

400 |

0,724 |

|

Rótulo_2 |

300 |

0,824 |

|

Rótulo_3 |

30000 |

0,94 |

|

Rótulo_4 |

20 |

0,62 |

|

Rótulo_5 |

10 |

0,16 |

A Macro F1 Score (macro pontuação F1) para o modelo é calculada da seguinte forma:

Macro F1 Score = (0.724 + 0.824 + 0.94 + 0.62 + 0.16)/5 = 0.6536Perda de Hamming

A fração de rótulos previstos incorretamente. Também é visto como a fração de rótulos incorretos em comparação com o número total de rótulos. Pontuações próximas a zero são melhores.

Micro precisão

Original:

Semelhante à métrica de precisão, exceto que a micro precisão é baseada na pontuação geral de todas as pontuações de precisão somadas.

Micro recall

Semelhante à métrica de recall, exceto que o micro recall é baseado na pontuação geral de todas as pontuações de recall somadas.

Pontuação Micro F1

A Pontuação Micro F1 é uma combinação das métricas de micro precisão e micro recall.

Melhorar o desempenho do seu classificador personalizado

As métricas fornecem uma visão sobre o desempenho do seu classificador personalizado durante uma tarefa de classificação. Se as métricas forem baixas, o modelo de classificação pode não ser eficaz para seu caso de uso. Você tem várias opções para melhorar o desempenho do classificador:

-

Em seus dados de treinamento, dê exemplos concretos que definam uma separação clara das categorias. Por exemplo, forneça documentos que usem exclusivos words/sentences para representar a categoria.

-

Adicione mais dados para rótulos pouco representados em seus dados de treinamento.

-

Tente reduzir a distorção nas categorias. Se o maior rótulo em seus dados tiver mais de 10 vezes os documentos no menor rótulo, tente aumentar o número de documentos para o menor rótulo. Reduza a taxa de inclinação para no máximo 10:1 entre classes altamente representadas e menos representadas. Você também pode remover documentos de entrada das classes altamente representadas.