Tutorial: conceitos básicos do Amazon EMR

Visão geral

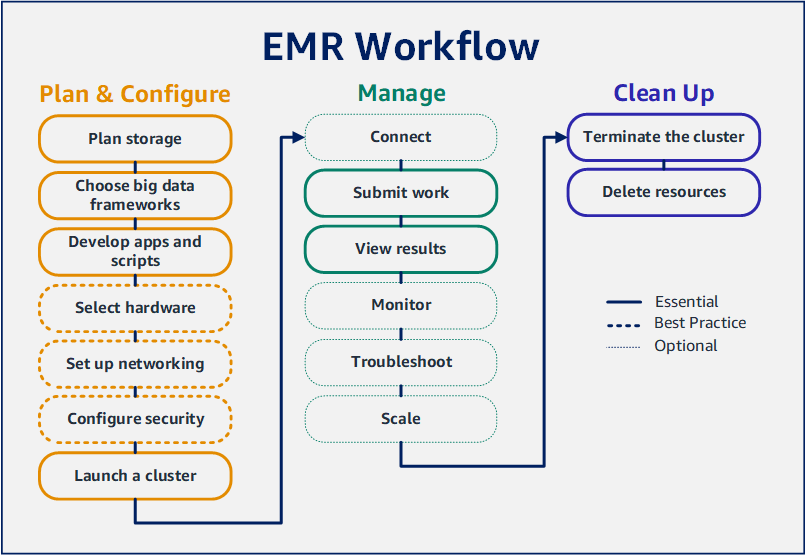

Com o Amazon EMR, é possível configurar um cluster para processar e analisar dados com estruturas de big data em apenas alguns minutos. Este tutorial mostra como iniciar um cluster de exemplo usando o Spark e como executar um script simples do PySpark armazenado em um bucket do Amazon S3. Ele abrange tarefas essenciais do Amazon EMR em três categorias principais de fluxo de trabalho: planejar e configurar, gerenciar e limpar.

Você encontrará links para tópicos mais detalhados à medida que avança no tutorial e obterá ideias para etapas adicionais na seção Próximas etapas. Se você tiver perguntas ou dúvidas, entre em contato com a equipe do Amazon EMR em nosso fórum de discussão.

Custo

-

O exemplo de cluster que você criar será executado em um ambiente dinâmico. O cluster acumula cobranças mínimas. Para evitar cobranças adicionais, certifique-se de concluir as tarefas de limpeza na última etapa deste tutorial. As cobranças são acumuladas à taxa por segundo, de acordo com os preços do Amazon EMR. As cobranças também variam com base na região. Para obter mais informações, consulte Preço do Amazon EMR.

-

Cobranças mínimas podem ser acumuladas para arquivos pequenos armazenados no Amazon S3. Algumas ou todas as cobranças do Amazon S3 poderão ser dispensadas se você estiver dentro dos limites de uso do nível gratuito da AWS. Para obter mais informações, consulte Preço do Amazon S3 e nível gratuito da AWS.

Preparação do armazenamento para o Amazon EMR

Ao usar o Amazon EMR, é possível escolher entre uma variedade de sistemas de arquivos para armazenar dados de entrada, dados de saída e arquivos de log. Neste tutorial, você usa o EMRFS para armazenar dados em um bucket do S3. O EMRFS é uma implementação do sistema de arquivos do Hadoop que permite a leitura e a gravação de arquivos regulares no Amazon S3. Para obter mais informações, consulte Trabalhar com armazenamento e sistemas de arquivos.

Para criar um bucket para este tutorial, siga as instruções em How do I create an S3 bucket? no Guia do usuário do console do Amazon Simple Storage Service. Crie o bucket na mesma região da AWS na qual você planeja iniciar o cluster do Amazon EMR. Por exemplo, Oeste dos EUA (Oregon) us-west-2.

Os buckets e as pastas usados com o Amazon EMR têm as seguintes limitações:

-

Os nomes podem consistir em letras minúsculas, números, pontos (.) e hifens (-).

-

Os nomes não podem terminar em números.

-

O nome do bucket deve ser exclusivo em todas as contas da AWS.

-

Uma pasta de saída deve estar vazia.

Preparação de uma aplicação com dados de entrada para o Amazon EMR

A maneira mais comum de preparar uma aplicação para o Amazon EMR é fazer o upload da aplicação e de seus dados de entrada para o Amazon S3. Em seguida, ao enviar o trabalho para o cluster, você especifica os locais do Amazon S3 para o script e para os dados.

Nesta etapa, você faz o upload de um script do PySpark de exemplo para o seu bucket do Amazon S3. Fornecemos um script do PySpark para você usar. O script processa os dados de inspeção de estabelecimentos alimentícios e retorna um arquivo de resultados em seu bucket do S3. O arquivo de resultados lista os dez principais estabelecimentos com mais violações do tipo “vermelho”.

Você também faz o upload de dados de entrada de exemplo no Amazon S3 para o processamento do script do PySpark. Os dados de entrada correspondem a uma versão modificada dos resultados de inspeções do Departamento de Saúde no Condado de King, em Washington, de 2006 a 2020. Para obter mais informações, consulte King County Open Data: Food Establishment Inspection Data. Confira a seguir exemplos de linhas do conjunto de dados.

name, inspection_result, inspection_closed_business, violation_type, violation_points

100 LB CLAM, Unsatisfactory, FALSE, BLUE, 5

100 PERCENT NUTRICION, Unsatisfactory, FALSE, BLUE, 5

7-ELEVEN #2361-39423A, Complete, FALSE, , 0

Preparar o script do PySpark de exemplo para o EMR

-

Copie o código de exemplo abaixo em um novo arquivo no editor de sua preferência.

import argparse

from pyspark.sql import SparkSession

def calculate_red_violations(data_source, output_uri):

"""

Processes sample food establishment inspection data and queries the data to find the top 10 establishments

with the most Red violations from 2006 to 2020.

:param data_source: The URI of your food establishment data CSV, such as 's3://DOC-EXAMPLE-BUCKET/food-establishment-data.csv'.

:param output_uri: The URI where output is written, such as 's3://DOC-EXAMPLE-BUCKET/restaurant_violation_results'.

"""

with SparkSession.builder.appName("Calculate Red Health Violations").getOrCreate() as spark:

# Load the restaurant violation CSV data

if data_source is not None:

restaurants_df = spark.read.option("header", "true").csv(data_source)

# Create an in-memory DataFrame to query

restaurants_df.createOrReplaceTempView("restaurant_violations")

# Create a DataFrame of the top 10 restaurants with the most Red violations

top_red_violation_restaurants = spark.sql("""SELECT name, count(*) AS total_red_violations

FROM restaurant_violations

WHERE violation_type = 'RED'

GROUP BY name

ORDER BY total_red_violations DESC LIMIT 10""")

# Write the results to the specified output URI

top_red_violation_restaurants.write.option("header", "true").mode("overwrite").csv(output_uri)

if __name__ == "__main__":

parser = argparse.ArgumentParser()

parser.add_argument(

'--data_source', help="The URI for you CSV restaurant data, like an S3 bucket location.")

parser.add_argument(

'--output_uri', help="The URI where output is saved, like an S3 bucket location.")

args = parser.parse_args()

calculate_red_violations(args.data_source, args.output_uri)

-

Salve o arquivo como health_violations.py.

-

Faça o upload de health_violations.py para o Amazon S3 no bucket criado para este tutorial. Para obter instruções, consulte Fazer upload de um objeto para o bucket no Guia de conceitos básicos do Amazon Simple Storage Service.

Preparar os dados de entrada de exemplo para o EMR

-

Faça o download do arquivo zip food_establishment_data.zip.

-

Descompacte e salve food_establishment_data.zip como food_establishment_data.csv em sua máquina.

-

Faça o upload do arquivo CSV para o bucket do S3 criado para este tutorial. Para obter instruções, consulte Fazer upload de um objeto para o bucket no Guia de conceitos básicos do Amazon Simple Storage Service.

Para obter mais informações sobre como configurar dados para o EMR, consulte Preparar dados de entrada.

Inicialização de um cluster do Amazon EMR

Após preparar um local de armazenamento e a aplicação, você poderá iniciar um cluster do Amazon EMR de exemplo. Nesta etapa, você inicia um cluster do Apache Spark usando a versão mais recente do Amazon EMR.

- New console

-

Iniciar um cluster com o Spark instalado usando o novo console

-

Faça login no AWS Management Console e abra o console do Amazon EMR em https://console.aws.amazon.com/emr.

-

Em EMR no EC2, no painel de navegação esquerdo, escolha Clusters e depois Criar cluster.

-

Na página Criar cluster, observe os valores padrão para Versão, Tipo de instância, Número de instâncias e Permissões. Esses campos são preenchidos automaticamente com valores que funcionam para clusters de uso geral.

-

No campo Nome do cluster, insira um nome exclusivo para o cluster para ajudar você a identificá-lo, como Meu primeiro cluster.

-

Em Aplicações, escolha a opção Spark para instalar o Spark em seu cluster.

Escolha as aplicações que você deseja em seu cluster do Amazon EMR antes de iniciar o cluster. Não é possível adicionar ou remover aplicações de um cluster após a inicialização.

-

Em Logs do cluster, marque a caixa de seleção Publicar logs específicos do cluster no Amazon S3. Substitua o valor do local do Amazon S3 pelo bucket do Amazon S3 criado, seguido por /logs. Por exemplo, s3://DOC-EXAMPLE-BUCKET/logs. A adição de /logs cria uma nova pasta chamada “logs” em seu bucket, na qual o Amazon EMR pode copiar os arquivos de log do seu cluster.

-

Em Configuração e permissões de segurança, escolha seu par de chaves do EC2. Na mesma seção, selecione o menu suspenso Perfil de serviço para o Amazon EMR e escolha EMR_DefaultRole. Em seguida, selecione o menu suspenso Perfil do IAM para o perfil de instância e escolha EMR_EC2_DefaultRole.

-

Escolha Criar cluster para iniciar o cluster e abrir a página de detalhes do cluster.

-

Veja o Status do cluster próximo ao nome do cluster. O status é alterado de Iniciando para Em execução e, em seguida, para Aguardando, conforme o Amazon EMR provisiona o cluster. Pode ser necessário escolher o ícone de atualização à direita ou atualizar seu navegador para visualizar as atualizações de status.

O status do cluster é alterado para Aguardando quando o cluster está ativo, em execução e pronto para aceitar trabalhos. Para obter mais informações sobre como ler o resumo do cluster, consulte Visualizar o status e os detalhes do cluster. Para obter informações sobre o status do cluster, consulte Noções básicas sobre o ciclo de vida do cluster.

- Old console

-

Iniciar um cluster com o Spark instalado usando o console antigo

Navegue até o novo console do Amazon EMR e selecione Alternar para o console antigo na navegação lateral. Para obter mais informações sobre o que esperar ao alternar para o console antigo, consulte Usar o console antigo.

-

Escolha Criar cluster para abrir o assistente de opções rápidas.

-

Observe os valores padrão para Versão, Tipo de instância, Número de instâncias e Permissões na página Criar cluster: opções rápidas. Esses campos são completados automaticamente com valores que funcionam para clusters de uso geral.

-

Insira um Nome do cluster para ajudar você a identificá-lo. Por exemplo, Meu primeiro cluster.

-

Deixe o Registro em log habilitado, mas substitua o valor da pasta do S3 pelo bucket do Amazon S3 criado, seguido por /logs. Por exemplo, s3://DOC-EXAMPLE-BUCKET/logs. A adição de /logs cria uma nova pasta chamada “logs” em seu bucket, na qual o EMR pode copiar os arquivos de log do seu cluster.

-

Escolha a opção Spark, em Aplicações, para instalar o Spark em seu cluster.

Escolha as aplicações que você deseja em seu cluster do Amazon EMR antes de iniciar o cluster. Não é possível adicionar ou remover aplicações de um cluster após a inicialização.

-

Escolha seu par de chaves do EC2 em Segurança e acesso.

-

Escolha Criar cluster para iniciar o cluster e abrir a página de status do cluster.

-

Veja o Status do cluster próximo ao nome do cluster. O status é alterado de Iniciando para Em execução e, em seguida, para Aguardando, conforme o Amazon EMR provisiona o cluster. Pode ser necessário escolher o ícone de atualização à direita ou atualizar seu navegador para visualizar as atualizações de status.

O status do cluster é alterado para Aguardando quando o cluster está ativo, em execução e pronto para aceitar trabalhos. Para obter mais informações sobre como ler o resumo do cluster, consulte Visualizar o status e os detalhes do cluster. Para obter informações sobre o status do cluster, consulte Noções básicas sobre o ciclo de vida do cluster.

- CLI

-

Iniciar um cluster com o Spark instalado usando a AWS CLI

-

Crie perfis do IAM padrão que podem ser usados para criar seu cluster ao usar o comando apresentado a seguir.

aws emr create-default-roles

Para obter mais informações sobre create-default-roles, consulte AWS CLI Command Reference.

-

Crie um cluster do Spark com o comando a seguir. Insira um nome para o seu cluster com a opção --name e especifique o nome do seu par de chaves do EC2 com a opção --ec2-attributes.

aws emr create-cluster \

--name "<My First EMR Cluster>" \

--release-label <emr-5.36.1> \

--applications Name=Spark \

--ec2-attributes KeyName=<myEMRKeyPairName> \

--instance-type m5.xlarge \

--instance-count 3 \

--use-default-roles

Observe os outros valores necessários para --instance-type, --instance-count e --use-default-roles. Esses valores foram escolhidos para clusters de uso geral. Para obter mais informações sobre create-cluster, consulte AWS CLI Command Reference.

Os caracteres de continuação de linha do Linux (\) são incluídos para facilitar a leitura. Eles podem ser removidos ou usados em comandos do Linux. No Windows, remova-os ou substitua-os por um sinal de interpolação (^).

O resultado deverá ser parecido com o que segue. A saída mostra o ClusterId e o ClusterArn do seu novo cluster. Anote o seu ClusterId. Você usa o ClusterId para verificar o status do cluster e enviar trabalhos.

{

"ClusterId": "myClusterId",

"ClusterArn": "myClusterArn"

}

-

Verifique o status do seu cluster com o comando a seguir.

aws emr describe-cluster --cluster-id <myClusterId>

Você deverá visualizar uma saída semelhante à apresentada a seguir com o objeto Status para o seu novo cluster.

{

"Cluster": {

"Id": "myClusterId",

"Name": "My First EMR Cluster",

"Status": {

"State": "STARTING",

"StateChangeReason": {

"Message": "Configuring cluster software"

}

}

}

}

O valor de State é alterado de STARTING para RUNNING e, em seguida, para WAITING, conforme o Amazon EMR provisiona o cluster.

O status do cluster é alterado para WAITING quando um cluster está ativo, em execução e pronto para aceitar trabalhos. Para obter informações sobre o status do cluster, consulte Noções básicas sobre o ciclo de vida do cluster.

Etapa 2: gerenciar o cluster do Amazon EMR

Envio do trabalho para o Amazon EMR

Após iniciar um cluster, você poderá enviar trabalhos ao cluster em execução para processar e analisar dados. Você envia os trabalhos para um cluster do Amazon EMR como uma etapa. Uma etapa é uma unidade de trabalho composta por uma ou mais ações. Por exemplo, você pode enviar uma etapa para calcular valores ou para transferir e processar dados. É possível enviar etapas ao criar um cluster ou para um cluster em execução. Nesta parte do tutorial, você envia health_violations.py como uma etapa para o cluster em execução. Para saber mais sobre as etapas, consulte Enviar trabalhos a um cluster.

- New console

-

Enviar uma aplicação do Spark como uma etapa com o novo console

-

Faça login no AWS Management Console e abra o console do Amazon EMR em https://console.aws.amazon.com/emr.

-

Em EMR no EC2, no painel de navegação esquerdo, escolha Clusters e, em seguida, selecione o cluster para o qual deseja enviar o trabalho. O estado do cluster deve ser Aguardando.

-

Escolha a guia Etapas e, em seguida, escolha Adicionar etapa.

-

Configure a etapa de acordo com as seguintes diretrizes:

-

Para Tipo, escolha Aplicação do Spark. Você deverá visualizar campos adicionais para Modo de implantação, Local da aplicação e Opções de spark-submit.

-

Para Nome, insira um novo nome. Se você tiver muitas etapas em um cluster, nomear cada etapa ajudará a controlá-las.

-

Para Modo de implantação, deixe o valor padrão Modo de cluster. Para obter mais informações sobre os modos de implantação do Spark, consulte Cluster mode overview na documentação do Apache Spark.

-

Para Local da aplicação, insira o local do script health_violations.py no Amazon S3, como s3://DOC-EXAMPLE-BUCKET/health_violations.py.

-

Deixe o campo Opções de spark-submit vazio. Para obter mais informações sobre as opções de spark-submit, consulte Launching applications with spark-submit.

-

No campo Argumentos, insira os seguintes argumentos e valores:

--data_source s3://DOC-EXAMPLE-BUCKET/food_establishment_data.csv

--output_uri s3://DOC-EXAMPLE-BUCKET/myOutputFolder

Substitua s3://DOC-EXAMPLE-BUCKET/food_establishment_data.csv pelo URI do bucket do S3 dos dados de entrada preparados em Preparação de uma aplicação com dados de entrada para o Amazon EMR.

Substitua DOC-EXAMPLE-BUCKET pelo nome do bucket criado para este tutorial e substitua myOutputFolder pelo nome da pasta de saída do cluster.

-

Para Ação se a etapa falhar, aceite a opção padrão Continuar. Dessa forma, se a etapa falhar, o cluster continuará em execução.

-

Escolha Adicionar para enviar a etapa. A etapa deve ser exibida no console com o status Pendente.

-

Monitore o status da etapa. Ele deve ser alterado de Pendente para Em execução e, por fim, para Concluído. Para atualizar o status no console, escolha o ícone de atualização à direita de Filtrar. O script demora cerca de um minuto para ser executado. Quando o status for alterado para Concluído, a etapa será concluída com êxito.

- Old console

-

Enviar uma aplicação do Spark como uma etapa com o console antigo

Navegue até o novo console do Amazon EMR e selecione Alternar para o console antigo na navegação lateral. Para obter mais informações sobre o que esperar ao alternar para o console antigo, consulte Usar o console antigo.

-

Selecione o nome do seu cluster na Lista de clusters. O estado do cluster deve ser Aguardando.

-

Escolha Steps (Etapas) e selecione Add step (Adicionar etapa).

-

Configure a etapa de acordo com as seguintes diretrizes:

-

Para Step type (Tipo de etapa), escolha Spark application (Aplicativo Spark). Você deverá visualizar campos adicionais para Modo de implantação, Opções de spark-submit e Local da aplicação.

-

Para Nome, deixe o valor padrão ou insira um novo nome. Se você tiver muitas etapas em um cluster, nomear cada etapa ajudará a controlá-las.

-

Para Modo de implantação, deixe o valor padrão Cluster. Para obter mais informações em relação aos modos de implantação do Spark, consulte Cluster mode overview na documentação do Apache Spark.

-

Deixe o campo Opções de spark-submit em branco. Para obter mais informações sobre as opções de spark-submit, consulte Launching applications with spark-submit.

-

Em Local da aplicação, insira o local do script health_violations.py no Amazon S3. Por exemplo, s3://DOC-EXAMPLE-BUCKET/health_violations.py.

-

No campo Argumentos, insira os seguintes argumentos e valores:

--data_source s3://DOC-EXAMPLE-BUCKET/food_establishment_data.csv

--output_uri s3://DOC-EXAMPLE-BUCKET/myOutputFolder

Substitua s3://DOC-EXAMPLE-BUCKET/food_establishment_data.csv pelo URI do S3 dos dados de entrada preparados em Preparação de uma aplicação com dados de entrada para o Amazon EMR.

Substitua DOC-EXAMPLE-BUCKET pelo nome do bucket criado para este tutorial e myOutputFolder pelo nome da pasta de saída do cluster.

-

Para Ação em caso de falha, aceite a opção padrão Continuar, para que, se a etapa falhar, o cluster continue em execução.

-

Escolha Adicionar para enviar a etapa. A etapa deve ser exibida no console com o status Pendente.

-

Verifique se o status da etapa foi alterado de Pendente para Em execução e, por fim, para Concluído. Para atualizar o status no console, escolha o ícone de atualização à direita da opção Filtrar. O script demora cerca de um minuto para ser executado.

Você saberá que a etapa foi concluída com êxito quando o status for alterado para Concluído.

- CLI

-

Enviar uma aplicação do Spark como uma etapa usando a AWS CLI

-

Certifique-se de ter o ClusterId do cluster iniciado em Inicialização de um cluster do Amazon EMR. Também é possível recuperar o ID do cluster com o comando apresentado a seguir.

aws emr list-clusters --cluster-states WAITING

-

Envie health_violations.py como uma etapa com o comando add-steps e seu ClusterId.

-

Você pode especificar um nome para sua etapa ao substituir “Minha aplicação do Spark”. Na matriz Args, substitua s3://DOC-EXAMPLE-BUCKET/health_violations.py pelo local da aplicação health_violations.py.

-

Substitua s3://DOC-EXAMPLE-BUCKET/food_establishment_data.csv pelo local do S3 do seu conjunto de dados food_establishment_data.csv.

-

Substitua s3://DOC-EXAMPLE-BUCKET/MyOutputFolder pelo caminho do S3 do bucket designado e por um nome para a pasta de saída do cluster.

-

ActionOnFailure=CONTINUE significa que o cluster continuará em execução se a etapa falhar.

aws emr add-steps \

--cluster-id <myClusterId> \

--steps Type=Spark,Name="<My Spark Application>",ActionOnFailure=CONTINUE,Args=[<s3://DOC-EXAMPLE-BUCKET/health_violations.py>,--data_source,<s3://DOC-EXAMPLE-BUCKET/food_establishment_data.csv>,--output_uri,<s3://DOC-EXAMPLE-BUCKET/MyOutputFolder>]

Para obter mais informações sobre o envio de etapas usando a CLI, consulte AWS CLI Command Reference.

Após enviar a etapa, você deverá visualizar uma saída como a apresentada a seguir, com uma lista de StepIds. Como você enviou uma etapa, verá somente um ID na lista. Copie o ID da etapa. Você usa o ID da etapa para verificar o status da etapa.

{

"StepIds": [

"s-1XXXXXXXXXXA"

]

}

-

Consulte o status da sua etapa com o comando describe-step.

aws emr describe-step --cluster-id <myClusterId> --step-id <s-1XXXXXXXXXXA>

Você deverá visualizar uma saída como a apresentada a seguir com informações sobre a etapa.

{

"Step": {

"Id": "s-1XXXXXXXXXXA",

"Name": "My Spark Application",

"Config": {

"Jar": "command-runner.jar",

"Properties": {},

"Args": [

"spark-submit",

"s3://DOC-EXAMPLE-BUCKET/health_violations.py",

"--data_source",

"s3://DOC-EXAMPLE-BUCKET/food_establishment_data.csv",

"--output_uri",

"s3://DOC-EXAMPLE-BUCKET/myOutputFolder"

]

},

"ActionOnFailure": "CONTINUE",

"Status": {

"State": "COMPLETED"

}

}

}

O State da etapa é alterado de PENDING para RUNNING e para COMPLETED, conforme a etapa é executada. A etapa demora cerca de um minuto para ser executada, então pode ser necessário verificar o status algumas vezes.

Você saberá que a etapa obteve êxito quando o State for alterado para COMPLETED.

Para obter mais informações sobre o ciclo de vida da etapa, consulte Execução de etapas para processar dados.

Visualização dos resultados

Após a execução com êxito de uma etapa, você poderá visualizar os resultados de saída na pasta de saída do Amazon S3.

Visualizar os resultados de health_violations.py

Abra o console do Amazon S3 em https://console.aws.amazon.com/s3/.

-

Escolha o nome do bucket e, em seguida, a pasta de saída que você especificou ao enviar a etapa. Por exemplo, DOC-EXAMPLE-BUCKET e, em seguida, myOutputFolder.

-

Verifique se os seguintes itens aparecem na sua pasta de saída:

-

Um objeto de tamanho pequeno chamado _SUCCESS.

-

Um arquivo CSV que começa com o prefixo part-, que contém seus resultados.

-

Escolha o objeto com seus resultados e, em seguida, escolha Fazer download para salvar os resultados em seu sistema de arquivos local.

-

Abra os resultados no editor de sua preferência. O arquivo de saída lista os dez principais estabelecimentos de alimentação com o maior número de violações vermelhas. O arquivo de saída também mostra o número total de violações vermelhas para cada estabelecimento.

Confira a seguir um exemplo de resultados para health_violations.py.

name, total_red_violations

SUBWAY, 322

T-MOBILE PARK, 315

WHOLE FOODS MARKET, 299

PCC COMMUNITY MARKETS, 251

TACO TIME, 240

MCDONALD'S, 177

THAI GINGER, 153

SAFEWAY INC #1508, 143

TAQUERIA EL RINCONSITO, 134

HIMITSU TERIYAKI, 128

Para obter mais informações sobre a saída do cluster do Amazon EMR, consulte Configurar um local de saída.

Ao usar o Amazon EMR, você pode desejar se conectar a um cluster em execução para ler arquivos de log, depurar o cluster ou usar ferramentas da CLI, como o shell do Spark. O Amazon EMR permite que você se conecte a um cluster usando o protocolo Secure Shell (SSH). Esta seção abrange como configurar o SSH, conectar-se ao cluster e visualizar arquivos de log do Spark. Para obter mais informações sobre como se conectar a um cluster, consulte Autenticação em nós de cluster do Amazon EMR.

Autorização de conexões SSH para o cluster

Antes de se conectar ao cluster, é necessário modificar os grupos de segurança do cluster para autorizar conexões SSH de entrada. Os grupos de segurança do Amazon EC2 atuam como firewalls virtuais para controlar o tráfego de entrada e de saída do cluster. Quando você criou o cluster para este tutorial, o Amazon EMR criou os seguintes grupos de segurança em seu nome:

- ElasticMapReduce-master

-

O grupo de segurança gerenciado padrão do Amazon EMR associado ao nó primário. Em um cluster do Amazon EMR, o nó primário corresponde a uma instância do Amazon EC2 que gerencia o cluster.

- ElasticMapReduce-slave

-

O grupo de segurança padrão associado aos nós centrais e de tarefa.

- New console

-

Permitir o acesso SSH a fontes confiáveis para o grupo de segurança primário com o novo console

Para editar seus grupos de segurança, você deve ter permissão para gerenciar os grupos de segurança para a VPC na qual o cluster está localizado. Para obter mais informações, consulte Alteração de permissões de um usuário e o exemplo de política que permite o gerenciamento de grupos de segurança do EC2 no Guia do usuário do IAM.

-

Faça login no AWS Management Console e abra o console do Amazon EMR em https://console.aws.amazon.com/emr.

-

Em EMR no EC2 no painel de navegação esquerdo, escolha Clusters e, em seguida, escolha o cluster que você deseja atualizar. Isso abre a página de detalhes do cluster. A guia Propriedades nesta página deve estar pré-selecionada.

-

Em Redes na guia Propriedades, selecione a seta ao lado de Grupos de segurança do EC2 (firewall) para expandir esta seção. Em Nó primário, selecione o link do grupo de segurança. Ao concluir as etapas apresentadas a seguir, como opção, você poderá voltar a esta etapa, escolher Nós centrais e de tarefa e repetir as etapas a seguir para permitir o acesso do cliente SSH aos nós centrais e de tarefas.

-

Isso abre o console do EC2. Escolha a guia Regras de entrada e, em seguida, Editar regras de entrada.

-

Verifique se há uma regra de entrada que permita acesso público com as configurações a seguir. Se existir, escolha Excluir para removê-la.

-

Type

SSH

-

Port (Porta)

22

-

Origem

Personalizado 0.0.0.0/0

Antes de dezembro de 2020, o grupo de segurança ElasticMapReduce-master tinha uma regra configurada previamente para permitir o tráfego de entrada na Porta 22 de todas as origens. Essa regra foi criada para simplificar as conexões SSH iniciais com o nó principal. Recomendamos fortemente remover esta regra de entrada e restringir o tráfego para origens confiáveis.

-

Role até o final da lista de regras e escolha Adicionar regra.

-

Em Type (Tipo), selecione SSH. Selecionar SSH insere automaticamente TCP para Protocolo e 22 para Intervalo de portas.

-

Para a origem, selecione Meu IP para adicionar automaticamente seu endereço IP como o endereço de origem. Você também pode adicionar um intervalo personalizado de endereços IP de clientes confiáveis ou criar regras adicionais para outros clientes. Diversos ambientes de rede alocam endereços IP dinamicamente, portanto, pode ser necessário atualizar os endereços IP para clientes confiáveis no futuro.

-

Escolha Save (Salvar).

-

Como opção, escolha Nós centrais e de tarefa na lista e repita as etapas acima para permitir o acesso do cliente SSH aos nós centrais e de tarefa.

- Old console

-

Conceder o acesso SSH a fontes confiáveis ao grupo de segurança primário com o console antigo

Para editar seus grupos de segurança, você deve ter permissão para gerenciar os grupos de segurança para a VPC na qual o cluster está localizado. Para obter mais informações, consulte Alteração de permissões de um usuário e o exemplo de política que permite o gerenciamento de grupos de segurança do EC2 no Guia do usuário do IAM.

Navegue até o novo console do Amazon EMR e selecione Alternar para o console antigo na navegação lateral. Para obter mais informações sobre o que esperar ao alternar para o console antigo, consulte Usar o console antigo.

Escolha Clusters. Escolha o Nome do cluster que você deseja modificar.

Escolha o link Grupos de segurança para o principal em Segurança e acesso.

Escolha ElasticMapReduce-master na lista.

Escolha a guia Regras de entrada e, em seguida, Editar regras de entrada.

Verifique se há uma regra de entrada que permita acesso público com as configurações a seguir. Se existir, escolha Excluir para removê-la.

-

Type

SSH

-

Port (Porta)

22

-

Origem

Personalizado 0.0.0.0/0

Antes de dezembro de 2020, o grupo de segurança ElasticMapReduce-master tinha uma regra configurada previamente para permitir o tráfego de entrada na Porta 22 de todas as origens. Esta regra foi criada para simplificar as conexões SSH iniciais com o nó primário. Recomendamos fortemente remover esta regra de entrada e restringir o tráfego para origens confiáveis.

Role até o final da lista de regras e escolha Adicionar regra.

-

Em Type (Tipo), selecione SSH.

Selecionar SSH insere automaticamente TCP para Protocolo e 22 para Intervalo de portas.

-

Para a origem, selecione Meu IP para adicionar automaticamente seu endereço IP como o endereço de origem. Você também pode adicionar um intervalo personalizado de endereços IP de clientes confiáveis ou criar regras adicionais para outros clientes. Diversos ambientes de rede alocam endereços IP dinamicamente, portanto, pode ser necessário atualizar os endereços IP para clientes confiáveis no futuro.

Escolha Save (Salvar).

Como opção, escolha ElasticMapReduce-slave na lista e repita as etapas acima para permitir o acesso do cliente SSH aos nós centrais e de tarefa.

Conexão com o cluster usando a AWS CLI

Independentemente do seu sistema operacional, é possível criar uma conexão SSH com o cluster usando a AWS CLI.

Conectar-se ao cluster e visualizar os arquivos de log usando a AWS CLI

-

Use o comando a seguir para abrir uma conexão SSH com o cluster. Substitua <mykeypair.key> pelo caminho completo e pelo nome do arquivo do seu par de chaves. Por exemplo, C:\Users\<username>\.ssh\mykeypair.pem.

aws emr ssh --cluster-id <j-2AL4XXXXXX5T9> --key-pair-file <~/mykeypair.key>

-

Navegue até /mnt/var/log/spark para acessar os logs do Spark no nó principal do cluster. Em seguida, visualize os arquivos nesse local. Para obter uma lista de arquivos de log adicionais no nó principal, consulte Visualizar arquivos de log no nó primário.

cd /mnt/var/log/spark

ls

Etapa 3: limpar os recursos do Amazon EMR

Encerramento do cluster

Agora que você enviou o trabalho para o cluster e visualizou os resultados da aplicação do PySpark, poderá encerrar o cluster. O encerramento de um cluster interrompe todas as cobranças do Amazon EMR e das instâncias do Amazon EC2 associadas ao cluster.

Ao encerrar um cluster, o Amazon EMR retém os metadados relacionados ao cluster por dois meses gratuitamente. Os metadados arquivados ajudam a clonar o cluster para um novo trabalho ou a revisitar a configuração do cluster para finalidades de referência. Os metadados não incluem os dados que o cluster grava no S3 ou os dados armazenados no HDFS no cluster.

O console do Amazon EMR não permite que você exclua um cluster da visualização de lista após o encerramento do cluster. Um cluster encerrado desaparecerá do console quando o Amazon EMR limpar os metadados.

- New console

-

Encerrar o cluster com o novo console

-

Faça login no AWS Management Console e abra o console do Amazon EMR em https://console.aws.amazon.com/emr.

-

Escolha Clusters e, em seguida, selecione o cluster que você deseja encerrar.

-

No menu suspenso Ações, escolha Encerrar cluster.

-

Escolha Encerrar na caixa de diálogo. Dependendo da configuração do cluster, o encerramento pode demorar de cinco a dez minutos. Para obter mais informações sobre os clusters do Amazon EMR, consulte Terminar um cluster.

- Old console

-

Encerrar o cluster com o console antigo

Navegue até o novo console do Amazon EMR e selecione Alternar para o console antigo na navegação lateral. Para obter mais informações sobre o que esperar ao alternar para o console antigo, consulte Usar o console antigo.

-

Escolha Clusters e, em seguida, selecione o cluster que você deseja encerrar. Por exemplo, Meu primeiro cluster do EMR.

-

Escolha Encerrar para abrir a solicitação Encerrar cluster.

-

Escolha Encerrar na solicitação aberta. Dependendo da configuração do cluster, o encerramento pode demorar de cinco a dez minutos. Para obter mais informações sobre como encerrar clusters do Amazon EMR, consulte Terminar um cluster.

Se você seguiu o tutorial com atenção, a proteção contra encerramento deverá estar desativada. A proteção contra encerramento de clusters evita o encerramento acidental. Se a proteção contra encerramento estiver ativada, você receberá uma solicitação para alterar a configuração antes de encerrar o cluster. Escolha Alterar e, em seguida, Desativar.

- CLI

-

Encerrar o cluster com a AWS CLI

-

Inicie o processo de encerramento do cluster com o comando a seguir. Substitua <myClusterId> pelo ID do seu cluster de exemplo. O comando não retorna uma saída.

aws emr terminate-clusters --cluster-ids <myClusterId>

-

Para verificar se o processo de encerramento do cluster está em andamento, verifique o status do cluster com o comando a seguir.

aws emr describe-cluster --cluster-id <myClusterId>

A seguir é apresentado uma saída de exemplo no formato JSON. O Status do cluster deve ser alterado de TERMINATING para TERMINATED. O encerramento pode demorar de cinco a dez minutos, dependendo da configuração do cluster. Para obter mais informações sobre como encerrar um cluster do Amazon EMR, consulte Terminar um cluster.

{

"Cluster": {

"Id": "j-xxxxxxxxxxxxx",

"Name": "My Cluster Name",

"Status": {

"State": "TERMINATED",

"StateChangeReason": {

"Code": "USER_REQUEST",

"Message": "Terminated by user request"

}

}

}

}

Exclusão de recursos do S3

Para evitar cobranças adicionais, você deve excluir o bucket do Amazon S3. Excluir o bucket remove todos os recursos do Amazon S3 deste tutorial. O bucket deve conter:

-

O script do PySpark.

-

O conjunto de dados de entrada.

-

Sua pasta de resultados de saída.

-

Sua pasta de arquivos de log.

Pode ser necessário executar etapas extras para excluir os arquivos armazenados se você salvou o script ou a saída do PySpark em um local diferente.

O cluster deve ser encerrado antes de você excluir o bucket. Caso contrário, pode não ser possível esvaziar o bucket.

Para excluir seu bucket, siga as instruções apresentadas em How do I delete an S3 bucket? no Guia do usuário do Amazon Simple Storage Service.

Próximas etapas

Você iniciou seu primeiro cluster do Amazon EMR do início ao fim. Você também concluiu tarefas essenciais do EMR, como preparar e enviar aplicações de big data, visualizar os resultados e encerrar um cluster.

Use os tópicos apresentados a seguir para saber mais sobre como personalizar seu fluxo de trabalho do Amazon EMR.

Exploração de aplicações de big data para o Amazon EMR

Descubra e compare as aplicações de big data que podem ser instaladas em um cluster no Guia de versão do Amazon EMR. O guia de lançamento detalha cada versão lançada do EMR e inclui dicas para usar estruturas como o Spark e o Hadoop no Amazon EMR.

Planejamento do hardware, das redes e da segurança do cluster

Neste tutorial, você criou um cluster do EMR simples, sem configurar as opções avançadas. As opções avançadas permitem especificar os tipos de instância do Amazon EC2, as redes do cluster e a segurança do cluster. Para obter mais informações sobre como planejar e iniciar um cluster que atenda aos seus requisitos, consulte Planejar e configurar clusters e Segurança no Amazon EMR.

Gerenciar clusters

Aprofunde-se no trabalho com clusters em execução em Gerenciar clusters. Para gerenciar um cluster, é possível se conectar ao cluster, depurar etapas e rastrear as atividades e a integridade do cluster. Você também pode ajustar os recursos do cluster em resposta às demandas da workload com o ajuste de escala gerenciado do EMR.

Uso de uma interface diferente

Além do console do Amazon EMR, você pode gerenciar o Amazon EMR usando a AWS Command Line Interface, a API do serviço Web ou um dos muitos AWS SDKs compatíveis. Para obter mais informações, consulte Interfaces de gerenciamento.

Você também pode interagir com aplicações instaladas em clusters do Amazon EMR de diversas maneiras. Algumas aplicações, como o Apache Hadoop, publicam interfaces da Web que você pode visualizar. Para obter mais informações, consulte Visualizar interfaces Web hospedadas em clusters do Amazon EMR.

Navegação pelo blog técnico do EMR

Para obter exemplos de orientações e discussões técnicas aprofundadas sobre os novos recursos do Amazon EMR, consulte o blog de big data da AWS.