Não estamos mais atualizando o serviço Amazon Machine Learning nem aceitando novos usuários para ele. Essa documentação está disponível para usuários existentes, mas não estamos mais atualizando-a. Para obter mais informações, consulte O que é o Amazon Machine Learning.

As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Informações do modelo binário

Interpretação das previsões

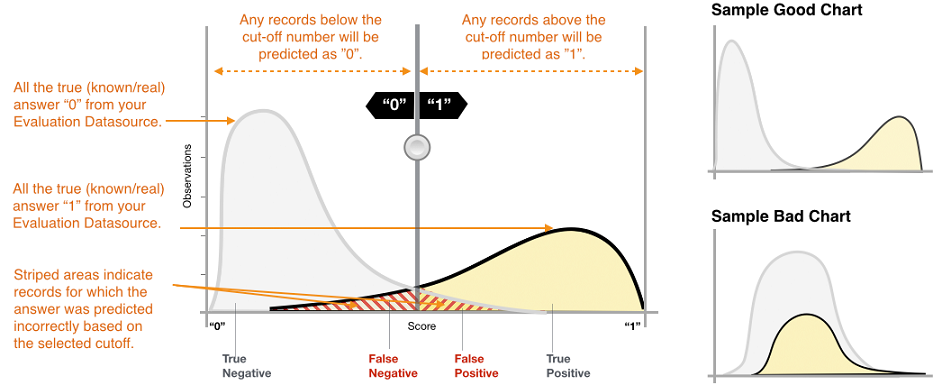

A saída real de vários algoritmos de classificação binária é uma pontuação de previsão. A pontuação indica a certeza do sistema de que a observação específica pertence à classe positiva (o valor de destino real é 1). Os modelos de classificação binária no Amazon ML geram uma pontuação que varia de 0 a 1. Como consumidor dessa pontuação, para decidir se a observação deve ser classificada como 1 ou 0, você interpreta a pontuação selecionando um limite de classificação, ou corte, e compara a pontuação com ele. Qualquer observação com pontuações superiores ao corte são previstas como destino = 1, enquanto as pontuações inferiores ao corte são previstas como destino = 0.

No Amazon ML, a pontuação de corte padrão é 0,5. Você pode optar por atualizar esse corte para atender às necessidades dos negócios. Você pode usar as visualizações no console para entender como a opção de corte afetará seu aplicativo.

Medição da precisão do modelo de ML

O Amazon ML fornece uma métrica de precisão padrão do setor para modelos de classificação binária chamados área sob a curva ROC (característica de operação do receptor) (AUC). A AUC mede a capacidade do modelo de prever uma pontuação maior de exemplos positivos em comparação com os exemplos negativos. Como ela não depende do corte da pontuação, você poderá ter uma ideia da precisão da previsão do modelo a partir da métrica AUC, sem escolher um limite.

A métrica de AUC retorna um valor decimal de 0 a 1. Os valores de AUC quase de 1 indicam um modelo de ML que é altamente preciso. Os valores próximos a 0,5 indicam um modelo de ML que não é melhor do que a adivinhação aleatória. Os valores próximos a 0 raramente aparecem e normalmente indicam um problema com os dados. Basicamente, uma AUC próxima a 0 informa que o modelo de ML reconheceu os padrões corretos, mas está utilizando-os para fazer previsões que estão fora da realidade (os zeros são previstos como uns e vice-versa). Para obter mais informações sobre a AUC, acesse a página Característica de operação do receptor

A métrica AUC de linha de base para um modelo binário é 0,5. É o valor de um modelo de ML hipotético que prevê aleatoriamente uma resposta 1 ou 0. O modelo de ML binário deve apresentar um desempenho melhor do que esse valor para começar a ser útil.

Uso da visualização de desempenho

Para explorar a precisão do modelo de ML, você pode analisar os gráficos na página Avaliação no console do Amazon ML. Essa página mostra dois histogramas: a) um histograma das pontuações dos positivos reais (o destino é 1) e b) um histograma das pontuações dos negativos reais (o destino é 0) nos dados de avaliação.

Um modelo de ML com boa precisão preditiva fará a previsão das maiores pontuações até os 1s reais e das menores pontuações até os 0s reais. Um modelo perfeito terá os dois histogramas em duas extremidades diferentes do eixo x, mostrando que todos os positivos reais receberam pontuações altas e os negativos reais receberam pontuações baixas. No entanto, os modelos de ML cometem erros, e um gráfico comum mostrará que os dois histogramas se sobrepõem em determinadas pontuações. Um modelo com desempenho extremamente baixo não conseguirá fazer a distinção entre classes positivas e negativas, e as duas classes terão basicamente histogramas sobrepostos.

Usando as visualizações, você pode identificar o número de previsões que podem ser classificadas nos dois tipos de previsões corretas e nos dois tipos de previsões incorretas.

Previsões corretas

-

Verdadeiro positivo (TP): o Amazon ML fez a previsão do valor como 1 e o valor verdadeiro é 1.

-

Verdadeiro negativo (TN): o Amazon ML fez a previsão do valor como 0 e o valor verdadeiro é 0.

Previsões incorretas

-

Falso positivo (FP): o Amazon ML fez a previsão do valor como 1, mas o valor verdadeiro é 0.

-

Falso negativo (FN): o Amazon ML fez a previsão do valor como 0, mas o valor verdadeiro é 1.

nota

O número de TP, TN, FP e FN depende do limite de pontuação selecionado, e a otimização de qualquer um desses números significa compensar nos outros. Um número alto de TPs normalmente resulta em um número alto FPs e um número baixo de TNs.

Ajuste do corte da pontuação

Os modelos de ML funcionam gerando pontuações de previsão numéricas e, em seguida, aplicando um corte para converter essas pontuações em rótulos binários 0/1. Ao alterar o corte da pontuação, você pode ajustar o comportamento do modelo quando ele comete um erro. Na página Avaliação do console do Amazon ML, você pode analisar o impacto de vários cortes de pontuação e salvar o corte de pontuação que deseja usar para seu modelo.

Ao ajustar o limite de corte de pontuação, observe o dilema entre os dois tipos de erros. Mover o corte para a esquerda captura mais verdadeiros positivos, mas o dilema é o aumento no número de erros de falsos positivos. Movê-lo para a direita captura menos erros de falsos positivos, mas o dilema é que ele perderá alguns verdadeiros positivos. Para o aplicativo de previsão, você decide qual tipo de erro é mais tolerável selecionando uma pontuação de corte apropriada.

Análise de métricas avançadas

O Amazon ML fornece as seguintes métricas adicionais para medir a precisão preditiva do modelo de ML: precisão, exatidão, recall e taxa de falsos positivos.

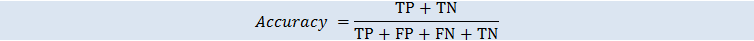

Precisão

Exatidão (ACC) mede a fração de previsões corretas. O intervalo é de 0 a 1. Um valor maior indica melhor precisão preditiva:

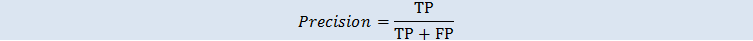

Precisão

Precisão mede a fração de positivos reais entre esses exemplos previstos como positivos. O intervalo é de 0 a 1. Um valor maior indica melhor precisão preditiva:

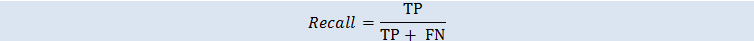

Recall

Recall mede a fração de positivos reais previstos como positivos. O intervalo é de 0 a 1. Um valor maior indica melhor precisão preditiva:

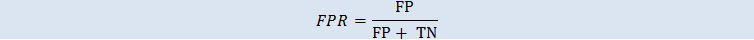

Taxa de falsos positivos

A taxa de falsos positivos (FPR - false positive rate) mede a taxa de alarmes falsos ou a fração de negativos reais previstos como positivos. O intervalo é de 0 a 1. Um valor menor indica melhor previsão preditiva:

Dependendo do seu problema de negócios, você pode se interessar mais por um modelo que funcione adequadamente em um subconjunto específico dessas métricas. Por exemplo, dois aplicativos de negócios podem ter requisitos muito diferentes para o modelo de ML:

-

Um aplicativo pode precisar ter certeza absoluta sobre as previsões de positivos (alta exatidão) e ser capaz de se permitir classificar erroneamente alguns exemplos de positivos como negativos (recall moderado).

-

Talvez seja necessário que outro aplicativo faça a previsão correta do máximo de exemplos de positivos possível (alto recall) e aceite alguns exemplos de negativos classificados erroneamente como positivos (exatidão moderada).

O Amazon ML permite que você escolha um corte de pontuação correspondente a um valor específico de qualquer uma das métricas avançadas anteriores. Ele também mostra os dilemas incorridos com a otimização de qualquer métrica. Por exemplo, se você selecionar um corte correspondente a uma alta exatidão, normalmente precisará compensar com um recall menor.

nota

Você precisa salvar o corte de pontuação para que ele entre em vigor na classificação de futuras previsões pelo modelo de ML.