As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Escalonamento de temperatura

Em problemas de classificação, presume-se que as probabilidades previstas (saída softmax) representem a verdadeira probabilidade de correção para a classe prevista. No entanto, embora essa suposição possa ter sido razoável para modelos de uma década atrás, ela não é verdadeira para os modelos de redes neurais modernos da atualidade (Guo et al. 2017). A perda de conexão entre as probabilidades de previsão do modelo e a confiança das previsões do modelo impediria a aplicação de modelos modernos de redes neurais em problemas do mundo real, como nos sistemas de tomada de decisão. Conhecer com precisão a pontuação de confiança das previsões do modelo é uma das configurações de controle de risco mais críticas necessárias para criar aplicativos de machine learning robustos e confiáveis.

Os modelos modernos de redes neurais tendem a possuir grandes arquiteturas com milhões de parâmetros de aprendizado. A distribuição das probabilidades de previsão em tais modelos geralmente é altamente distorcida para 1 ou 0, o que significa que o modelo é confiante demais e o valor absoluto dessas probabilidades pode não ter sentido. (Esse problema independe da presença de desequilíbrio de classes no conjunto de dados.) Vários métodos de calibração para criar uma pontuação de confiança de predição foram desenvolvidos nos últimos dez anos por meio de etapas de pós-processamento para recalibrar as probabilidades ingênuas do modelo. Esta seção descreve um método de calibração chamado escalonamento de temperatura, que é uma técnica simples, mas eficaz, para recalibrar probabilidades de previsão (Guo et al. 2017). O escalonamento de temperatura é uma versão de parâmetro único do Platt Logistic Scaling (Platt 1999).

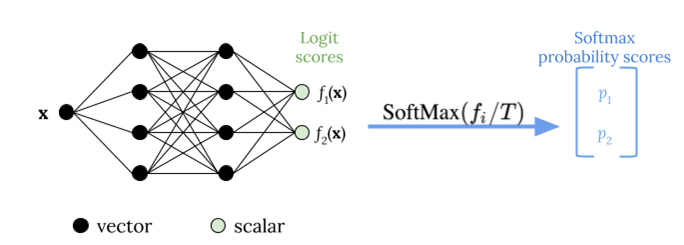

O escalonamento de temperatura usa um único parâmetro escalar T > 0, onde T é a temperatura, para redimensionar as pontuações logit antes de aplicar a função softmax, conforme mostrado na figura a seguir. Como o mesmo T é utilizado para todas as classes, a saída softmax com escalonamento possui uma relação monotônica com a saída não dimensionada. Quando T = 1, você recupera a probabilidade original com a função softmax padrão. Em modelos com excesso de confiança em que T > 1, as probabilidades recalibradas possuem um valor menor do que as probabilidades originais e são distribuídas de forma mais uniforme entre 0 e 1.

O método para obter uma temperatura ideal T para um modelo treinado é minimizar a probabilidade negativa do log para um conjunto de dados de validação retido.

Recomendamos que você integre o método de escalonamento de temperatura como parte do processo de treinamento do modelo: após a conclusão do treinamento do modelo, extraia o valor da temperatura T usando o conjunto de dados de validação e, em seguida, redimensione os valores logit usando T na função softmax. Com base em experimentos em tarefas de classificação de texto usando modelos baseados em BERT, a temperatura T geralmente varia entre 1,5 e 3.

A figura a seguir ilustra o método de escalonamento de temperatura, que aplica o valor de temperatura T antes de passar a pontuação logit para a função softmax.

As probabilidades calibradas por escalonamento de temperatura podem representar aproximadamente a pontuação de confiança das previsões do modelo. Isso pode ser avaliado quantitativamente criando um diagrama de confiabilidade (Guo et al. 2017), que representa o alinhamento entre a distribuição da precisão esperada e a distribuição das probabilidades de previsão.

O escalonamento de temperatura também foi avaliado como uma forma eficaz de quantificar a incerteza preditiva total nas probabilidades calibradas, mas não é robusta na captura da incerteza epistêmica em cenários como desvios de dados (Ovadia et al. 2019). Considerando a facilidade de implementação, recomendamos que você aplique o escalonamento de temperatura à saída do seu modelo de aprendizado profundo para criar uma solução robusta para quantificar incertezas preditivas.