As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Implante um modelo compilado usando o console

Você deve atender à seção de pré-requisitos se o modelo tiver sido compilado usando o console Amazon AWS SDK para Python (Boto3) AI ou o AWS CLI console do Amazon SageMaker AI. Siga as etapas abaixo para criar e implantar um modelo SageMaker AI Neo-compilado usando o console de SageMaker AI https://console.aws.amazon.com SageMaker /AI

Tópicos

Implante o modelo

Depois de atender aos pré-requisitos, use as etapas a seguir para implantar um modelo compilado com o Neo:

-

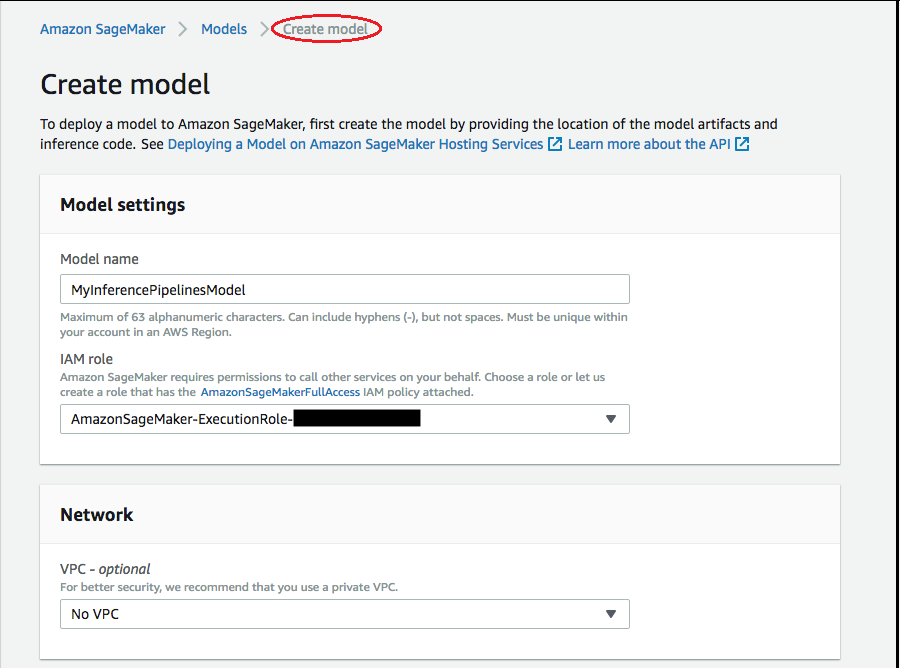

Escolha Modelos e depois Criar modelos no grupo Inferência. Na página Criar modelo, preencha os campos Nome do modelo, Função do IAM e, se necessário, VPC (opcional).

-

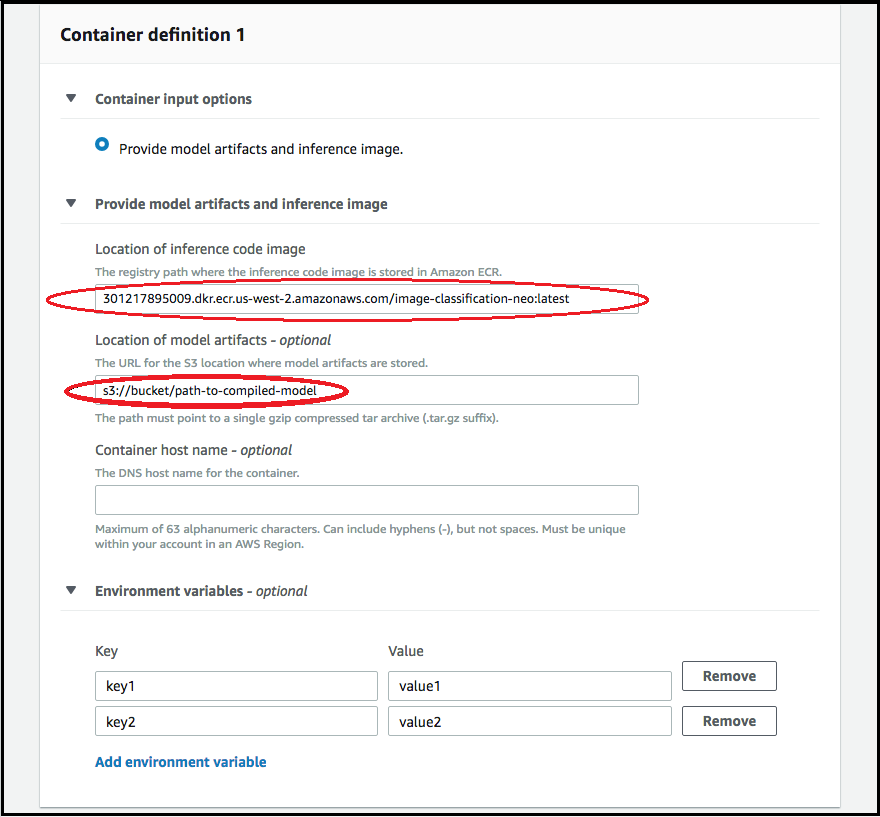

Para adicionar informações sobre o contêiner usado para implantar o modelo, selecione Adicionar contêiner e Próximo. Preencha os campos Opções de entrada de contêiner, Local de imagem do código de inferência e Local dos artefatos do modelo e, opcionalmente, Nome de host do contêiner e Variáveis de ambiente.

-

Para implantar modelos compilados pelo Neo, escolha o seguinte:

-

Opções de entrada de contêiner: escolha Fornecer artefatos do modelo e a imagem de inferência:

-

Localização da imagem do código de inferência: escolha o URI da imagem de inferência em Neo Inference Container Images, dependendo da AWS região e do tipo de aplicativo.

-

Local dos artefatos do modelo: insira o URI completo do bucket do S3 do artefato do modelo compilado gerado pela API de compilação do Neo.

-

Variáveis de ambiente:

-

Deixe esse campo em branco para SageMaker XGBoost.

-

Se você treinou seu modelo usando SageMaker IA, especifique a variável de ambiente

SAGEMAKER_SUBMIT_DIRECTORYcomo o URI do bucket do Amazon S3 que contém o script de treinamento. -

Se você não treinou seu modelo usando SageMaker IA, especifique as seguintes variáveis de ambiente:

Chave Valores para MXNet e PyTorch Valores TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <your region> <your region> MMS_DEFAULT_RESPONSE_TIMEOUT 500 Deixe esse campo em branco para TF

-

-

-

Confirme se as informações dos contêineres são precisas e, em seguida, escolha Create model (Criar modelo). Na página de destino Criar modelo, escolha Criar endpoint.

-

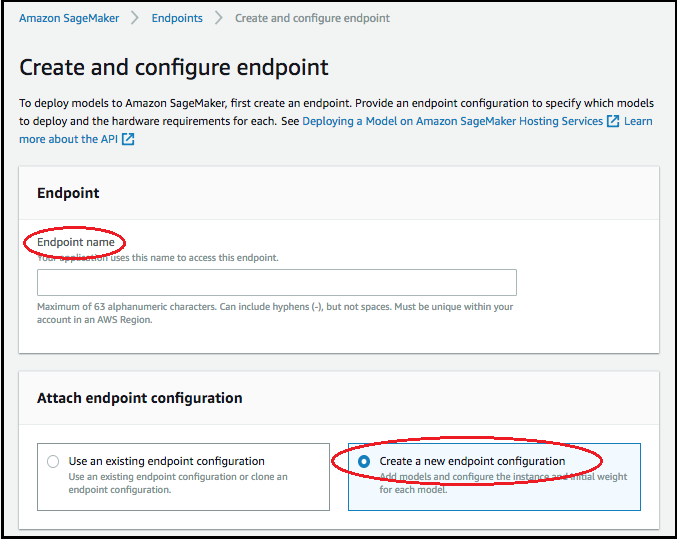

No diagrama Criar e configurar endpoint, especifique o Nome do endpoint. Para Anexar configuração do endpoint, escolha Criar uma nova configuração do endpoint.

-

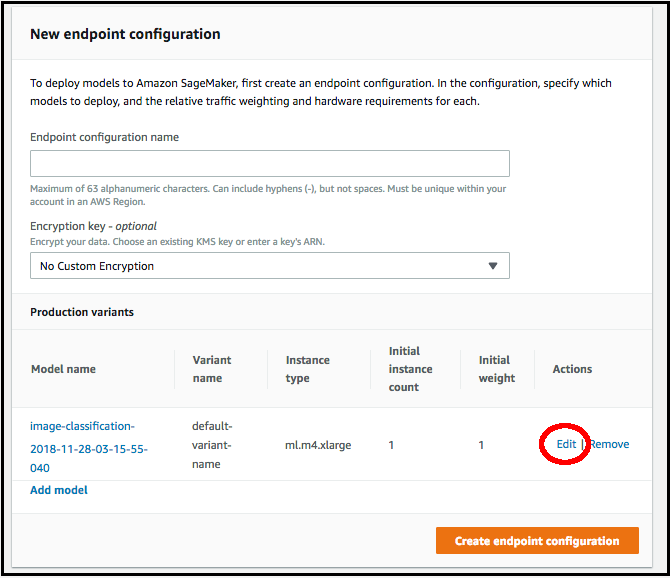

Na página Nova configuração do endpoint, especifique Nome da configuração do endpoint.

-

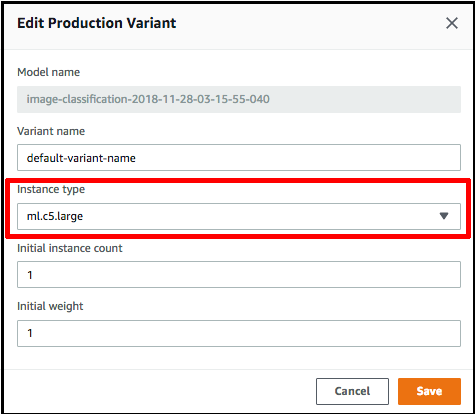

Escolha Editar ao lado do nome do modelo e especifique o Tipo de instância correto na página Editar variante de produção. É imperativo que o valor de Tipo de instância corresponda ao especificado no trabalho de compilação.

-

Escolha Save (Salvar).

-

Na página Nova configuração de endpoint, escolha Criar configuração de endpoint e, em seguida, escolha Criar endpoint.