As traduções são geradas por tradução automática. Em caso de conflito entre o conteúdo da tradução e da versão original em inglês, a versão em inglês prevalecerá.

Usar a detecção de fala tóxica

Usar a detecção de fala tóxica em uma transcrição em lote

Para usar a detecção de fala tóxica com uma transcrição em lote, veja os seguintes exemplos:

-

Faça login no AWS Management Console

. -

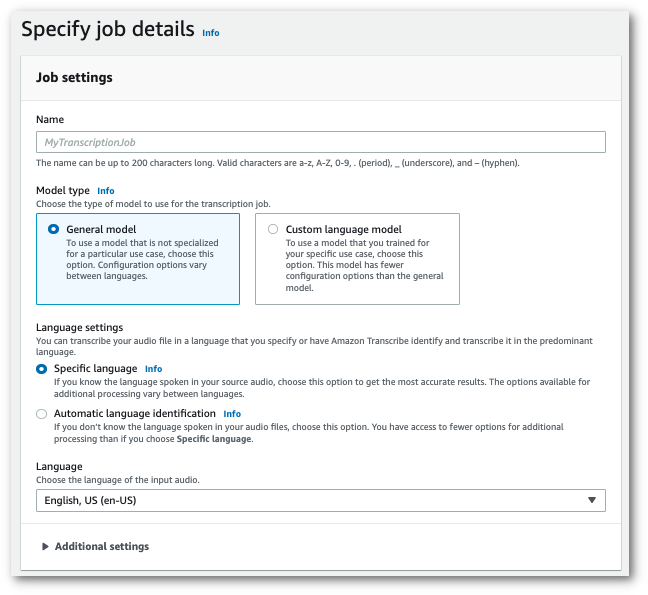

No painel de navegação, escolha Tarefas de transcrição e selecione Criar tarefa (no canto superior direito). Isso abre a página Especificar os detalhes da tarefa.

-

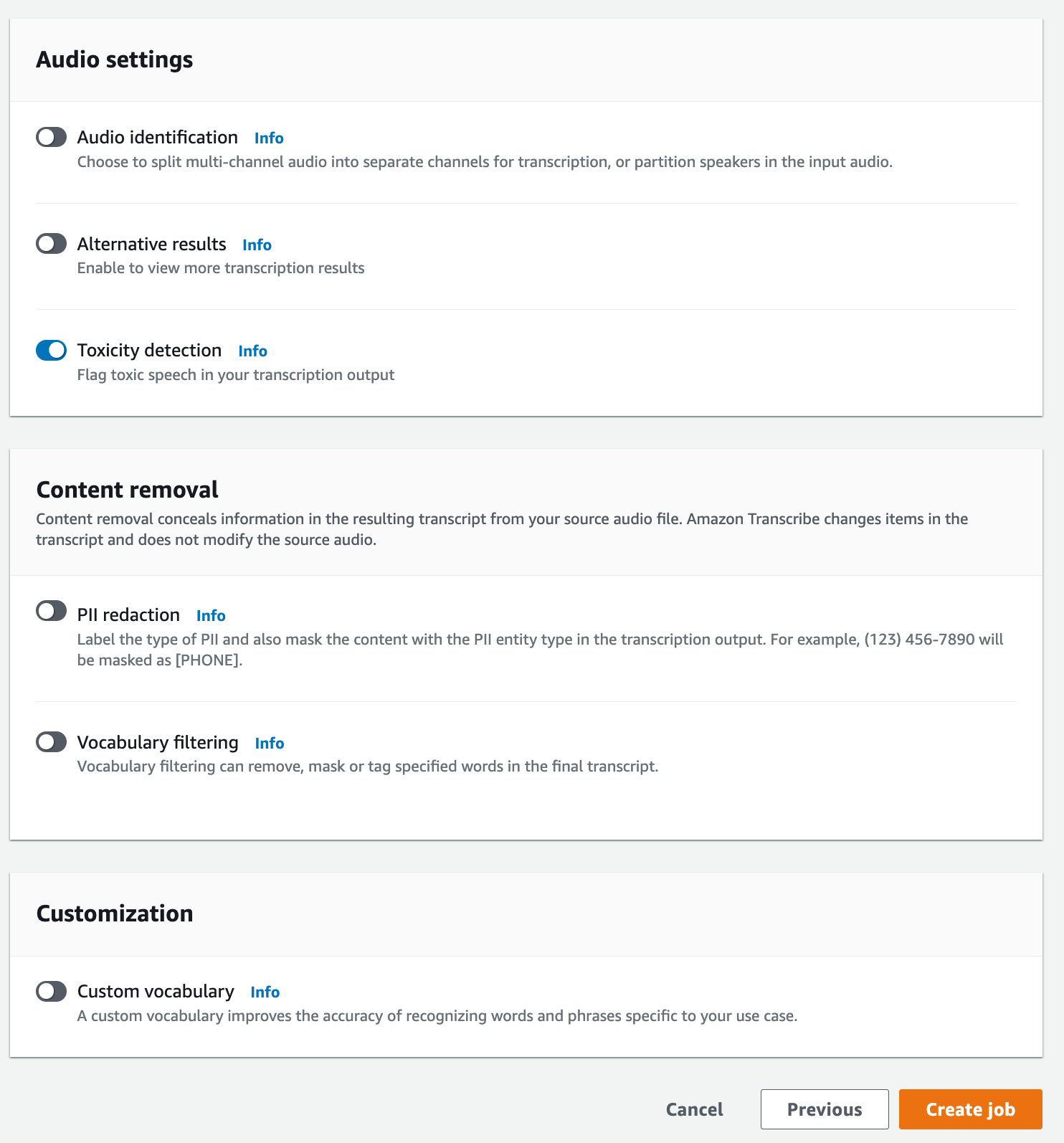

Na página Especificar os detalhes da tarefa, você também pode habilitar a edição de PII, se quiser. Observe que as outras opções listadas não são compatíveis com a detecção de toxicidade. Escolha Próximo. Isso leva você à página Configurar tarefa: opcional. No painel Configurações de áudio, selecione Detecção de toxicidade.

-

Selecione Criar tarefa para executar a tarefa de transcrição.

-

Depois que seu trabalho de transcrição estiver concluído, você poderá baixá-lo no menu suspenso Fazer download na página de detalhes da tarefa de transcrição.

Este exemplo usa o start-transcription-jobToxicityDetection parâmetro. Para ter mais informações, consulte StartTranscriptionJob e ToxicityDetection.

aws transcribe start-transcription-job \ --regionus-west-2\ --transcription-job-namemy-first-transcription-job\ --media MediaFileUri=s3://amzn-s3-demo-bucket/my-input-files/my-media-file.flac\ --output-bucket-nameamzn-s3-demo-bucket\ --output-keymy-output-files/\ --language-code en-US \ --toxicity-detection ToxicityCategories=ALL

Aqui está outro exemplo usando o start-transcription-job

aws transcribe start-transcription-job \ --regionus-west-2\ --cli-input-jsonfile://filepath/my-first-toxicity-job.json

O arquivo my-first-toxicity-job.json contém o seguinte corpo da solicitação.

{ "TranscriptionJobName": "my-first-transcription-job", "Media": { "MediaFileUri": "s3://amzn-s3-demo-bucket/my-input-files/my-media-file.flac" }, "OutputBucketName": "amzn-s3-demo-bucket", "OutputKey": "my-output-files/", "LanguageCode": "en-US", "ToxicityDetection": [ { "ToxicityCategories": [ "ALL" ] } ] }

Este exemplo usa o AWS SDK para Python (Boto3) to enable ToxicityDetection para o método start_transcription_jobStartTranscriptionJob e ToxicityDetection.

Para obter exemplos adicionais de uso do AWS SDKs, incluindo exemplos específicos de recursos, cenários e entre serviços, consulte o capítulo. Exemplos de código para o Amazon Transcribe usando AWS SDKs

from __future__ import print_function import time import boto3 transcribe = boto3.client('transcribe', 'us-west-2') job_name = "my-first-transcription-job" job_uri = "s3://amzn-s3-demo-bucket/my-input-files/my-media-file.flac" transcribe.start_transcription_job( TranscriptionJobName = job_name, Media = { 'MediaFileUri': job_uri }, OutputBucketName = 'amzn-s3-demo-bucket', OutputKey = 'my-output-files/', LanguageCode = 'en-US', ToxicityDetection = [ { 'ToxicityCategories': ['ALL'] } ] ) while True: status = transcribe.get_transcription_job(TranscriptionJobName = job_name) if status['TranscriptionJob']['TranscriptionJobStatus'] in ['COMPLETED', 'FAILED']: break print("Not ready yet...") time.sleep(5) print(status)

Exemplo de saída

A fala tóxica é marcada e categorizada na saída da transcrição. Cada caso de fala tóxica é categorizado e recebe uma pontuação de confiança (um valor entre 0 e 1). Um valor de confiança maior indica uma maior probabilidade de que o conteúdo seja uma fala tóxica dentro da categoria especificada.

Veja a seguir um exemplo de saída no formato JSON mostrando uma fala tóxica categorizada com as pontuações de confiança correspondentes.

{ "jobName": "my-toxicity-job", "accountId": "111122223333", "results": { "transcripts": [...], "items":[...], "toxicity_detection": [ { "text": "What the * are you doing man? That's why I didn't want to play with your * . man it was a no, no I'm not calming down * man. I well I spent I spent too much * money on this game.", "toxicity": 0.7638, "categories": { "profanity": 0.9913, "hate_speech": 0.0382, "sexual": 0.0016, "insult": 0.6572, "violence_or_threat": 0.0024, "graphic": 0.0013, "harassment_or_abuse": 0.0249 }, "start_time": 8.92, "end_time": 21.45 }, Items removed for brevity { "text": "What? Who? What the * did you just say to me? What's your address? What is your * address? I will pull up right now on your * * man. Take your * back to , tired of this **.", "toxicity": 0.9816, "categories": { "profanity": 0.9865, "hate_speech": 0.9123, "sexual": 0.0037, "insult": 0.5447, "violence_or_threat": 0.5078, "graphic": 0.0037, "harassment_or_abuse": 0.0613 }, "start_time": 43.459, "end_time": 54.639 }, ] }, ... "status": "COMPLETED" }