本文属于机器翻译版本。若本译文内容与英语原文存在差异,则一律以英文原文为准。

SageMaker HyperPod 食谱

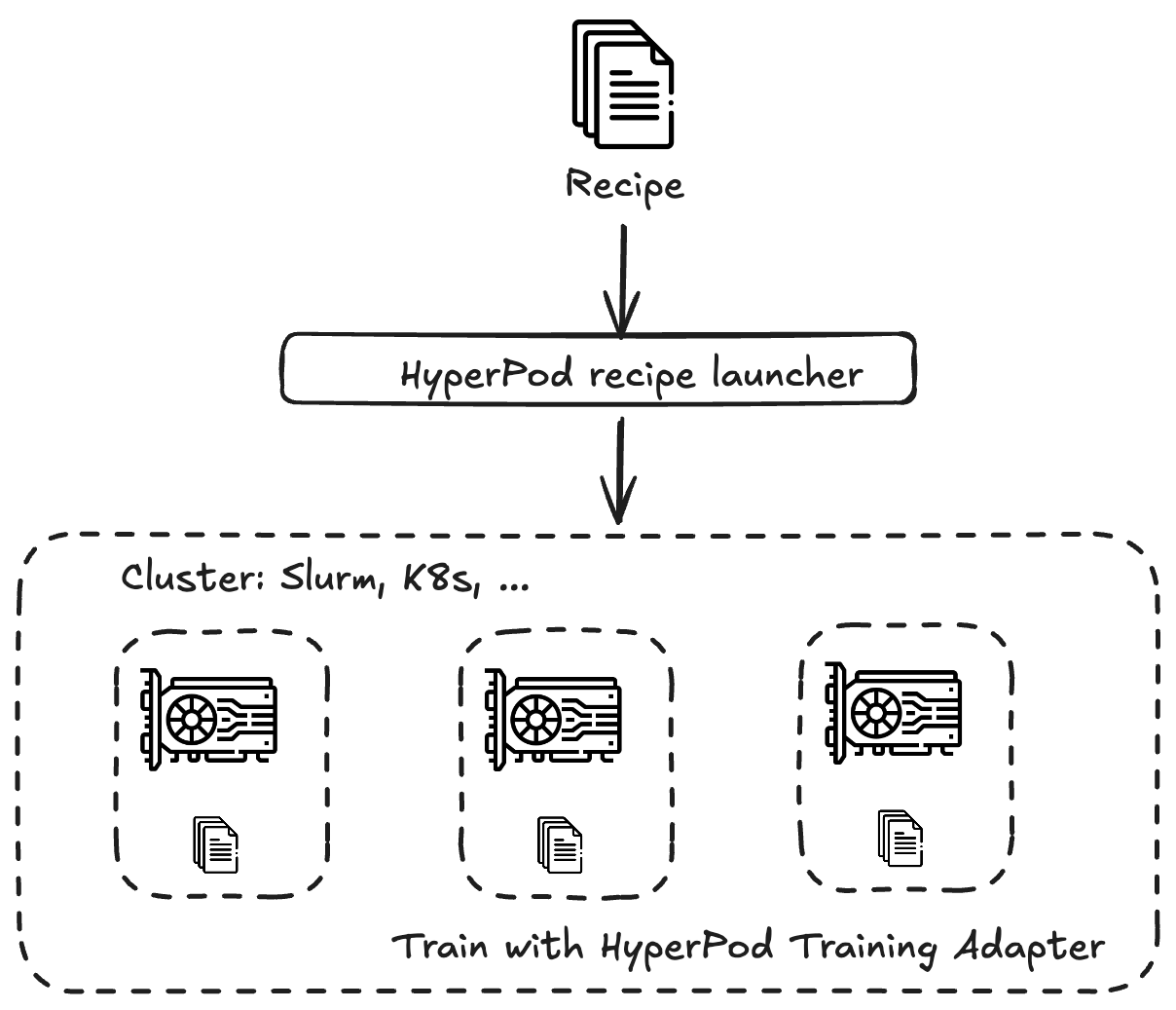

Amazon SageMaker HyperPod 配方是预先配置的训练堆栈,可帮助您快速开始训练和微调来自各种模型系列(例如 Llama、Mistral、Mixtral 或FMs)的公开基础模型 ()。 AWS DeepSeekRecipes 可以自动执行 end-to-end训练循环,包括加载数据集、应用分布式训练技术以及管理检查点以更快地从故障中恢复。

SageMaker HyperPod 对于可能不具备深厚机器学习专业知识的用户来说,配方特别有益,因为它们消除了训练大型模型所涉及的大部分复杂性。

你可以在内部运行食谱, SageMaker HyperPod 也可以作为 SageMaker 训练作业运行食谱。

下表保存在 SageMaker HyperPod GitHub 存储库中,提供了 up-to-date有关支持预训练和微调的模型、它们各自的配方和启动脚本、支持的实例类型等的最多信息。

对于 SageMaker HyperPod 用户而言, end-to-end训练工作流程的自动化来自于训练适配器与 SageMaker HyperPod 配方的集成。训练适配器基于 NVIDIA NeMo 框架

您也可以通过定义自己的自定义配方来训练自己的模型。

要开始使用教程,请参阅教程。