在仔細考慮之後,我們決定在兩個步驟中停止 Amazon Kinesis Data Analytics for SQL 應用程式:

1. 從 2025 年 10 月 15 日起,您將無法建立新的 Kinesis Data Analytics for SQL 應用程式。

2. 我們將自 2026 年 1 月 27 日起刪除您的應用程式。您將無法啟動或操作 Amazon Kinesis Data Analytics for SQL 應用程式。從那時起,Amazon Kinesis Data Analytics for SQL 將不再提供支援。如需詳細資訊,請參閱Amazon Kinesis Data Analytics for SQL 應用程式終止。

本文為英文版的機器翻譯版本,如內容有任何歧義或不一致之處,概以英文版為準。

步驟 2:建立應用程式

在本節建立 Amazon Kinesis Data Analytics 應用程式,如下所示:

-

設定應用程式輸入,以使用您在 步驟 1:準備 中建立的 Kinesis 資料串流作為串流來源。

-

使用主控台上的異常偵測範本。

建立應用程式

-

按照 Kinesis Data Analytics 入門練習中的步驟 1、2 和 3 進行操作 (請參閱 步驟 3.1:建立應用程式)。

-

在來源設定中,執行下列動作:

-

指定您在前一節建立的串流來源。

-

主控台推斷結構描述後,請編輯結構描述,並將

heartRate欄類型設定為INTEGER。大部分的心率值都是正常的,而且探索程序很可能會將

TINYINT類型指派給此資料欄。但是,一小部分的值顯示出高心率。如果這些高數值不符合TINYINT類型,Kinesis Data Analytics 會將這些資料列傳送至錯誤串流。將資料類型更新為INTEGER,以便容納所有產生的心率資料。

-

-

使用主控台上的異常偵測範本。然後,您可以更新範本程式碼,以提供適當的資料欄名稱。

-

-

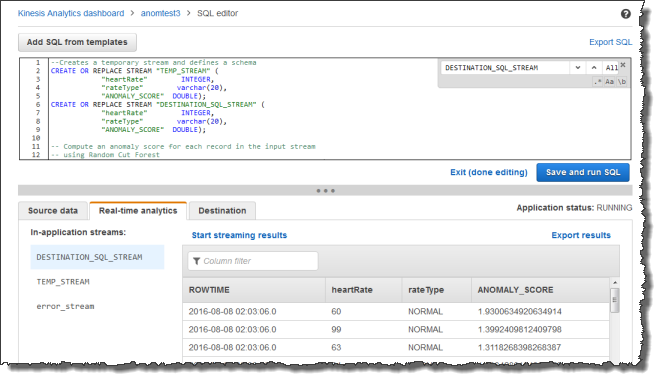

提供資料欄名稱以更新應用程式碼。生成的應用程式碼如下所示 (將此代碼貼到 SQL 編輯器中):

--Creates a temporary stream. CREATE OR REPLACE STREAM "TEMP_STREAM" ( "heartRate" INTEGER, "rateType" varchar(20), "ANOMALY_SCORE" DOUBLE); --Creates another stream for application output. CREATE OR REPLACE STREAM "DESTINATION_SQL_STREAM" ( "heartRate" INTEGER, "rateType" varchar(20), "ANOMALY_SCORE" DOUBLE); -- Compute an anomaly score for each record in the input stream -- using Random Cut Forest CREATE OR REPLACE PUMP "STREAM_PUMP" AS INSERT INTO "TEMP_STREAM" SELECT STREAM "heartRate", "rateType", ANOMALY_SCORE FROM TABLE(RANDOM_CUT_FOREST( CURSOR(SELECT STREAM * FROM "SOURCE_SQL_STREAM_001"))); -- Sort records by descending anomaly score, insert into output stream CREATE OR REPLACE PUMP "OUTPUT_PUMP" AS INSERT INTO "DESTINATION_SQL_STREAM" SELECT STREAM * FROM "TEMP_STREAM" ORDER BY FLOOR("TEMP_STREAM".ROWTIME TO SECOND), ANOMALY_SCORE DESC; -

在 Kinesis Data Analytics 主控台上執行 SQL 程式碼並檢閱結果: