本文為英文版的機器翻譯版本,如內容有任何歧義或不一致之處,概以英文版為準。

最佳實務

若要啟用後續機器學習 (ML) 或強化學習 (RL),請務必遵循各種領域的最佳實務,包括資料擷取、資產管理、遙測儲存和視覺化。

資料擷取在專案的成功中扮演重要角色。它涉及將邊緣資產產生的資料上傳到您選擇的 AWS 雲端,以允許雲端規模互動。為了簡化程序並促進可擴展性,應實作用於自動加入新網站的邊緣元件。這可確保新資產可以在上線時與現有基礎設施無縫整合。

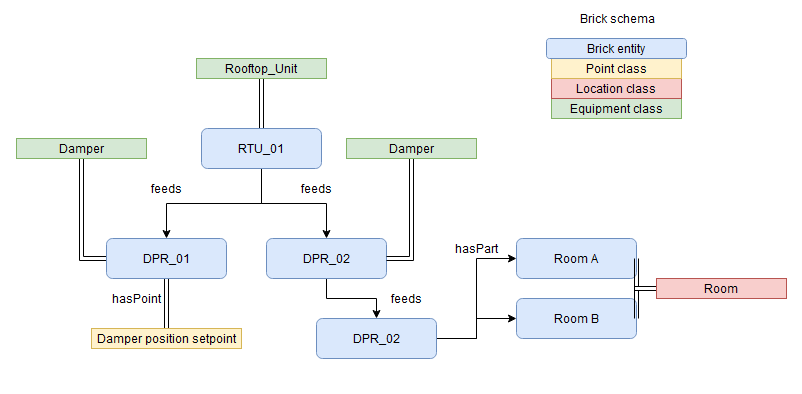

資產管理是另一個需要仔細考量的重要層面。透過將資產中繼資料映射至標準化本體,例如 Brick 本體,您可以全面檢視資產及其屬性、階層和關係。下圖顯示改編自 Brick 內科

將此中繼資料存放在圖形資料庫中,例如 Amazon Neptune

遙測存放區負責即時儲存擷取的資料,並採用生命週期管理來降低成本並降低風險。遙測存放區同時使用熱儲存和冷儲存機制,以實現高效且可靠的資料儲存。實作 等資料目錄可AWS Glue

若要提供洞見並啟用明智的決策,建議您開發視覺化元件。這是一個儀表板,可讓使用者視覺化上傳的資產資料,並提供清晰且直覺的收集資訊表示。以易於使用的方式呈現資料,可協助利益相關者輕鬆掌握能源最佳化專案的目前狀態,並做出資料驅動的決策。建立此資料基礎之後,您可以使用 RL 來啟用能源最佳化。如需實作範例,請參閱 GitHub 儲存庫 Amazon Neptune 和 AWS IoT SiteWise 工業機器學習應用程式

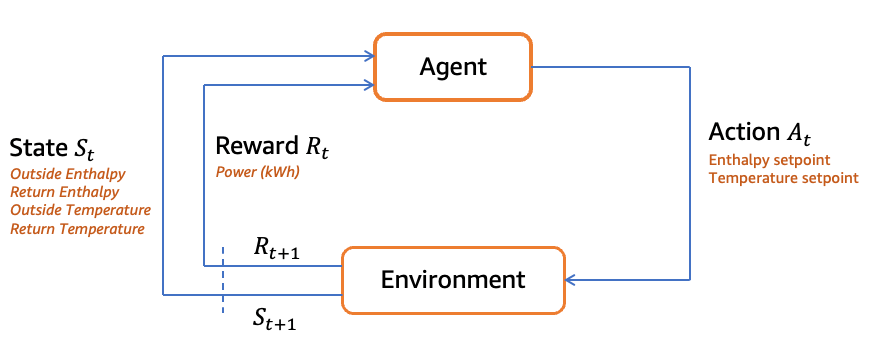

外部條件在 RL 環境中扮演關鍵角色。您應該考慮諸如大氣壓力、恆定氣流、供應溫度、供應相對濕度、區域溫度、區域相對濕度、外部空氣溫度、外部空氣相對濕度、冷卻設定點和最低外部空氣百分比等變數。這些條件會形成狀態表示式,並提供 RL 代理程式做出決策所需的內容。

RL 解決方案應該做出某些假設,例如恆定的氣流和恆定的供氣溫度或相對濕度,以簡化問題。這些假設有助於限制 RL 代理程式的環境,並讓代理程式更快速地學習和最佳化其動作。

RL 代理程式的動作是由 economizer 啟用設定點定義。這些設定點,例如節能器最大啟用溫度和節能器最大啟用熵,可判斷系統的行為及其節省電源的可能性。RL 代理程式會學習根據觀察到的狀態選取適當的設定點,以最大化節省電源的獎勵。

獎勵函數是 RL 的重要層面。在這種情況下,獎勵是根據省電邏輯計算,同時保持人類的舒適度。RL 代理程式旨在將耗電量降至最低,而獎勵的判斷方式是將耗電量與選取的節能器啟用設定點進行比較。RL 代理程式會藉由鼓勵降低功率,學習在一段時間內最佳化其動作。

下圖顯示能源最佳化 RL 迴圈的範例。如需此工作流程和範例程式碼的詳細資訊,請參閱 GitHub 儲存庫指南,以監控和最佳化 上的能源用量 AWS

透過遵循最佳實務來開發 RL 解決方案,需要在探索和入侵之間取得平衡。Epsilon-Greedy 探勘或 Thompson 取樣等技術可協助客服人員在訓練時使用適當數量的反覆運算。

謹慎的 RL 演算法選擇,例如 Q-learning 或 Deep Q Network (DQN),以及超參數調校,可確保最佳的學習和收斂。使用經驗重播等技術可以提高可用範例的效率,並且在代理程式的實際體驗有限時很有用。目標網路透過讓代理程式在重新考慮其方法之前嘗試多個範例來改善訓練的穩定性。整體而言,這些實務有助於有效的 RL 解決方案開發,以最大化獎勵和最佳化效能。

總而言之,為省電模擬器開發 RL 解決方案需要考慮外部條件、定義假設、選取有意義的動作,以及設計適當的獎勵函數。最佳實務包括適當的探索探索權衡、演算法選擇、超參數調校,以及採用穩定性增強技術,例如體驗重播和目標網路。雲端技術為分析和機器學習提供成本效益、耐用性和可擴展性。遵守資料擷取、資產管理、遙測儲存、視覺化和機器學習開發的最佳實務,可實現無縫整合、高效率資料處理和寶貴的洞見,進而成功交付專案。