Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Überprüfen Sie einen Auftrag zur Bewertung eines Modells am Menschen in Amazon Bedrock (Konsole)

Sie können die in einem Bericht enthaltenen Daten zur Bewertung durch Menschen mithilfe der Amazon Bedrock-Konsole überprüfen.

Auf Ihrem Bericht über die Modellbewertung sehen Sie die Gesamtzahl der Eingabeaufforderungen in dem Datensatz, den Sie bereitgestellt oder ausgewählt haben, und wie viele dieser Eingabeaufforderungen beantwortet wurden. Wenn die Anzahl der Antworten kleiner als die Anzahl der Eingabeaufforderungen mal die Anzahl der Mitarbeiter pro Eingabeaufforderung ist, die Sie für den Auftrag konfiguriert haben (1, 2 oder 3) überprüfen Sie unbedingt die Datenausgabedatei in Ihrem Amazon-S3-Bucket. Es ist möglich, dass die Eingabeaufforderung einen Fehler im Modell verursacht hat und keine Inferenz abgerufen wurde. Eine weitere Möglichkeit ist, dass einer oder mehrere Ihrer Mitarbeiter es abgelehnt haben, eine Antwort auf die Modellausgabe auszuwerten. Für metrische Berechnungen werden nur Antworten von Mitarbeitern verwendet.

Gehen Sie wie folgt vor, um eine Modellbewertung, für die Mitarbeiter eingesetzt werden, auf der Amazon-Bedrock-Konsole zu öffnen.

-

Öffnen Sie die Amazon-Bedrock-Konsole.

-

Wählen Sie im Navigationsbereich die Option Modellbewertung.

-

Suchen Sie als Nächstes in der Tabelle Modellbewertungen den Namen des Auftrag zur Modellbewertung, den Sie überprüfen möchten. Wählen Sie ihn anschließend aus.

Der Bericht über die Modellbewertung bietet anhand von Berichten Einblick in die Daten, die während einer menschlichen Auswertung gesammelt wurden. Jeder Bericht enthält die Metrik, die Beschreibung und die Bewertungsmethode sowie eine Datenvisualisierung, in der die für die jeweilige Metrik gesammelten Daten dargestellt werden.

In jedem der folgenden Abschnitte finden Sie ein Beispiel für die 5 möglichen Bewertungsmethoden, die Ihr Arbeitsteam in der Auswertungsoberfläche gesehen hat. Die Beispiele zeigen auch, welches Schlüssel-Wert-Paar verwendet wird, um die Ergebnisse in Amazon S3 zu speichern.

Likert-Skala, Vergleich mehrerer Modellergebnisse

Menschliche Gutachter geben auf einer 5-Punkte-Likert-Skala gemäß Ihren Anweisungen ihre Präferenz zwischen den beiden Antworten aus dem Modell an. Die Ergebnisse im Abschlussbericht werden als Histogramm der Präferenzbewertungen der Bewerter für Ihren gesamten Datensatz angezeigt.

Stellen Sie sicher, dass Sie in Ihren Anweisungen die wichtigen Punkte der 5-Punkte-Skala definieren, damit Ihre Bewerter wissen, wie sie die Antworten erwartungsgemäß bewerten können.

JSON-Ausgabe

Unter dem ersten untergeordneten Schlüssel evaluationResults wird die gewählte Bewertungsmethode zurückgegeben. In der Ausgabedatei, die in Ihrem Amazon-S3-Bucket gespeichert ist, werden die Ergebnisse der einzelnen Mitarbeiter im "evaluationResults": "comparisonLikertScale"-Schlüssel-Wert-Paar gespeichert.

Auswahlschaltflächen (Optionsfeld)

Mithilfe der Auswahlschaltflächen können Bewerter eine Antwort anstelle einer anderen auswählen. Die Gutachter geben anhand von Optionsfeldern an, welche von zwei Antworten sie gemäß Ihren Anweisungen bevorzugen. Die Ergebnisse im Abschlussbericht werden als Prozentsatz der Antworten ausgewiesen, die die Mitarbeiter für jedes Modell bevorzugt haben. Achten Sie darauf, Ihre Auswertungsmethode in der Anleitung klar zu erläutern.

JSON-Ausgabe

Unter dem ersten untergeordneten Schlüssel evaluationResults wird die gewählte Bewertungsmethode zurückgegeben. In der Ausgabedatei, die in Ihrem Amazon-S3-Bucket gespeichert ist, werden die Ergebnisse der einzelnen Mitarbeiter im "evaluationResults": "comparisonChoice"-Schlüssel-Wert-Paar gespeichert.

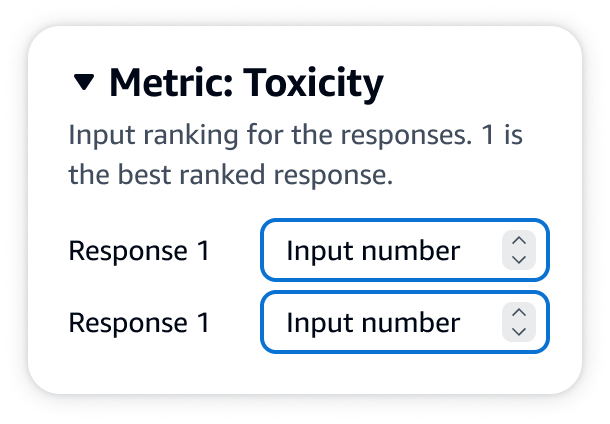

Ordinaler Rang

Mit einer ordinalen Rangfolge kann ein Bewerter seine bevorzugten Antworten auf eine Eingabeaufforderung entsprechend Ihren Anweisungen in eine Reihenfolge beginnend bei 1 bringen. Die Ergebnisse im Abschlussbericht werden als Histogramm der Bewertungen der Bewerter für den gesamten Datensatz angezeigt. Definieren Sie in Ihren Anweisungen unbedingt, was ein Rang von 1 bedeutet. Dieser Datentyp wird als Präferenzrang bezeichnet.

JSON-Ausgabe

Unter dem ersten untergeordneten Schlüssel evaluationResults wird die gewählte Bewertungsmethode zurückgegeben. In der Ausgabedatei, die in Ihrem Amazon-S3-Bucket gespeichert ist, werden die Ergebnisse der einzelnen Mitarbeiter im "evaluationResults": "comparisonRank"-Schlüssel-Wert-Paar gespeichert.

Daumen hoch/runter

up/down Mit Thumbs kann ein menschlicher Gutachter jede Antwort aus einem Modell bewerten, das Ihrem Arbeitsteam für jede Modellantwort vorgelegt acceptable/unacceptable according to your instructions. The results in the final report will be shown as a percentage of the total number of ratings by evaluators that received a thumbs up rating for each model. You may use this rating method for a model evaluation job that contains one or more models. If you use this in an evaluation that contains two models, a thumbs up/down wird. Im Abschlussbericht werden die aggregierten Ergebnisse für jedes Modell einzeln aufgeführt. Stellen Sie sicher, dass Sie in Ihren Anweisungen definieren, was akzeptabel ist (d. h. was eine Bewertung mit dem Daumen hoch ist).

JSON-Ausgabe

Unter dem ersten untergeordneten Schlüssel evaluationResults wird die gewählte Bewertungsmethode zurückgegeben. In der Ausgabedatei, die in Ihrem Amazon-S3-Bucket gespeichert ist, werden die Ergebnisse der einzelnen Mitarbeiter im "evaluationResults": "thumbsUpDown"-Schlüssel-Wert-Paar gespeichert.

Likert-Skala, Bewertung einer einzelnen Modellantwort

Anhand einer 5-Punkte-Likert-Skala kann ein Bewerter entsprechend Ihrer Anweisungen angeben, inwiefern er die Antwort des Modells befürwortet. Die Ergebnisse im Abschlussbericht werden als Histogramm der 5-Punkte-Bewertungen der Bewerter für Ihren gesamten Datensatz angezeigt. Sie können diese Methode für eine Auswertung eines oder mehrerer Modelle verwenden. Wenn Sie diese Bewertungsmethode für eine Auswertung mit mehr als einem Modell verwenden, wird Ihrem Arbeitsteam für jede Modellantwort eine 5-Punkte-Likert-Skala angezeigt, und im Abschlussbericht werden die aggregierten Ergebnisse für jedes Modell einzeln aufgeführt. Stellen Sie sicher, dass Sie in Ihren Anweisungen die wichtigen Punkte der 5-Punkte-Skala definieren, damit Ihre Bewerter wissen, wie sie die Antworten erwartungsgemäß bewerten können.

JSON-Ausgabe

Unter dem ersten untergeordneten Schlüssel evaluationResults wird die gewählte Bewertungsmethode zurückgegeben. In der Ausgabedatei, die in Ihrem Amazon-S3-Bucket gespeichert ist, werden die Ergebnisse der einzelnen Mitarbeiter im "evaluationResults": "individualLikertScale"-Schlüssel-Wert-Paar gespeichert.