Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Evaluieren Sie Ihre DeepRacer AWS-Modelle in der Simulation

Nachdem Ihr Schulungsauftrag abgeschlossen ist, sollten Sie das geschulte Modell evaluieren, um dessen Konvergenzverhalten zu bewerten. Die Evaluierung erfolgt, indem eine Reihe von Läufen auf einer ausgewählten Strecke abgeschlossen und der Agent auf der Strecke nach wahrscheinlichen Aktionen, die vom geschulten Modell abgeleitet werden, bewegt wird. Die Leistungsmetriken umfassen den Prozentsatz der vollständigen Bewältigung der Strecke und die Zeit, die auf den einzelnen Strecken vom Start bis zum Ende oder außerhalb der Strecke gefahren wird.

Um Ihr trainiertes Modell zu evaluieren, können Sie die DeepRacer AWS-Konsole verwenden. Führen Sie hierzu die Schritte in diesem Thema aus.

Um ein trainiertes Modell in der DeepRacer AWS-Konsole zu evaluieren

-

Öffnen Sie die DeepRacer AWS-Konsole unter https://console.aws.amazon.com /deepracer.

-

Wählen Sie im Hauptnavigationsbereich Models (Modelle) und dann das gerade geschulte Modell aus der Liste Models (Modelle) aus, um die Modelldetailseite zu öffnen.

-

Wählen Sie die Registerkarte Evaluation aus.

-

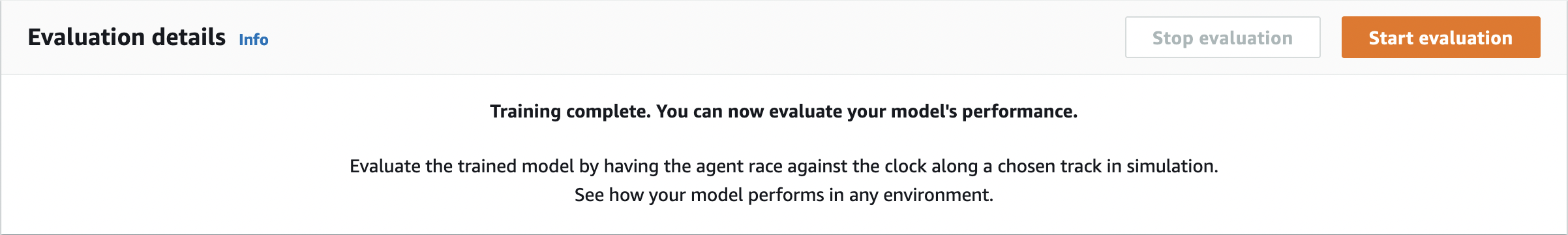

Wählen Sie unter Bewertungsdetails die Option Bewertung starten aus.

Sie können eine Evaluierung starten, nachdem sich der Schulungsauftragsstatus zu Completed (Abgeschlossen) oder der Status des Modells zu Ready (Bereit) geändert hat, wenn der Schulungsauftrag nicht abgeschlossen wurde.

Ein Modell ist bereit, wenn der Schulungsauftrag abgeschlossen ist. Wenn die Schulung nicht abgeschlossen wurde, kann sich das Modell auch im Zustand Ready (Bereit) befinden, wenn es bis zum Fehlerpunkt geschult wurde.

-

Geben Sie auf der Seite Modell bewerten unter Renntyp einen Namen für Ihre Bewertung ein und wählen Sie dann den Renntyp aus, den Sie für das Training des Modells ausgewählt haben.

Für die Evaluierung können Sie einen anderen Renntyp als den in der Schulung verwendeten Renntyp auswählen. Sie können beispielsweise ein Modell für head-to-bot Rennen trainieren und es dann für Zeitfahren auswerten. Im Allgemeinen muss das Modell gut generalisieren, wenn sich der Schulungstyp vom Renntyp für die Evaluierung unterscheidet. Für den ersten Lauf sollten Sie den gleichen Renntyp sowohl für die Evaluierung als auch für die Schulung verwenden.

-

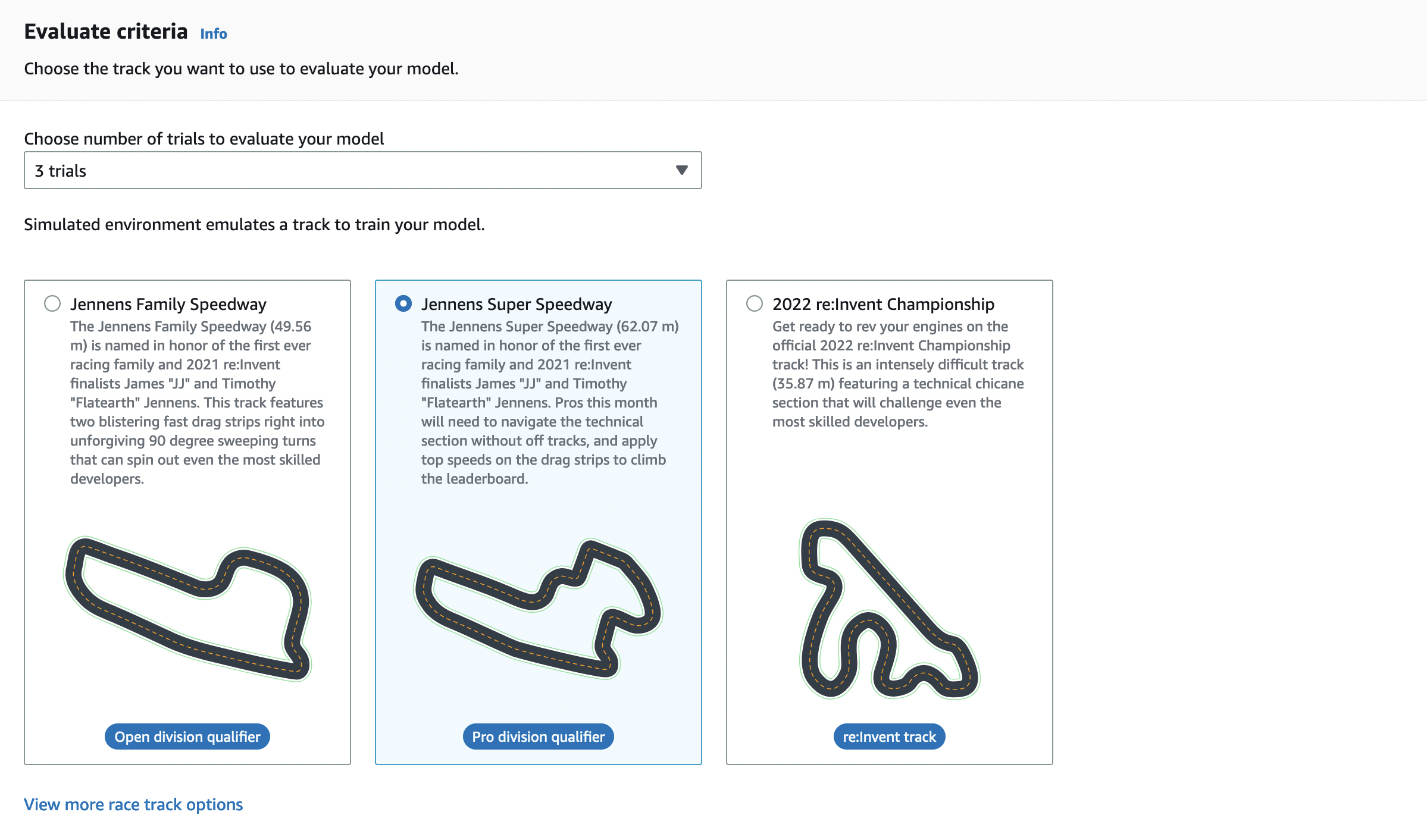

Wählen Sie auf der Seite Modell evaluieren unter Bewertungskriterien die Anzahl der Versuche aus, die Sie durchführen möchten, und wählen Sie dann eine Strecke aus, auf der das Modell bewertet werden soll.

Normalerweise sollten Sie eine Strecke auswählen, die der entspricht, die Sie beim Training des Modells verwendet haben (bzw. dieser ähnlich ist). Sie können zur Evaluierung Ihres Modells eine beliebige Strecke auswählen. Die beste Leistung ist jedoch auf einer Strecke zu erwarten, die derjenigen im Training am nächsten kommt.

Um zu sehen, ob Ihr Modell gut generalisiert, wählen Sie eine andere Evaluierungsstrecke als die in der Schulung verwendete Strecke aus.

-

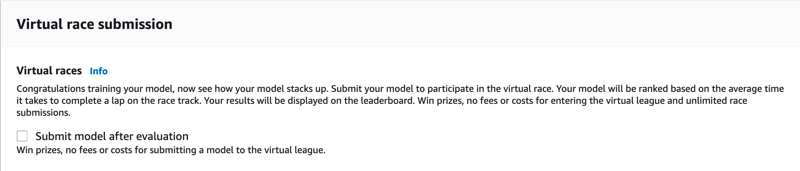

Deaktivieren Sie auf der Seite Evaluate model (Modell evaluieren) unter Virtual Race Submission (Virtuelle Renneinreichung) für Ihr erstes Modell die Option Submit model after evaluation (Modell nach Evaluierung senden). Wenn Sie später an einer Rennveranstaltung teilnehmen möchten, lassen Sie diese Option aktiviert.

-

Wählen Sie auf der Seite Evaluate model (Modell evaluieren) die Option Start evaluation (Evaluierung starten), um mit der Erstellung und Initialisierung des Evaluierungsauftrags zu beginnen.

Dieser Initialisierungsprozess dauert etwa 3 Minuten.

-

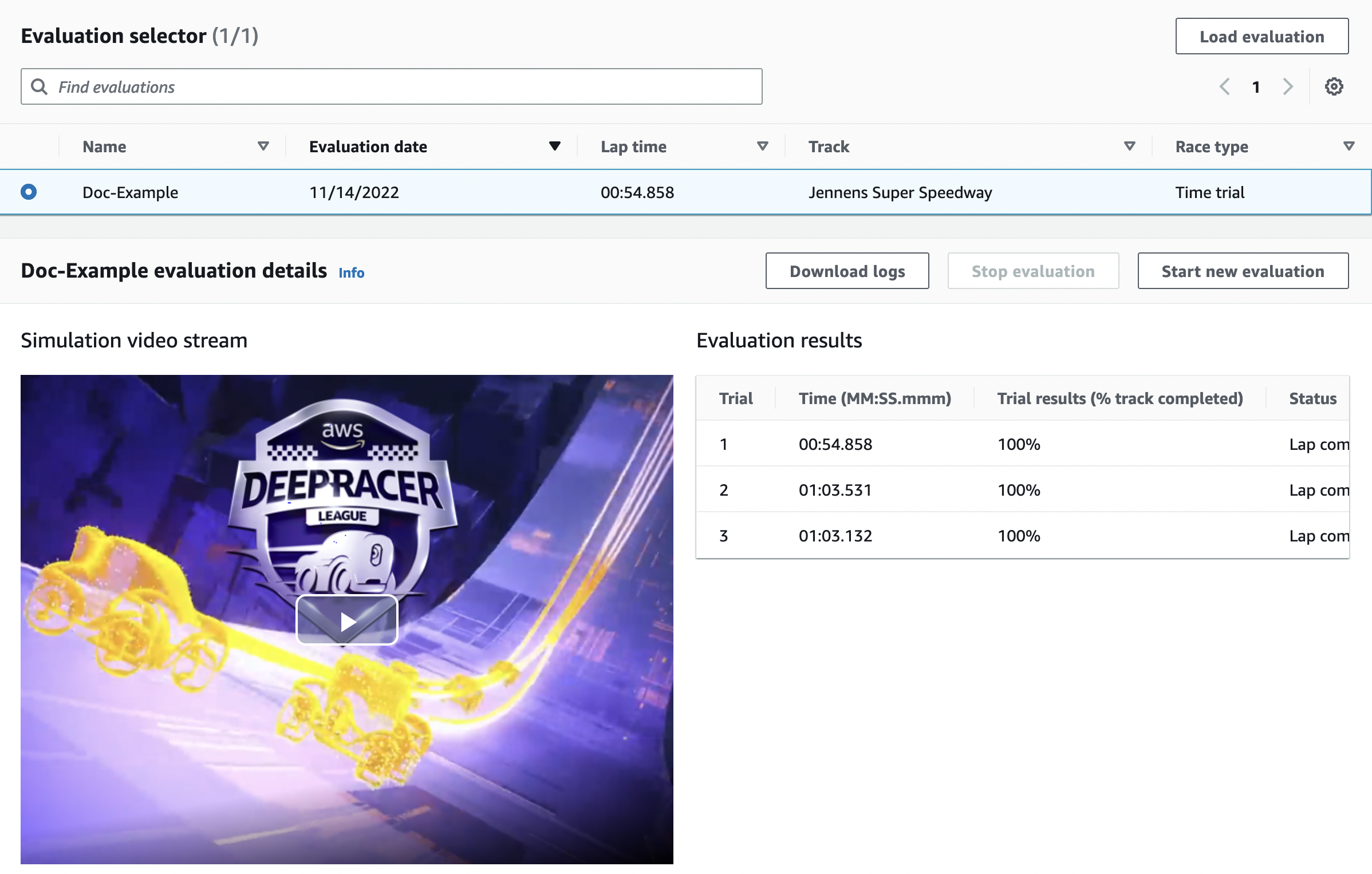

Im Verlauf der Evaluierung werden die Bewertungsergebnisse, einschließlich der Testzeit und der Abschlussquote der Strecke, nach jedem Test unter den Bewertungsdetails angezeigt. Im Fenster Simulation Video Stream (Simulationsvideostream) können Sie sehen, wie der Agent auf der gewählten Strecke funktioniert.

Sie können einen Evaluierungsauftrag beenden, bevor er abgeschlossen wird. Um einen Evaluierungsauftrag zu beenden, wählen Sie Stop evaluation (Evaluierung stoppen) in der oberen rechten Ecke der Karte Evaluation (Evaluierung) und bestätigen Sie dies dann, um die Evaluierung zu stoppen.

-

Nachdem der Evaluierungsauftrag abgeschlossen ist, untersuchen Sie die Leistungsmetriken aller Läufe unter Evaluation results (Evaluierungsergebnisse). Der dazugehörige Simulationsvideostream ist nicht mehr verfügbar.

Eine Historie der Evaluierungen Ihres Modells ist in der Evaluationsauswahl verfügbar. Um die Details einer bestimmten Bewertung anzuzeigen, wählen Sie die Bewertung aus der Auswahlliste für die Bewertung aus und klicken Sie dann in der oberen rechten Ecke der Bewertungsauswahlkarte auf Bewertung laden.

Bei dieser speziellen Bewertungsaufgabe schließt das trainierte Modell die Tests ab, was zu erheblichen Zeitverzögerungen führt. Bei einem ersten Durchlauf ist dies nicht ungewöhnlich. Mögliche Gründe dafür sind, dass die Schulung nicht konvergiert hat und mehr Zeit benötigt, der Aktionsbereich vergrößert werden muss, um dem Agenten mehr Raum für Reaktionen zu geben, oder dass die Belohnungsfunktion aktualisiert werden muss, um unterschiedliche Umgebungen zu bewältigen.

In diesem Fall können Sie das Modell weiter verbessern, indem Sie ein zuvor geschultes Modell klonen, die Belohnungsfunktion ändern, Hyperparameter optimieren und dann den Prozess wiederholen, bis die Gesamtbelohnung konvergiert und sich die Leistungsmetriken verbessern. Weitere Informationen zur Verbesserung des Trainings finden Sie unter DeepRacer AWS-Modelle trainieren und auswerten.

Um Ihr vollständig trainiertes Modell für den Betrieb in einer physischen Umgebung auf Ihr DeepRacer AWS-Gerät zu übertragen, müssen Sie die Modellartefakte herunterladen. Wählen Sie dazu auf der Detailseite des Modells Download model (Modell herunterladen) aus. Wenn Ihr DeepRacer physisches AWS-Gerät keine neuen Sensoren unterstützt und Ihr Modell mit den neuen Sensortypen trainiert wurde, erhalten Sie eine Fehlermeldung, wenn Sie das Modell auf Ihrem DeepRacer AWS-Gerät in einer realen Umgebung verwenden. Weitere Informationen zum Testen eines DeepRacer AWS-Modells mit einem physischen Gerät finden Sie unterBetreiben Sie Ihr DeepRacer AWS-Fahrzeug .

Sobald Sie Ihr Modell auf einer Strecke trainiert haben, die mit der Strecke identisch oder ähnlich ist, die bei einer AWS DeepRacer League-Rennveranstaltung oder einem DeepRacer AWS-Community-Rennen angegeben wurde, können Sie das Modell für die virtuellen Rennen in der DeepRacer AWS-Konsole einreichen. Folgen Sie dazu im Hauptnavigationsbereich den Rennen der AWS virtuellen Rennstrecke oder der Community. Weitere Informationen finden Sie unter Nehmen Sie an einem DeepRacer AWS-Rennen teil.

Um ein Modell für die Vermeidung von Hindernissen oder head-to-bot Rennen zu trainieren, müssen Sie dem Modell und dem physischen Gerät möglicherweise neue Sensoren hinzufügen. Weitere Informationen finden Sie unter Renntypen verstehen und von AWS unterstützte Sensoren aktivieren DeepRacer.