Die vorliegende Übersetzung wurde maschinell erstellt. Im Falle eines Konflikts oder eines Widerspruchs zwischen dieser übersetzten Fassung und der englischen Fassung (einschließlich infolge von Verzögerungen bei der Übersetzung) ist die englische Fassung maßgeblich.

Bewährte Methoden

Wir empfehlen, dass Sie sich an bewährte Methoden für Speicher und Technik halten. Diese bewährten Methoden können Ihnen helfen, das Beste aus Ihrer datenzentrierten Architektur herauszuholen.

Bewährte Speicherpraktiken für Big Data

Die folgende Tabelle beschreibt eine gängige bewährte Methode zum Speichern von Dateien für eine Big-Data-Verarbeitungslast auf Amazon S3. Die letzte Spalte ist ein Beispiel für eine Lebenszyklusrichtlinie, die Sie festlegen können. Wenn Amazon S3 Intelligent-Tiering

Name der Datenschicht | Beschreibung | Beispiel für eine Lebenszyklus-Richtlinienstrategie |

Raw | Enthält unverarbeitete Rohdaten Hinweis: Bei einer externen Datenquelle ist die Rohdatenschicht in der Regel eine 1:1 -Kopie der Daten, aber auf AWS können die Daten während des Aufnahmeprozesses nach Schlüsseln partitioniert werden, die auf der AWS-Region oder dem AWS-Datum basieren. | Verschieben Sie Dateien nach einem Jahr in die Speicherklasse S3 Standard-IA. Archivieren Sie die Dateien nach zwei Jahren in S3 Standard-IA in Amazon Simple Storage Service Glacier (Amazon S3 Glacier). |

Stufe | Enthält verarbeitete Zwischendaten, die für den Verbrauch optimiert sind Beispiel: Von CSV nach Apache Parquet konvertierte Rohdateien oder Datentransformationen | Sie können Daten nach einem bestimmten Zeitraum oder gemäß den Anforderungen Ihrer Organisation löschen. Sie können einige Datenderivate (z. B. eine Apache Avro-Transformation eines ursprünglichen JSON-Formats) nach kürzerer Zeit (z. B. nach 90 Tagen) aus dem Data Lake entfernen. |

Analysen | Enthält die aggregierten Daten für Ihre spezifischen Anwendungsfälle in einem benutzerfreundlichen Format Beispiel: Apache Parquet | Sie können Daten nach S3 Standard-IA verschieben und die Daten dann nach einem bestimmten Zeitraum oder gemäß den Anforderungen Ihres Unternehmens löschen. |

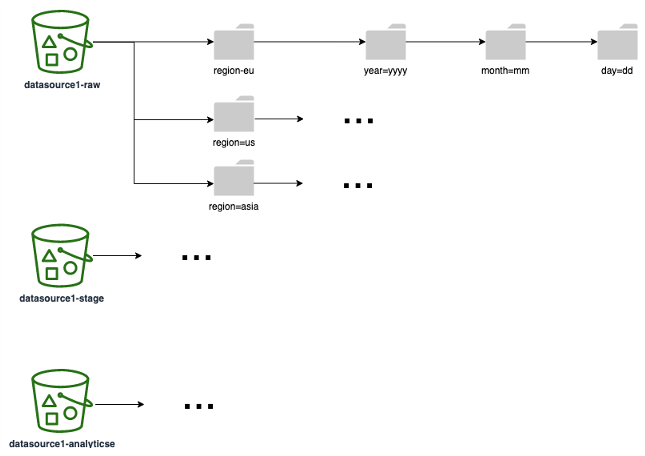

Das folgende Diagramm zeigt ein Beispiel für eine Partitionierungsstrategie (entspricht einem S3-Ordner/-Präfix), die Sie für alle Datenschichten verwenden können. Wir empfehlen Ihnen, eine Partitionierungsstrategie zu wählen, die darauf basiert, wie Ihre Daten im nachgelagerten Bereich verwendet werden. Wenn Berichte beispielsweise auf Ihren Daten basieren (wobei die häufigsten Abfragen im Bericht die Ergebnisse nach Region und Datum filtern), stellen Sie sicher, dass Sie die Regionen und Daten als Partitionen einbeziehen, um die Abfrageleistung und Laufzeit zu verbessern.

Bewährte technische Verfahren

Technische Best Practices hängen von den spezifischen AWS-Services und Verarbeitungstechnologien ab, die Sie für den Entwurf Ihrer datenzentrierten Architektur verwenden. Wir empfehlen Ihnen jedoch, die folgenden bewährten Methoden zu beachten. Diese bewährten Methoden gelten für typische Anwendungsfälle der Datenverarbeitung.

Area | Bewährte Methode |

SQL | Reduzieren Sie die Datenmenge, die abgefragt werden muss, indem Sie Attribute auf Ihre Daten projizieren. Anstatt die gesamte Tabelle zu analysieren, können Sie die Datenprojektion verwenden, um nur bestimmte erforderliche Spalten in der Tabelle zu scannen und zurückzugeben. Vermeiden Sie nach Möglichkeit große Verknüpfungen, da Verknüpfungen zwischen mehreren Tabellen aufgrund ihrer ressourcenintensiven Anforderungen die Leistung erheblich beeinträchtigen können. |

Apache Spark | Optimieren Sie Spark-Anwendungen Optimieren Sie die Speicherverwaltung |

Datenbank-Design | Folgen Sie den Architektur-Best Practices für Datenbanken |

Bereinigung von Daten | Verwenden Sie das serverseitige Bereinigen von Partitionen mit dem |

Skalierung | Verstehen und implementieren Sie die horizontale Skalierung |