Las traducciones son generadas a través de traducción automática. En caso de conflicto entre la traducción y la version original de inglés, prevalecerá la version en inglés.

Implementar un modelo compilado con la Consola

Debe cumplir con la sección de requisitos previos si el modelo se compiló utilizando AWS SDK para Python (Boto3) la AWS CLI consola Amazon AI o la consola Amazon SageMaker AI. Siga los pasos que se indican a continuación para crear e implementar un modelo compilado con SageMaker IA NEO utilizando la consola de SageMaker IA o la IA https://console.aws.amazon.com. SageMaker

Implementar el modelo

Una vez que haya cumplido los requisitos previos, siga los siguientes pasos para implementar un modelo compilado con Neo:

-

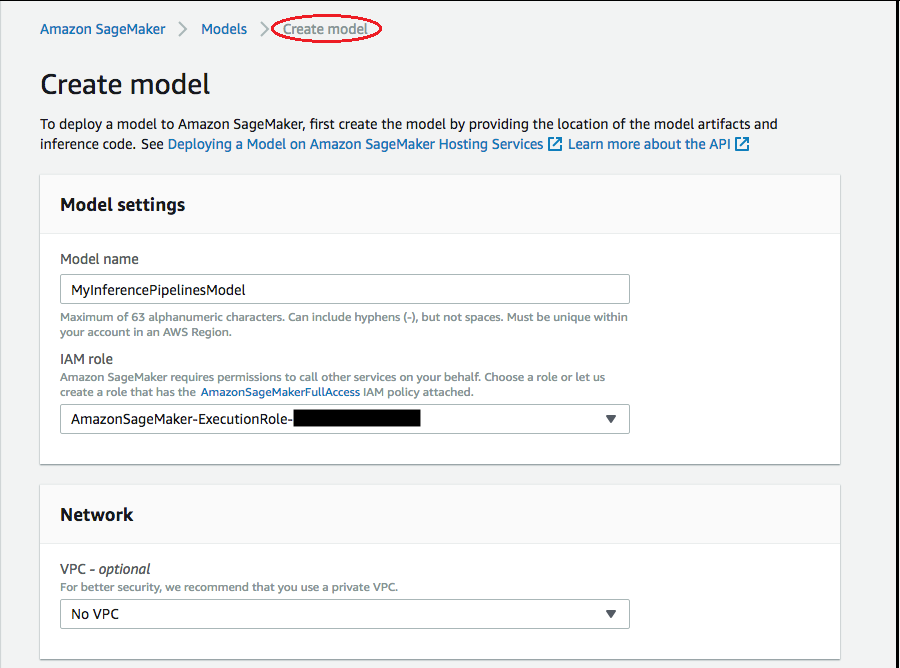

Elija Modelos y, a continuación, seleccione Crear modelos en el grupo Inferencia. En la página Crear modelo, cumplimente los campos Nombre del modelo, Rol de IAM y, si es preciso, VPC (opcional).

-

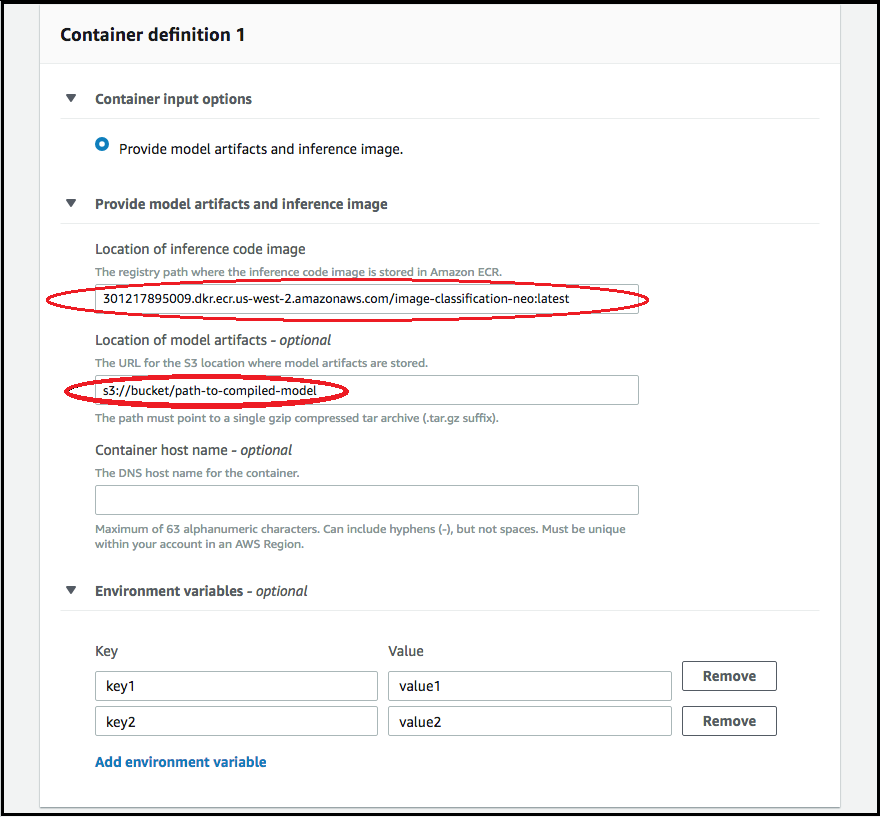

Para agregar información sobre el contenedor utilizado para implementar el modelo, seleccione Agregar contenedor y haga clic en Siguiente. Complete los campos Opciones de entrada del contenedor, Ubicación de la imagen del código de inferencia y Ubicación de los artefactos del modelo; opcionalmente, también puede completar los campos Nombre del host contenedor y Variables de entorno.

-

Para implementar modelos compilados por Neo, elija las opciones siguientes:

-

Opciones de entrada del contenedor: seleccione Proporcionar artefactos de modelo e imágenes de inferencia.

-

Ubicación de la imagen del código de inferencia: elija el URI de la imagen de inferencia de Imágenes de contenedor de inferencias de Neo, según la AWS región y el tipo de aplicación.

-

Ubicación de los artefactos del modelo: introduzca el URI del bucket de S3 del artefacto del modelo compilado generado por la API de compilación de Neo.

-

Variables de entorno:

-

Deje este campo en blanco durante SageMaker XGBoost.

-

Si entrenó su modelo mediante SageMaker IA, especifique la variable de entorno

SAGEMAKER_SUBMIT_DIRECTORYcomo el URI del bucket de Amazon S3 que contiene el script de entrenamiento. -

Si no entrenó el modelo con SageMaker IA, especifique las siguientes variables de entorno:

Clave Valores para MXNet y PyTorch Valores TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <su región> <su región> MMS_DEFAULT_RESPONSE_TIMEOUT 500 Deje este campo en blanco para TF

-

-

-

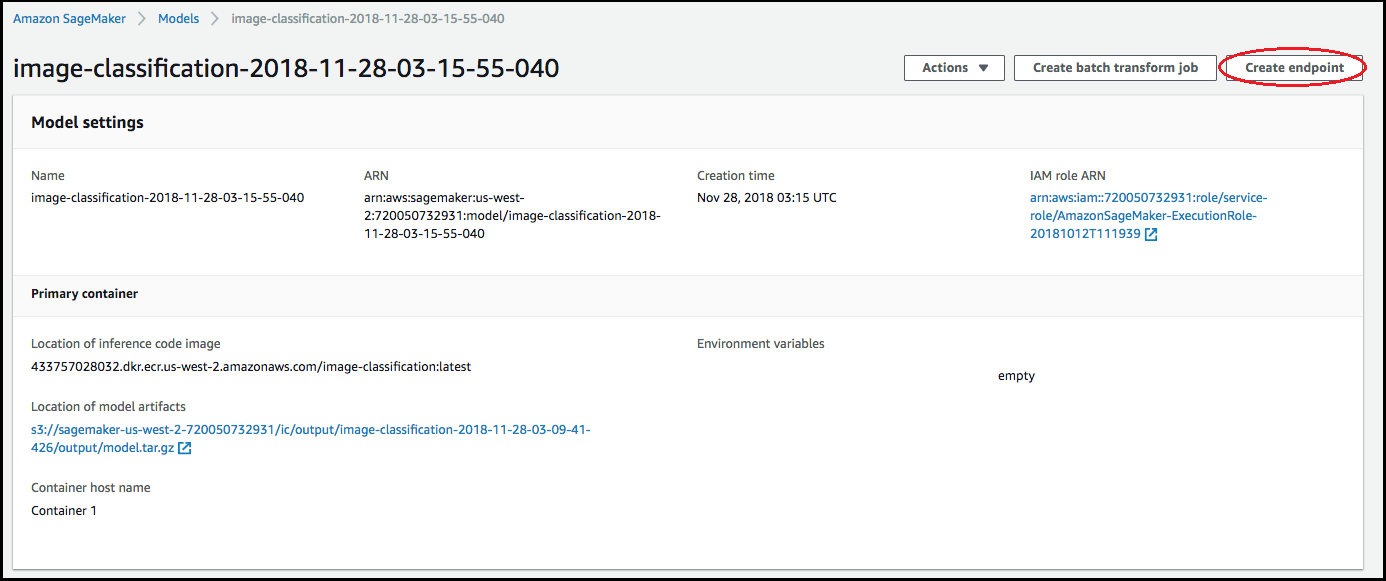

Confirme que la información para los contenedores es precisa y, a continuación, seleccione Crear modelo. En la página de inicio para crear un modelo, elija Crear punto de conexión.

-

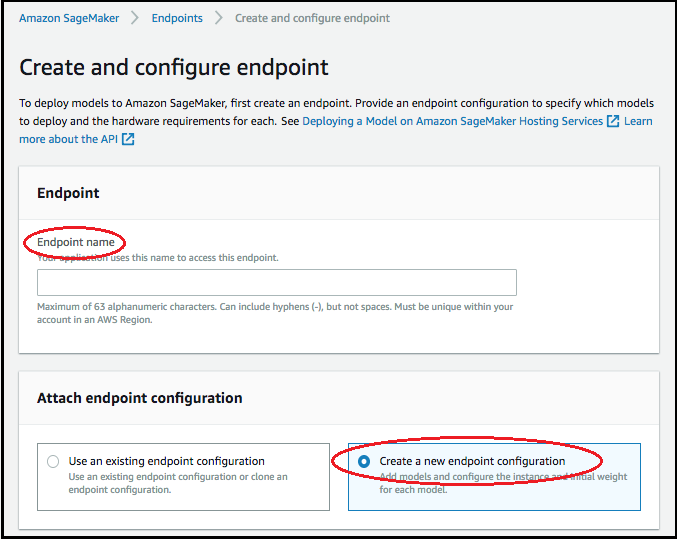

En el diagrama Crear y configurar punto de enlace, especifique el Nombre del punto de enlace. Para Asociar configuración de punto de conexión, seleccione Crear una nueva configuración de punto de conexión.

-

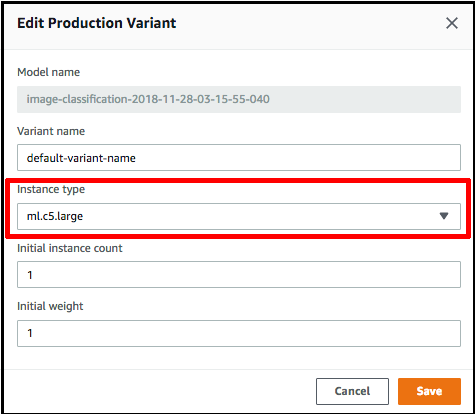

En la página Nueva configuración del punto de conexión, especifique el Nombre de configuración de punto de conexión.

-

Seleccione Editar junto al nombre del modelo y especifique el Tipo de instancia correcto en la página Editar variante de producción. Es imprescindible que el valor del Tipo de instancia coincida con el valor especificado en el trabajo de compilación.

-

Seleccione Save.

-

En la página de Configuración de nuevo punto de conexión, elija Crear configuración de punto de conexión y, a continuación, elija Crear punto de conexión.