Aidez à améliorer cette page

Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Pour contribuer à ce guide de l'utilisateur, cliquez sur le GitHub lien Modifier cette page sur qui se trouve dans le volet droit de chaque page.

Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Déployez des pods dans des sous-réseaux alternatifs avec un réseau personnalisé

S'applique à : les nœuds Linux IPv4 Fargate, les nœuds Linux avec des instances Amazon EC2

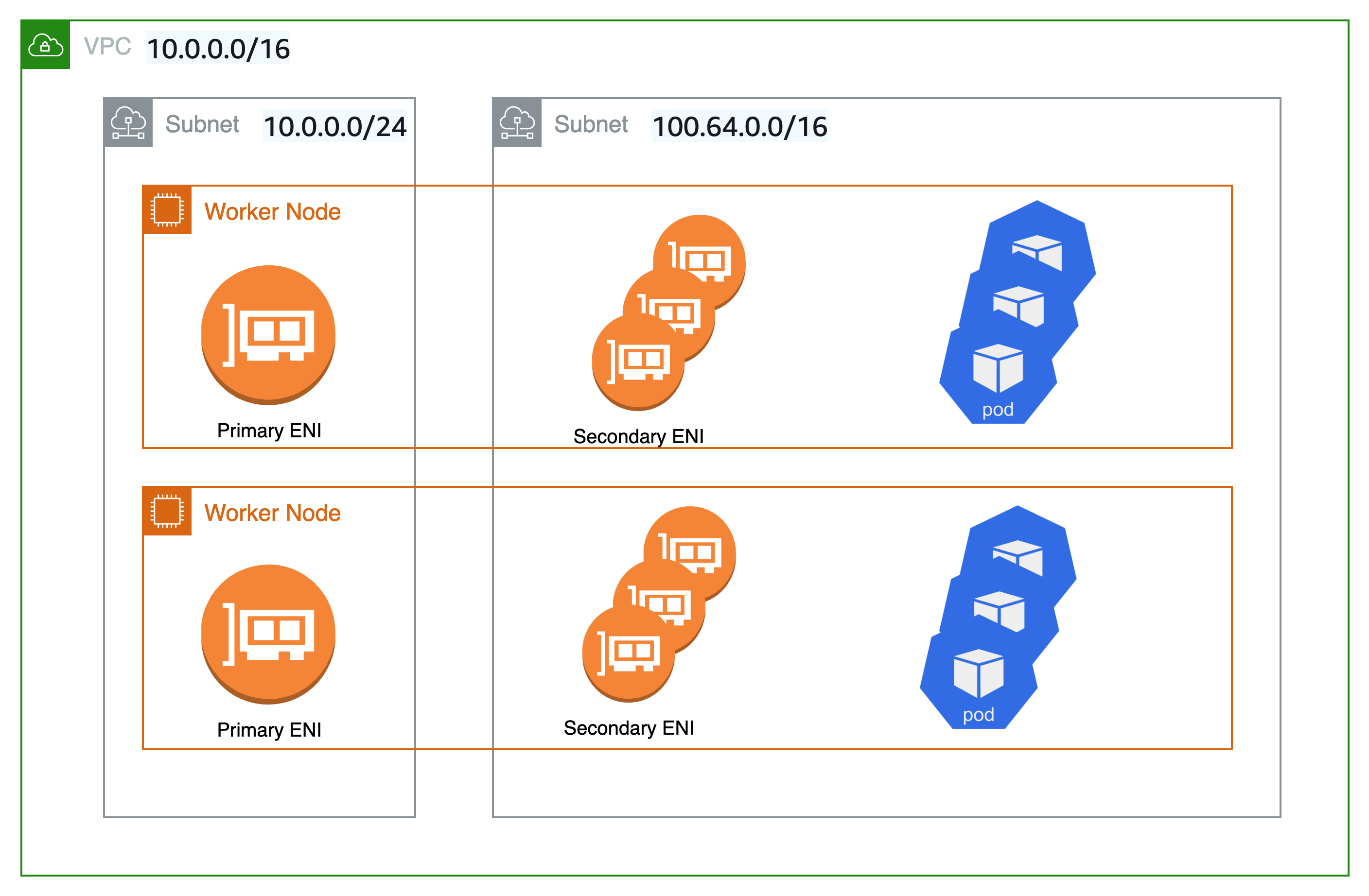

Par défaut, lorsque le plug-in Amazon VPC CNI pour Kubernetes crée des interfaces réseau élastiques secondaires (interfaces réseau) pour votre EC2 nœud Amazon, il les crée dans le même sous-réseau que l'interface réseau principale du nœud. Il associe également les mêmes groupes de sécurité à l'interface réseau secondaire, qui sont associés à l'interface réseau principale. Pour une ou plusieurs des raisons suivantes, vous voudrez peut-être que le plugin crée des interfaces réseau secondaires dans un sous-réseau différent ou associe différents groupes de sécurité aux interfaces réseau secondaires, ou les deux :

-

Le nombre d'

IPv4adresses disponibles dans le sous-réseau dans lequel se trouve l'interface réseau principale est limité. Cela peut limiter le nombre de pods que vous pouvez créer dans le sous-réseau. En utilisant un sous-réseau différent pour les interfaces réseau secondaires, vous pouvez augmenter le nombre d'IPv4adresses disponibles pour les pods. -

Pour des raisons de sécurité, vos pods devront peut-être utiliser un sous-réseau ou des groupes de sécurité différents de ceux de l'interface réseau principale du nœud.

-

Les nœuds sont configurés dans des sous-réseaux publics et vous souhaitez placer les pods dans des sous-réseaux privés. La table de routage associée à un sous-réseau public comprend une route vers une passerelle Internet. La table de routage associée à un sous-réseau privé n'inclut pas de route vers une passerelle Internet.

Astuce

Vous pouvez également ajouter un sous-réseau nouveau ou existant directement à votre cluster Amazon EKS, sans utiliser de réseau personnalisé. Pour de plus amples informations, veuillez consulter Ajouter un sous-réseau VPC existant à un cluster Amazon EKS depuis la console de gestion.

Considérations

Voici quelques considérations relatives à l'utilisation de cette fonctionnalité.

-

Lorsque la mise en réseau personnalisée est activée, aucune adresse IP attribuée à l'interface réseau principale n'est attribuée aux Pods. Seules les adresses IP des interfaces réseau secondaires sont attribuées aux Pods.

-

Si votre cluster utilise la

IPv6famille, vous ne pouvez pas utiliser le réseau personnalisé. -

Si vous prévoyez d'utiliser une mise en réseau personnalisée uniquement pour pallier à l'épuisement des adresses

IPv4, vous pouvez plutôt créer un cluster à l'aide de la familleIPv6. Pour de plus amples informations, veuillez consulter En savoir plus sur IPv6 les adresses des clusters, des pods et des services. -

Même si les pods déployés sur des sous-réseaux spécifiés pour les interfaces réseau secondaires peuvent utiliser des sous-réseaux et des groupes de sécurité différents de ceux de l'interface réseau principale du nœud, les sous-réseaux et les groupes de sécurité doivent se trouver dans le même VPC que le nœud.

-

Pour Fargate, les sous-réseaux sont contrôlés via le profil Fargate. Pour de plus amples informations, veuillez consulter Définissez quels pods utilisent AWS Fargate lors de leur lancement.