Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Architecture et diagrammes de séquence

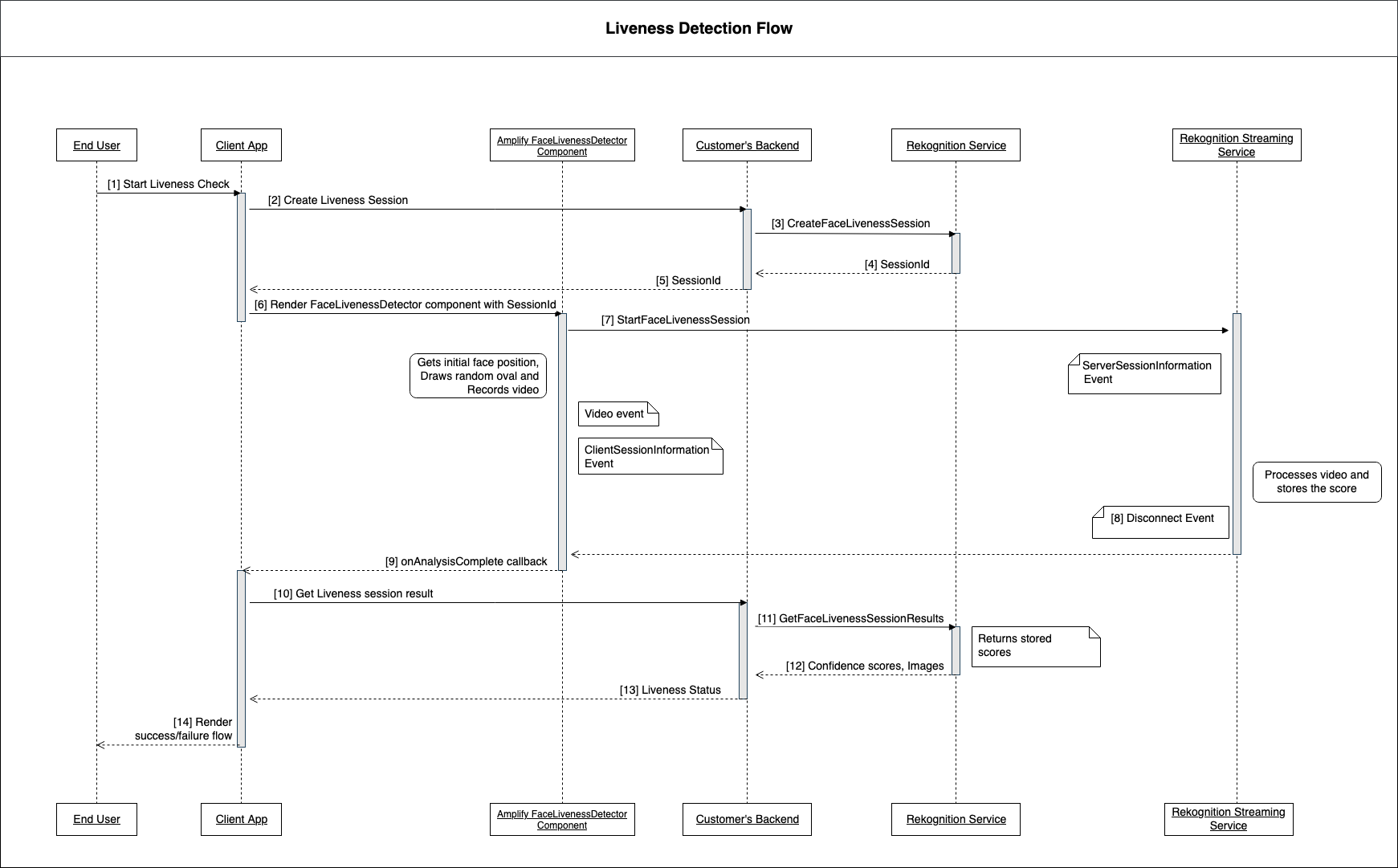

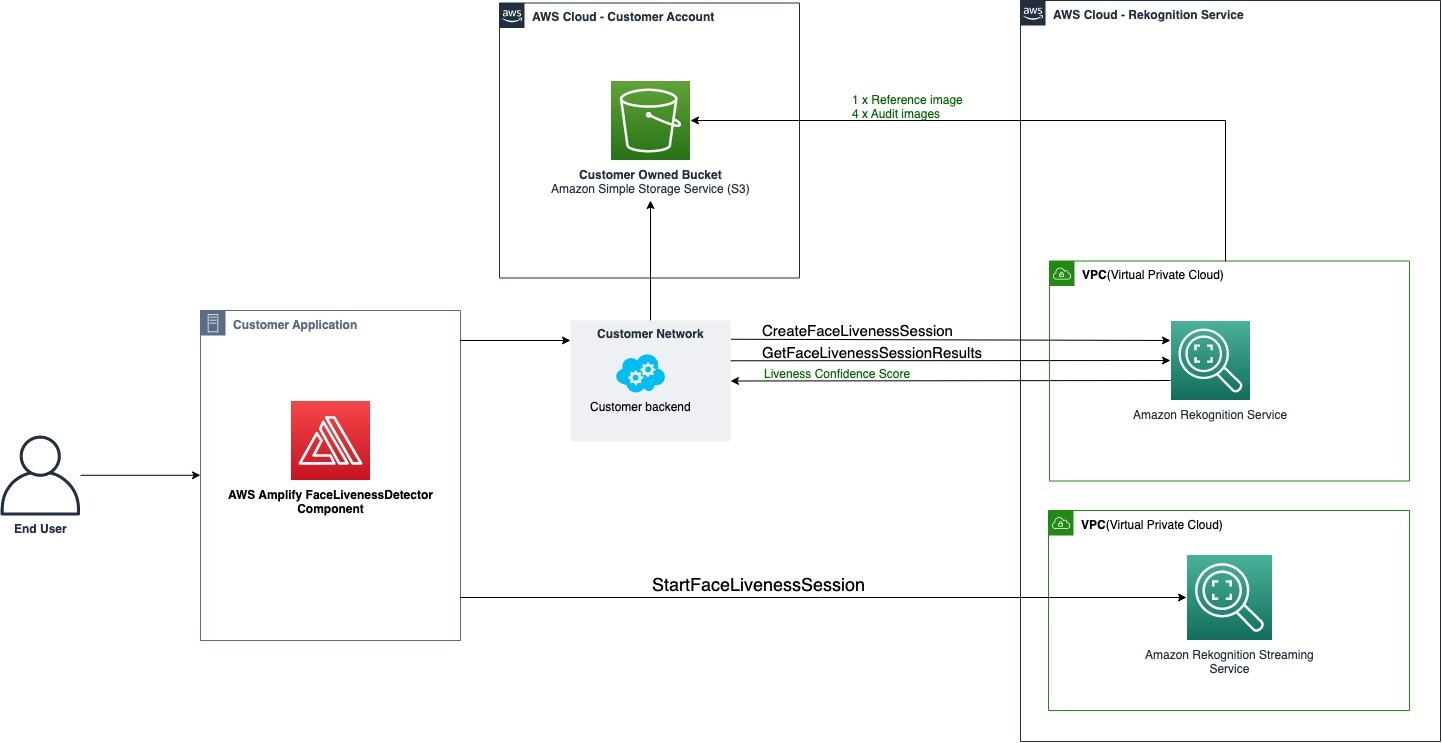

Les diagrammes suivants décrivent le fonctionnement d’Amazon Rekognition Face Liveness en ce qui concerne l’architecture de la fonctionnalité et la séquence des opérations :

Le processus de vérification de la vivacité faciale comporte plusieurs étapes, comme indiqué ci-dessous :

-

L’utilisateur lance un test Face Liveness dans l’application cliente.

L’application cliente appelle le backend du client, qui à son tour appelle le service Amazon Rekognition. Le service crée une session Face Liveness et renvoie une session unique SessionId. Remarque : Une SessionId fois envoyé, il expire au bout de 3 minutes. Il n'y a donc que 3 minutes pour effectuer les étapes 3 à 7 ci-dessous. Un nouveau SessionID doit être utilisé pour chaque contrôle de Face Liveness. Si un ID de session donné est utilisé pour les tests Face Liveness ultérieurs, les contrôles échoueront. De plus, un SessionId fichier expire 3 minutes après son envoi, rendant toutes les données Liveness associées à la session (par exemple, l'identifiant de session, l'image de référence, les images d'audit, etc.) indisponibles.

-

L'application client affiche le composant FaceLivenessDetector Amplify à l'aide des rappels SessionId obtenus et appropriés.

-

Le FaceLivenessDetector composant établit une connexion au service de streaming Amazon Rekognition, affiche un ovale sur l'écran de l'utilisateur et affiche une séquence de lumières colorées. FaceLivenessDetector enregistre et diffuse des vidéos en temps réel sur le service de streaming Amazon Rekognition.

-

Le service de streaming Amazon Rekognition traite la vidéo en temps réel, stocke les résultats et DisconnectEvent renvoie un FaceLivenessDetector au composant une fois le streaming terminé.

-

Le FaceLivenessDetector composant appelle le

onAnalysisCompleterappel pour signaler à l'application cliente que le streaming est terminé et que les scores sont prêts à être récupérés. -

L’application cliente appelle le backend du client pour obtenir un drapeau booléen indiquant si l’utilisateur était actif ou non. Le backend du client fait la demande au service Amazon Rekognition pour obtenir le score de confiance, les images de référence et les images d’audit. Le backend client utilise ces attributs pour déterminer si l’utilisateur est en ligne et renvoie une réponse appropriée à l’application cliente.

-

Enfin, l'application client transmet la réponse au FaceLivenessDetector composant, qui affiche le success/failure message de manière appropriée pour terminer le flux.