Les traductions sont fournies par des outils de traduction automatique. En cas de conflit entre le contenu d'une traduction et celui de la version originale en anglais, la version anglaise prévaudra.

Contrôleur de SageMaker tableau de bord Amazon Debugger Insights

Il existe différents composants du contrôleur Debugger pour la surveillance et le profilage. Dans ce guide, vous allez découvrir les composants du contrôleur Debugger.

Note

Le tableau de bord SageMaker Debugger Insights exécute une application Studio Classic sur une ml.m5.4xlarge instance pour traiter et afficher les visualisations. Chaque onglet SageMaker Debugger Insights exécute une session de noyau Studio Classic. Plusieurs sessions de noyau pour plusieurs onglets de SageMaker Debugger Insights s'exécutent sur une seule instance. Lorsque vous fermez un onglet SageMaker Debugger Insights, la session de noyau correspondante est également fermée. L'application Studio Classic reste active et entraîne des frais pour l'utilisation de l'ml.m5.4xlargeinstance. Pour plus d'informations sur les tarifs, consultez la page de SageMaker tarification d'Amazon

Important

Lorsque vous avez terminé d'utiliser le tableau de bord SageMaker Debugger Insights, arrêtez l'ml.m5.4xlargeinstance pour éviter d'accumuler des frais. Pour plus d'informations sur la façon d'arrêter une instance, consultez Arrêtez l'instance Amazon SageMaker Debugger Insights.

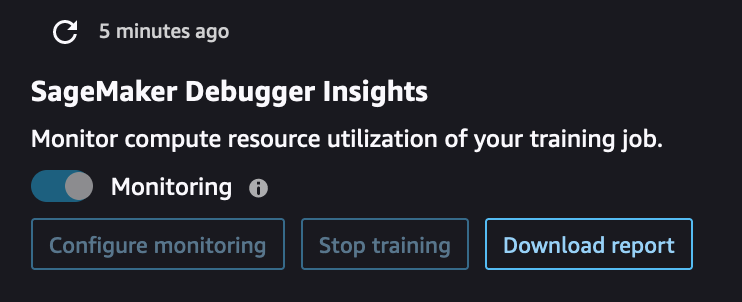

SageMaker Interface utilisateur du contrôleur Debugger Insights

À l'aide du contrôleur Debugger situé en haut à gauche du tableau de bord Insights, vous pouvez actualiser le tableau de bord, configurer ou mettre à jour les paramètres Debugger pour surveiller les métriques système, arrêter la tâche d'entraînement et télécharger le rapport de profilage Debugger.

-

Si vous souhaitez actualiser manuellement le tableau de bord, choisissez le bouton d'actualisation (la flèche arrondie en haut à gauche) comme indiqué dans la capture d'écran précédente.

-

Le bouton Monitoring est activé par défaut pour toute tâche de SageMaker formation initiée à l'aide du SDK SageMaker Python. S'il n'est pas activé, vous pouvez utiliser le bouton à bascule pour démarrer la surveillance. Pendant la surveillance, Debugger collecte uniquement les métriques d'utilisation des ressources pour détecter les problèmes de calcul, tels que les goulets d'étranglement du CPU et la sous-utilisation du GPU. Pour une liste complète des problèmes d'utilisation des ressources surveillés par Debugger, voir Règles intégrées du Debugger pour le profilage de l'utilisation des ressources matérielles du système (métriques système).

-

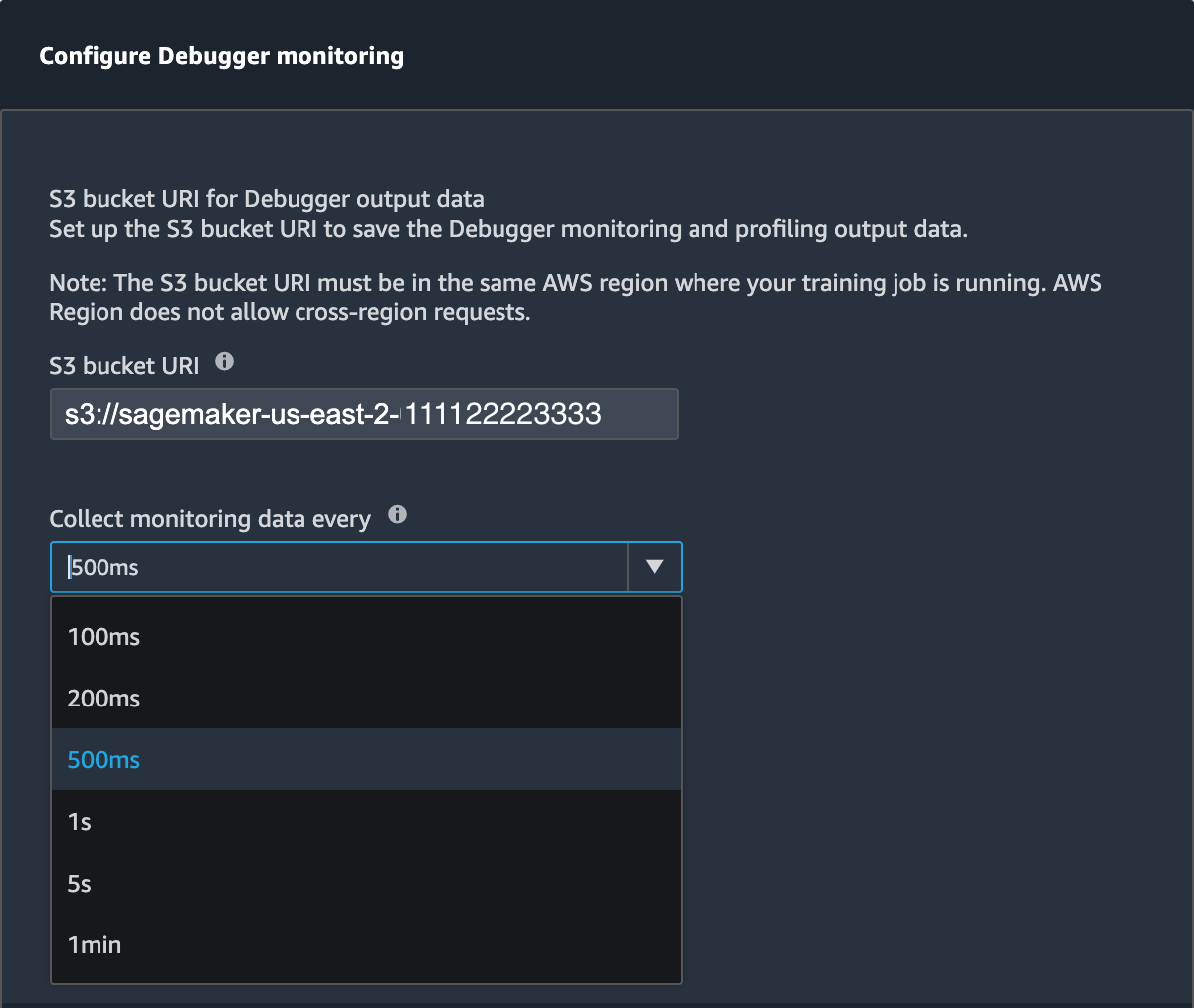

Le bouton Configurer la surveillance ouvre une fenêtre contextuelle que vous pouvez utiliser pour définir ou mettre à jour la fréquence de collecte des données et le chemin S3 pour enregistrer les données.

Vous pouvez spécifier des valeurs pour les champs suivants.

-

S3 bucket URI (URI du compartiment S3) : spécifiez l'URI du compartiment S3 de base.

-

Collect monitoring data every (Collecter les données de surveillance toutes les) : sélectionnez un intervalle de temps pour la collecte des métriques système. Vous pouvez choisir un intervalle de surveillance dans la liste déroulante. Les intervalles disponibles sont 100 millisecondes, 200 millisecondes, 500 millisecondes (par défaut), 1 seconde, 5 secondes et 1 minute.

Note

Si vous choisissez l'un des intervalles les plus courts, vous augmentez la granularité des métriques d'utilisation des ressources, ce qui vous permet de capturer les pics et les anomalies avec une résolution temporelle plus élevée. Toutefois, plus la résolution est élevée, plus la taille des métriques système à traiter est importante. Cela peut entraîner des frais supplémentaires et avoir un impact sur le temps global d'entraînement et de traitement.

-

-

À l'aide du bouton Arrêter l'entraînement, vous pouvez arrêter la tâche d'entraînement lorsque vous constatez des anomalies dans l'utilisation des ressources.

-

À l'aide du bouton Télécharger le rapport, vous pouvez télécharger un rapport de profilage agrégé en utilisant la ProfilerReportrègle intégrée de SageMaker Debugger. Le bouton est activé lorsque vous ajoutez la ProfilerReportrègle intégrée à l'estimateur. Pour plus d'informations, voir Configurer les règles de profilage intégrées et le rapport de profilage généré à l'aide du SageMaker débogueur.