Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Memulai dengan Amazon EMR di EKS

Topik ini membantu Anda mulai menggunakan Amazon EMR di EKS dengan menerapkan aplikasi Spark pada cluster virtual. Ini termasuk langkah-langkah untuk mengatur izin yang benar dan untuk memulai pekerjaan. Sebelum memulai, pastikan bahwa Anda telah menyelesaikan langkah-langkah dalam Menyiapkan Amazon EMR di EKS. Ini membantu Anda mendapatkan alat seperti AWS CLI pengaturan sebelum membuat cluster virtual Anda. Untuk templat lain yang dapat membantu Anda memulai, lihat Panduan Praktik Terbaik Kontainer EMR

Anda memerlukan informasi berikut dari langkah-langkah penyiapan:

-

ID klaster virtual untuk klaster Amazon EKS dan namespace Kubernetes terdaftar dengan Amazon EMR

penting

Saat membuat cluster EKS, pastikan untuk menggunakan m5.xlarge sebagai tipe instance, atau jenis instance lainnya dengan CPU dan memori yang lebih tinggi. Menggunakan tipe instans dengan CPU atau memori yang lebih rendah dari m5.xlarge dapat menyebabkan kegagalan pekerjaan karena sumber daya yang tidak mencukupi yang tersedia di cluster.

-

Nama IAM role yang digunakan untuk eksekusi tugas

-

Label rilis untuk rilis Amazon EMR (misalnya,

emr-6.4.0-latest) -

Target tujuan untuk pencatatan dan pemantauan:

-

Nama grup CloudWatch log Amazon dan awalan aliran log

-

Lokasi Amazon S3 untuk menyimpan peristiwa dan log kontainer

-

penting

Amazon EMR pada pekerjaan EKS menggunakan Amazon CloudWatch dan Amazon S3 sebagai target tujuan untuk pemantauan dan pencatatan. Anda dapat memantau kemajuan pekerjaan dan memecahkan masalah kegagalan dengan melihat log pekerjaan yang dikirim ke tujuan ini. Untuk mengaktifkan logging, kebijakan IAM yang terkait dengan peran IAM untuk pelaksanaan pekerjaan harus memiliki izin yang diperlukan untuk mengakses sumber daya target. Jika kebijakan IAM tidak memiliki izin yang diperlukan, Anda harus mengikuti langkah-langkah yang diuraikan, Mengonfigurasi proses Perbarui kebijakan kepercayaan dari peran eksekusi tugas pekerjaan untuk menggunakan log Amazon S3, dan Mengonfigurasi pekerjaan yang dijalankan untuk menggunakan CloudWatch Log sebelum menjalankan tugas sampel ini.

Jalankan aplikasi Spark

Ambil langkah-langkah berikut untuk menjalankan aplikasi Spark sederhana di Amazon EMR di EKS. entryPointFile aplikasi untuk aplikasi Spark Python terletak di. s3:// REGION.elasticmapreduce/emr-containers/samples/wordcount/scripts/wordcount.pyREGIONIni adalah Wilayah di mana EMR Amazon Anda di kluster virtual EKS berada, seperti. us-east-1

-

Perbarui kebijakan IAM untuk peran pelaksanaan pekerjaan dengan izin yang diperlukan, seperti yang ditunjukkan oleh pernyataan kebijakan berikut.

-

Pernyataan pertama

ReadFromLoggingAndInputScriptBucketsdalam kebijakan ini memberikanListBucketdanGetObjectsakses ke bucket Amazon S3 berikut:-

REGION.elasticmapreduceentryPointfile aplikasi berada. -

amzn-s3-demo-destination-bucket- ember yang Anda tentukan untuk data keluaran Anda. -

amzn-s3-demo-logging-bucket- ember yang Anda tentukan untuk data logging Anda.

-

-

Pernyataan kedua

WriteToLoggingAndOutputDataBucketsdalam kebijakan ini memberikan izin pekerjaan untuk menulis data ke bucket keluaran dan logging Anda masing-masing. -

Pernyataan ketiga

DescribeAndCreateCloudwatchLogStreammemberikan pekerjaan dengan izin untuk mendeskripsikan dan membuat Amazon CloudWatch Logs. -

Pernyataan keempat

WriteToCloudwatchLogsmemberikan izin untuk menulis log ke grup CloudWatch log Amazon bernamamy_log_group_namemy_log_stream_prefix

-

-

Untuk menjalankan aplikasi Spark Python, gunakan perintah berikut. Ganti semua nilai yang dapat diganti dengan

red italicizednilai yang sesuai.REGIONIni adalah Wilayah di mana EMR Amazon Anda di kluster virtual EKS berada, seperti.us-east-1aws emr-containers start-job-run \ --virtual-cluster-idcluster_id\ --namesample-job-name\ --execution-role-arnexecution-role-arn\ --release-labelemr-6.4.0-latest\ --job-driver '{ "sparkSubmitJobDriver": { "entryPoint": "s3://REGION.elasticmapreduce/emr-containers/samples/wordcount/scripts/wordcount.py", "entryPointArguments": ["s3://amzn-s3-demo-destination-bucket/wordcount_output"], "sparkSubmitParameters": "--conf spark.executor.instances=2 --conf spark.executor.memory=2G --conf spark.executor.cores=2 --conf spark.driver.cores=1" } }' \ --configuration-overrides '{ "monitoringConfiguration": { "cloudWatchMonitoringConfiguration": { "logGroupName": "my_log_group_name", "logStreamNamePrefix": "my_log_stream_prefix" }, "s3MonitoringConfiguration": { "logUri": "s3://amzn-s3-demo-logging-bucket" } } }'Data output dari pekerjaan ini akan tersedia di

s3://.amzn-s3-demo-destination-bucket/wordcount_outputAnda juga dapat membuat file JSON dengan parameter tertentu untuk menjalankan tugas Anda. Kemudian jalankan perintah

start-job-rundengan jalur ke file JSON. Untuk informasi selengkapnya, lihat Kirim pekerjaan yang dijalankan dengan StartJobRun. Untuk detail lebih lanjut tentang mengonfigurasi parameter untuk menjalankan tugas, lihat Pilihan untuk mengonfigurasi tugas berjalan. -

Untuk menjalankan aplikasi Spark SQL, gunakan perintah berikut. Ganti semua

red italicizednilai dengan nilai yang sesuai.REGIONIni adalah Wilayah di mana EMR Amazon Anda di kluster virtual EKS berada, seperti.us-east-1aws emr-containers start-job-run \ --virtual-cluster-idcluster_id\ --namesample-job-name\ --execution-role-arnexecution-role-arn\ --release-labelemr-6.7.0-latest\ --job-driver '{ "sparkSqlJobDriver": { "entryPoint": "s3://query-file.sql", "sparkSqlParameters": "--conf spark.executor.instances=2 --conf spark.executor.memory=2G --conf spark.executor.cores=2 --conf spark.driver.cores=1" } }' \ --configuration-overrides '{ "monitoringConfiguration": { "cloudWatchMonitoringConfiguration": { "logGroupName": "my_log_group_name", "logStreamNamePrefix": "my_log_stream_prefix" }, "s3MonitoringConfiguration": { "logUri": "s3://amzn-s3-demo-logging-bucket" } } }'Contoh file query SQL ditunjukkan di bawah ini. Anda harus memiliki penyimpanan file eksternal, seperti S3, tempat data untuk tabel disimpan.

CREATE DATABASE demo; CREATE EXTERNAL TABLE IF NOT EXISTS demo.amazonreview( marketplace string, customer_id string, review_id string, product_id string, product_parent string, product_title string, star_rating integer, helpful_votes integer, total_votes integer, vine string, verified_purchase string, review_headline string, review_body string, review_date date, year integer) STORED AS PARQUET LOCATION 's3://URI to parquet files'; SELECT count(*) FROM demo.amazonreview; SELECT count(*) FROM demo.amazonreview WHERE star_rating = 3;Output untuk pekerjaan ini akan tersedia di log stdout driver di S3 atau CloudWatch, tergantung pada

monitoringConfigurationyang dikonfigurasi. -

Anda juga dapat membuat file JSON dengan parameter tertentu untuk menjalankan tugas Anda. Kemudian jalankan perintah start-job-run dengan jalur ke file JSON. Untuk informasi selengkapnya, lihat Mengirimkan pekerjaan. Untuk detail selengkapnya tentang mengonfigurasi parameter job run, lihat Opsi untuk mengonfigurasi job run.

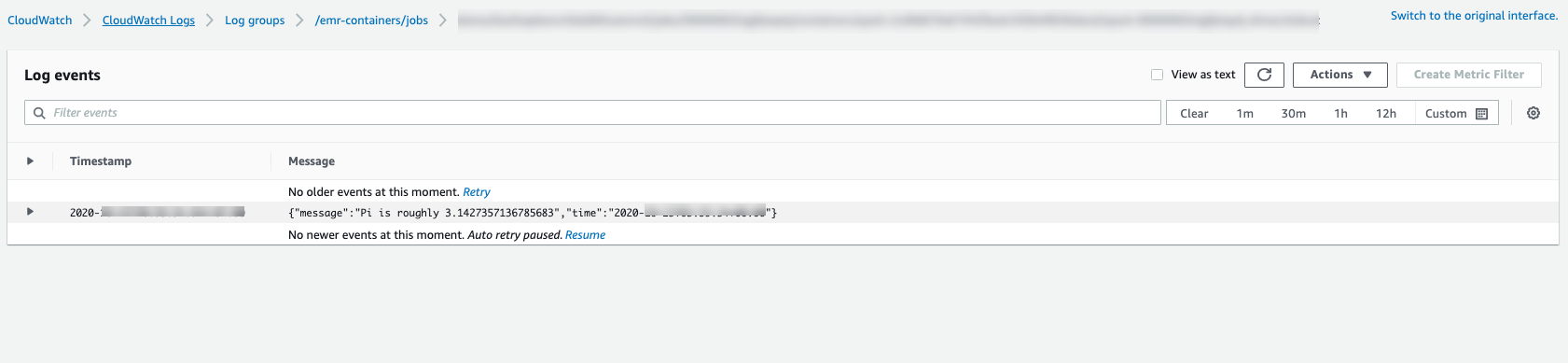

Untuk memantau kemajuan pekerjaan atau kegagalan debug, Anda dapat memeriksa log yang diunggah ke Amazon S3, Log, CloudWatch atau keduanya. Lihat jalur log di Amazon S3 di Konfigurasikan pekerjaan yang dijalankan untuk menggunakan log S3 dan untuk log Cloudwatch di Konfigurasikan pekerjaan yang dijalankan untuk menggunakan Log. CloudWatch Untuk melihat log di CloudWatch Log, ikuti petunjuk di bawah ini.

-

Buka CloudWatch konsol di https://console.aws.amazon.com/cloudwatch/

. -

Di panel Navigasi, pilih Log. Lalu pilih Grup log.

-

Pilih grup log untuk Amazon EMR di EKS kemudian lihat log acara yang diunggah.

-

penting

Pekerjaan memiliki kebijakan coba ulang yang dikonfigurasi default. Untuk informasi tentang cara mengubah atau menonaktifkan konfigurasi, lihat Menggunakan kebijakan coba ulang pekerjaan.