Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Membuat saluran pipa Amazon OpenSearch Ingestion

Pipeline adalah mekanisme yang digunakan Amazon OpenSearch Ingestion untuk memindahkan data dari sumbernya (dari mana data berasal) ke wastafelnya (ke mana data pergi). Dalam OpenSearch Ingestion, wastafel akan selalu menjadi domain OpenSearch Layanan Amazon tunggal, sedangkan sumber data Anda bisa berupa klien seperti Amazon S3, Fluent Bit, atau Collector. OpenTelemetry

Untuk informasi selengkapnya, lihat Pipelines

Topik

Prasyarat dan peran IAM yang diperlukan

Untuk membuat pipeline OpenSearch Ingestion, Anda harus memiliki sumber daya berikut:

-

Peran IAM, yang disebut peran pipa, yang diasumsikan oleh OpenSearch Ingestion untuk menulis ke wastafel. Anda dapat membuat peran ini sebelumnya, atau Anda dapat meminta OpenSearch Ingestion membuatnya secara otomatis saat Anda membuat pipeline.

-

Domain OpenSearch Layanan atau koleksi OpenSearch Tanpa Server untuk bertindak sebagai wastafel. Jika Anda menulis ke domain, itu harus menjalankan OpenSearch 1.0 atau yang lebih baru, atau Elasticsearch 7.4 atau yang lebih baru. Wastafel harus memiliki kebijakan akses yang memberikan izin yang sesuai untuk peran pipeline IAM Anda.

Untuk petunjuk untuk membuat sumber daya ini, lihat topik berikut:

catatan

Jika Anda menulis ke domain yang menggunakan kontrol akses berbutir halus, ada langkah-langkah tambahan yang perlu Anda selesaikan. Lihat Petakan peran pipeline (hanya untuk domain yang menggunakan kontrol akses berbutir halus).

Izin IAM yang diperlukan

OpenSearch Ingestion menggunakan izin IAM berikut untuk membuat pipeline:

-

osis:CreatePipeline— Buat pipa. -

osis:ValidatePipeline— Periksa apakah konfigurasi pipeline valid. -

iam:CreateRoledaniam:AttachPolicy— Have OpenSearch Ingestion secara otomatis membuat peran pipeline untuk Anda. -

iam:PassRole— Lewati peran pipeline ke OpenSearch Ingestion sehingga dapat menulis data ke domain. Izin ini harus ada pada sumber daya peran pipeline, atau hanya*jika Anda berencana untuk menggunakan peran yang berbeda di setiap pipeline.

Misalnya, kebijakan berikut memberikan izin untuk membuat pipeline:

OpenSearch Ingestion juga menyertakan izin yang dipanggilosis:Ingest, yang diperlukan untuk mengirim permintaan yang ditandatangani ke pipeline menggunakan Signature Version 4. Untuk informasi selengkapnya, lihat Membuat peran konsumsi.

catatan

Selain itu, pengguna pertama yang membuat pipeline di akun harus memiliki izin untuk iam:CreateServiceLinkedRole tindakan tersebut. Untuk informasi selengkapnya, lihat sumber daya peran pipeline.

Untuk informasi selengkapnya tentang setiap izin, lihat Tindakan, sumber daya, dan kunci kondisi untuk OpenSearch Tertelan di Referensi Otorisasi Layanan.

Menentukan versi pipeline

Saat Anda membuat pipeline menggunakan editor konfigurasi, Anda harus menentukan versi utama Data Prepperversion opsi dalam konfigurasi pipeline Anda:

version: "2"log-pipeline: source: ...

Saat Anda memilih Buat, OpenSearch Ingestion menentukan versi minor terbaru yang tersedia dari versi utama yang Anda tentukan, dan menyediakan pipeline dengan versi tersebut. Misalnya, jika Anda menentukanversion:

"2", dan versi terbaru yang didukung dari Data Prepper adalah 2.1.1, OpenSearch Ingestion menyediakan pipeline Anda dengan versi 2.1.1. Kami tidak menampilkan versi minor yang sedang dijalankan pipeline Anda secara publik.

Untuk meningkatkan pipeline Anda saat versi utama baru dari Data Prepper tersedia, edit konfigurasi pipeline dan tentukan versi baru. Anda tidak dapat menurunkan versi pipeline ke versi sebelumnya.

catatan

OpenSearch Ingestion tidak segera mendukung versi baru dari Data Prepper segera setelah dirilis. Akan ada beberapa jeda antara saat versi baru tersedia untuk umum dan saat didukung di OpenSearch Ingestion. Selain itu, OpenSearch Ingestion mungkin secara eksplisit tidak mendukung versi mayor atau minor tertentu sama sekali. Untuk daftar lengkap, lihatVersi Data Prepper yang Didukung.

Setiap kali Anda membuat perubahan pada pipeline yang memulai blue/green penerapan, OpenSearch Ingestion dapat memutakhirkannya ke versi minor terbaru dari versi utama yang saat ini dikonfigurasi untuk pipeline. Untuk informasi lebih lanjut, lihatPenerapan biru/hijau untuk pembaruan saluran pipa. OpenSearch Ingestion tidak dapat mengubah versi utama pipeline Anda kecuali Anda secara eksplisit memperbarui version opsi dalam konfigurasi pipeline.

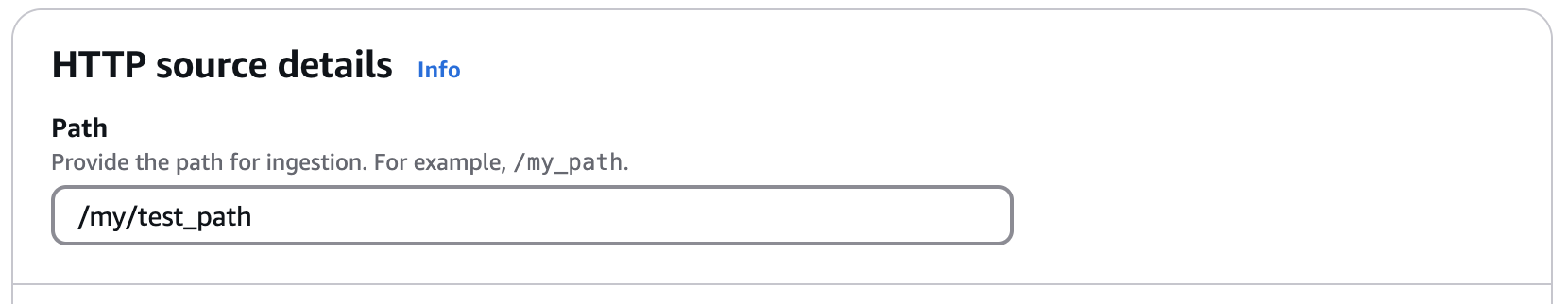

Menentukan jalur konsumsi

Untuk sumber berbasis tarik seperti OTel jejakpath opsi tambahan dalam konfigurasi sumber Anda. Path adalah string seperti/log/ingest, yang mewakili jalur URI untuk konsumsi. Path ini mendefinisikan URI yang Anda gunakan untuk mengirim data ke pipeline.

Misalnya, Anda menentukan jalur berikut untuk pipeline dengan sumber HTTP:

Saat Anda memasukkan data ke dalam pipeline, Anda harus menentukan titik akhir berikut dalam konfigurasi klien Anda:. https://pipeline-name-abc123.us-west-2.osis.amazonaws.com/my/test_path

Jalur harus dimulai dengan garis miring (/) dan dapat berisi karakter khusus '-', '_', ' . ', dan'/', serta ${pipelineName} placeholder. Jika Anda menggunakan ${pipelineName} (seperti/${pipelineName}/test_path), OpenSearch Ingestion menggantikan variabel dengan nama sub-pipeline terkait.

Membuat jaringan pipa

Bagian ini menjelaskan cara membuat pipeline OpenSearch Ingestion menggunakan konsol OpenSearch Layanan dan. AWS CLI

Untuk membuat pipeline, masuk ke konsol Amazon OpenSearch Service di https://console.aws.amazon.com/aos/rumah

Pilih pipeline kosong, atau pilih cetak biru konfigurasi. Cetak biru mencakup pipeline yang telah dikonfigurasi sebelumnya untuk berbagai kasus penggunaan umum. Untuk informasi selengkapnya, lihat Bekerja dengan cetak biru.

Pilih Pilih cetak biru.

Konfigurasikan sumber

-

Jika Anda memulai dari pipeline kosong, pilih sumber dari menu tarik-turun. Sumber yang tersedia mungkin termasuk lainnya Layanan AWS, OpenTelemetry, atau HTTP. Untuk informasi selengkapnya, lihat Mengintegrasikan saluran Amazon OpenSearch Ingestion dengan layanan dan aplikasi lain.

-

Bergantung pada sumber yang Anda pilih, konfigurasikan pengaturan tambahan untuk sumbernya. Misalnya, untuk menggunakan Amazon S3 sebagai sumber, Anda harus menentukan URL antrian Amazon SQS dari pipeline menerima pesan. Untuk daftar plugin sumber yang didukung dan tautan ke dokumentasinya, lihatPlugin dan opsi yang didukung untuk saluran Amazon OpenSearch Ingestion.

-

Untuk beberapa sumber, Anda harus menentukan opsi jaringan Sumber. Pilih akses VPC atau akses Publik. Jika Anda memilih Akses publik, lewati ke langkah berikutnya. Jika Anda memilih akses VPC, konfigurasikan pengaturan berikut:

Pengaturan Deskripsi Manajemen titik akhir Pilih apakah Anda ingin membuat titik akhir virtual private cloud (VPC) sendiri, atau minta OpenSearch Ingestion membuatnya untuk Anda. Manajemen endpoint default ke endpoint yang dikelola oleh Ingestion. OpenSearch

VPC Pilih ID VPC yang ingin Anda gunakan. VPC dan pipeline harus sama. Wilayah AWS

Subnet Pilih satu atau lebih subnet. OpenSearch Layanan akan menempatkan titik akhir VPC dan antarmuka jaringan elastis di subnet.

Grup keamanan Pilih satu atau beberapa grup keamanan VPC yang memungkinkan aplikasi Anda mencapai pipeline OpenSearch Ingestion pada port (80 atau 443) dan protokol (HTTP atau) yang diekspos oleh pipeline. HTTPs

Opsi lampiran VPC Jika sumber Anda adalah titik akhir yang dikelola sendiri, lampirkan pipeline Anda ke VPC. Pilih salah satu opsi CIDR default yang disediakan, atau gunakan CIDR khusus.

Untuk informasi selengkapnya, lihat Mengkonfigurasi akses VPC untuk saluran pipa Amazon Ingestion OpenSearch .

-

Pilih Berikutnya.

Konfigurasikan prosesor

Tambahkan satu atau beberapa prosesor ke pipeline Anda. Prosesor adalah komponen dalam sub-pipeline yang memungkinkan Anda memfilter, mengubah, dan memperkaya peristiwa sebelum menerbitkan catatan ke domain atau sink koleksi. Untuk daftar prosesor yang didukung dan tautan ke dokumentasinya, lihatPlugin dan opsi yang didukung untuk saluran Amazon OpenSearch Ingestion.

Anda dapat memilih Tindakan dan menambahkan yang berikut:

-

Perutean bersyarat - Merutekan peristiwa ke sink yang berbeda berdasarkan kondisi tertentu. Untuk informasi selengkapnya, lihat Perutean bersyarat

. -

Sub-pipa - Setiap sub-pipa adalah kombinasi dari satu sumber, nol atau lebih prosesor, dan satu wastafel. Hanya satu sub-pipeline yang dapat memiliki sumber eksternal. Semua yang lain harus memiliki sumber yang merupakan sub-pipeline lain dalam konfigurasi pipa keseluruhan. Konfigurasi pipa tunggal dapat berisi 1-10 sub-pipeline.

Pilih Berikutnya.

Konfigurasikan wastafel

Pilih tujuan di mana pipeline menerbitkan catatan. Setiap sub-pipa harus berisi setidaknya satu wastafel. Anda dapat menambahkan maksimal 10 sink ke pipa.

Untuk OpenSearch sink, konfigurasikan bidang berikut:

| Pengaturan | Deskripsi |

|---|---|

| Nama kebijakan jaringan (Hanya wastafel tanpa server) |

Jika Anda memilih koleksi OpenSearch Tanpa Server, masukkan nama kebijakan Jaringan. OpenSearch Ingestion membuat kebijakan jika tidak ada, atau memperbaruinya dengan aturan yang memberikan akses ke titik akhir VPC yang menghubungkan pipeline dan koleksi. Untuk informasi selengkapnya, lihat Memberikan akses saluran pipa Amazon OpenSearch Ingestion ke koleksi. |

| Nama indeks |

Nama indeks tempat pipa mengirimkan data. OpenSearch Ingestion membuat indeks ini jika belum ada. |

| Opsi pemetaan indeks |

Pilih bagaimana pipa menyimpan dan mengindeks dokumen dan bidangnya ke OpenSearch wastafel. Jika Anda memilih Pemetaan dinamis, OpenSearch tambahkan bidang secara otomatis saat Anda mengindeks dokumen. Jika Anda memilih Sesuaikan pemetaan, masukkan templat pemetaan indeks. Untuk informasi selengkapnya, lihat Templat indeks |

| Aktifkan DLQ |

Konfigurasikan antrian surat mati Amazon S3 (DLQ) untuk pipeline. Untuk informasi selengkapnya, lihat Antrean surat mati. |

| Pengaturan tambahan |

Konfigurasikan opsi lanjutan untuk OpenSearch wastafel. Untuk informasi selengkapnya, lihat Opsi konfigurasi |

Untuk menambahkan wastafel Amazon S3, pilih Tambahkan wastafel dan Amazon S3. Untuk informasi selengkapnya, lihat Amazon S3 sebagai tujuan.

Pilih Berikutnya.

Konfigurasikan pipa

Konfigurasikan pengaturan pipa tambahan berikut:

| Pengaturan | Deskripsi |

|---|---|

| Nama pipa |

Nama unik untuk pipa. |

| Buffer persisten |

Buffer persisten menyimpan data Anda dalam buffer berbasis disk di beberapa Availability Zone. Untuk informasi selengkapnya, lihat Buffering persisten. Jika Anda mengaktifkan buffering persisten, pilih AWS Key Management Service kunci untuk mengenkripsi data buffer. |

| Kapasitas pipa |

Kapasitas pipa minimum dan maksimum, dalam Unit OpenSearch Komputasi Tertelan (). OCUs Untuk informasi selengkapnya, lihat Menskalakan jaringan pipa di Amazon Ingestion OpenSearch . |

| Peran pipa |

Peran IAM yang memberikan izin yang diperlukan untuk pipa untuk menulis ke wastafel dan membaca dari sumber berbasis tarik. Anda dapat membuat peran sendiri, atau meminta OpenSearch Ingestion membuatnya untuk Anda berdasarkan kasus penggunaan yang Anda pilih. Untuk informasi selengkapnya, lihat Menyiapkan peran dan pengguna di Amazon OpenSearch Ingestion. |

| Tanda |

Tambahkan satu atau beberapa tag ke pipeline Anda. Untuk informasi selengkapnya, lihat Menandai saluran pipa Amazon OpenSearch Ingestion. |

| Opsi penerbitan log | Aktifkan penerbitan log pipeline ke Amazon CloudWatch Logs. Kami menyarankan Anda mengaktifkan penerbitan log sehingga Anda dapat lebih mudah memecahkan masalah pipeline. Untuk informasi selengkapnya, lihat Memantau log pipa. |

Pilih Berikutnya., lalu tinjau konfigurasi pipeline Anda dan pilih Buat pipeline.

OpenSearch Ingestion menjalankan proses asinkron untuk membangun pipeline. Setelah status pipelineActive, Anda dapat mulai menelan data.

Perintah create-pipeline menerima konfigurasi pipeline sebagai string atau dalam file.yaml atau .json. Jika Anda memberikan konfigurasi sebagai string, setiap baris baru harus diloloskan. \n Sebagai contoh, "log-pipeline:\n source:\n

http:\n processor:\n - grok:\n ....

Perintah contoh berikut membuat pipeline dengan konfigurasi berikut:

-

Minimal 4 Tertelan OCUs, maksimal 10 Tertelan OCUs

-

Disediakan dalam virtual private cloud (VPC)

-

Penerbitan log diaktifkan

aws osis create-pipeline \ --pipeline-namemy-pipeline\ --min-units 4 \ --max-units 10 \ --log-publishing-options IsLoggingEnabled=true,CloudWatchLogDestination={LogGroup="MyLogGroup"} \ --vpc-options SecurityGroupIds={sg-12345678,sg-9012345},SubnetIds=subnet-1212234567834asdf\ --pipeline-configuration-body "file://pipeline-config.yaml" \ --pipeline-role-arn arn:aws:iam::1234456789012:role/pipeline-role

OpenSearch Ingestion menjalankan proses asinkron untuk membangun pipeline. Setelah status pipelineActive, Anda dapat mulai menelan data. Untuk memeriksa status pipa, gunakan GetPipelineperintah.

Untuk membuat pipeline OpenSearch Ingestion menggunakan API OpenSearch Ingestion, panggil operasi. CreatePipeline

Setelah pipeline berhasil dibuat, Anda dapat mengonfigurasi klien dan mulai memasukkan data ke dalam domain OpenSearch Layanan. Untuk informasi selengkapnya, lihat Mengintegrasikan saluran Amazon OpenSearch Ingestion dengan layanan dan aplikasi lain.

Melacak status pembuatan pipa

Anda dapat melacak status pipa saat OpenSearch Ingestion menyediakannya dan menyiapkannya untuk menyerap data.

Setelah Anda awalnya membuat pipeline, ia melewati beberapa tahap saat OpenSearch Ingestion mempersiapkannya untuk menelan data. Untuk melihat berbagai tahapan pembuatan pipeline, pilih nama pipeline untuk melihat halaman pengaturan Pipeline. Di bawah Status, pilih Lihat detail.

Pipeline melewati tahapan berikut sebelum tersedia untuk menelan data:

-

Validasi - Memvalidasi konfigurasi pipeline. Ketika tahap ini selesai, semua validasi telah berhasil.

-

Menciptakan lingkungan — Mempersiapkan dan menyediakan sumber daya. Ketika tahap ini selesai, lingkungan pipa baru telah dibuat.

-

Menyebarkan pipa - Menyebarkan pipa. Ketika tahap ini selesai, pipa telah berhasil digunakan.

-

Periksa kesehatan pipa — Memeriksa kesehatan pipa. Ketika tahap ini selesai, semua pemeriksaan kesehatan telah berlalu.

-

Aktifkan lalu lintas - Mengaktifkan pipeline untuk menyerap data. Ketika tahap ini selesai, Anda dapat mulai menelan data ke dalam pipa.

Gunakan get-pipeline-change-progressperintah untuk memeriksa status pipa. AWS CLI Permintaan berikut memeriksa status pipeline bernamamy-pipeline:

aws osis get-pipeline-change-progress \ --pipeline-namemy-pipeline

Tanggapan:

{ "ChangeProgressStatuses": { "ChangeProgressStages": [ { "Description": "Validating pipeline configuration", "LastUpdated": 1.671055851E9, "Name": "VALIDATION", "Status": "PENDING" } ], "StartTime": 1.671055851E9, "Status": "PROCESSING", "TotalNumberOfStages": 5 } }

Untuk melacak status pembuatan pipeline menggunakan API OpenSearch Ingestion, hubungi operasi. GetPipelineChangeProgress