Terjemahan disediakan oleh mesin penerjemah. Jika konten terjemahan yang diberikan bertentangan dengan versi bahasa Inggris aslinya, utamakan versi bahasa Inggris.

Sempurnakan Model

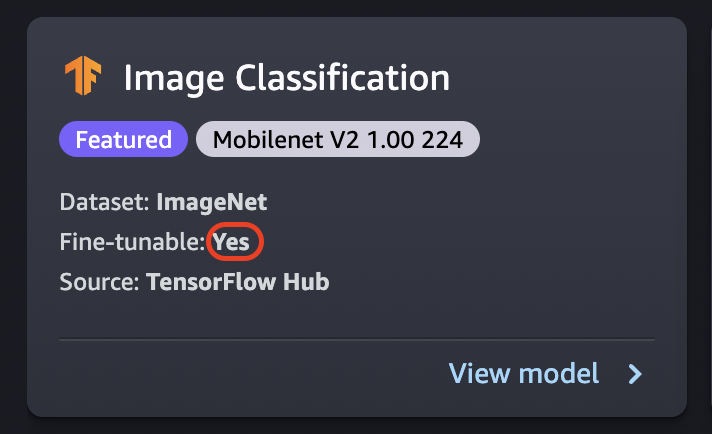

Fine-tuning melatih model yang telah dilatih sebelumnya pada dataset baru tanpa pelatihan dari awal. Proses ini, juga dikenal sebagai pembelajaran transfer, dapat menghasilkan model yang akurat dengan kumpulan data yang lebih kecil dan waktu pelatihan yang lebih sedikit. Anda dapat menyempurnakan model jika kartunya menunjukkan atribut fine-tunable yang disetel ke Yes.

penting

Pada 30 November 2023, pengalaman Amazon SageMaker Studio sebelumnya sekarang bernama Amazon SageMaker Studio Classic. Bagian berikut khusus untuk menggunakan aplikasi Studio Classic. Untuk informasi tentang menggunakan pengalaman Studio yang diperbarui, lihat SageMaker Studio Amazon.

catatan

Untuk informasi selengkapnya tentang fine-tuning JumpStart model di Studio, lihat Sempurnakan model pondasi di Studio

Sumber data Fine-Tuning

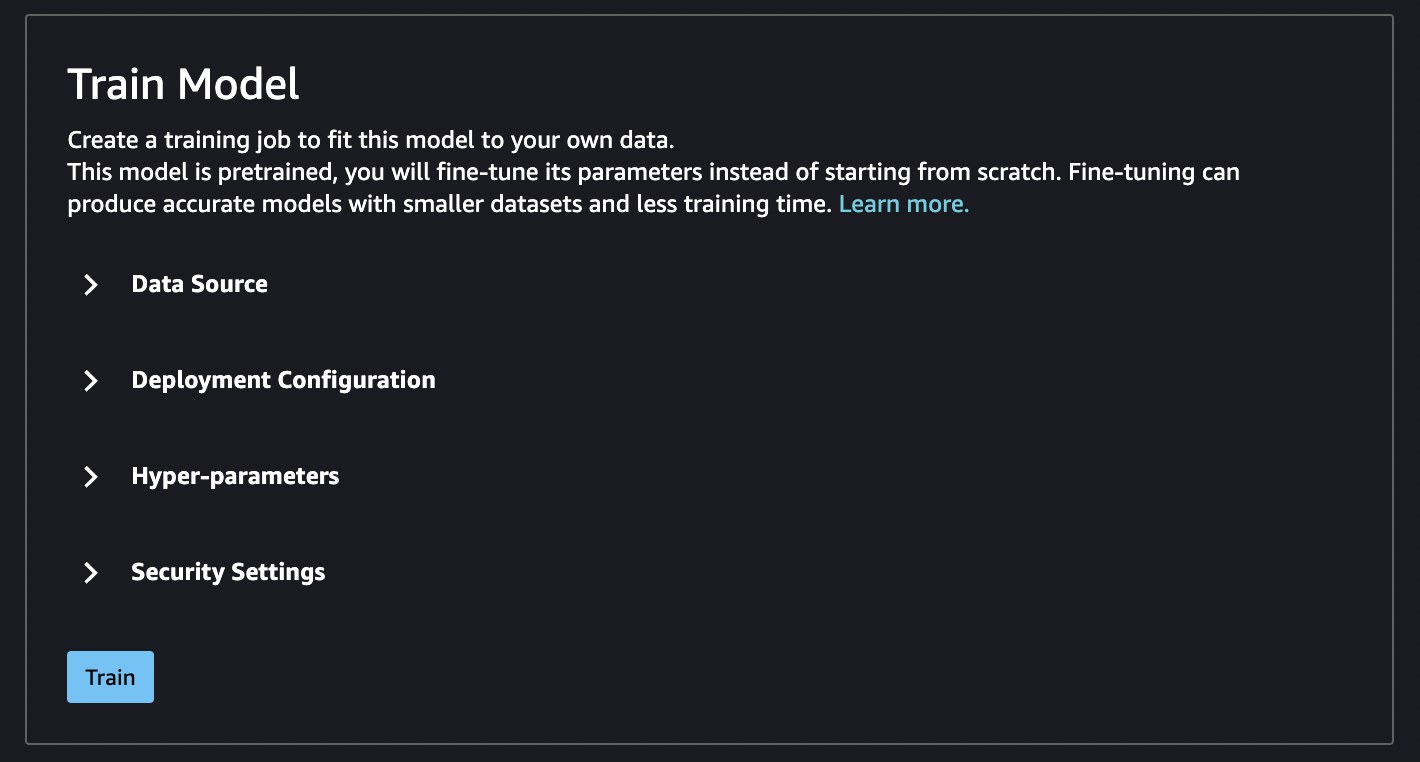

Saat menyempurnakan model, Anda dapat menggunakan kumpulan data default atau memilih data Anda sendiri, yang terletak di bucket Amazon S3.

Untuk menelusuri bucket yang tersedia untuk Anda, pilih bucket Find S3. Bucket ini dibatasi oleh izin yang digunakan untuk menyiapkan akun Studio Classic Anda. Anda juga dapat menentukan URI Amazon S3 dengan memilih Masukkan lokasi bucket Amazon S3.

Tip

Untuk mengetahui cara memformat data di bucket, pilih Pelajari lebih lanjut. Bagian deskripsi untuk model memiliki informasi rinci tentang input dan output.

Untuk model teks:

-

Bucket harus memiliki file data.csv.

-

Kolom pertama harus berupa bilangan bulat unik untuk label kelas. Misalnya:

1,2,3,4,n -

Kolom kedua harus berupa string.

-

Kolom kedua harus memiliki teks yang sesuai yang cocok dengan jenis dan bahasa untuk model.

Untuk model visi:

-

Bucket harus memiliki subdirektori sebanyak jumlah kelas.

-

Setiap subdirektori harus berisi gambar yang termasuk dalam kelas itu dalam format.jpg.

catatan

Bucket Amazon S3 harus sama dengan Wilayah AWS tempat Anda menjalankan SageMaker Studio Classic karena SageMaker tidak mengizinkan permintaan Lintas wilayah.

Konfigurasi penyebaran Fine-Tuning

Keluarga p3 direkomendasikan sebagai yang tercepat untuk pelatihan pembelajaran mendalam, dan ini direkomendasikan untuk menyempurnakan model. Bagan berikut menunjukkan jumlah GPU di setiap jenis instance. Ada opsi lain yang tersedia yang dapat Anda pilih, termasuk jenis instans p2 dan g4.

| Jenis instans | GPU |

| p3.2xlarge | 1 |

| p3.8xlarge | 4 |

| p3.16xlarge | 8 |

| p3dn.24xlarge | 8 |

Hyperparameter

Anda dapat menyesuaikan hyperparameters dari pekerjaan pelatihan yang digunakan untuk menyempurnakan model. Hiperparameter yang tersedia untuk setiap model yang dapat disetel berbeda tergantung pada modelnya. Untuk informasi tentang setiap hyperparameter yang tersedia, rujuk dokumentasi hyperparameters untuk model yang Anda pilih. Gunakan Algoritma SageMaker Bawaan Amazon atau Model Pra-terlatih Misalnya, lihat Klasifikasi Gambar - TensorFlow Hyperparameters detail tentang Klasifikasi Gambar yang dapat disetel dengan baik - hiperparameter. TensorFlow

Jika Anda menggunakan dataset default untuk model teks tanpa mengubah hyperparameters, Anda mendapatkan model yang hampir identik sebagai hasilnya. Untuk model visi, kumpulan data default berbeda dari kumpulan data yang digunakan untuk melatih model yang telah dilatih sebelumnya, sehingga model Anda berbeda sebagai hasilnya.

Hyperparameter berikut umum di antara model:

-

Epoch — Satu epoch adalah satu siklus melalui seluruh dataset. Beberapa interval menyelesaikan batch, dan beberapa batch akhirnya menyelesaikan sebuah epoch. Beberapa zaman dijalankan hingga keakuratan model mencapai tingkat yang dapat diterima, atau ketika tingkat kesalahan turun di bawah tingkat yang dapat diterima.

-

Laju belajar — Jumlah nilai yang harus diubah antar zaman. Saat model disempurnakan, bobot internalnya didorong dan tingkat kesalahan diperiksa untuk melihat apakah model membaik. Tingkat pembelajaran tipikal adalah 0,1 atau 0,01, di mana 0,01 adalah penyesuaian yang jauh lebih kecil dan dapat menyebabkan pelatihan memakan waktu lama untuk bertemu, sedangkan 0,1 jauh lebih besar dan dapat menyebabkan pelatihan melampaui batas. Ini adalah salah satu hiperparameter utama yang mungkin Anda sesuaikan untuk melatih model Anda. Perhatikan bahwa untuk model teks, tingkat pembelajaran yang jauh lebih kecil (5e-5 untuk BERT) dapat menghasilkan model yang lebih akurat.

-

Ukuran Batch — Jumlah catatan dari kumpulan data yang akan dipilih untuk setiap interval untuk dikirim ke GPU untuk pelatihan.

Dalam contoh gambar, Anda mungkin mengirimkan 32 gambar per GPU, jadi 32 akan menjadi ukuran batch Anda. Jika Anda memilih jenis instans dengan lebih dari satu GPU, batch dibagi dengan jumlah GPU. Ukuran batch yang disarankan bervariasi tergantung pada data dan model yang Anda gunakan. Misalnya, cara Anda mengoptimalkan data gambar berbeda dari cara Anda menangani data bahasa.

Pada bagan tipe instans di bagian konfigurasi penerapan, Anda dapat melihat jumlah GPU per jenis instans. Mulailah dengan ukuran batch standar yang direkomendasikan (misalnya, 32 untuk model visi). Kemudian, kalikan ini dengan jumlah GPU dalam jenis instance yang Anda pilih. Misalnya, jika Anda menggunakan a

p3.8xlarge, ini akan menjadi 32 (ukuran batch) dikalikan dengan 4 (GPU), dengan total 128, karena ukuran batch Anda menyesuaikan dengan jumlah GPU. Untuk model teks seperti BERT, coba mulai dengan ukuran batch 64, dan kemudian kurangi sesuai kebutuhan.

Output pelatihan

Ketika proses fine-tuning selesai, JumpStart berikan informasi tentang model: model induk, nama pekerjaan pelatihan, ARN pekerjaan pelatihan, waktu pelatihan, dan jalur keluaran. Jalur keluaran adalah tempat Anda dapat menemukan model baru Anda di bucket Amazon S3. Struktur folder menggunakan nama model yang Anda berikan dan file model ada di /output subfolder dan selalu diberi namamodel.tar.gz.

Contoh: s3://bucket/model-name/output/model.tar.gz

Konfigurasikan nilai default untuk pelatihan model

Anda dapat mengonfigurasi nilai default untuk parameter seperti peran IAM, VPC, dan kunci KMS untuk diisi sebelumnya untuk penerapan dan pelatihan model. JumpStart Untuk informasi selengkapnya, lihat, Konfigurasikan nilai default untuk JumpStart model.