Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Addestra il tuo primo DeepRacer modello AWS

Questa procedura dettagliata dimostra come addestrare il tuo primo modello utilizzando la console AWS. DeepRacer

Addestra un modello di reinforcement learning utilizzando la console AWS DeepRacer

Scopri dove trovare il pulsante Crea modello nella DeepRacer console AWS per iniziare il percorso di formazione dei modelli.

Per addestrare un modello di apprendimento per rinforzo

-

Se è la prima volta che usi AWS DeepRacer, scegli Create model dalla landing page del servizio o seleziona Get started sotto l'intestazione Reinforcement learning nel pannello di navigazione principale.

-

Nella pagina Guida introduttiva all'apprendimento per rinforzo, in Fase 2: Creazione di un modello, scegli Crea modello.

In alternativa, scegli I tuoi modelli sotto l'intestazione Reinforcement learning dal pannello di navigazione principale. Nella pagina I tuoi modelli, scegli Crea modello.

Specificate il nome e l'ambiente del modello

Assegna un nome al tuo modello e scopri come scegliere la traccia di simulazione più adatta a te.

Per specificare il nome e l'ambiente del modello

-

Nella pagina Crea modello, in Dettagli di addestramento, inserisci un nome per il tuo modello.

-

Facoltativamente, aggiungi una descrizione del lavoro di formazione.

-

Per ulteriori informazioni sull'aggiunta di tag opzionali, consultaAssegnazione di tag.

-

In Simulazione ambientale, scegli un percorso da utilizzare come ambiente di formazione per il tuo DeepRacer agente AWS. In Direzione della traccia, scegli in senso orario o antiorario. Quindi, seleziona Next (Successivo).

Per la tua prima corsa, scegli una pista con una forma semplice e curve fluide. Nelle successive iterazioni, è possibile scegliere piste più complesse per migliorare progressivamente i modelli. Per addestrare un modello per una determinata corsa, scegliere la pista più simile a quella dell'evento.

-

Scegli Avanti nella parte inferiore della pagina.

Scegli un tipo di gara e un algoritmo di allenamento

La DeepRacer console AWS ha tre tipi di gara e due algoritmi di addestramento tra cui scegliere. Scopri quali sono quelli più adatti al tuo livello di abilità e ai tuoi obiettivi di allenamento.

Per scegliere il tipo di gara e l'algoritmo di allenamento

-

Nella pagina Crea modello, in Tipo di gara, seleziona Cronometro, Evitare oggetti o H. ead-to-bot

Per la tua prima corsa, ti consigliamo di scegliere la prova a tempo. Per indicazioni su come ottimizzare la configurazione dei sensori del vostro agente per questo tipo di gara, consultatePersonalizza la DeepRacer formazione AWS per le prove a tempo.

-

Facoltativamente, nelle corse successive, scegli Evitare oggetti per aggirare gli ostacoli fissi posizionati in punti fissi o casuali lungo il percorso scelto. Per ulteriori informazioni, consulta Personalizza la DeepRacer formazione AWS per le gare di evitamento degli oggetti.

-

Scegli Posizione fissa per generare riquadri in posizioni fisse designate dall'utente sulle due corsie del tracciato o seleziona Posizione casuale per generare oggetti distribuiti casualmente sulle due corsie all'inizio di ogni episodio della simulazione di allenamento.

-

Quindi, scegli un valore per il Numero di oggetti su una traccia.

-

Se hai scelto Posizione fissa, puoi regolare la posizione di ciascun oggetto sulla traccia. Per Posizionamento della corsia, scegli tra la corsia interna e la corsia esterna. Per impostazione predefinita, gli oggetti sono distribuiti uniformemente sulla pista. Per modificare la distanza tra la linea di partenza e quella di arrivo di un oggetto, inserite una percentuale di tale distanza compresa tra sette e 90 nel campo Posizione (%) tra inizio e fine.

-

-

Opzionalmente, per gare più ambiziose, scegli di Head-to-bot gareggiare contro un massimo di quattro veicoli robot che si muovono a velocità costante. Per ulteriori informazioni, consulta DeepRacer Addestramento AWS personalizzato per le gare head-to-bot.

-

In Scegli il numero di veicoli bot, seleziona con quanti robot vuoi che il tuo agente addestra.

-

Quindi, scegli la velocità in millimetri al secondo alla quale desideri che i veicoli bot percorrano la pista.

-

Facoltativamente, seleziona la casella Abilita il cambio di corsia per dare ai veicoli bot la possibilità di cambiare corsia in modo casuale ogni 1-5 secondi.

-

-

In Algoritmo di addestramento e iperparametri, scegli l'algoritmo Soft Actor Critic (SAC) o Proximal Policy Optimization (PPO). Nella DeepRacer console AWS, i modelli SAC devono essere addestrati in spazi di azione continua. I modelli PPO possono essere addestrati in spazi di azione continui o discreti.

-

In Algoritmo di addestramento e iperparametri, utilizza i valori degli iperparametri predefiniti così come sono.

In seguito, per migliorare le prestazioni di addestramento, espandere Hyperparameters (Iperparametri) e modificare i valori degli iperparametri predefiniti come segue:

-

Per Gradient descent batch size (Dimensioni del batch per la discesa del gradiente), scegliere le opzioni disponibili.

-

Per Number of epochs (Numero di epoch), impostare un valore valido.

-

For Learning rate (Velocità di apprendimento), impostare un valore valido.

-

Per il valore alfa SAC (solo algoritmo SAC), impostate un valore valido.

-

Per Entropy (Entropia), impostare un valore valido.

-

Per Discount factor (Fattore sconto), impostare un valore valido.

-

Per Loss type (Tipo di perdita), scegliere le opzioni disponibili.

-

Per Number of experience episodes between each policy-updating iteration (Numero di episodi di esperienza tra ciascuna iterazione di aggiornamento della policy), impostare un valore valido.

Per ulteriori informazioni sugli iperparametri, consultare Ottimizza sistematicamente gli iperparametri.

-

-

Scegli Next (Successivo).

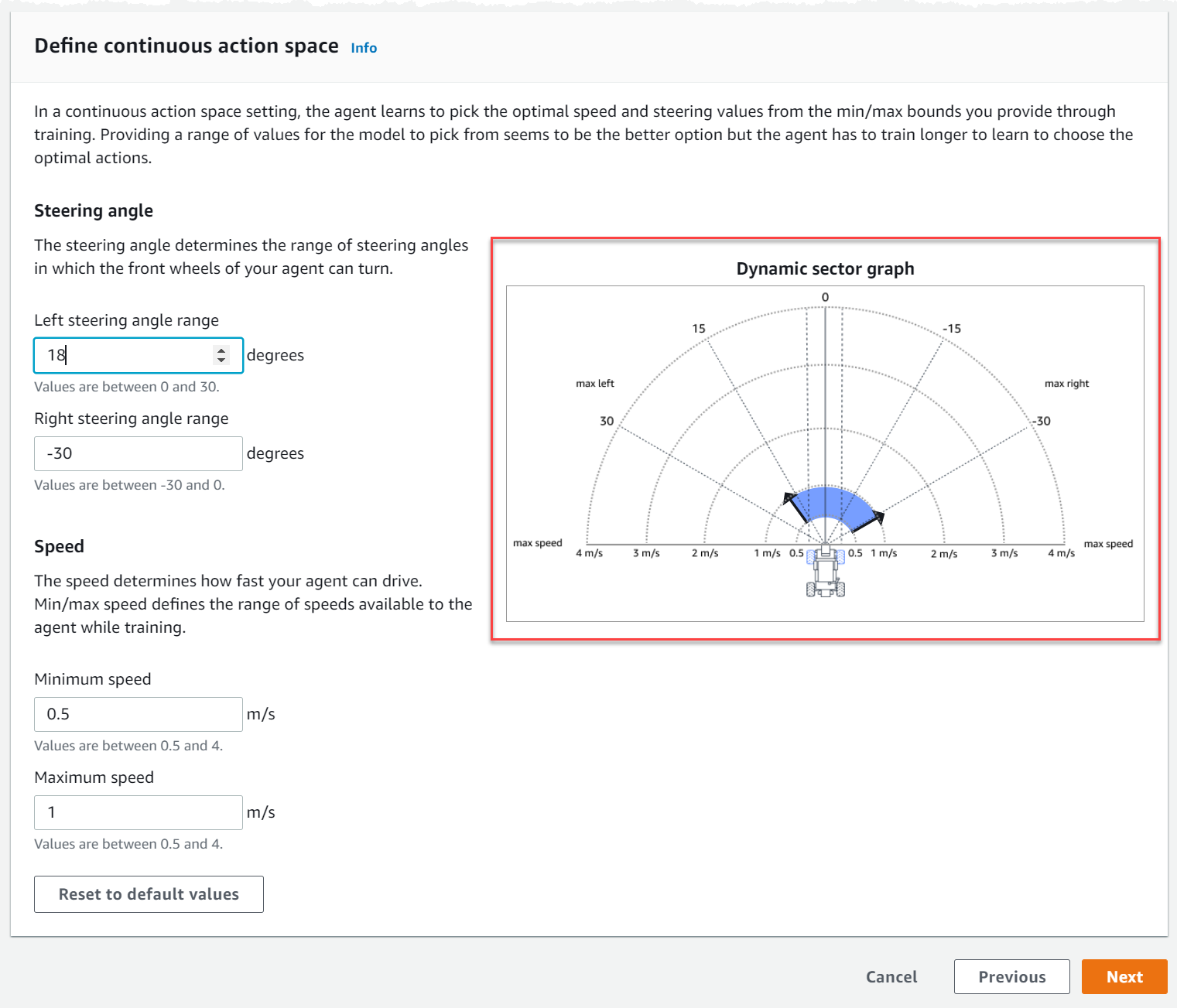

Definisci lo spazio d'azione

Nella pagina Definisci lo spazio d'azione, se hai scelto di allenarti con l'algoritmo Soft Actor Critic (SAC), lo spazio d'azione predefinito è lo spazio di azione continuo. Se hai scelto di allenarti con l'algoritmo Proximal Policy Optimization (PPO), scegli tra Spazio d'azione continuo e Spazio d'azione discreto. Per saperne di più su come ogni spazio di azione e algoritmo modella l'esperienza di formazione dell'agente, consulta. Spazio DeepRacer d'azione AWS e funzione di ricompensa

-

In Definisci lo spazio di azione continuo, scegli i gradi dell'intervallo dell'angolo di sterzata sinistro e dell'intervallo dell'angolo di sterzata destro.

Prova a inserire gradi diversi per ogni intervallo dell'angolo di sterzata e osserva come la visualizzazione dell'intervallo cambia per rappresentare le tue scelte sul grafico a settore dinamico.

-

In Speed, inserisci una velocità minima e massima per il tuo agente in millimetri al secondo.

Notate come le vostre modifiche si riflettono nel grafico a settore dinamico.

-

Facoltativamente, scegliete Ripristina valori predefiniti per cancellare i valori indesiderati. Ti consigliamo di provare diversi valori sul grafico per sperimentare e imparare.

-

Scegli Next (Successivo).

-

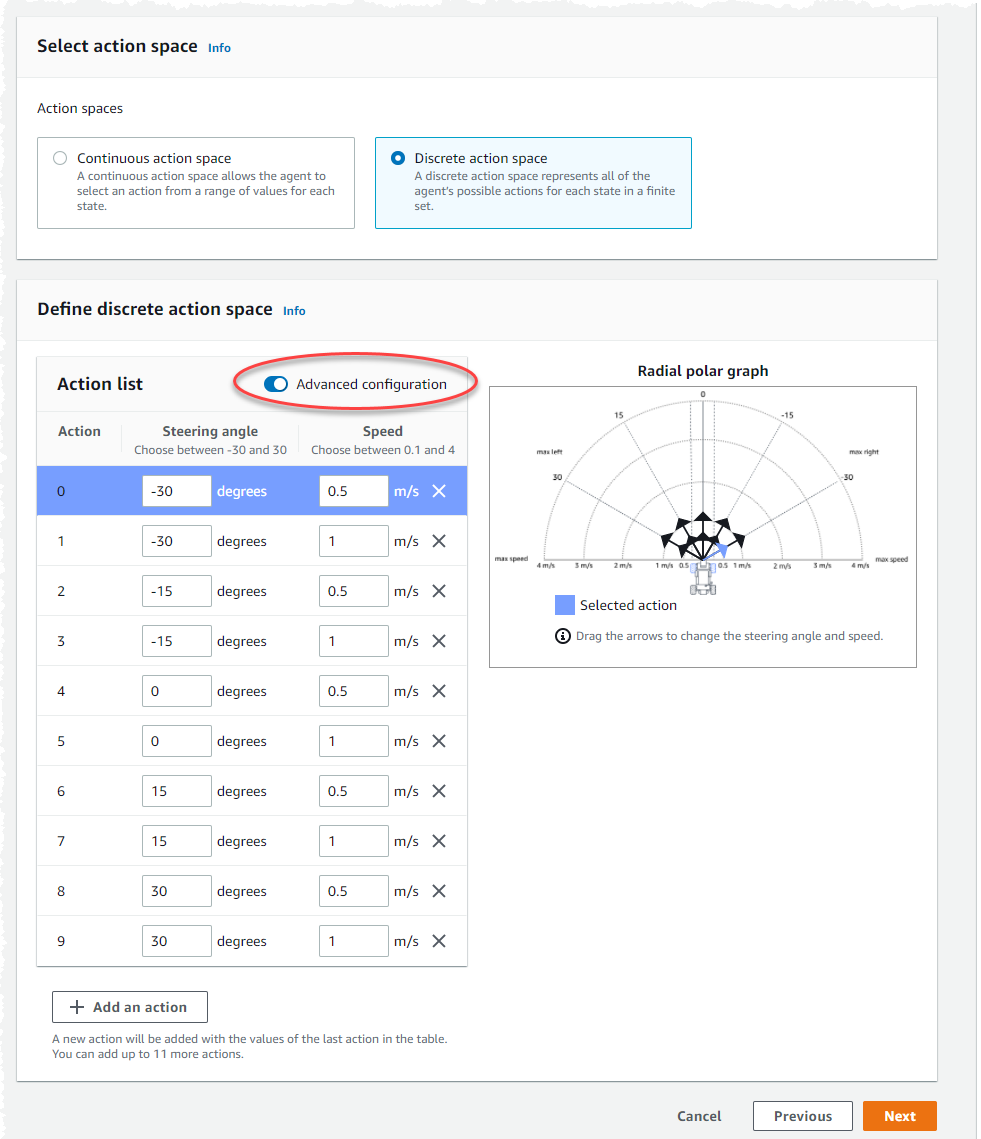

Scegliete un valore per la granularità dell'angolo di sterzo dall'elenco a discesa.

-

Scegli un valore in gradi compreso tra 1 e 30 per l'angolo di sterzata massimo del tuo agente.

-

Scegli un valore per la granularità della velocità dall'elenco a discesa.

-

Scegli un valore in millimetri al secondo compreso tra 0,1-4 per la velocità massima del tuo agente.

-

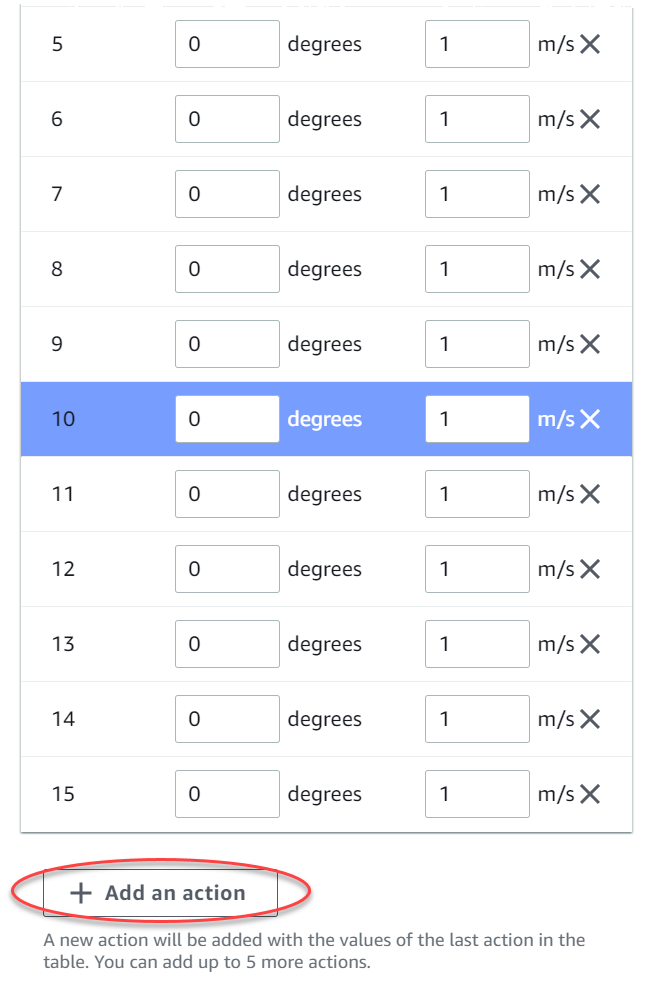

Utilizza le impostazioni di azione predefinite nell'elenco Azioni o, facoltativamente, attiva la configurazione avanzata per ottimizzare le impostazioni. Se scegli Precedente o disattivi la Configurazione avanzata dopo aver regolato i valori, perderai le modifiche.

-

Immettete un valore in gradi compreso tra -30 e 30 nella colonna Angolo di sterzo.

-

Immettete un valore compreso tra 0,1 e 4 in millimetri al secondo per un massimo di nove azioni nella colonna Velocità.

-

Facoltativamente, seleziona Aggiungi un'azione per aumentare il numero di righe nell'elenco delle azioni.

-

Facoltativamente, seleziona X su una riga per rimuoverla.

-

-

Scegli Next (Successivo).

Scegli un'auto virtuale

Scopri come iniziare a usare le auto virtuali. Guadagna nuove auto personalizzate, verniciature e modifiche gareggiando ogni mese nella Open Division.

Per scegliere un'auto virtuale

-

Nella pagina Scegli la configurazione della scocca del veicolo e del sensore, scegli una scocca compatibile con il tuo tipo di gara e lo spazio di azione. Se nel tuo garage non hai un'auto che corrisponda allo stesso modello, vai alla sezione Il mio garage sotto la rubrica Apprendimento per rinforzo nel pannello di navigazione principale per crearne una.

Per l'allenamento a cronometro, ti bastano la configurazione predefinita dei sensori e la fotocamera a obiettivo singolo di The Original DeepRacer, ma tutte le altre configurazioni di gusci e sensori funzionano a condizione che lo spazio d'azione corrisponda. Per ulteriori informazioni, consulta Personalizza la DeepRacer formazione AWS per le prove a tempo.

Per l'addestramento alla prevenzione degli oggetti, le telecamere stereo sono utili, ma è possibile utilizzare anche una singola telecamera per evitare ostacoli fissi in posizioni fisse. Un sensore LiDAR è opzionale. Per informazioni, consulta Spazio DeepRacer d'azione AWS e funzione di ricompensa.

Per l'ead-to-botallenamento H, oltre a una singola telecamera o a una telecamera stereo, un'unità LiDAR è ottimale per rilevare ed evitare punti ciechi mentre sorpassano altri veicoli in movimento. Per ulteriori informazioni, consulta DeepRacer Addestramento AWS personalizzato per le gare head-to-bot.

-

Scegli Next (Successivo).

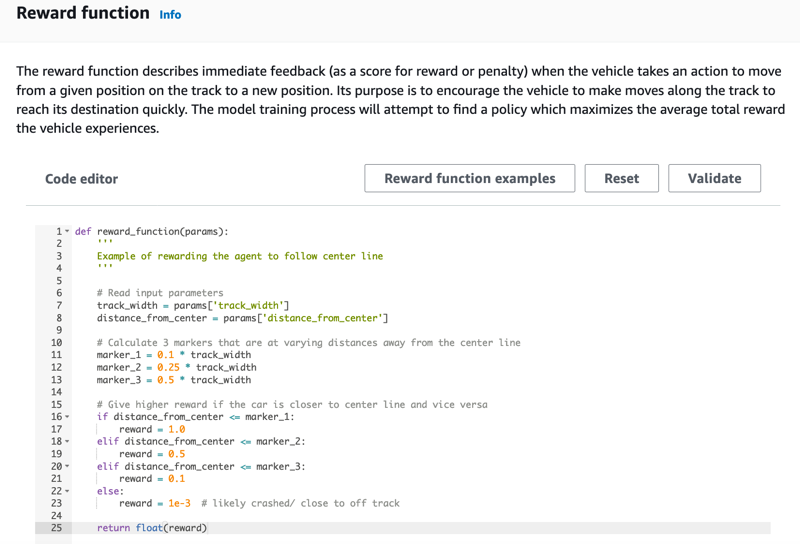

Personalizza la tua funzione di ricompensa

La funzione di ricompensa è alla base dell'apprendimento per rinforzo. Impara a usarla per incentivare la tua auto (agente) a intraprendere azioni specifiche mentre esplora la pista (ambiente). Ad esempio incoraggiando e scoraggiando determinati comportamenti in un animale domestico, puoi usare questo strumento per incoraggiare la tua auto a finire un giro il più velocemente possibile e scoraggiarla dall'uscire di pista o entrare in collisione con oggetti.

Per personalizzare la funzione di ricompensa

-

Nella pagina Create model (Crea modello) in Reward function (Funzione ricompensa), utilizzare l'esempio di funzione ricompensa predefinita così com'è per il primo modello.

Successivamente, è possibile scegliere Reward function examples (Esempi di funzioni ricompensa) per selezionare un'altra funzione di esempio e quindi scegliere Use code (Usa codice) per accettare la funzione di ricompensa selezionata.

Esistono quattro funzioni di esempio con cui puoi iniziare. Illustrano come seguire il centro della pista (impostazione predefinita), come mantenere l'agente all'interno dei bordi dei binari, come evitare la guida a zig-zag e come evitare di schiantarsi contro ostacoli fermi o altri veicoli in movimento.

Per ulteriori informazioni sulla funzione di ricompensa, consulta Riferimento alla funzione di DeepRacer ricompensa AWS.

-

In condizioni di stop, lasciate invariato il valore predefinito del tempo massimo oppure impostate un nuovo valore per terminare il processo di addestramento, in modo da evitare che i lavori di formazione durino a lungo (e che possano andare via).

Nella fase iniziale dell'addestramento, è consigliabile iniziare impostando un valore di parametro basso, quindi allungare gradualmente il tempo di addestramento.

-

In Invia automaticamente ad AWS DeepRacer, l'opzione Invia DeepRacer automaticamente questo modello all'AWS dopo il completamento della formazione e ottieni la possibilità di vincere premi è selezionata per impostazione predefinita. Facoltativamente, puoi scegliere di non inserire il tuo modello selezionando il segno di spunta.

-

Nella sezione Requisiti del campionato, seleziona il tuo Paese di residenza e accetta i termini e le condizioni selezionando la casella.

-

Scegli Crea modello per iniziare a creare il modello e a fornire l'istanza del job di formazione.

-

Dopo l'invio, osserva l'inizializzazione del lavoro di addestramento, quindi l'esecuzione.

Il processo di inizializzazione richiede alcuni minuti per passare da Inizializzazione a In corso.

-

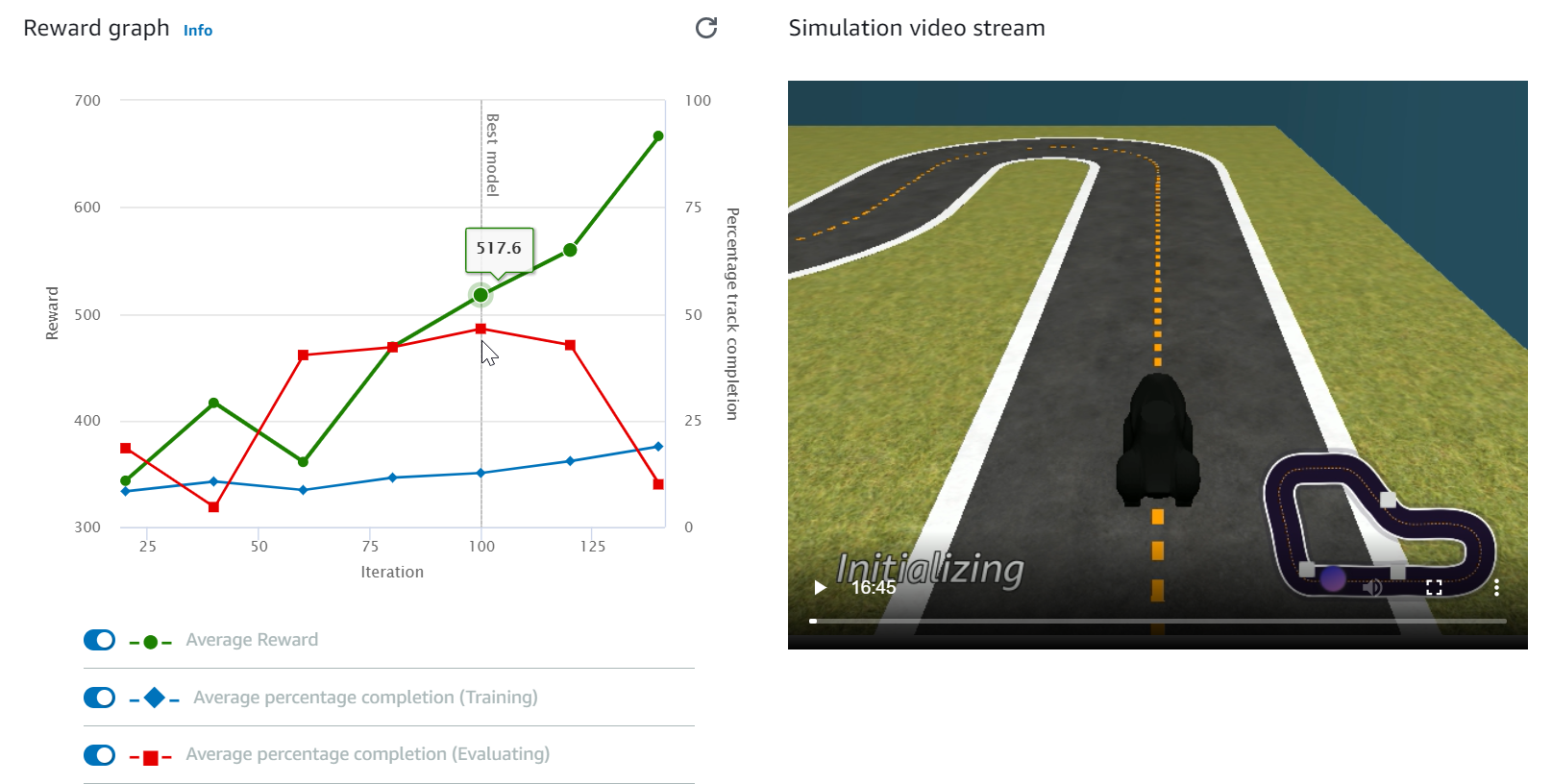

Guarda il Reward graph (Grafico delle ricompense) e il Simulation video stream (Flusso video di simulazione) per osservare come procede l'addestramento. Periodicamente, è possibile scegliere il pulsante di aggiornamento accanto al Reward graph (Grafico ricompense) per aggiornare il Reward graph (Grafico ricompense) fino al termine del processo di addestramento.

Il processo di formazione viene eseguito sul AWS cloud, quindi non è necessario tenere aperta la DeepRacer console AWS. Puoi sempre tornare alla console per controllare il tuo modello in qualsiasi momento mentre il lavoro è in corso.

Se la finestra dello streaming video della simulazione o il grafico Reward non rispondono, aggiorna la pagina del browser per aggiornare i progressi della formazione.