Le traduzioni sono generate tramite traduzione automatica. In caso di conflitto tra il contenuto di una traduzione e la versione originale in Inglese, quest'ultima prevarrà.

Distribuzione di un modello compilato utilizzando la console

Devi soddisfare la sezione dei prerequisiti se il modello è stato compilato utilizzando AWS SDK per Python (Boto3) AWS CLI, la o la console Amazon SageMaker AI. Segui i passaggi seguenti per creare e distribuire un modello compilato da SageMaker AI NEO utilizzando la console AI SageMaker /AI. https://console.aws.amazon.com SageMaker

Argomenti

Implementazione del modello

Dopo aver soddisfatto i prerequisiti, utilizza le seguenti fasi per distribuire un modello compilato con Neo:

-

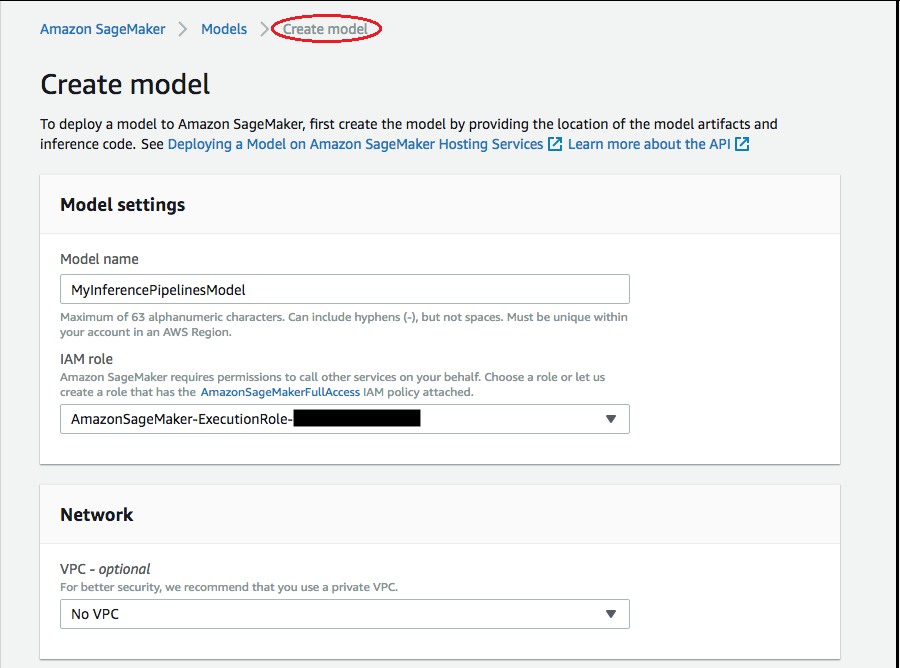

Scegli Modelli, quindi seleziona Crea modelli dal gruppo Inferenza. Nella pagina Crea modello, completa i campi Nome modello, Ruolo IAM e, se necessario, VPC (facoltativo).

-

Per aggiungere informazioni sul container utilizzato per distribuire il modello, scegli Aggiungi container, quindi seleziona Successivo. Completa i campi Opzioni di input del container, Posizione dell'immagine del codice di inferenza e Posizione degli artefatti dei modelli e, opzionalmente, Nome host container e Variabili di ambiente.

-

Per distribuire modelli compilati da Neo, scegli le seguenti opzioni:

-

Opzioni di input del container: scegli Fornisci gli artefatti di modello e l'immagine di inferenza.

-

Posizione dell'immagine del codice di inferenza: scegli l'URI dell'immagine di inferenza da Neo Inference Container Images, a seconda della AWS Regione e del tipo di applicazione.

-

Posizione degli artefatti dei modello: immetti l’URI del bucket Amazon S3 dell'artefatto del modello compilato generato dall'API di compilazione Neo.

-

Variabili di ambiente:

-

Lascia vuoto questo campo per. SageMaker XGBoost

-

Se hai addestrato il tuo modello utilizzando l' SageMaker intelligenza artificiale, specifica la variabile di ambiente

SAGEMAKER_SUBMIT_DIRECTORYcome URI del bucket Amazon S3 che contiene lo script di addestramento. -

Se non hai addestrato il tuo modello utilizzando l' SageMaker intelligenza artificiale, specifica le seguenti variabili di ambiente:

Chiave Valori per MXNet e PyTorch Valori TensorFlow SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <la tua regione> <la tua regione> MMS_DEFAULT_RESPONSE_TIMEOUT 500 Lasciare questo campo vuoto per TF

-

-

-

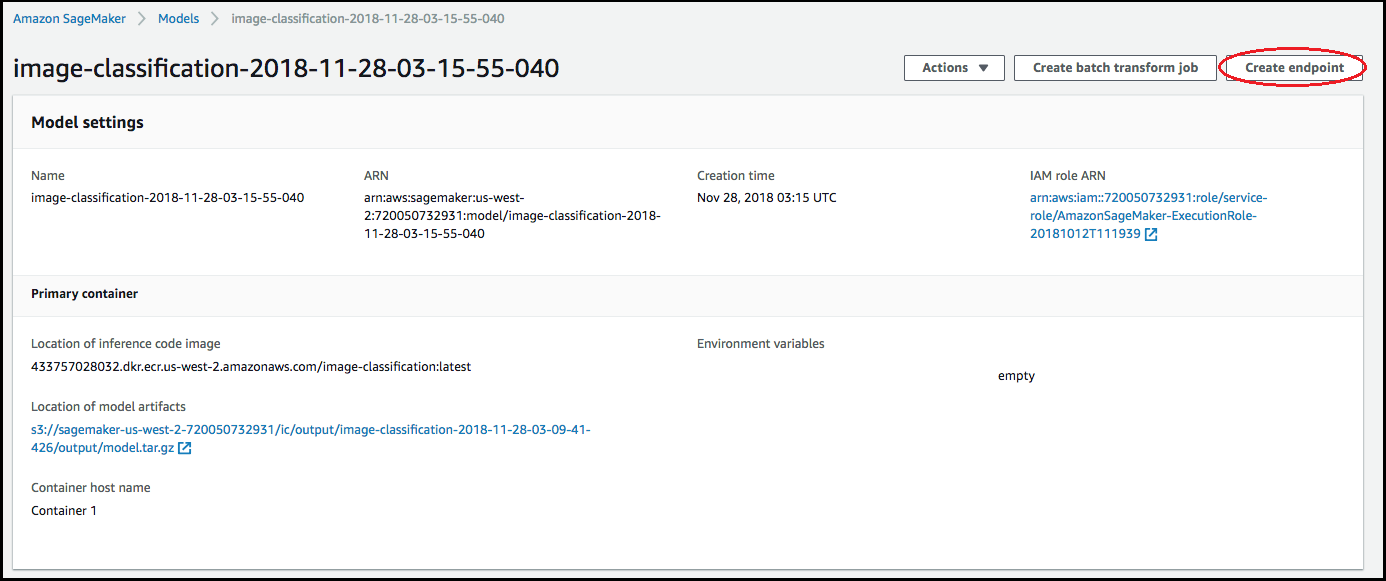

Verifica che le informazioni per i container siano accurate e quindi scegli Create model (Crea modello). Nella pagina di destinazione Crea modello, scegli Crea endpoint.

-

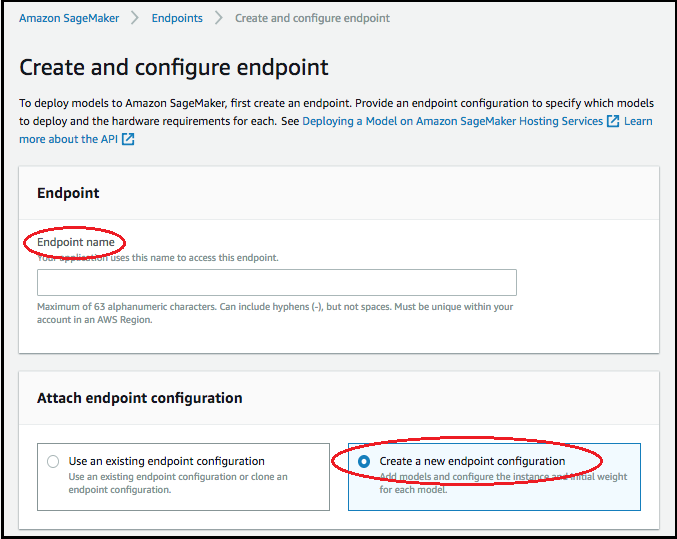

Nel diagramma Crea e configura l'endpoint, specifica il Nome endpoint. Per Collega configurazione endpoint, scegli Crea una nuova configurazione dell'endpoint.

-

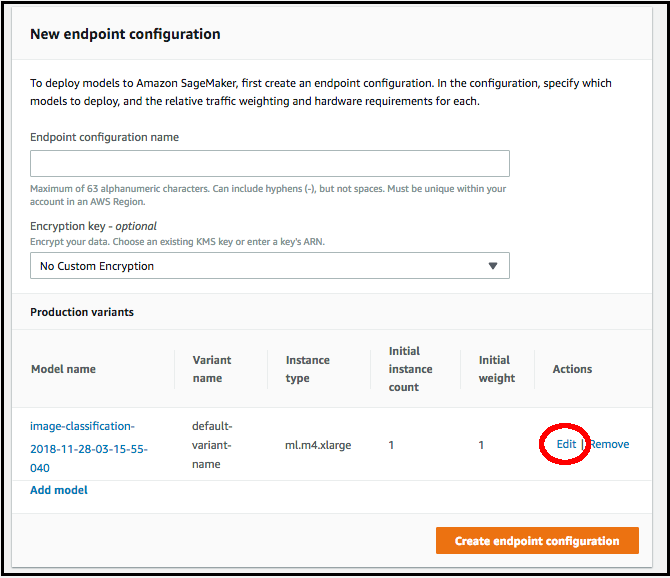

Nella pagina Nuova configurazione endpoint, specifica il Nome configurazione endpoint.

-

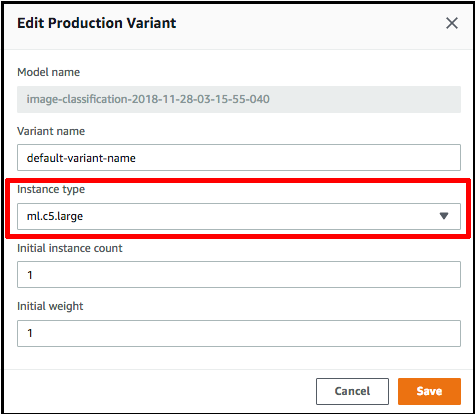

Scegli Modifica accanto al nome del modello e specifica il Tipo di istanza corretto nella pagina Modifica variante di produzione. È fondamentale che il valore per Tipo di istanza corrisponda a quello specificato nel processo di compilazione.

-

Scegli Save (Salva).

-

Nella pagina Nuova configurazione endpoint, scegli Crea configurazione endpoint, quindi scegli Crea endpoint.