翻訳は機械翻訳により提供されています。提供された翻訳内容と英語版の間で齟齬、不一致または矛盾がある場合、英語版が優先します。

コンソールを使ってコンパイル済みモデルをデプロイする

モデルが AWS SDK for Python (Boto3)、、または Amazon SageMaker AI コンソールを使用してコンパイルされている場合は AWS CLI、前提条件セクションを満たす必要があります。SageMaker AI コンソール「SageMaker AI」を使用して SageMaker AI Neo コンパイルモデルを作成およびデプロイするには、以下のステップに従います。https://console.aws.amazon.com/ SageMaker

トピック

モデルをデプロイする

前提条件を満たしたら、次のステップに従い、Neo を使ってコンパイルしたモデルをデプロイします。

-

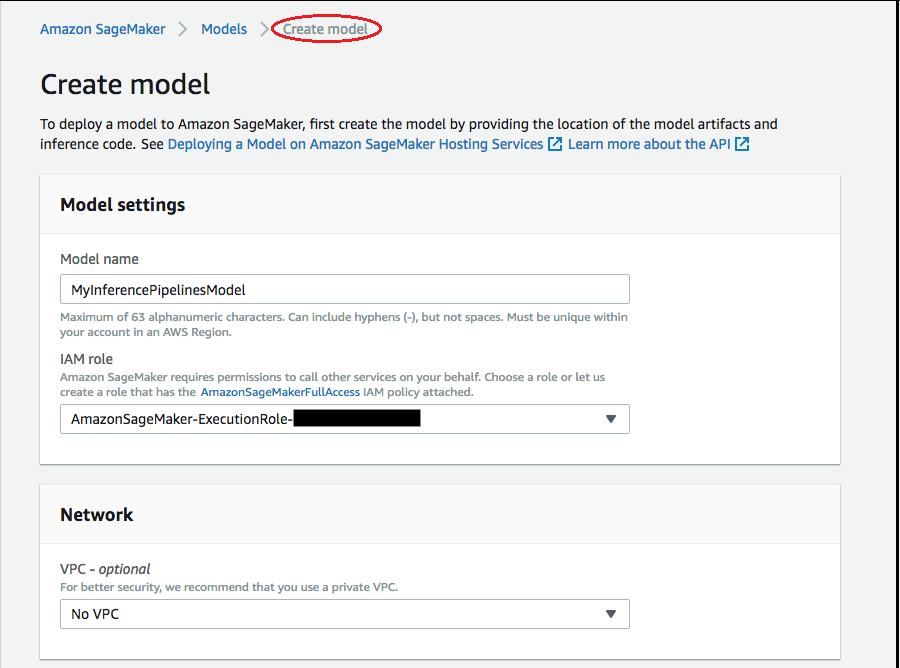

[Models] (モデル) を選択し、[Inference] (推論) グループから [Create models] (モデルの作成) を選択します。[Create model] (モデルの作成) ページで、[Model name] (モデル名)、[IAM role] (IAM ロール)、および必要に応じて [VPC] フィールドに値を入力します。

-

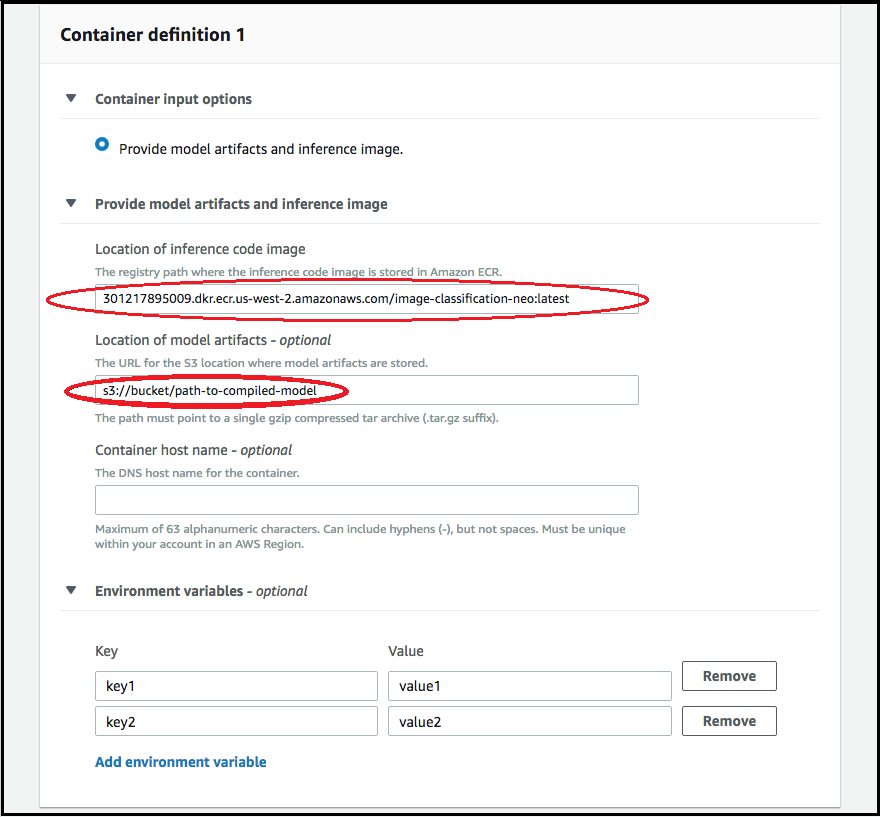

モデルのデプロイに使われたコンテナに関する情報を追加するには、[Add container] (コンテナの追加) を選択して [Next] (次へ) を選択します。[Container input options] (コンテナ入力オプション)、[Location of inference code image] (推論コードイメージの場所)、[Location of model artifacts] (モデルアーティファクトの場所)、およびオプションで [Container host name] (コンテナのホスト名)、[Environmental variables] (環境変数) の各フィールドに入力します。

-

Neo コンパイル済みモデルをデプロイするには、以下を選択してください。

-

Container input options (コンテナ入力オプション): [Provide model artifacts and inference image] (モデルアーティファクトと推論イメージを指定します。) を選択します。

-

[Location of inference code image] (推論コードイメージの場所): [Neo Inference Container Images] (Neo の推論コンテナイメージ) から、 AWS リージョンとアプリケーションの種類に応じて、推論イメージの URI を選択します。

-

[Location of model artifact] (モデルアーティファクトの場所): Neo のコンパイル API によって生成されたコンパイル済みモデルアーティファクトの Amazon S3 バケット の完全な URI を入力します。

-

環境変数:

-

SageMaker XGBoost の場合は、このフィールドは空白のままにします。

-

SageMaker AI を使用してモデルをトレーニングした場合は、トレーニングスクリプトを含む Amazon S3 バケット URI

SAGEMAKER_SUBMIT_DIRECTORYとして環境変数を指定します。 -

SageMaker AI を使用してモデルをトレーニングしなかった場合は、次の環境変数を指定します。

キー MXNet と PyTorch の値 TensorFlow の値 SAGEMAKER_PROGRAM inference.py inference.py SAGEMAKER_SUBMIT_DIRECTORY /opt/ml/model/code /opt/ml/model/code SAGEMAKER_CONTAINER_LOG_LEVEL 20 20 SAGEMAKER_REGION <ご利用のリージョン> <ご利用のリージョン> MMS_DEFAULT_RESPONSE_TIMEOUT 500 TF の場合は、このフィールドは空白のままにします。

-

-

-

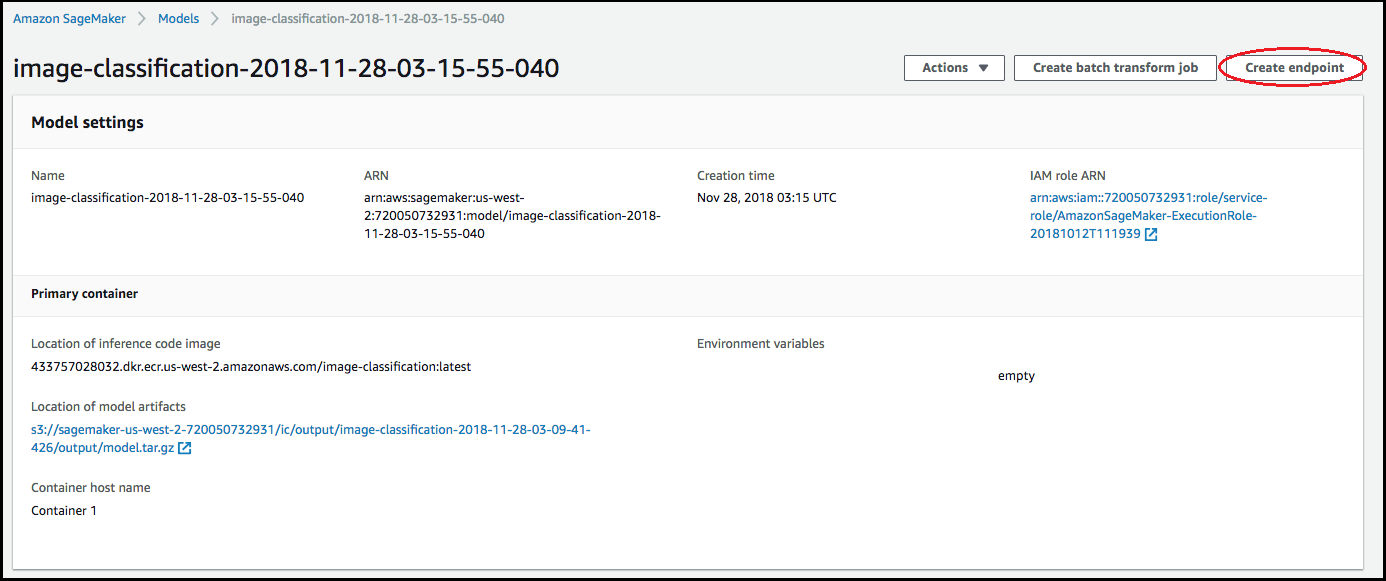

コンテナの情報が正確であることを確認し、 [モデルの作成] を選択します。[Create model landing page] (モデルランディングページを作成) で [Create endpoint] (エンドポイントの作成) を選択します。

-

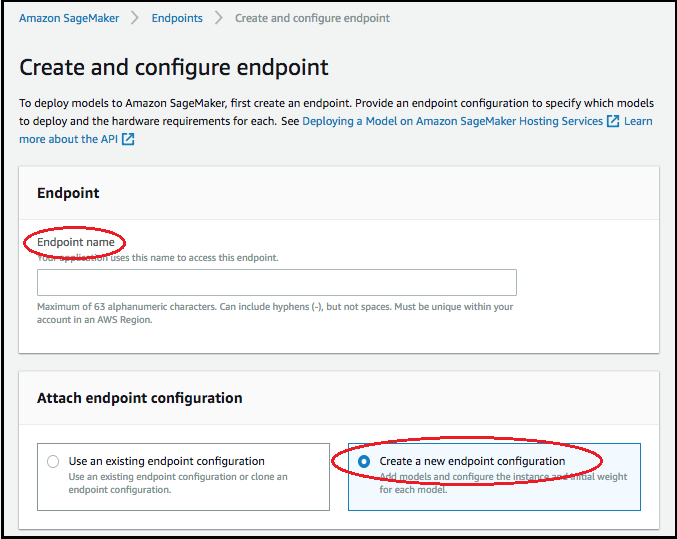

[エンドポイントを作成および設定] ダイアグラムで、[エンドポイント名] を指定します。[Attach endpoint configuration] (エンドポイント設定のアタッチ) で [Create a new endpoint configuration] (新しいエンドポイント設定の作成) を選択します。

-

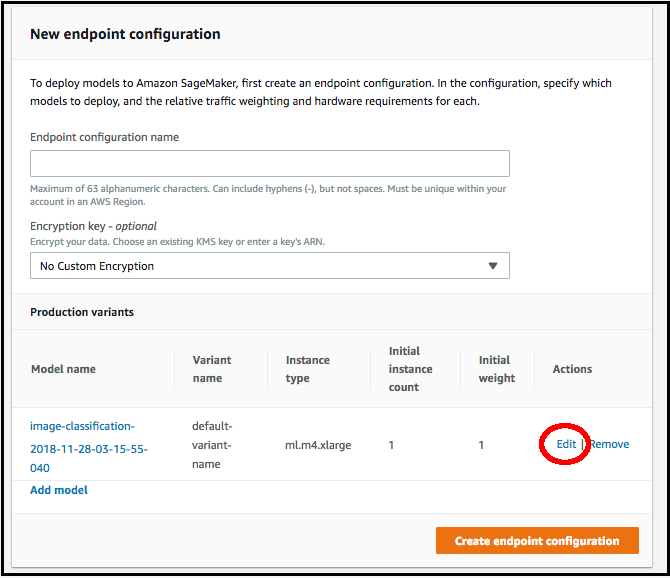

[新しいエンドポイント設定] ページで、[エンドポイント設定名] を指定します。

-

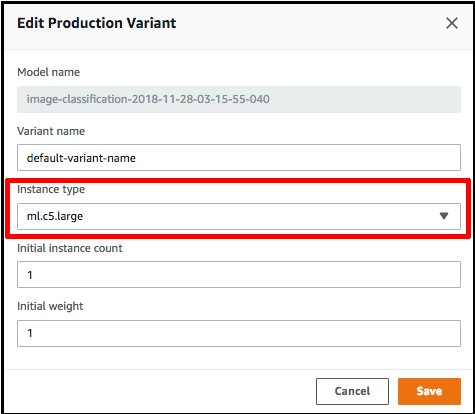

モデルの名前の横にある [Edit] (編集) を選択し、[Edit Production Variant] (本番稼働用バリアントの編集) ページで正しい [Instance type] (インスタンスタイプ) を指定します。[インスタンスタイプ] の値が、コンパイルジョブで指定されたものと一致することが必須です。

-

[保存] を選択します。

-

[New endpoint configuration] (新しいエンドポイント設定) ページで [Create endpoint configuration] (エンドポイント設定の作成) を選択してから、[Create endpoint] (エンドポイントの作成) を選択します。