기계 번역으로 제공되는 번역입니다. 제공된 번역과 원본 영어의 내용이 상충하는 경우에는 영어 버전이 우선합니다.

실시간 추론을 위한 모델 배포

중요

Amazon SageMaker Studio 또는 Amazon SageMaker Studio Classic에서 Amazon SageMaker 리소스를 생성할 수 있도록 허용하는 사용자 지정 IAM 정책도 해당 리소스에 태그를 추가할 수 있는 권한을 부여해야 합니다. Studio와 Studio Classic은 만드는 리소스에 태그를 자동으로 지정하기 때문에 리소스에 태그를 추가할 권한이 필요합니다. IAM 정책이 Studio 및 Studio Classic에서 리소스를 만들도록 허용하지만 태그 지정은 허용하지 않는 경우 리소스 만들기를 시도할 때 'AccessDenied' 오류가 발생할 수 있습니다. 자세한 내용은 SageMaker AI 리소스에 태그를 지정할 수 있는 권한 제공 섹션을 참조하세요.

SageMaker 리소스를 만들 수 있는 권한을 부여하는 AWS Amazon SageMaker AI에 대한 관리형 정책에는 해당 리소스를 만드는 동안 태그를 추가할 수 있는 권한이 이미 포함되어 있습니다.

SageMaker AI 호스팅 서비스를 사용하여 모델을 배포하는 몇 가지 옵션이 있습니다. SageMaker Studio를 사용하여 모델을 대화형으로 배포할 수 있습니다. 또는 SageMaker Python AWS SDK 또는 SDK for Python(Boto3)과 같은 SDK를 사용하여 프로그래밍 방식으로 모델을 배포할 수 있습니다. 를 사용하여 배포할 수도 있습니다 AWS CLI.

시작하기 전 준비 사항

SageMaker AI 모델을 배포하기 전에 다음을 찾아 기록해 둡니다.

-

Amazon S3 버킷이 AWS 리전 있는 위치

-

모델 아티팩트가 저장되는 Amazon S3 URI 경로

-

SageMaker AI의 IAM 역할

-

추론 코드가 포함된 사용자 지정 이미지의 Docker Amazon ECR URI 레지스트리 경로 또는 및에서 지원하는 기본 제공 Docker 이미지의 프레임워크 및 버전 AWS

각에서 AWS 서비스 사용 가능한 목록은 리전 맵 및 엣지 네트워크를 AWS 리전참조하세요. https://aws.amazon.com/about-aws/global-infrastructure/regional-product-services/

중요

모델 아티팩트가 저장되는 Amazon S3 버킷은 모델 패키지를 생성한 AWS 리전 과 동일해야 합니다.

여러 모델을 사용한 공유 리소스 사용률

Amazon SageMaker AI를 사용하여 엔드포인트에 하나 이상의 모델을 배포할 수 있습니다. 여러 모델이 엔드포인트를 공유하면 ML 컴퓨팅 인스턴스, CPU 및 액셀러레이터와 같이 엔드포인트에서 호스팅되는 리소스를 공동으로 활용합니다. 엔드포인트에 여러 모델을 배포하는 가장 유연한 방법은 각 모델을 추론 구성 요소 로 정의하는 것입니다.

추론 구성 요쇼

추론 구성 요소는 모델을 엔드포인트에 배포하는 데 사용할 수 있는 SageMaker AI 호스팅 객체입니다. 추론 구성 요소 설정에서 모델, 엔드포인트 및 엔드포인트가 호스팅하는 리소스를 모델이 활용하는 방법을 지정합니다. 모델을 지정하려면 SageMaker AI 모델 객체를 지정하거나 모델 아티팩트와 이미지를 직접 지정할 수 있습니다.

설정에서 필요한 CPU 코어, 액셀러레이터 및 메모리가 모델에 할당되는 방식을 조정하여 리소스 사용률을 최적화할 수 있습니다. 엔드포인트에 여러 추론 구성 요소를 배포할 수 있습니다. 여기서 각 추론 구성 요소에는 하나의 모델과 해당 모델의 리소스 사용률이 포함됩니다.

추론 구성 요소를 배포한 후 SageMaker API에서 InvokeEndpoint 작업을 사용할 때 연결된 모델을 직접 호출할 수 있습니다.

추론 구성 요소는 다음과 같은 이점을 제공합니다.

- 유연성

-

추론 구성 요소는 엔드포인트 자체에서 모델 호스팅의 세부 정보를 분리합니다. 이를 통해 모델을 호스팅하고 엔드포인트와 함께 제공하는 방법을 더 유연하게 제어할 수 있습니다. 동일한 인프라에서 여러 모델을 호스팅할 수 있으며 필요에 따라 엔드포인트에서 모델을 추가하거나 제거할 수 있습니다. 각 모델을 독립적으로 업데이트할 수 있습니다.

- 확장성

-

호스팅할 각 모델의 복사본 수를 지정하고 최소 복사본 수를 설정하여 모델이 요청을 처리하는 데 필요한 수량으로 로드되도록 할 수 있습니다. 추론 구성 요소 복사를 0으로 축소하여 다른 복사를 확장할 수 있는 공간을 확보할 수 있습니다.

SageMaker AI는 다음을 사용하여 모델을 배포할 때 모델을 추론 구성 요소로 패키징합니다.

-

SageMaker Studio Classic.

-

모델 객체를 배포하기 위한 SageMaker Python SDK(엔드포인트 유형을

EndpointType.INFERENCE_COMPONENT_BASED로 설정한 경우). -

엔드포인트 AWS SDK for Python (Boto3) 에 배포하는

InferenceComponent객체를 정의하는 입니다.

SageMaker Studio로 모델 배포

다음 단계를 완료하여 SageMaker Studio를 통해 모델을 대화형으로 생성하고 배포합니다. Studio에 대한 자세한 내용은 Studio 설명서를 참조하세요. 다양한 배포 시나리오에 대한 자세한 내용은 블로그 패키지를 참조하고 Amazon SageMaker AI - 2부를 사용하여 클래식 ML 모델 및 LLMs 쉽게 배포

아티팩트 및 권한 준비

SageMaker Studio에서 모델을 생성하기 전에 이 섹션을 완료합니다.

Studio에서 아티팩트를 가져오고 모델을 생성하는 두 가지 옵션이 있습니다.

-

모델 아티팩트, 사용자 지정 추론 코드 및

requirements.txt파일에 나열된 모든 종속성을 포함하는 사전 패키징된tar.gz아카이브를 가져올 수 있습니다. -

SageMaker AI는 아티팩트를 패키징할 수 있습니다. 원시 모델 아티팩트와 종속성만

requirements.txt파일로 가져와야 하며, SageMaker AI는 기본 추론 코드를 제공할 수 있습니다(또는 사용자 지정 추론 코드로 기본 코드를 재정의할 수 있습니다). SageMaker AI는 PyTorch, XGBoost 프레임워크에 대해이 옵션을 지원합니다.

모델, AWS Identity and Access Management (IAM) 역할 및 Docker 컨테이너(또는 SageMaker AI에 사전 구축된 컨테이너가 있는 원하는 프레임워크 및 버전)를 가져오는 것 외에도 SageMaker AI Studio를 통해 모델을 생성하고 배포할 수 있는 권한도 부여해야 합니다.

SageMaker AI 및 기타 관련 서비스에 액세스할 수 있으려면 IAM 역할에 AmazonSageMakerFullAccess 정책이 연결되어 있어야 합니다. Studio에서 인스턴스 유형의 가격을 보려면 AWS PriceListServiceFullAccess 정책도 연결해야 합니다(또는 전체 정책을 연결하지 않으려면 더 구체적으로 pricing:GetProducts 작업을 연결해야 함).

모델을 생성할 때 모델 아티팩트를 업로드하도록 선택한 경우(또는 추론 권장을 위해 샘플 페이로드 파일을 업로드하도록 선택한 경우) Amazon S3 버킷을 생성해야 합니다. 버킷 이름 앞에는 SageMaker AI 단어가 붙어야 합니다. SageMaker AI의 대체 대문자도 허용됩니다sagemaker. Sagemaker 또는 .

버킷 명명 규칙 sagemaker-{를 사용하는 것이 좋습니다. 이 버킷은 업로드한 아티팩트를 저장하는 데 사용됩니다.Region}-{accountID}

버킷을 생성한 후 다음 CORS(원본 간 리소스 공유) 정책을 버킷에 연결합니다.

[ { "AllowedHeaders": ["*"], "ExposeHeaders": ["Etag"], "AllowedMethods": ["PUT", "POST"], "AllowedOrigins": ['https://*.sagemaker.aws'], } ]

다음 방법 중 하나를 사용하여 Amazon S3 버킷에 CORS 정책을 연결할 수 있습니다.

-

Amazon S3 콘솔의 크로스 오리진 리소스 공유 편집(CORS)

페이지를 통해 -

Amazon S3 API PutBucketCors 사용

-

put-bucket-cors AWS CLI 명령 사용:

aws s3api put-bucket-cors --bucket="..." --cors-configuration="..."

배포 가능한 모델 생성

이 단계에서는 원하는 컨테이너 및 프레임워크, 사용자 지정 추론 코드 및 네트워크 설정과 같은 추가 사양과 함께 아티팩트를 제공하여 SageMaker AI에서 배포 가능한 모델 버전을 생성합니다.

다음을 수행하여 SageMaker Studio에서 배포 가능한 모델을 생성합니다.

-

SageMaker Studio 애플리케이션을 엽니다.

-

왼쪽 탐색 창에서 모델을 선택합니다.

-

배포 가능 모델 탭을 선택합니다.

-

배포 가능 모델 페이지에서 생성을 선택합니다.

-

배포 가능 모델 생성 페이지의 모델 이름 필드에 모델의 이름을 입력합니다.

배포 가능 모델 생성 페이지에서 작성할 수 있는 몇 가지 섹션이 더 있습니다.

컨테이너 정의 섹션은 다음 스크린샷과 같습니다.

컨테이너 정의 섹션에서 다음을 수행하세요.

-

컨테이너 유형에서 SageMaker AI 관리형 컨테이너를 사용하려면 사전 구축된 컨테이너를 선택하고, 자체 컨테이너가 있는 경우 자체 컨테이너 가져오기를 선택합니다.

-

사전 구축된 컨테이너를 선택한 경우 사용할 컨테이너 프레임워크, 프레임워크 버전 및 하드웨어 유형을 선택합니다.

-

자체 컨테이너 가져오기를 선택한 경우 컨테이너 이미지에 대한 ECR 경로에 Amazon ECR 경로를 입력합니다.

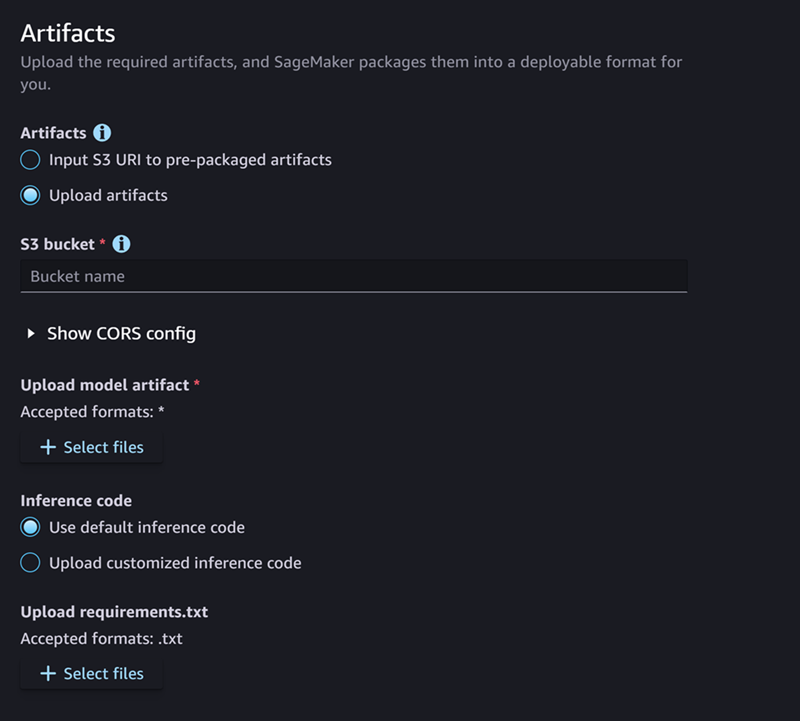

그런 다음 다음 스크린샷처럼 아티팩트 섹션을 작성합니다.

아티팩트 섹션에서 다음을 수행합니다.

-

SageMaker AI가 모델 아티팩트(PyTorch 또는 XGBoost) 패키징에 지원하는 프레임워크 중 하나를 사용하는 경우 아티팩트의 경우 아티팩트 업로드 옵션을 선택할 수 있습니다. 이 옵션을 사용하면 원시 모델 아티팩트, 보유한 사용자 지정 추론 코드 및 requirements.txt 파일을 간단히 지정할 수 있으며 SageMaker AI는 아카이브 패키징을 처리합니다. 다음을 수행합니다.

-

아티팩트에서 아티팩트 업로드를 선택하여 파일 제공을 계속합니다. 그렇지 않으면 모델 파일, 추론 코드 및

requirements.txt파일이 포함된tar.gz아카이브가 이미 있는 경우 사전 패키징된 아티팩트에 S3 URI 입력을 선택합니다. -

아티팩트를 업로드하기로 선택한 경우 S3 버킷의 경우 SageMaker AI가 아티팩트를 패키징한 후 저장할 버킷의 Amazon S3 경로를 입력합니다. 선택한 후 다음 단계를 완료합니다.

-

모델 아티팩트 업로드의 경우 모델 파일을 업로드합니다.

-

추론 코드에서 SageMaker AI가 추론을 제공하기 위해 제공하는 기본 코드를 사용하려면 기본 추론 코드 사용을 선택합니다. 그렇지 않으면 사용자 지정 추론 코드 업로드를 선택하여 자체 추론 코드를 사용합니다.

-

requirements.txt 업로드에서 런타임에 설치하려는 종속성을 나열하는 텍스트 파일을 업로드합니다.

-

-

SageMaker AI가 모델 아티팩트 패키징에 지원하는 프레임워크를 사용하지 않는 경우 Studio는 사전 패키징된 아티팩트 옵션을 표시하므로 이미 아카이브로 패키징된 모든 아티팩트를 제공해야 합니다.

tar.gz다음을 수행합니다.-

사전 패키징된 아티팩트의 경우

tar.gz아카이브가 Amazon S3에 이미 업로드된 경우 사전 패키징된 모델 아티팩트에 대한 입력 S3 URI를 선택합니다. Amazon S3 아카이브를 SageMaker AI에 직접 업로드하려면 사전 패키징된 모델 아티팩트 업로드를 선택합니다. -

사전 패키징된 모델 아티팩트 에 대해 입력 S3 URI를 선택한 경우 Amazon S3 URI 경로를 입력합니다. 그렇지 않으면 로컬 시스템에서 아카이브를 선택 및 업로드합니다.

-

다음 섹션은 다음 스크린샷과 같은 보안입니다.

보안 섹션에서 다음을 수행합니다.

-

IAM 역할에 IAM 역할의 ARN을 입력합니다.

-

(선택 사항) Virtual Private Cloud(VPC)의 경우 모델 구성 및 아티팩트를 저장할 Amazon VPC를 선택할 수 있습니다.

-

(선택 사항) 컨테이너의 인터넷 액세스를 제한하려면 네트워크 격리 토글을 켭니다.

마지막으로 다음 스크린샷과 같은 고급 옵션 섹션을 선택적으로 작성할 수 있습니다.

(선택 사항) 고급 옵션 섹션에는 다음 옵션이 있습니다.

-

사용자 지정 인스턴스 권장 사항 토글을 켜면 생성 후 모델에서 Amazon SageMaker Inference Recommender를 실행할 수 있습니다. 추론 추천은 추론 성능 및 비용을 최적화하기 위한 권장 인스턴스 유형을 제공하는 기능입니다. 모델 배포를 준비할 때 이러한 인스턴스 권장 사항을 볼 수 있습니다.

-

환경 변수 추가에 컨테이너의 환경 변수를 키-값 페어로 입력합니다.

-

태그에 모든 태그를 키-값 페어로 입력합니다.

-

모델 및 컨테이너 구성을 완료한 후 배포 가능한 모델 생성을 선택합니다.

이제 SageMaker Studio에 배포 준비가 된 모델이 있어야 합니다.

모델 배포

마지막으로 이전 단계에서 구성한 모델을 HTTPS 엔드포인트에 배포합니다. 단일 모델 또는 여러 모델을 엔드포인트에 배포할 수 있습니다.

모델 및 엔드포인트 호환성

엔드포인트에 모델을 배포하기 전에 다음 설정에 대해 동일한 값을 가짐으로써 모델과 엔드포인트가 호환되어야 합니다.

-

IAM 역할

-

서브넷 및 보안 그룹을 포함한 Amazon VPC

-

네트워크 격리(활성화 또는 비활성화)

Studio는 다음과 같은 방법으로 호환되지 않는 엔드포인트에 모델을 배포하지 못하도록 합니다.

-

모델을 새 엔드포인트에 배포하려고 하면 SageMaker AI는 호환되는 초기 설정으로 엔드포인트를 구성합니다. 이러한 설정을 변경하여 호환성을 해제하면 Studio가 알림을 표시하고 배포를 방지합니다.

-

기존 엔드포인트에 배포하려고 하는데 해당 엔드포인트가 호환되지 않는 경우 Studio는 알림을 표시하고 배포를 방지합니다.

-

배포에 여러 모델을 추가하려고 하면 Studio는 서로 호환되지 않는 모델을 배포하는 것을 방지합니다.

Studio가 모델 및 엔드포인트 비호환성에 대한 알림을 표시하면 알림에서 세부 정보 보기를 선택하여 비호환 설정을 확인할 수 있습니다.

모델을 배포하는 한 가지 방법은 Studio에서 다음을 수행하는 것입니다.

-

SageMaker Studio 애플리케이션을 엽니다.

-

왼쪽 탐색 창에서 모델을 선택합니다.

-

모델 페이지의 SageMaker AI 모델 목록에서 모델을 하나 이상 선택합니다.

-

배포(Deploy)를 선택합니다.

-

엔드포인트 이름에서 드롭다운 메뉴를 엽니다. 기존 엔드포인트를 선택하거나 모델을 배포하는 새 엔드포인트를 생성할 수 있습니다.

-

인스턴스 유형에서 엔드포인트에 사용할 인스턴스 유형을 선택합니다. 이전에 모델에 대해 추론 추천자 작업을 실행한 경우 권장 인스턴스 유형이 권장이라는 제목 아래 목록에 나타납니다. 그렇지 않으면 모델에 적합할 수 있는 몇 가지 전향적 인스턴스가 표시됩니다.

JumpStart에 대한 인스턴스 유형 호환성

JumpStart 모델을 배포하는 경우 Studio는 모델이 지원하는 인스턴스 유형만 표시합니다.

-

초기 인스턴스 수에 엔드포인트에 프로비저닝하려는 초기 인스턴스 수를 입력합니다.

-

최대 인스턴스 수의 경우 트래픽 증가를 수용하도록 확장할 때 엔드포인트가 프로비저닝할 수 있는 최대 인스턴스 수를 지정합니다.

-

배포하려는 모델이 모델 허브에서 가장 많이 사용되는 JumpStart LLMs 중 하나인 경우 인스턴스 유형 및 인스턴스 수 필드 뒤에 대체 구성 옵션이 나타납니다.

가장 인기 있는 JumpStart LLMs의 경우 AWS 에는 비용 또는 성능에 맞게 최적화할 수 있도록 미리 벤치마킹된 인스턴스 유형이 있습니다. 이 데이터는 LLM 배포에 사용할 인스턴스 유형을 결정하는 데 도움이 될 수 있습니다. 대체 구성을 선택하여 미리 벤치마킹된 데이터가 포함된 대화 상자를 엽니다. 패널은 다음 스크린샷과 같습니다.

대체 구성 상자에서 다음을 수행합니다.

-

인스턴스 유형을 선택합니다. 시간당 비용 또는 최상의 성능을 선택하여 지정된 모델의 비용 또는 성능을 최적화하는 인스턴스 유형을 볼 수 있습니다. 지원되는 기타 인스턴스를 선택하여 JumpStart 모델과 호환되는 다른 인스턴스 유형 목록을 볼 수도 있습니다. 여기서 인스턴스 유형을 선택하면 6단계에서 지정한 이전 인스턴스 선택이 덮어씁니다.

-

(선택 사항) 선택한 구성 사용자 지정 토글을 켜서 최대 총 토큰(허용하려는 최대 토큰 수, 즉 입력 토큰과 모델의 생성된 출력의 합계), 최대 입력 토큰 길이(각 요청의 입력에 허용하려는 최대 토큰 수), 최대 동시 요청(모델이 한 번에 처리할 수 있는 최대 요청 수)을 지정합니다.

-

선택을 선택하여 인스턴스 유형 및 구성 설정을 확인합니다.

-

-

모델 필드는 배포 중인 모델 또는 모델의 이름으로 이미 채워져 있어야 합니다. 모델 추가를 선택하여 배포에 모델을 더 추가할 수 있습니다. 추가하는 각 모델에 대해 다음 필드를 작성합니다.

-

CPU 코어 수에 모델 사용에 사용할 CPU 코어를 입력합니다.

-

최소 복사본 수에 지정된 시간에 엔드포인트에서 호스팅하려는 최소 모델 복사본 수를 입력합니다.

-

최소 CPU 메모리(MB)의 경우 모델에 필요한 최소 메모리 양(MB)을 입력합니다.

-

최대 CPU 메모리(MB)의 경우 모델이 사용할 수 있도록 허용할 최대 메모리 양(MB)을 입력합니다.

-

-

(선택 사항) 고급 옵션에서 다음을 수행합니다.

-

IAM 역할의 경우 기본 SageMaker AI IAM 실행 역할을 사용하거나 필요한 권한이 있는 자체 역할을 지정합니다. 이 IAM 역할은 배포 가능 모델을 생성할 때 지정한 역할과 동일해야 합니다.

-

가상 프라이빗 클라우드(VPC)의 경우 엔드포인트를 호스팅할 VPC를 지정할 수 있습니다.

-

암호화 KMS 키에서 AWS KMS 키를 선택하여 엔드포인트를 호스팅하는 ML 컴퓨팅 인스턴스에 연결된 스토리지 볼륨의 데이터를 암호화합니다.

-

네트워크 격리 활성화 토글을 켜서 컨테이너의 인터넷 액세스를 제한합니다.

-

제한 시간 구성에 모델 데이터 다운로드 제한 시간(초) 및 컨테이너 시작 상태 확인 제한 시간(초) 필드에 값을 입력합니다. 이러한 값은 SageMaker AI가 모델을 컨테이너에 다운로드하고 컨테이너를 시작하는 데 각각 허용하는 최대 시간을 결정합니다.

-

태그에 모든 태그를 키-값 페어로 입력합니다.

참고

SageMaker AI는 배포 중인 모델과 호환되는 초기 값으로 IAM 역할, VPC 및 네트워크 격리 설정을 구성합니다. 이러한 설정을 변경하여 호환성을 해제하면 Studio가 알림을 표시하고 배포를 방지합니다.

-

옵션을 구성한 후 페이지는 다음 스크린샷과 같아야 합니다.

배포를 구성한 후 배포를 선택하여 엔드포인트를 생성하고 모델을 배포합니다.

Python SDK를 사용하여 모델 배포

SageMaker Python SDK를 사용하면 두 가지 방법으로 모델을 빌드할 수 있습니다. 첫 번째는 Model 또는 ModelBuilder 클래스에서 모델 객체를 생성하는 것입니다. Model 클래스를 사용하여 Model 객체를 생성하는 경우 모델 패키지 또는 추론 코드(모델 서버에 따라 다름), 클라이언트와 서버 간의 데이터 직렬화 및 역직렬화를 처리하는 스크립트, 사용을 위해 Amazon S3에 업로드할 종속성을 지정해야 합니다. 모델을 구축하는 두 번째 방법은 모델 아티팩트 또는 추론 코드를 제공하는 ModelBuilder를 사용하는 것입니다. ModelBuilder는 종속성을 자동으로 캡처하고 필요한 직렬화 및 역직렬화 함수를 추론하며 종속성을 패키징하여 Model 객체를 생성합니다. ModelBuilder에 대한 자세한 정보는 ModelBuilder를 사용하여 Amazon SageMaker AI에서 모델 생성을 참조하세요.

다음 섹션에서는 모델을 생성하고 모델 객체를 배포하는 두 가지 방법을 모두 설명합니다.

설정

다음 예제에서는 모델 배포 프로세스를 준비합니다. 필요한 라이브러리를 가져오고 모델 아티팩트를 찾는 S3 URL을 정의합니다.

예 모델 아티팩트 URL

다음 코드는 예제 Amazon S3 URL을 빌드합니다. URL은 Amazon S3 버킷에서 사전 훈련된 모델의 모델 아티팩트를 찾습니다.

# Create a variable w/ the model S3 URL # The name of your S3 bucket: s3_bucket = "amzn-s3-demo-bucket" # The directory within your S3 bucket your model is stored in: bucket_prefix = "sagemaker/model/path" # The file name of your model artifact: model_filename = "my-model-artifact.tar.gz" # Relative S3 path: model_s3_key = f"{bucket_prefix}/"+model_filename # Combine bucket name, model file name, and relate S3 path to create S3 model URL: model_url = f"s3://{s3_bucket}/{model_s3_key}"

전체 Amazon S3 URL은 변수 model_url에 저장되며, 이는 다음 예제에서 사용됩니다.

개요

SageMaker Python SDK 또는 SDK for Python(Boto3)을 사용하여 모델을 배포할 수 있는 방법은 여러 가지가 있습니다. 다음 섹션에서는 몇 가지 가능한 접근 방식에 대해 완료하는 단계를 요약합니다. 다음 예제에서는 이러한 단계를 보여줍니다.

구성

다음 예제에서는 모델을 엔드포인트에 배포하는 데 필요한 리소스를 구성합니다.

배포

다음 예제에서는 모델을 엔드포인트에 배포합니다.

를 사용하여 모델 배포 AWS CLI

를 사용하여 엔드포인트에 모델을 배포할 수 있습니다 AWS CLI.

개요

를 사용하여 모델을 배포할 때 추론 구성 요소를 사용하거나 사용하지 않고 모델을 배포할 AWS CLI수 있습니다. 다음 섹션에서는 두 접근 방식에 대해 실행하는 명령을 요약합니다. 이러한 명령은 다음 예제에서 확인할 수 있습니다.

구성

다음 예제에서는 모델을 엔드포인트에 배포하는 데 필요한 리소스를 구성합니다.

배포

다음 예제에서는 모델을 엔드포인트에 배포합니다.